注意力机制的数学之美:深入解析其数学基础

发布时间: 2024-08-22 18:13:52 阅读量: 36 订阅数: 38

大模型的架构设计及其核心组件解析-机器学习领域的深度探讨

# 1. 注意力机制概述

注意力机制是一种神经网络技术,它允许模型专注于输入数据中最重要的部分。它在自然语言处理(NLP)和计算机视觉(CV)等领域得到了广泛的应用。

注意力机制的工作原理是通过计算一个权重向量,该权重向量分配给输入数据的不同部分。这些权重用于加权输入数据,从而突出最重要的部分。然后,模型对加权后的输入数据进行处理,以执行其特定任务。

注意力机制的主要优点之一是它能够捕获输入数据中的长期依赖关系。这对于NLP任务(如机器翻译)至关重要,其中模型需要理解句子中单词之间的关系,即使它们相隔很远。

# 2. 注意力机制的数学基础

注意力机制的数学基础涉及概率论、信息论、线性代数、矩阵运算、微积分和优化理论等多个数学领域。本章节将对这些基础知识进行简要介绍,为后续的注意力机制原理理解奠定基础。

### 2.1 概率论与信息论基础

#### 2.1.1 概率分布与熵

概率分布描述了随机变量取值的可能性分布。常见概率分布包括正态分布、二项分布、泊松分布等。

熵是衡量随机变量不确定性的度量。熵越大,不确定性越大。熵的计算公式为:

```

H(X) = -∑_x p(x) log p(x)

```

其中,X 为随机变量,p(x) 为 X 取值为 x 的概率。

#### 2.1.2 互信息与条件概率

互信息衡量两个随机变量之间的相关性。互信息的计算公式为:

```

I(X; Y) = H(X) + H(Y) - H(X, Y)

```

其中,X 和 Y 为两个随机变量,H(X) 和 H(Y) 分别为 X 和 Y 的熵,H(X, Y) 为 X 和 Y 的联合熵。

条件概率表示在已知另一个随机变量的情况下,某个随机变量取值的概率。条件概率的计算公式为:

```

P(X | Y) = P(X, Y) / P(Y)

```

其中,X 和 Y 为两个随机变量,P(X, Y) 为 X 和 Y 同时取值的概率,P(Y) 为 Y 取值的概率。

### 2.2 线性代数与矩阵运算

#### 2.2.1 向量与矩阵

向量是一组有序数字的集合。矩阵是一组数字排列成行和列的二维数组。

#### 2.2.2 矩阵乘法与逆矩阵

矩阵乘法是将两个矩阵相乘得到一个新的矩阵。矩阵乘法的规则是将第一个矩阵的每一行与第二个矩阵的每一列相乘,然后将结果相加。

逆矩阵是一个矩阵,当与原矩阵相乘时得到单位矩阵。单位矩阵是一个对角线元素为 1,其他元素为 0 的矩阵。

### 2.3 微积分与优化理论

#### 2.3.1 导数与积分

导数是函数变化率的度量。导数的计算公式为:

```

f'(x) = lim_(h->0) (f(x + h) - f(x)) / h

```

其中,f(x) 为函数,h 为自变量 x 的增量。

积分是函数在某个区间下的面积。积分的计算公式为:

```

∫_a^b f(x) dx = lim_(n->∞) ∑_(i=1)^n f(x_i) Δx

```

其中,f(x) 为函数,[a, b] 为积分区间,Δx 为区间 [a, b] 的划分,x_i 为第 i 个划分点。

#### 2.3.2 梯度下降与反向传播

梯度下降是一种优化算法,用于寻找函数的最小值或最大值。梯度下降的更新公式为:

```

θ_new = θ_old - α ∇f(θ)

```

其中,θ 为模型参数,α 为学习率,∇f(θ) 为 f(θ) 的梯度。

反向传播是一种计算梯度的算法,用于训练神经网络。反向传播通过链式法则计算损失函数相对于模型参数的导数。

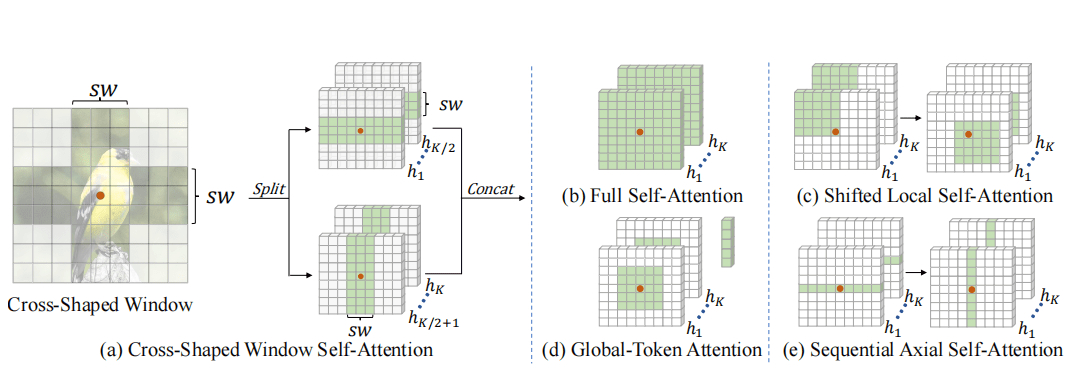

# 3.1 基于位置的注意力

基于位置的注意力机制利用输入序列中元素的位置信息来计算注意力权重。它主要分为两种类型:自注意力和交叉注意力。

#### 3.1.1 自注意力

自注意力机制计算序列中每个元素与自身其他元素之间的注意力权重。它可以捕获序列中元素之间的长期依赖关系。自注意力机制的计算公式如下:

```python

Q = W_q * X

K = W_k * X

V = W_v * X

A = softmax(Q @ K.T / sqrt(d_k))

O = A @ V

```

其中:

* `X` 是输入序列,形状为 `(seq_len, d_model)`

* `W_q`, `W_k`, `W_v` 是可学习的权重矩阵,形状均为 `(d_model, d_k)`

* `d_k` 是键向量和查询向量的维度

* `A` 是注意力权重矩阵,形状为 `(seq_len, seq_len)`

* `O` 是输出序列,形状为 `(seq_len, d_model)`

#### 3.1.2 交叉注意力

交叉注意力机制计算两个不同序列中元素之间的注意力权重。它可以捕获不同序列之间的交互信息。交叉注意力机制的计算公式如下:

```python

Q = W_q * X_q

K = W_k * X_k

V = W_v * X_k

A = softmax(Q @ K.T / sqrt(d_k))

O =

```

0

0