注意力机制的最佳实践:分享模型开发和部署的经验

发布时间: 2024-08-22 18:40:43 阅读量: 26 订阅数: 38

EffectiveTensorflow:TensorFlow教程和最佳实践

# 1. 注意力机制概述**

注意力机制是一种神经网络技术,它允许模型专注于输入数据中最相关的部分。它模拟了人类视觉系统,可以将注意力集中在图像的特定区域,或文本中的特定单词。注意力机制在自然语言处理和计算机视觉等领域取得了显著成功,它使模型能够更好地理解和处理复杂的数据。

注意力机制的基本原理是使用一个注意力函数,该函数计算输入数据中每个元素的重要性。然后,这些重要性权重用于加权输入数据,从而突出重要的部分。注意力机制可以应用于各种数据类型,包括文本、图像和音频。

# 2. 注意力机制模型

### 2.1 Transformer模型

**2.1.1 Transformer架构**

Transformer模型由谷歌在2017年提出,是一种基于注意力机制的序列到序列模型。其架构主要由编码器和解码器组成。编码器将输入序列转换为一组向量,而解码器则利用这些向量生成输出序列。

**编码器**由多个编码器层堆叠而成,每个编码器层包含两个子层:

1. **自注意力层:**计算输入序列中每个元素与所有其他元素之间的注意力权重,并根据这些权重生成新的表示。

2. **前馈网络:**对自注意力层的输出进行非线性变换。

**解码器**也由多个解码器层堆叠而成,每个解码器层包含三个子层:

1. **蒙版自注意力层:**计算输出序列中每个元素与所有其他元素之间的注意力权重,但只考虑之前的元素。

2. **编码器-解码器注意力层:**计算输出序列中每个元素与编码器输出之间的注意力权重,并利用这些权重生成新的表示。

3. **前馈网络:**对编码器-解码器注意力层的输出进行非线性变换。

### 2.1.2 Transformer中的注意力机制

Transformer模型中的注意力机制主要有两种类型:

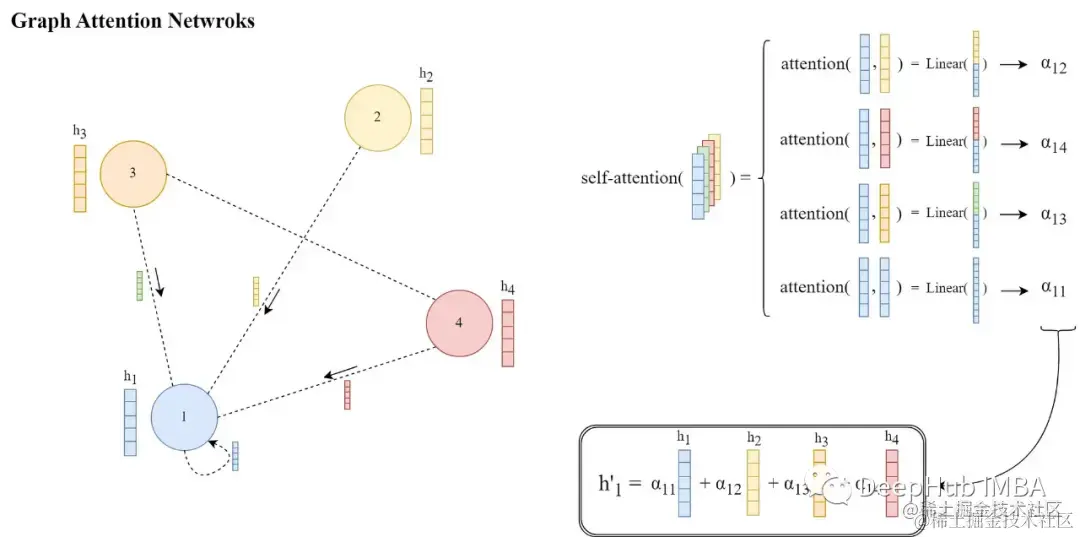

1. **自注意力:**计算序列中每个元素与所有其他元素之间的注意力权重。

2. **编码器-解码器注意力:**计算输出序列中每个元素与编码器输出之间的注意力权重。

**自注意力**通过计算查询向量(Q)、键向量(K)和值向量(V)之间的点积来计算注意力权重。查询向量表示当前元素,键向量表示所有其他元素,值向量表示所有其他元素的特征。

**编码器-解码器注意力**通过计算查询向量(Q)、键向量(K)和值向量(V)之间的点积来计算注意力权重。查询向量表示当前输出元素,键向量表示编码器输出,值向量表示编码器输出的特征。

### 2.2 卷积神经网络中的注意力机制

**2.2.1 卷积注意力模块**

卷积注意力模块(CAM)将注意力机制应用于卷积神经网络。CAM在卷积层之后添加一个注意力层,该层计算特征图中每个通道的注意力权重。这些权重用于生成注意力图,该注意力图可视化网络关注图像中的哪些区域。

**2.2.2 自注意力机制**

自注意力机制也可以应用于卷积神经网络。自注意力层计算特征图中每个元素与所有其他元素之间的注意力权重。这些权重用于生成自注意力图,该自注意力图可视化网络关注图像中的哪些关系。

**代码示例:**

```python

import tensorflow as tf

# 自注意力层

class SelfAttention(tf.keras.layers.Layer):

def __init__(self, units):

super(SelfAttention, self).__init__()

self.units = units

self.query_dense = tf.keras.layers.Dense(units)

self.key_dense = tf.keras.layers.Dense(units)

self.value_dense = tf.keras.layers.Dense(units)

def call(self, inputs):

query = self.query_dense(inputs)

key = self.key_dense(inputs)

value = self.value_dense(inputs)

# 计算注意力权重

attention_weights = tf.matmul(query, key, transpose_b=True)

attention_weights = tf.nn.softmax(attention_weights)

# 加权求和

output = tf.matmul(attention_weights, value)

return output

# 卷积注意力模块

class ConvolutionalAttentionModule(tf.keras.layers.Layer):

def __init__(self, channels):

super(ConvolutionalAttentionModule, self).__init__()

self.channels = channels

self.conv1 = tf.keras.layers.Conv2D(channels // 8, 1, activation='relu')

self.conv2 = tf.keras.layers.Conv2D(channels, 1, activation='sigmoid')

```

0

0