解锁注意力机制的威力:视觉问答模型的革命性应用

发布时间: 2024-08-22 17:50:37 阅读量: 14 订阅数: 23

# 1. 视觉问答模型的概述**

视觉问答模型(VQA)是一种人工智能技术,它可以理解图像并回答有关图像的问题。VQA模型将图像作为输入,并生成自然语言文本作为输出,回答有关图像内容的问题。

VQA模型通常由三个主要组件组成:图像特征提取器、问题编码器和答案解码器。图像特征提取器从图像中提取视觉特征,问题编码器将问题编码为向量表示,答案解码器将向量表示解码为自然语言文本答案。

VQA模型在许多应用中具有广泛的应用,包括图像检索、视频问答和医疗诊断。它们还可以帮助我们更好地理解图像内容,并为人类和机器之间的自然语言交互铺平道路。

# 2. 视觉问答模型的理论基础

### 2.1 注意力机制的原理

注意力机制是视觉问答模型的关键组成部分,它允许模型专注于图像中与问题相关的区域。注意力机制的原理是:

- **编码器-解码器架构:**视觉问答模型通常采用编码器-解码器架构。编码器将图像编码成一个固定长度的向量,而解码器将该向量解码为一个答案。

- **注意力模块:**注意力模块位于编码器和解码器之间。它计算图像中每个位置的权重,表示该位置对答案相关性的重要性。

- **加权求和:**注意力权重与图像编码向量相乘,得到一个加权求和向量。该向量包含图像中与问题最相关的区域的信息。

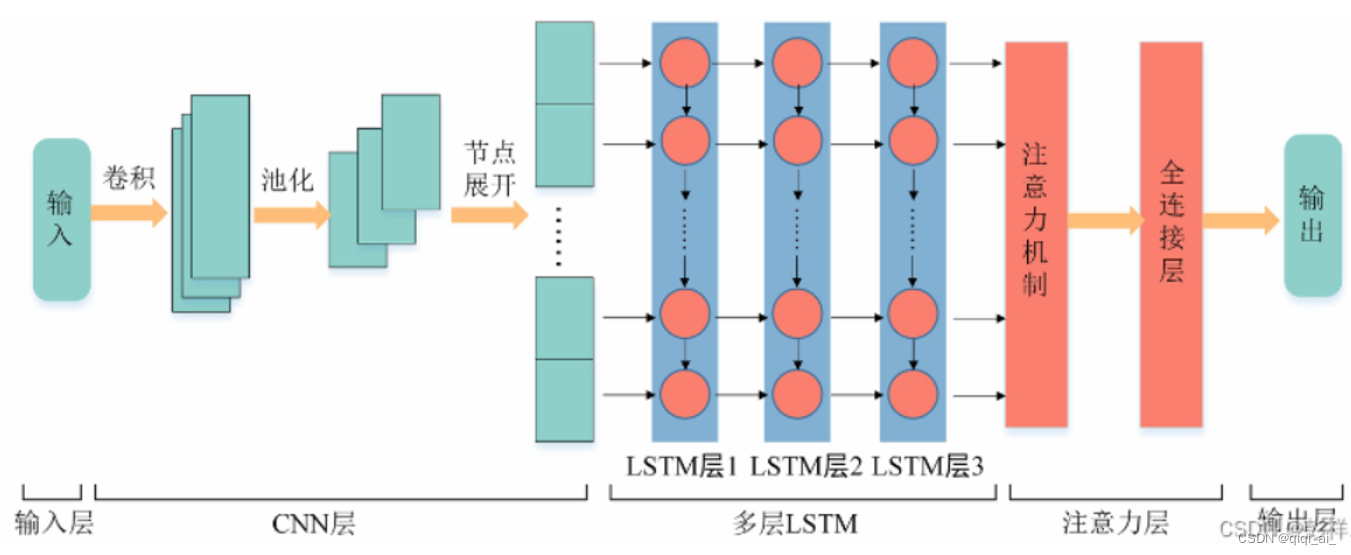

### 2.2 视觉问答模型的架构

视觉问答模型的架构通常包括以下组件:

- **图像编码器:**将图像编码成一个固定长度的向量。常见的图像编码器包括卷积神经网络(CNN)和Transformer。

- **问题编码器:**将问题编码成一个向量。常见的文本编码器包括词嵌入和循环神经网络(RNN)。

- **注意力模块:**计算图像中每个位置的注意力权重。

- **解码器:**将注意力加权求和向量解码为答案。常见的解码器包括RNN和Transformer。

### 2.3 训练和评估视觉问答模型

训练视觉问答模型涉及以下步骤:

- **数据准备:**收集图像-问题-答案三元组数据集。

- **模型初始化:**初始化图像编码器、问题编码器、注意力模块和解码器。

- **训练:**使用反向传播算法最小化模型在训练数据集上的损失函数。

- **评估:**使用验证数据集评估模型的性能。常见的评估指标包括准确率、召回率和F1分数。

**代码块:**

```python

import torch

from torch import nn

class VisualQuestionAnsweringModel(nn.Module):

def __init__(self, image_encoder, question_encoder, attention_module, decoder):

super().__init__()

self.image_encoder = image_encoder

self.question_encoder = question_encoder

self.attention_module = attention_module

self.decoder = decoder

def forward(self, image, question):

image_encoding = self.image_encoder(image)

question_encoding = self.question_encoder(question)

attention_weights = self.attention_module(image_encoding, question_encoding)

weighted_sum = torch.sum(attention_weights * image_encoding, dim=1)

answer = self.decoder(weighted_sum)

return answer

```

**逻辑分析:**

该代码块定义了一个视觉问答模型,它由图像编码器、问题编码器、注意力模块和解码器组成。模型的前向传递函数接收图像和问题作为输入,并返回答案。

**参数说明:**

- `image`: 输入图像,形状为`(B, C, H, W)`。

- `question`: 输入问题,形状为`(B, L)`。

- `image_encoding`: 图像编码,形状为`(B, D)`。

- `question_encoding`: 问题编码,形状为`(B, D)`。

- `attention_weights`: 注意力权重,形状为`(B, H, W)`。

- `weighted_sum`: 加权求和向量,形状为`(B, D)`。

- `answer`: 答案,形状为`(B, A)`。

# 3. 视觉问答模型的实践应用

视觉问答模型在实际应用中有着广泛的潜力,以下介绍其在图像检索和理解、视频问答和医疗诊断领域的应用。

### 3.1 图像检索和理解

视觉问答模型可以用于图像检索和理解任务。通过向模型提供一个自然语言问题和一张图像,模型可以识别图像中的对象、场景和关系,并生成一个文本答案。这在以下场景中非常有用:

- **图像搜索引擎:**视觉问答模型可以增强图像搜索引擎,允许用户使用自然语言查询来查找特定图像。

- **图像分类和标注:**模型可以自动对图像进行分类和标注,帮助用户组织和管理图像库。

- **图像理解:**模型可以提供对图像的深入理解,识别场景、对象和关系,并生成详细的描述。

### 3.2 视频问答

视觉问答模型还可以用于视频问答任务。通过向模型提供一个自然语言问题和一段视频,模型可以分析视频内容,识别关键帧、对象和事件,并生成一个文本答案。这在以下场景中非常有用:

- **视频搜索引擎:**视觉问答模型可以增强视频搜索引擎,允许用户使用自然语言查询来查找特定视频片段。

- **视频摘要:**模型可以生成视频摘要,突出显示视频中的关键信息和事件。

- **视频理解:**模型可以提供对视频的深入理解,识别场景、对象和事件,并生成详细的描述。

### 3.3 医疗诊断

视觉问答模型在医疗诊断领域也具有巨大的潜力。通过向模型提供医学图像和一个自然语言问题,模型可以分析图像,识别异常、病变和解剖结构,并生成一个文本答案。这在以下场景中非常有用:

- **医学图像诊断:**视觉问答模型可以辅助医生诊断医学图像,识别疾病、异常和解剖结构。

- **医学知识检索:**模型可以帮助医生快速检索医学知识,回答有关疾病、治疗和药物的自然语言问题。

- **患者教育:**模型可以生成易于理解的医学信息,帮助患者了解他们的病情和治疗方案。

**代码示例:**

```python

import torchvision.models as models

import torch

from PIL import Image

# 加载图像

image = Image.open("image.jpg")

# 预处理图像

preprocess = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

image_tensor = preprocess(image).unsqueeze(0)

# 加载模型

model = models.resnet18(pretrained=True)

# 预测

outputs = model(image_tensor)

_, predicted = torch.max(outputs.data, 1)

# 输出预测结果

print(predicted)

```

**代码逻辑分析:**

* 加载图像并进行预处理,将其转换为张量。

* 加载预训练的 ResNet-18 模型。

* 将图像张量输入模型并进行预测。

* 获取预测结果并打印。

**参数说明:**

* `image_tensor`:预处理后的图像张量。

* `model`:预训练的 ResNet-18 模型。

* `outputs`:模型的输出,是一个张量。

* `predicted`:预测结果,是一个整数,表示图像所属的类别。

# 4.1 多模态融合

多模态融合是视觉问答模型的一项重要进阶技术,它允许模型处理来自不同模态的数据,例如图像、文本和音频。通过融合来自不同模态的信息,模型可以获得更全面和丰富的理解,从而提高问答性能。

### 4.1.1 多模态数据融合方法

有多种方法可以融合来自不同模态的数据,包括:

- **早期融合:**在模型的早期阶段融合数据,例如将图像和文本特征连接起来。

- **晚期融合:**在模型的后期阶段融合数据,例如将图像和文本特征作为独立的输入馈送到模型中。

- **动态融合:**在模型训练过程中动态地融合数据,例如使用注意力机制来学习如何根据输入数据调整对不同模态的权重。

### 4.1.2 多模态融合的优势

多模态融合为视觉问答模型提供了以下优势:

- **更丰富的语义理解:**通过融合来自不同模态的数据,模型可以获得更全面的语义理解,从而更好地理解问题和图像中的内容。

- **更鲁棒的推理:**多模态数据可以提供互补的信息,从而使模型对噪声和不完整数据更具鲁棒性。

- **更广泛的适用性:**多模态模型可以处理各种输入数据类型,从而使其更适用于现实世界中的应用。

### 4.1.3 多模态融合的代码示例

以下代码块展示了如何使用早期融合方法融合图像和文本特征:

```python

import torch

# 加载图像特征和文本特征

image_features = torch.load('image_features.pt')

text_features = torch.load('text_features.pt')

# 连接图像特征和文本特征

fused_features = torch.cat([image_features, text_features], dim=1)

# 使用融合的特征训练视觉问答模型

model = VisualQuestionAnsweringModel()

model.train(fused_features, questions, answers)

```

### 4.1.4 多模态融合的逻辑分析

在上面的代码示例中:

- `image_features`和`text_features`是来自图像和文本的预提取特征。

- `torch.cat()`函数用于将图像特征和文本特征连接起来,形成融合的特征`fused_features`。

- 融合的特征`fused_features`随后被用作视觉问答模型的输入。

- 模型使用融合的特征训练,以学习如何从图像和文本中提取相关信息并生成答案。

# 5. 视觉问答模型的挑战和未来方向

### 5.1 视觉推理和常识推理

视觉问答模型在视觉推理和常识推理方面面临着挑战。视觉推理涉及从视觉输入中推断出隐含的关系和概念,而常识推理涉及应用背景知识和世界知识来回答问题。

**挑战:**

* 视觉问答模型难以处理需要多步推理或依赖常识知识的问题。

* 模型可能无法理解图像中复杂的空间关系和物体之间的交互。

* 缺乏对现实世界知识的理解,限制了模型回答需要常识推理的问题的能力。

**未来方向:**

* 开发新的模型架构,能够整合视觉推理和常识推理能力。

* 利用知识图谱和外部知识库增强模型的背景知识。

* 探索基于神经符号推理和概率推理的混合方法。

### 5.2 跨模态理解

视觉问答模型通常依赖于视觉信息,但它们可以受益于跨模态理解,即同时处理文本、视觉和音频等多种模态信息。

**挑战:**

* 跨模态信息之间的对齐和融合具有挑战性。

* 不同模态信息可能包含冗余或矛盾的信息,需要模型有效地解决。

* 缺乏跨模态数据集和评估指标,阻碍了模型的开发和评估。

**未来方向:**

* 开发新的跨模态模型架构,能够有效地融合不同模态信息。

* 创建更多跨模态数据集,涵盖各种场景和任务。

* 制定新的评估指标,以衡量跨模态理解能力。

### 5.3 可解释性和可信度

视觉问答模型的可解释性和可信度对于其在现实世界中的应用至关重要。用户需要了解模型的推理过程并相信其预测。

**挑战:**

* 黑箱模型难以解释,使得用户难以理解模型的预测。

* 模型可能对输入的微小扰动敏感,导致不可靠的预测。

* 缺乏量化可信度的指标,使得评估模型的可靠性具有挑战性。

**未来方向:**

* 开发可解释的模型架构,能够提供对推理过程的洞察。

* 探索对抗性训练和正则化技术,以提高模型的鲁棒性和可信度。

* 制定新的指标和方法来评估模型的可解释性和可信度。

# 6. 视觉问答模型的社会影响

### 6.1 辅助技术

视觉问答模型在辅助技术领域具有广泛的应用前景。对于视力障碍者来说,视觉问答模型可以帮助他们“看到”周围环境,并与之互动。例如,一个基于视觉问答模型的应用程序可以识别物体、阅读文本和提供导航信息。

### 6.2 教育和研究

视觉问答模型在教育和研究领域也发挥着重要作用。在教育方面,视觉问答模型可以作为一种交互式学习工具,帮助学生理解复杂的概念。例如,一个视觉问答模型可以帮助学生识别和理解不同类型的植物和动物。在研究方面,视觉问答模型可以用于分析大量视觉数据,从而发现新的模式和见解。

### 6.3 伦理考量

与任何技术一样,视觉问答模型也引发了一些伦理考量。例如,视觉问答模型可能被用于监视或侵犯隐私。此外,视觉问答模型还可能加剧现有的社会偏见,因为它们通常是在有偏见的数据集上训练的。因此,在开发和部署视觉问答模型时,必须仔细考虑伦理影响。

0

0