医学图像分析的利器:注意力机制助力疾病诊断

发布时间: 2024-08-22 18:04:17 阅读量: 36 订阅数: 39

时间序列分析利器:ARIMA模型详解与Python实战

# 1. 医学图像分析概述**

医学图像分析是指利用计算机技术从医学图像中提取有价值的信息,辅助疾病诊断和治疗。医学图像分析在医学领域有着广泛的应用,包括医学图像分割、分类和检测。

医学图像分析面临着许多挑战,例如数据量大且复杂、医学图像的异质性等。注意力机制作为一种深度学习技术,可以帮助解决这些挑战,提升医学图像分析的准确性和效率。

# 2. 注意力机制在医学图像分析中的应用**

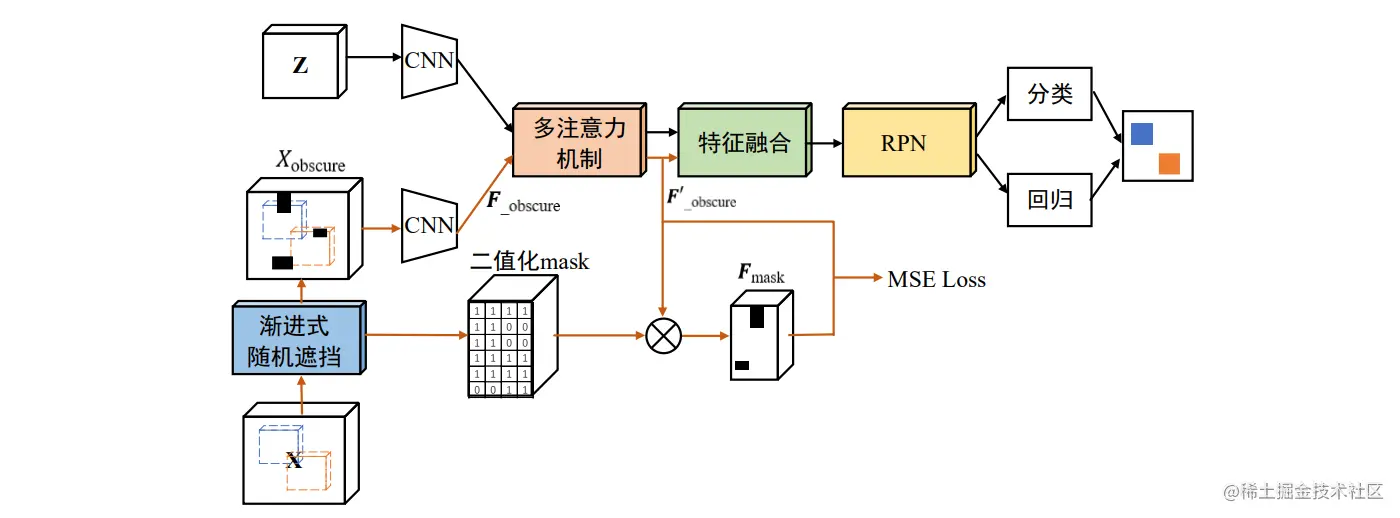

注意力机制是一种神经网络技术,它允许模型专注于图像中与特定任务相关的区域。在医学图像分析中,注意力机制已被证明可以提高图像分割、分类和检测的准确性。

## 2.1 注意力机制的基本原理

### 2.1.1 注意力机制的类型

注意力机制有两种主要类型:

- **空间注意力机制:**专注于图像中的特定区域。

- **通道注意力机制:**专注于图像中的特定通道。

### 2.1.2 注意力机制的实现方法

注意力机制通常通过以下步骤实现:

1. **特征提取:**从图像中提取特征图。

2. **注意力计算:**使用注意力机制计算特征图中每个位置或通道的重要性。

3. **注意力加权:**将注意力权重应用于特征图,以突出重要的区域或通道。

## 2.2 注意力机制在医学图像分析中的应用案例

### 2.2.1 医学图像分割

注意力机制已用于提高医学图像分割的准确性。例如,Attention U-Net模型使用空间注意力机制来专注于图像中感兴趣的区域,从而提高了分割边界和细小结构的准确性。

### 2.2.2 医学图像分类

注意力机制还用于提高医学图像分类的准确性。例如,SENet模型使用通道注意力机制来专注于图像中与分类任务相关的通道,从而提高了模型的判别能力。

### 2.2.3 医学图像检测

注意力机制已用于提高医学图像检测的准确性。例如,YOLOv3模型使用空间注意力机制来专注于图像中可能包含目标的区域,从而提高了检测速度和准确性。

**代码示例:**

```python

import torch

import torch.nn as nn

class SpatialAttention(nn.Module):

def __init__(self, kernel_size=7):

super(SpatialAttention, self).__init__()

self.conv = nn.Conv2d(in_channels=1, out_channels=1, kernel_size=kernel_size, padding=kernel_size//2)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

avg_out = torch.mean(x, dim=1, keepdim=True)

max_out, _ = torch.max(x, dim=1, keepdim=True)

x = torch.cat([avg_out, max_out], dim=1)

x = self.conv(x)

return self.sigmoid(x)

```

**代码逻辑分析:**

这段代码实现了空间注意力机制。它首先计算图像的平均池化和最大池化,然后将它们连接在一起并通过卷积层。最后,它使用sigmoid函数将输出限制在0到1之间,表示每个位置的注意力权重。

**参数说明:**

- `kernel_size`:卷积核的大小。

# 3. 注意力机制在医学图像分析中的实践

注意力机制在医学图像分析中发挥着至关重要的作用,促进了疾病诊断的准确性和效率。本章将深入探讨基于注意力机制的医学图像分割、分类和检测算法,并提供具体的实践指南。

### 3.1 基于注意力机制的医学图像分割算法

医学图像分割是将医学图像中的不同解剖结构或病变区域分割出来的过程。基于注意力机制的分割算法通过引入注意力模块,增强了模型对图像中感兴趣区域的关注能力,提高了分割精度。

#### 3.1.1 U-Net模型

U-Net模型是一种经典的医学图像分割模型,其结构呈U形,包括编码器和解码器两部分。编码器负责提取图像特征,解码器负责将特征图上采样并恢复空间分辨率。

```python

import torch

import torch.nn as nn

class UNet(nn.Module):

def __init__(self, in_channels, out_channels):

super(UNet, self).__init__()

# 编码器

self.encoder = nn.Sequential(

nn.Conv2d(in_channels, 64, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Conv2d(64, 128, kernel_size=3, stride=1, paddi

```

0

0