可解释的推荐与搜索:EARS前沿讲习班

需积分: 5 151 浏览量

更新于2024-07-17

收藏 19.64MB PDF 举报

“4_CCKS_ATT_YongfengZhang.pdf”是2019年全国知识图谱与语义计算大会前沿讲习班的PPT和讲义,主要探讨了可解释的推荐系统(Explainable Recommendation)和可解释的搜索(Explainable Search)。

在当今的智能系统中,尤其是AI在Web领域的应用,如推荐系统、搜索引擎等,往往被称为“黑箱”学习问题。这是因为最先进的机器学习模型,特别是深度学习模型,其工作原理对用户来说通常是不透明的。这导致了一个挑战:我们无法清晰地解释机器的输出结果,使得用户难以理解和信任这些系统。例如,当推荐系统给出一个商品推荐或搜索引擎返回一个搜索结果时,用户可能想知道为什么会有这样的推荐或结果出现。

可解释的AI(Explainable AI)成为了近年来的研究热点,尤其是在推荐系统(Explainable RS)、搜索(Explainable Search)以及问答系统(Explainable QA)等领域。这一趋势源于对透明度和用户理解的需求。对于用户来说,能够理解推荐或搜索背后的原因至关重要,这可以增强他们对系统的信任感,帮助他们做出更符合自己需求的选择。例如,用户可能会问:“为什么给我推荐这个商品?”或者“为什么搜索结果会这样排列?”

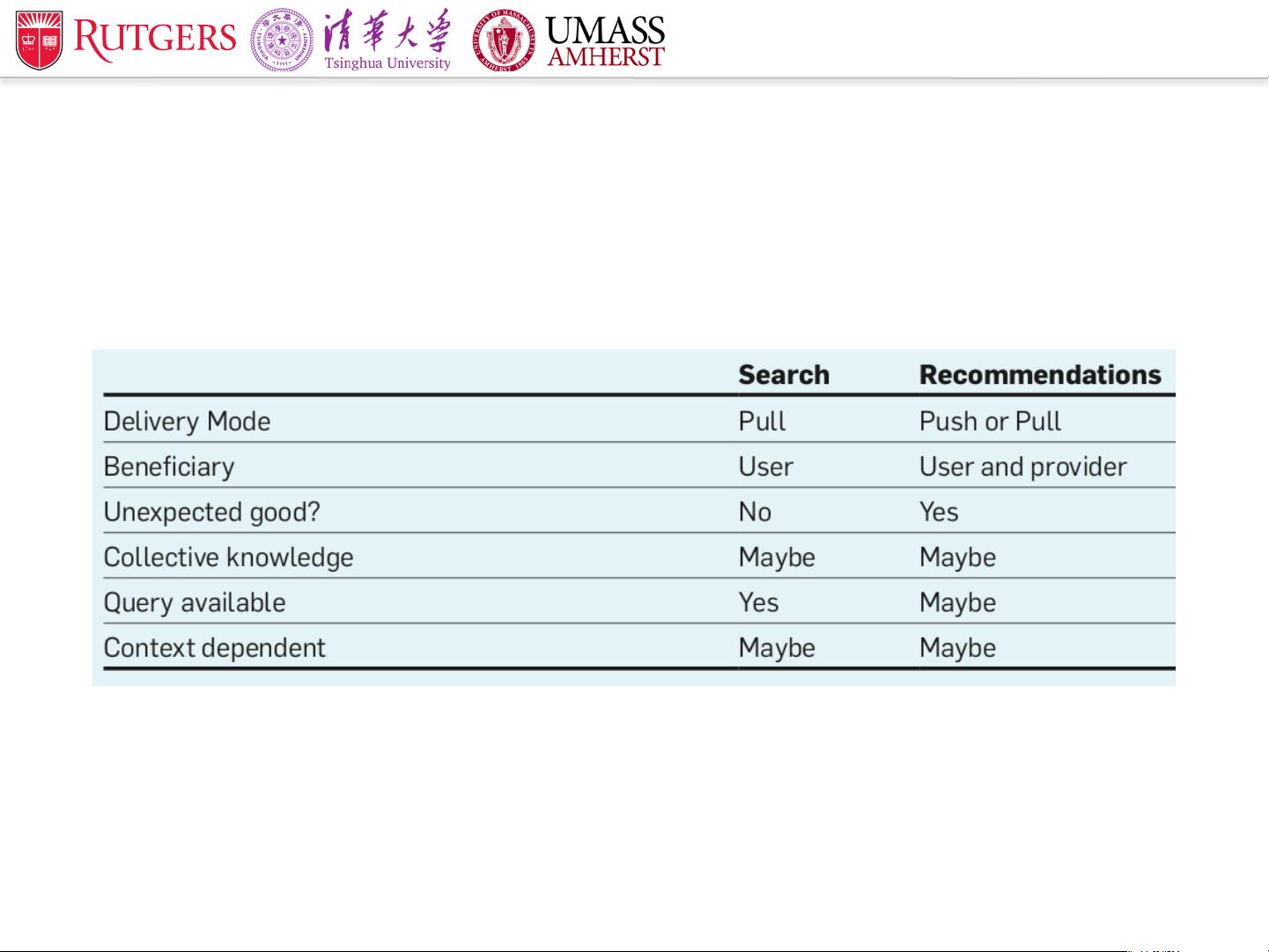

本教程分为两个部分:第一部分专注于可解释的推荐系统,讨论如何通过模型的可解释性来提升用户体验,使用户能够理解为何某项商品或服务被推荐给他们。这可能涉及到用户的兴趣模型、历史行为分析、协同过滤等机制的解释。

第二部分则关注可解释的搜索,这涉及到搜索引擎如何处理查询、评估相关性和排序文档的逻辑。解释搜索结果可以帮助用户理解搜索引擎是如何从海量信息中找出最相关的答案。这可能涉及到关键词匹配、语义理解、用户意图识别等技术的解释。

总结来说,这个教程深入浅出地探讨了在AI驱动的推荐系统和搜索中实现可解释性的关键问题,旨在提高系统的透明度,增进用户对系统决策的理解,从而提升用户满意度和系统的整体效能。通过这样的研究,我们可以期待未来的智能系统不仅能够做出准确的预测和建议,还能提供清晰的解释,使用户能够更好地理解和接受这些决策。

2019-08-29 上传

2019-08-29 上传

2023-06-06 上传

2023-07-13 上传

2023-05-19 上传

2023-07-20 上传

2023-07-16 上传

2023-07-16 上传

2023-06-08 上传

2023-06-08 上传

Jayxp

- 粉丝: 6

- 资源: 137

最新资源

- zlib-1.2.12压缩包解析与技术要点

- 微信小程序滑动选项卡源码模版发布

- Unity虚拟人物唇同步插件Oculus Lipsync介绍

- Nginx 1.18.0版本WinSW自动安装与管理指南

- Java Swing和JDBC实现的ATM系统源码解析

- 掌握Spark Streaming与Maven集成的分布式大数据处理

- 深入学习推荐系统:教程、案例与项目实践

- Web开发者必备的取色工具软件介绍

- C语言实现李春葆数据结构实验程序

- 超市管理系统开发:asp+SQL Server 2005实战

- Redis伪集群搭建教程与实践

- 掌握网络活动细节:Wireshark v3.6.3网络嗅探工具详解

- 全面掌握美赛:建模、分析与编程实现教程

- Java图书馆系统完整项目源码及SQL文件解析

- PCtoLCD2002软件:高效图片和字符取模转换

- Java开发的体育赛事在线购票系统源码分析