SharinGAN:融合合成与真实数据的无监督几何估计新策略

40 浏览量

更新于2024-06-20

收藏 1.54MB PDF 举报

标题:“合成和真实数据进行无监督几何估计的新方法”探讨的是一个关键问题,即如何在没有大量标注的情况下,训练深度学习模型,使其能够适应合成数据和真实世界的场景,特别是在人脸表面法线估计和单目深度估计这两个重要的计算机视觉任务上。传统的挑战在于,尽管合成数据易于获取且带有预设标签,但这些模型在实际应用中往往表现不佳,因为它们无法有效处理合成与真实世界间的域差距。

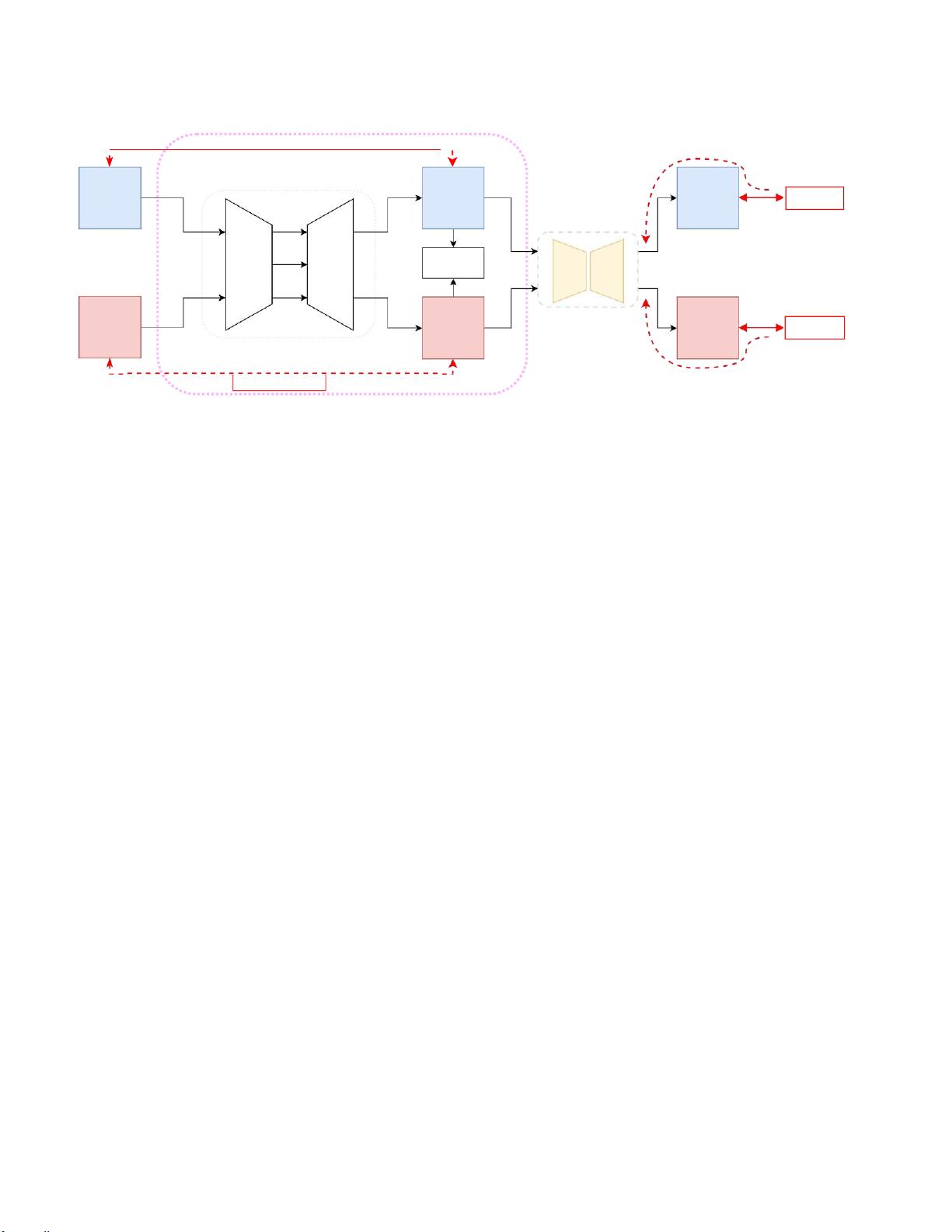

研究者提出了一种名为SharinGAN的新方法,该方法的核心思想是将合成图像和真实图像映射到一个共享的表示空间,这个空间包含两个域都共有的任务相关信息。他们假设图像可以分解为三个组成部分:跨合成与真实共享的通用信息(I)、合成或真实特有的领域无关信息(δ′),以及与任务紧密相关的领域特定信息(δs和δr)。真实图像和合成图像分别表达为xr = f(I, δr, δ′)和xs = f(I, δs, δ′)。

为了弥合这种域差距,他们的方法将合成图像中的与任务相关的信息δs和真实图像中的δr映射到一个共享的表示δsh,这样可以保持其他不变的特征,并让回归器专注于学习那些跨越两个域的任务相关特征。这种方法旨在通过端到端的网络训练,使模型能够在无监督条件下显著提高对真实数据的处理能力。

研究者通过实验验证了这种方法的有效性,表明它在人脸表面法线估计和单目深度估计等任务上带来了显著的性能提升,证明了将合成和真实数据结合进行无监督几何估计的潜在价值。这种方法不仅有助于克服合成数据的局限性,还可能为未来的计算机视觉任务提供更鲁棒的解决方案。

2023-02-23 上传

172 浏览量

2021-03-29 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

192 浏览量

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- DB2 OLAP Server - 理论与实践

- C语言参考手册之函数库

- 访问控制列表网络地址转换

- Apress.Pro.Web.2.0.Application.Development.with.GWT.May.2008

- ISMA_2.0.pdf

- Java正则表达式入门及用法

- MATLAB命令大全

- c#收集资料(C#函数列表)

- js 面向对象教程 很不错的教程

- RCNA实验配置完整版

- ruby语言入门教程

- Roy Thomas Fielding博士论文中文版(REST)

- foundation actionscript3.0 anmation

- PL/SQL Develope 7.0 User's Guide

- Lucene学习笔记

- PMBOOK--PMP HANDBOOK