无监督学习案例研究:大数据集中的异常检测技巧

发布时间: 2024-09-02 08:31:56 阅读量: 190 订阅数: 68

bigdate_learn:大数据学习案例

# 1. 无监督学习与异常检测概述

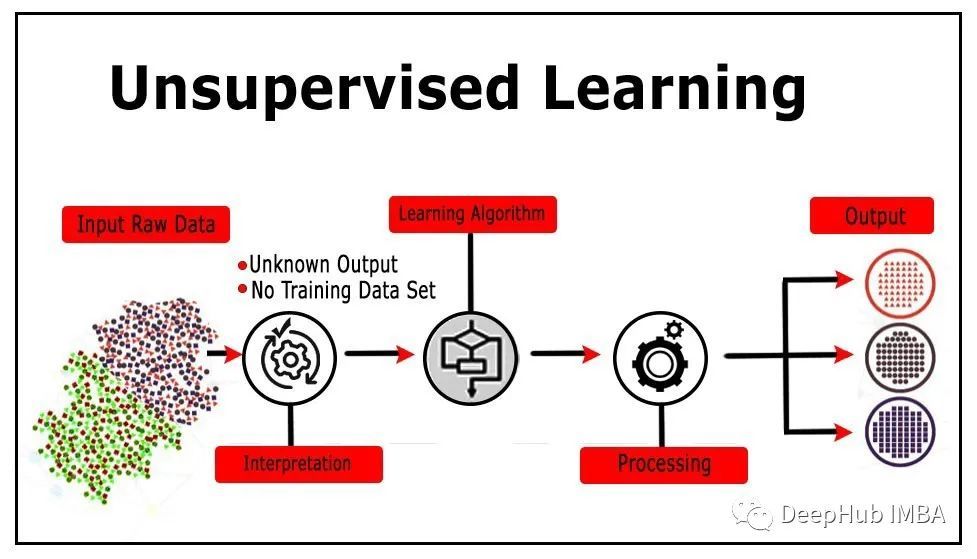

## 1.1 无监督学习的定义

无监督学习是一种机器学习方法,不需要预先标注的数据作为训练集。它的目的是发现数据集中的隐藏结构和规律,无需事先指定输出的类别标签。无监督学习尤其适用于解决分类和聚类等任务,在异常检测、数据压缩、特征提取等领域中有着广泛的应用。

## 1.2 异常检测与无监督学习的结合

异常检测是无监督学习的一个重要应用,旨在从无标签数据中识别出不符合预期模式或行为的异常样本。这一过程对于确保数据质量、网络安全、欺诈检测等具有重要的现实意义。异常检测依赖于无监督学习算法,通过分析数据集的统计特性,识别出偏离常规模式的异常行为。

## 1.3 无监督学习在异常检测中的优势

使用无监督学习进行异常检测的优势在于它不依赖于预先标记的数据,可以处理大量未标注的数据,从而发现难以预先定义的异常模式。此外,它还能处理实时数据流,对于动态变化的环境具有良好的适应性。例如,在网络安全领域,不断变化的攻击模式要求系统能够持续地从新的数据中学习和检测异常。

# 2. 无监督学习基础理论

## 2.1 无监督学习的定义与应用

### 2.1.1 无监督学习的概念框架

无监督学习是机器学习中的一种方法,它不依赖于预先标记的数据进行训练。在无监督学习中,算法被给予的数据没有预先定义的输出值,它需要从输入数据中发现模式和结构。这与监督学习不同,监督学习使用带有标签的数据进行训练,而无监督学习则需要算法自主地从数据中挖掘出信息。

无监督学习的目的是找到隐藏在数据中的内在结构或分布,它可以应用于许多场景,包括聚类、关联规则学习、数据降维和异常检测等。由于数据的未标记性,无监督学习在处理大规模、高维数据集时非常有效,尤其是在处理真实世界问题时,往往难以获得足够量的标记数据。

#### 聚类任务中的无监督学习

聚类是无监督学习中最常见的任务之一,它的目的是将数据集中的数据点根据相似性分组。聚类可以帮助我们理解数据的分布和结构。比如,在市场细分中,企业可以使用聚类来识别不同的客户群体。

#### 关联规则学习中的无监督学习

关联规则学习用于发现大型数据集中变量之间的有趣关系。它通常用于市场篮分析,例如,通过发现经常一起购买的商品,零售商可以调整他们的产品布局,促进交叉销售。

### 2.1.2 无监督学习在异常检测中的角色

异常检测是一个发现数据集中异常或偏差模式的过程。在安全、金融、医疗等领域,及时准确地识别异常非常重要。无监督学习算法可以处理未标记的数据,使得它在异常检测中具有独特的优势。

通过学习数据的正常模式,无监督学习算法可以识别出不符合这些模式的数据点作为异常。这种方法对于处理那些异常少见或未知的异常检测任务特别有效。无监督学习算法在异常检测中的作用不仅限于识别异常,还可以帮助进行特征工程,优化其他学习模型的性能。

## 2.2 常用无监督学习算法

### 2.2.1 聚类算法基础

聚类算法是无监督学习的核心技术之一,它将数据集中的对象分配到多个分组中,使得同组内的对象比不同组内的对象更相似。

#### K均值算法(K-means)

K均值算法是最经典的聚类方法之一。它通过迭代地更新数据点到最近的簇中心的分配来工作。算法的目的是最小化簇内距离的总和,这个距离是指每个点与分配给它的簇的中心之间的距离。K均值算法简单且易于实现,但需要预先确定簇的数量,对异常值敏感。

```python

from sklearn.cluster import KMeans

import numpy as np

# 假设 X 是包含数据点的 NumPy 数组

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 使用 KMeans 算法进行聚类

kmeans = KMeans(n_clusters=2, random_state=0).fit(X)

print("簇中心点:", kmeans.cluster_centers_)

print("每个数据点的簇分配:", kmeans.labels_)

```

#### 密度峰聚类(DBSCAN)

DBSCAN是一种基于密度的聚类算法,它将簇定义为高密度区域,这些区域由相互之间在一定邻域内且密度足够高的点组成。与K均值不同,DBSCAN不需要预先指定簇的数量,还能识别出任意形状的簇,并且对噪声和异常值具有鲁棒性。

```python

from sklearn.cluster import DBSCAN

from sklearn.datasets import make_blobs

# 创建一个含有噪声的聚类数据集

X, _ = make_blobs(n_samples=300, centers=2, cluster_std=0.60, random_state=0)

# 使用 DBSCAN 进行聚类

db = DBSCAN(eps=0.3, min_samples=10).fit(X)

labels = db.labels_

# DBSCAN 并不保证每个簇都有一个标签,它可能将某些点标记为噪声(-1)

print("聚类结果:", set(labels))

```

### 2.2.2 密度估计方法

密度估计方法在无监督学习中用来估计数据的概率分布。这些估计是基于数据点的局部密度来完成的,通常用于异常检测。

#### 核密度估计(Kernel Density Estimation, KDE)

核密度估计通过给定一组观测数据点,推断出数据的潜在概率分布。它利用核函数对数据点附近的概率密度进行加权。KDE是一种非参数方法,它不需要对数据的分布做出假设,能灵活地处理不同形状的数据分布。

```python

import numpy as np

import matplotlib.pyplot as plt

from sklearn.neighbors import KernelDensity

# 生成数据

X = np.concatenate([np.random.normal(0, 1, 300), np.random.normal(5, 1, 200)])

# 使用核密度估计估计概率密度

kde = KernelDensity(kernel='gaussian', bandwidth=0.5).fit(X.reshape(-1,1))

log_density = kde.score_samples(X.reshape(-1,1))

# 绘制结果

plt.hist(X, bins=30, alpha=0.5, density=True)

plt.plot(X, np.exp(log_density), 'k', linewidth=2)

plt.show()

```

### 2.2.3 子空间与流形学习技术

在处理高维数据时,数据实际上可能存在于一个低维的子空间或流形中。子空间学习和流形学习技术旨在发现这种低维结构,从而更好地理解数据的本质。

#### 主成分分析(PCA)

主成分分析是一种降维技术,它通过线性变换将数据转换到一个新的坐标系统中,使得数据在新的坐标系统中的最大方差在第一个坐标(即第一主成分)上,第二大方差在第二个坐标上,以此类推。PCA是无监督学习中最常用的降维方法之一。

```python

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

# 假定 data 是一个二维数据集

data = np.array([[0, 0], [1, 1], [2, 2], [3, 3]])

# 使用 PCA 进行降维,这里我们将数据降至1维

pca = PCA(n_components=1)

data_reduced = pca.fit_transform(data)

# 绘制降维后的数据

plt.scatter(data_reduced, [0]*len(data_reduced))

plt.yticks([])

plt.show()

```

#### 局部线性嵌入(LLE)

局部线性嵌入是一种非线性降维技术,它假设数据存在于一个较低维度的流形中,并尝试保留数据在局部邻域内的线性结构。LLE在降维的同时,尝试保持数据的局部和全局结构。

```python

from sklearn.manifold import LocallyLinearEmbedding

# 假定 data 是一个高维数据集

data = np.random.rand(100, 10)

# 使用 LLE 进行降维

lle = LocallyLinearEmbedding(n_components=2)

data_reduced = lle.fit_transform(data)

# 绘制降维后的数据

plt.scatter(data_reduced[:, 0], data_reduced[:, 1])

plt.show()

```

### 2.3 无监督学习的评估指标

评估指标是衡量无监督学习算法性能的重要工具。在无监督学习中,由于缺乏标签,我们不能使用标准的监督学习评估指标,如准确率。相反,无监督学习算法的评估需要基于数据的内在结构,或者通过假设检验。

#### 准确性、召回率和F1分数

虽然准确性、召回率和F1分数是常用的有监督学习评估指标,但在无监督学习中,我们可以用它们来评估聚类算法。在无监督学习中,这些指标需要通过真实簇和预测簇之间的比较来计算。

#### 调和平均与几何平均的应用

调和平均和几何平均是另一种评估聚类算法的方法。调和平均通常用于评估算法对簇内距离的敏感度,而几何平均则用于评估簇间距离。这些指标需要对聚类结果进行分析,比较聚类结果与真实分布的一致性。

在下一章中,我们将深入探讨异常检测技术的具体实现,包括不同类型异常的检测方法、经典算法及其实践技巧,以及如何构建实时异常检测系统。

# 3. 异常检测技术详解

## 3.1 异常检测的类型和挑战

异常检测作为无监督学习的一个关键应用场景,有其独特的分类和面对的挑战。理解这些类型和挑战对于设计和实现一个有效的异常检测系统至关重要。

### 3.1.1 点异常、上下文异常和集合异常

异常检测根据其特点可以分为点异常、上下文异常和集合异常。

- **点异常**(Point Anomalies)是指那些与数据集中的其他点显著不同的单个数据点。例如,在信用卡交易中,一笔极高的消费金额可能被识别为点异常。

- **上下文异常**(Contextual Anomalies)发生在特定上下文中视为异常但在其他上下文中可能完全正常的数据点。以温度传感器的数据为例,零下的温度在一个热带气候数据集中可能是个上下文异常。

- **集合异常**(Collective Anomalies)是指一组数据点的集合在统计意义上与其它数据点的集合不同,而不是单个数据点。一个简单的例子是在监控网络流量时,一组流量数据的突增可能表示了DDoS攻击,而单个的数据点可能看不出异常。

要检测这些类型的异常,需要采用不同的方法和策略。例如,点异常可以使用统计方法进行检测,上下文异常可能需要对数据上下文有深入理解,而集合异常的检测则更多依赖于数据序列或数据群组的分析。

### 3.1.2 大数据背景下的异常检测难题

大数据环境给异常检测带来了额外的挑战:

- **数据量巨大**:传统算法可能无法在合理的时间内处理如此庞大的数据

0

0