深入监督学习:过拟合与欠拟合的识别与处理策略

发布时间: 2024-09-02 08:19:06 阅读量: 147 订阅数: 64

# 1. 监督学习的基本概念

监督学习是机器学习中的一个重要分支,它涉及从带有标签的训练数据中学习一个模型,以便对新的、未见过的数据进行预测。在这一章节中,我们将初步探索监督学习的核心概念,包括标签、特征、模型以及预测等基本术语。

## 监督学习的基本原理

监督学习通常以分类和回归两种任务形式出现。在分类任务中,预测的目标是离散的标签,例如垃圾邮件检测中的“垃圾”或“非垃圾”。而在回归任务中,预测的目标是连续值,比如房价预测中的具体价格数值。

## 监督学习的数据结构

监督学习依赖于标注过的数据集,这些数据集包含输入特征(特征向量)和与之对应的输出标签。数据的质量和数量直接影响学习模型的性能。

## 监督学习的模型训练与预测

在模型训练阶段,我们使用算法对数据进行拟合,形成从输入到输出的映射关系。在预测阶段,新数据被输入模型中以得到输出结果。

通过理解这些基础知识,我们可以更好地进入后续章节,探讨如何解决监督学习中的过拟合与欠拟合问题,以及相关的预防策略和实际应用案例。

# 2. 过拟合与欠拟合的理论基础

### 2.1 监督学习中的模型复杂度

在监督学习中,模型的复杂度是影响其性能的关键因素之一。模型复杂度与模型的泛化能力紧密相关,合理选择模型复杂度是确保学习任务成功的重要环节。

#### 2.1.1 模型复杂度与泛化能力

模型复杂度可以理解为模型对数据复杂结构的捕捉能力,它主要受到模型结构的复杂性、参数的数量以及特征空间维度的影响。一般而言,一个模型的复杂度越高,其对训练数据的拟合能力越强,但这也可能带来泛化能力的下降。

**复杂度高**:如果模型过于复杂,模型可能不仅仅捕捉到了数据中的真实关系,还可能捕获了数据的噪声和异常值,这就是过拟合现象。过拟合的模型在训练数据上表现很好,但在未见数据上的表现会大打折扣。

**复杂度低**:相对的,如果模型过于简单,它可能无法充分捕捉数据中蕴含的复杂关系,即欠拟合现象。欠拟合的模型在训练数据上和未见数据上表现都不理想。

#### 2.1.2 过拟合与欠拟合的定义及其影响

过拟合和欠拟合是监督学习中经常遇到的两个主要问题。它们在不同程度上影响了模型的泛化能力。

**过拟合**:当一个模型过度学习了训练数据的特征,包括噪声和不重要的特征,而不能很好地推广到新的数据时,就发生了过拟合。过拟合的模型在训练集上的表现通常远好于测试集,表现为训练误差小而测试误差大。

**欠拟合**:相反,如果模型过于简单,无法捕捉数据的真实规律,使得模型在训练集和测试集上的表现都不理想,这种情况称为欠拟合。

### 2.2 过拟合与欠拟合的识别方法

有效识别过拟合和欠拟合是模型优化的第一步,以下是一些常用的识别方法。

#### 2.2.1 训练集与测试集表现差异分析

在机器学习中,通常将数据集分为训练集和测试集两部分。通过比较模型在训练集和测试集上的表现,可以直观地判断模型是否存在过拟合或欠拟合。

如果训练集上的表现明显优于测试集,可能发生了过拟合。相反,如果训练集和测试集上的表现都较差,可能是模型过于简单,发生了欠拟合。

```python

# 示例代码:使用scikit-learn评估模型

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建随机森林分类器

clf = RandomForestClassifier(n_estimators=100)

# 训练模型

clf.fit(X_train, y_train)

# 预测训练集和测试集

y_train_pred = clf.predict(X_train)

y_test_pred = clf.predict(X_test)

# 计算准确率

train_acc = accuracy_score(y_train, y_train_pred)

test_acc = accuracy_score(y_test, y_test_pred)

print(f"Train Accuracy: {train_acc:.2f}")

print(f"Test Accuracy: {test_acc:.2f}")

```

#### 2.2.2 学习曲线的绘制与解读

学习曲线是在不同的训练集大小下模型性能(通常是训练误差和测试误差)的图表展示。通过绘制学习曲线,可以更直观地理解模型是否过拟合或欠拟合。

如果模型过拟合,学习曲线会显示在训练集上误差较小,而在测试集上误差较大。如果模型欠拟合,学习曲线则会显示在训练集和测试集上的误差都较大。

```python

# 示例代码:绘制学习曲线

from sklearn.model_selection import learning_curve

import matplotlib.pyplot as plt

import numpy as np

def plot_learning_curve(estimator, X, y, title="Learning Curve", ylim=None, cv=None, n_jobs=None, train_sizes=np.linspace(.1, 1.0, 5)):

plt.figure()

plt.title(title)

if ylim is not None:

plt.ylim(*ylim)

plt.xlabel("Training examples")

plt.ylabel("Score")

train_sizes, train_scores, test_scores = learning_curve(

estimator, X, y, cv=cv, n_jobs=n_jobs, train_sizes=train_sizes)

train_scores_mean = np.mean(train_scores, axis=1)

test_scores_mean = np.mean(test_scores, axis=1)

plt.grid()

plt.plot(train_sizes, train_scores_mean, 'o-', color="r", label="Training score")

plt.plot(train_sizes, test_scores_mean, 'o-', color="g", label="Cross-validation score")

plt.legend(loc="best")

return plt

plot_learning_curve(clf, X, y, cv=10)

plt.show()

```

#### 2.2.3 正则化项的分析与应用

正则化是解决过拟合问题的常用技术之一。它通过对模型的复杂度进行惩罚,以期降低过拟合的风险。

在机器学习中,常见的正则化项有L1和L2正则化。L1正则化倾向于产生稀疏的权重矩阵,而L2正则化则倾向于降低权重值的大小,使权重分布更加平滑。

```python

# 示例代码:在scikit-learn中应用L2正则化

from sklearn.linear_model import RidgeClassifier

# 创建岭回归分类器(L2正则化)

ridge_clf = RidgeClassifier(alpha=1.0)

# 训练模型并绘制学习曲线

plot_learning_curve(ridge_clf, X, y, cv=10)

plt.show()

```

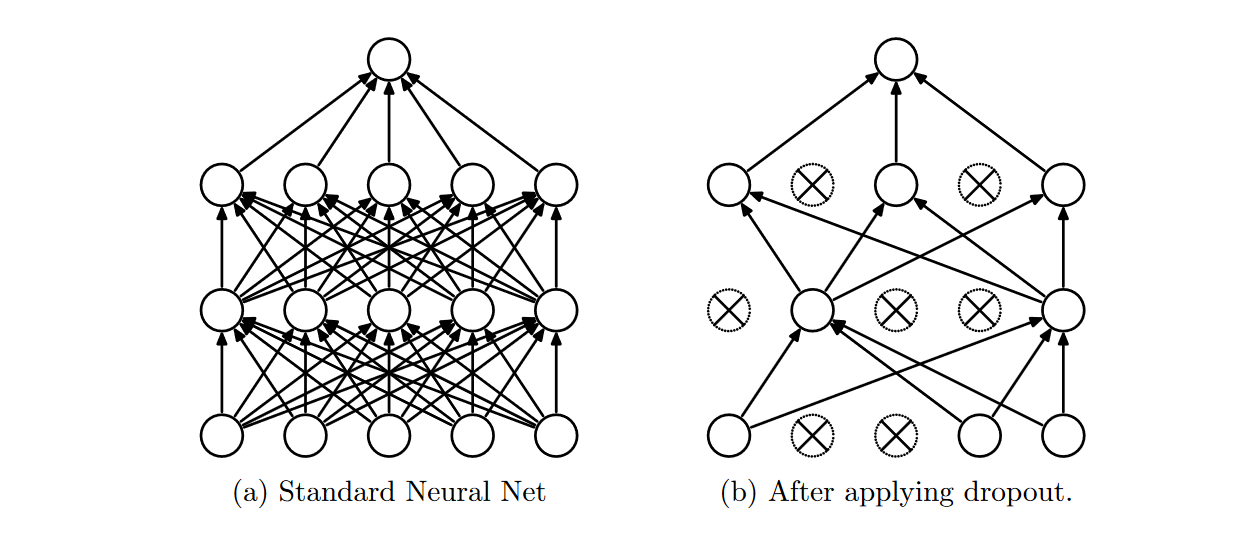

以上内容介绍了模型复杂度和过拟合、欠拟合的基本概念,识别方法以及正则化项的应用。在下一节中,我们将深入探讨预防过拟合与欠拟合的具体策略,包括数据增强、模型选择和优化,以及Dropout等技术的应用。

# 3. 预防过拟合与欠拟合的策略

## 3.1 数据增强与预处理

### 3.1.1 数据增强技术的应用

数据增强是机器学习领域中用于提高模型泛化能力的常用技术,尤其在图像和语音识别等领域,数据增强可以极大地增加样本的多样性,从而减少过拟合现象的发生。

数据增强技术的核心思想是通过对原始数据进行一系列变换来人工扩大数据集,这些变换包括但不限于旋转、缩放、裁剪、颜色变换、添加噪声、时间反转等。以图像数据为例,简单的旋转和翻转可以增加数据的多样性,使得模型不易记住特定的、不变的样本特征,而是学习到更为泛化的特征。

在代码层面上,数据增强可以通过各种图像处理库如Pillow或OpenCV实现。例如,使用Pillow库对图像进行随机旋转的Python代码片段如下:

```python

from PIL import Image, ImageEnhance

import random

def augment_image(image_path):

# 加载图像

img = Image.open(image_path)

# 随机旋转

angle = random.randint(-30, 30)

img = img.rotate(angle)

# 可以继续添加其他增强操作,如裁剪、缩放等

return img

```

在实际应用中,数据增强的策略选择应根据问题的特定需求而定。例如,在医学图像处理中,由于图像的特性,可能不会使用太激进的增强方式,而在自然图像处理中,则可以尝试更丰富的变换。

### 3.1.2 特征选择与降维方法

特征选择和降维是另一种预防过拟合的常用技术。通过移除冗余或无关的特征,可以减少模型学习过程中的噪声和方差,从而提高泛化能力。

特征选择通常有三种策略:过滤法、包装法和嵌入法。

- **过滤法**(Filter):使用统计测试对每个特征与标签之间的关系进行评估,根据得分排序特征,并选择顶部的特征。这种方法计算效率高,但可能忽略特征之间的相互作用。

```python

import numpy as np

from sklearn.feature_selection import SelectKBest, f_classif

def select_features_by_filter(X, y):

# 使用方差分析F检验选择特征

selector = Se

```

0

0