特征工程:无监督学习中的关键步骤详解

发布时间: 2024-09-02 08:39:57 阅读量: 146 订阅数: 74

支持向量机:SMO算法详解与实现路径

# 1. 特征工程概述

在机器学习领域,特征工程是将原始数据转化为机器学习模型可以理解的格式的过程。它涵盖了一系列的技术和方法,旨在通过创造性地改进特征来提高模型性能。特征工程的目标是减少数据维度、消除噪音、增强有用信息,以便能够更好地训练模型。

## 1.1 特征工程的重要性

在构建预测模型时,直接使用原始数据往往不能充分地挖掘数据中蕴含的信息。特征工程通过精心挑选和构造特征,能够显著提升模型的预测能力和准确性。例如,在图像识别任务中,通过特征提取技术,如边缘检测、颜色直方图等,能够提炼出图像中的关键信息,为分类器提供更有意义的输入。

## 1.2 特征工程的关键步骤

特征工程包括数据探索、特征选择、特征构造、特征提取等多个步骤。每个步骤都旨在改善数据质量,增强模型的泛化能力。数据探索阶段通过统计分析、可视化等手段来了解数据特性;特征选择则是识别并保留对模型预测最有价值的特征;特征构造和提取则通过数学变换来增强数据表达。

在实践中,特征工程需要结合具体问题进行定制化设计,它依赖于领域知识、统计分析和模型反馈来不断优化。通过对特征的深入理解和智能处理,可以大幅提高机器学习模型的性能,使其实现更准确的预测和更有效的决策。

# 2. 无监督学习的基础理论

无监督学习是机器学习中的一项重要分支,它不同于监督学习需要标签数据进行模型训练,无监督学习尝试在没有明确标签的情况下,从数据中发现隐藏的结构和模式。本章将探讨无监督学习的定义、应用场景、核心算法以及评估指标,帮助读者深入理解这一领域,并为后续章节中特征工程的应用打下坚实的基础。

### 2.1 无监督学习的定义和应用场景

#### 2.1.1 无监督学习的基本概念

无监督学习是机器学习的一种类型,其目的是从未标记的数据中学习数据的结构和分布,无需事先知道数据的具体输出。在无监督学习中,数据并没有事先定义的目标变量,算法必须在没有指导的情况下自我发现数据中的有趣结构。

无监督学习可以分为几个子领域,如聚类(将相似的对象组合在一起)、降维(降低数据的复杂度)、关联规则学习(发现数据项之间的有趣关系)等。这些技术被广泛应用于市场细分、社交网络分析、组织大型数据集、图像分割等多个领域。

#### 2.1.2 应用于数据挖掘和模式识别的实例

无监督学习在数据挖掘和模式识别中的应用非常广泛。以市场细分为例,通过聚类技术可以将消费者根据其购买行为分组,帮助商家更好地了解目标市场。在社交网络分析中,无监督学习可以揭示用户之间的关系模式,从而发现社交圈子的自然划分。

另一个应用实例是图像分割,无监督学习技术可以将图像中的对象分离开来,这在计算机视觉领域中尤为重要。例如,通过聚类算法,可以将图像中的像素点基于颜色、纹理等特征进行分组,从而实现对图像的自动分割。

### 2.2 无监督学习的核心算法

#### 2.2.1 聚类算法

聚类算法旨在将数据点划分为具有相似性质的多个组。K-means是聚类分析中最常用的算法之一。K-means的目标是将n个数据点分成k个簇,使得每个数据点属于离其最近的均值所代表的簇,以此来最小化簇内的平方误差总和。

```python

from sklearn.cluster import KMeans

import numpy as np

# 示例数据集

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 应用K-means算法

kmeans = KMeans(n_clusters=2, random_state=0).fit(X)

# 输出簇的中心点和分配给每个簇的数据点索引

print("Centers of clusters:")

print(kmeans.cluster_centers_)

print("Label of each point:")

print(kmeans.labels_)

```

#### 2.2.2 降维技术

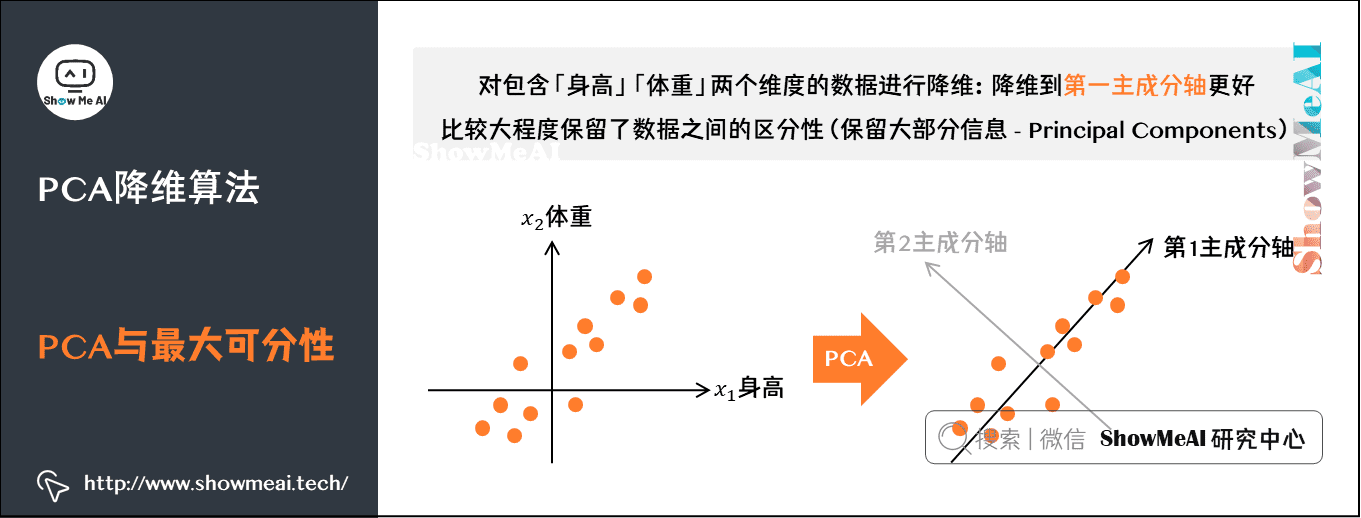

降维技术的目标是减少数据集中特征的数量,同时尽可能保留原始数据的重要信息。主成分分析(PCA)是降维领域中最著名的算法之一。PCA通过正交变换将一组可能相关的变量转换为一组线性不相关的变量,即主成分。

```python

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

# 示例数据集

X = np.array([[1, 2], [3, 4], [5, 6]])

# 应用PCA算法

pca = PCA(n_components=2)

X_reduced = pca.fit_transform(X)

# 绘制降维后的数据点

plt.scatter(X_reduced[:, 0], X_reduced[:, 1])

plt.title('PCA of the data')

plt.xlabel('First principal component')

plt.ylabel('Second principal component')

plt.show()

```

#### 2.2.3 关联规则学习

关联规则学习的目标是从大量数据中发现项目间的有趣关系。Apriori算法是一种广泛使用的关联规则学习算法,它通过迭代查找频繁项集来生成关联规则。频繁项集是指数据集中经常出现的项目组合。

### 2.3 无监督学习的评估指标

#### 2.3.1 聚类有效性评价

聚类的有效性评价通常用于衡量聚类结果的优劣。常见的评价指标包括轮廓系数(Silhouette Coefficient)、DB指数(Davies-Bouldin Index)和Calinski-Harabasz指数等。轮廓系数是一个介于-1和1之间的值,越接近于1表示聚类效果越好。

```python

from sklearn.metrics import silhouette_score

# 已有的聚类标签

labels = np.array([1, 1, 1, 2, 2, 2])

# 计算轮廓系数

score = silhouette_score(X, labels, metric='euclidean')

print("Silhouette Coefficient: %0.3f" % score)

```

#### 2.3.2 降维结果的评价方法

在降维后,需要一种方法来评估降维结果是否有效地保留了数据集的关键信息。常用的评价方法包括重构误差和保留的方差百分比。重构误差是通过将降维后的数据重构回原始维度后与原始数据的差异度量,而保留的方差百分比则是降维后各主成分方差占原始数据方差总和的百分比。

```python

# 计算保留的方差百分比

explained_variance = pca.explained_variance_ratio_

print("Explained variance ratio: %s" % str(explained_variance))

```

通过这些基础理论的介绍,下一章我们将深入探讨特征选择与提取的具体策略和技术,以及它们在机器学习和数据分析中的应用。

# 3. 特征选择与提取

在数据科学领域,"数据是新的石油"。这句话不仅仅象征着数据的重要性,也暗示了数据的丰富性和多样性。在面对庞大的数据集时,提取相关特征以提高模型性能和降低计算复杂度成了数据预处理中至关重要的一步。特征选择与提取正是实现这一目的的关键技术。本章将详细介绍特征选择的策略、方法以及特征提取技术,并通过案例分析展示这些技术在实际问题中的应用。

## 3.1 特征选择的策略与方法

特征选择的目的是识别并选取与目标变量最相关的特征子集。这样不仅可以减少数据的维度,还可以提高模型的预测性能,降低过拟合的风险。根据选择特征的方法不同,特征选择可以分为以下几种策略。

### 3.1.1 基于过滤的方法

基于过滤的方法依赖于各种统计测试来评估特征和目标变量之间的相关性。这些方法通常快速高效,但是它们不考虑特征间的交互关系。

一个常见的统计测试是卡方检验(Chi-Square Test),它用于分类特征和目标变量之间的独立性检验。其他测试如ANOVA F-test和互信息(Mutual Information)也被广泛使用。代码块3.1展示了如何使用Python的`scikit-learn`库来执行卡方检验。

```python

from sklearn.feature_selection import SelectKBest, chi2

# 假设X是我们的特征数据集,y是目标变量

X = ... # 特征数据

y = ... # 目标变量

# 选择最佳的k个特征

chi2_selector = SelectKBest(chi2, k=10)

X_k_best = chi2_selector.fit_transform(X, y)

# 获取被选中的特征名

selected_features = chi2_selector.get_support(indices=True)

```

在上述代码中,`SelectKBest`类用于选择最能代表目标变量的k个特征。`chi2`方法评估每个特征和目标变量之间的卡方值。通过这种选择,我们可以排除那些不显著的特征,加快学习过程,并减少过拟合的可能性。

### 3.1.2 基于包装的方法

与过滤方法不同,包装方法将特征选择看作是一个搜索过程,通过训练一个模型,并根据模型的表现来选择特征。

递归特征消除(Recursive Feature Elimination, RFE)是一种流行的包装方法。它通过递归地构建模型并选择最重要的特征来工作。代码块3.2演示了如何使用`RFE`方法选择特征。

```python

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

# 创建一个分类器

estimator = RandomForestClassifier(n_estimators=100)

# 使用RFE选择特征

selector = RFE(estimator, n_features_to_select=5, step=1)

selector = selector.fit(X, y)

# 获取被选中的特征名

selected_features = X.columns[selector.support_]

```

在代码块3.2中,我们使用了随机森林分类器作为基础模型,并指定希望选择的特征数量。`RFE`迭代地剔除最不重要的特征,直至达到指定的特征数量。

### 3.1.3 基于嵌入的方法

嵌入方法结合了过滤方法和包装方法的优点,通过在模型训练过程中内置特征选择来降低计算成本。

例如,岭回归(Ridge Regression)通过正则化系数对特征重要性进行排序。代码块3.3演示了如何使用岭回归进行特征选择。

```python

from sklearn.linear_model import RidgeCV

# 设置岭回归

```

0

0