卷积积分与神经网络基础:函数逼近与δ函数理解

需积分: 0 93 浏览量

更新于2024-08-05

收藏 594KB PDF 举报

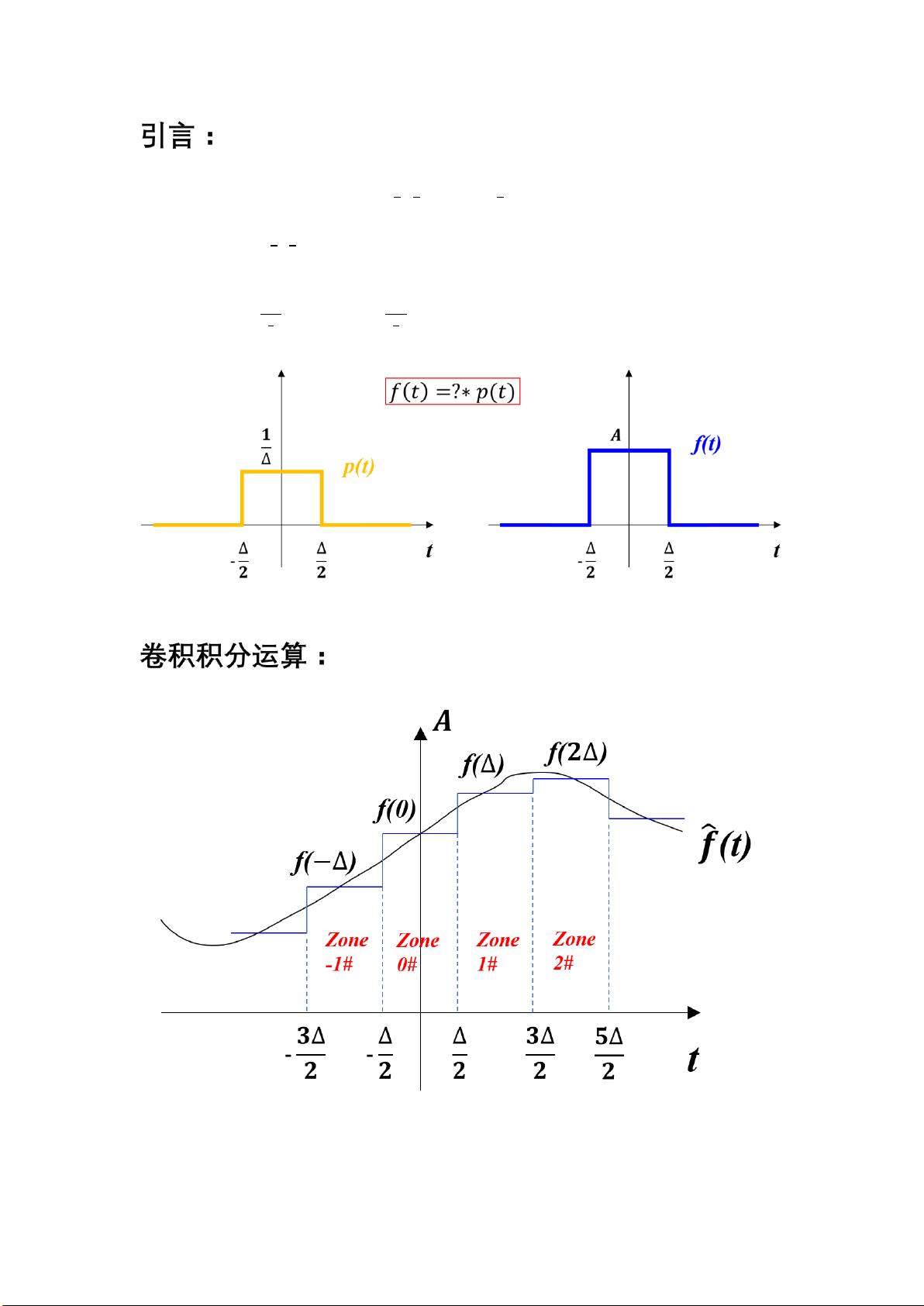

卷积积分和卷积神经网络在信号处理和深度学习领域中占据重要地位,特别是在图像和时间序列分析中。本节主要探讨了如何利用卷积操作来近似连续函数及其在神经网络中的应用。

首先,我们引入了一个示例,其中函数p(t)在区间(-Δ², Δ²)内取值1/Δ,其余区间为0。另一个函数f(t)同样有类似的结构,但取值为𝑨/Δ。问题是要确定f(t)相对于p(t)的放大倍数,答案是f(t)是p(t)的甲方/Δ倍,表示为f(t) = 𝑨/Δ * p(t)。

接着,我们讨论了卷积的概念。在数学上,任何函数f(t)都可以通过无限个“门函数”(宽度为δ,每个门函数对应函数在特定位置的值)的线性组合来逼近,即得到其傅立叶变换Fs(t)的近似表示Fs^(t)。这个过程可以表示为连续的卷积积分形式:

Fs^(t) ≈ ∑ Fs(nΔ) * Δ * p(t - nΔ), 其中n从负无穷到正无穷。

当δ非常小(趋近于0),离散卷积近似于连续积分,这可以用来推导出连续傅立叶变换的公式:

Fs(t) = lim(Δ→0) [∑ Fs(nΔ) * Δ * p(t - nΔ)], 这相当于Fs(t) = ∫Fs(ϕ) * p(t - ϕ) dϕ。

这里的σ(离散和)与积分的区别在于,当δ趋于零时,离散的δ函数(p(t))近似为δ(t),即单位脉冲函数,这是微积分中的基本概念。

卷积神经网络正是利用了这种卷积运算的思想,它们的层结构模仿了人脑处理信息的方式,通过局部感受野(类似于门函数)来提取输入数据的特征。在图像识别、语音处理等任务中,每一层的卷积核实际上是在执行一种滑动窗口的卷积操作,捕捉不同尺度和位置的特征,从而减少参数数量,提高模型的计算效率和泛化能力。

总结来说,本节内容展示了卷积积分在函数逼近和卷积神经网络中的核心作用,它不仅提供了一种高效处理信号的方法,还为构建复杂网络结构提供了理论基础。理解并掌握这些概念对于深入学习和应用神经网络至关重要。

2024-05-22 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

咖啡碎冰冰

- 粉丝: 18

- 资源: 292

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜