【进阶深度学习】:卷积神经网络深度剖析及其在物体识别中的高效应用

发布时间: 2024-09-06 17:02:34 阅读量: 31 订阅数: 32

深度学习d5:卷积神经网络基础;leNet;卷积神经网络进阶

# 1. 深度学习与卷积神经网络简介

## 1.1 深度学习的兴起

深度学习是机器学习的一个子领域,它通过建立、模拟人脑进行分析和学习的神经网络,对数据进行高级抽象。这使得计算机能够以更接近于人类的认知方式处理复杂的数据模式。卷积神经网络(CNN)是深度学习中最具代表性的模型之一,广泛应用于图像识别、语音识别以及各类数据的分类和回归分析。

## 1.2 卷积神经网络的特点

CNN的核心在于其卷积层和池化层的设计。卷积层能够自动提取输入数据的重要特征,而池化层则通过下采样减少数据维度,同时保留了重要的结构信息。这些特性使得CNN在处理图像和视频数据时显得尤为高效和准确。

## 1.3 CNN的应用领域

随着技术的不断演进,CNN已经被成功应用在多个领域,如自动驾驶、医学影像分析、视频监控和增强现实等。它的优势在于能够有效地减少对于特征工程的依赖,通过大量的数据学习自行提取有用特征,从而在各类任务中取得卓越的表现。

在下一章节中,我们将深入探讨卷积神经网络的理论基础,了解其核心概念及高级结构,并揭示它们如何让CNN在深度学习领域中占有一席之地。

# 2. 卷积神经网络的理论基础

## 2.1 卷积神经网络的核心概念

### 2.1.1 神经网络的基本组成

神经网络是深度学习的基石,包括卷积神经网络(CNN)在内的所有深度学习模型,都是由神经元组成的层级结构。神经元是网络的基本计算单元,每个神经元从输入信号接收加权求和,并经过一个激活函数计算,产生输出信号。在CNN中,神经元以一种特殊的方式组织,以处理图像或其他形式的多维数据。

#### 神经元的运算过程

神经元的工作原理可以用以下数学模型表示:

\[ y = f(\sum_{i=1}^{n} w_i x_i + b) \]

其中,\(x_i\) 表示输入信号,\(w_i\) 是与输入信号相连的权重,\(b\) 是偏置项,\(f\) 是激活函数,\(y\) 是神经元的输出。常见的激活函数包括ReLU、Sigmoid和Tanh等。

### 2.1.2 卷积层的工作原理

卷积层是CNN中最重要的组成部分之一,它通过滤波器(也称为卷积核)在输入数据上进行滑动,以此捕捉局部特征。

#### 卷积操作的数学解释

卷积层的核心是卷积操作,可以表示为:

\[ (X * W)(i,j) = \sum_{m=-k}^{k} \sum_{n=-k}^{k} X(i+m, j+n) \cdot W(m, n) \]

这里,\(X\) 是输入特征图,\(W\) 是滤波器,\(*\) 表示卷积操作,\(k\) 是滤波器的大小的一半,\((i,j)\) 表示输出特征图的位置。每个滤波器可以检测到不同的特征,例如边缘、角点等。

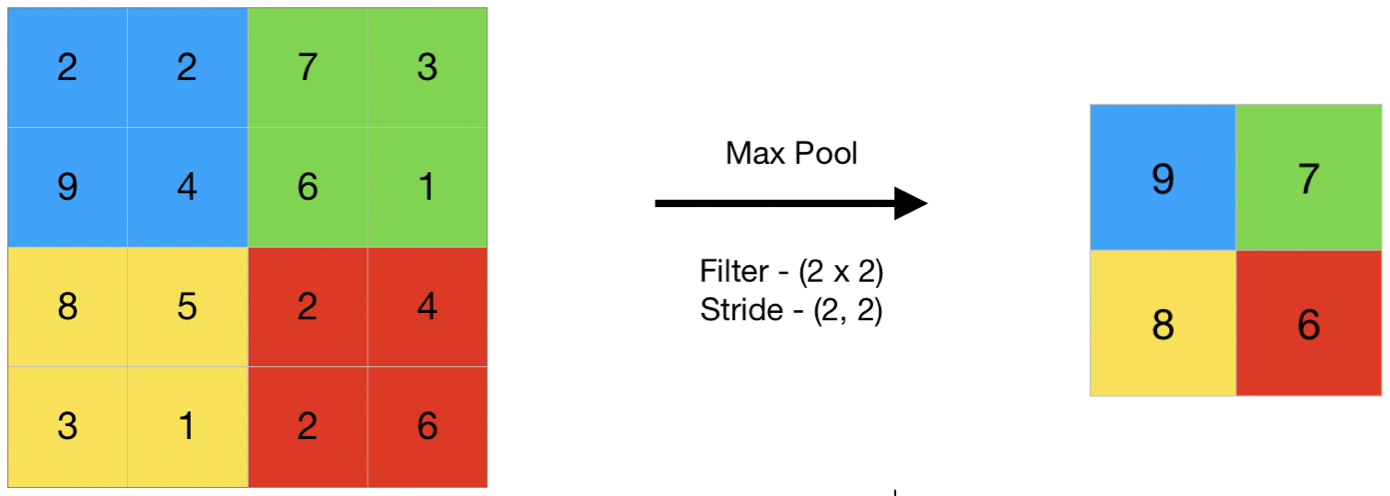

### 2.1.3 池化层的作用与效果

池化层(Pooling Layer)用于降低特征图的空间大小,减少参数数量和计算量,同时控制过拟合。

#### 池化层的常见方法

常见的池化方法包括最大池化(Max Pooling)和平均池化(Average Pooling)。例如,2x2的最大池化可以表示为:

\[ Pooling(X)(i,j) = max(X(i:i+1, j:j+1)) \]

### 2.2 卷积神经网络的高级结构

#### 2.2.1 残差网络(ResNet)的突破

残差网络通过引入“跳跃连接”(skip connections)来解决深度网络训练中的梯度消失和优化困难的问题。

#### 残差块的架构

残差块的数学公式可以表示为:

\[ Y = F(X, \{W_i\}) + X \]

其中,\(X\) 是输入,\(F\) 是两个或更多层的组合,\(+\) 表示逐元素相加。这种架构使得网络能够学习输入与输出之间的残差映射。

#### 2.2.2 反卷积与生成对抗网络(GAN)

反卷积是一种特殊的卷积操作,通常用于图像的上采样和生成对抗网络中的生成器部分。

#### 反卷积的原理

反卷积操作的数学模型与卷积操作类似,但滤波器在输入数据上以不同的方式进行滑动,使得输出特征图的大小增大。

#### 2.2.3 网络优化技术与正则化方法

网络优化技术指的是通过特定的算法和策略来改进网络训练过程中的效率和效果。

#### 常用的网络优化技术

常用的技术包括动量优化(Momentum)、自适应学习率算法(如Adam和RMSprop)等。

### 2.3 卷积神经网络在图像识别中的应用

#### 实现卷积神经网络的代码示例

在Keras中实现一个简单的卷积神经网络用于图像识别:

```python

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential([

Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 1)),

MaxPooling2D(pool_size=(2, 2)),

Flatten(),

Dense(128, activation='relu'),

Dense(1, activation='sigmoid')

])

***pile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

```

#### 深入分析卷积操作

在上述代码块中,`Conv2D`层实现了卷积操作。该层使用了32个3x3的滤波器,激活函数为ReLU。卷积操作从输入数据中提取特征,并通过激活函数引入非线性。

#### 正则化技术在CNN中的应用

为了防止过拟合,模型在Dense层后面通常会添加正则化项。例如:

```python

from keras.layers import Dropout

model.add(Dense(128, activation='relu', kernel_regularizer=keras.regularizers.l2(0.01)))

```

在这里,通过在全连接层后面添加L2正则化项,可以有效减少模型的过拟合风险。

## 2.2 卷积神经网络的高级结构

### 2.2.1 残差网络(ResNet)的突破

残差网络(Residual Network,简称ResNet)是深度学习领域的一个重要突破,特别是在图像识别和分类任务中。其设计理念源于解决深层网络中梯度消失问题,以及如何有效地训练深层网络。残差网络通过引入“残差学习”和“跳跃连接”(skip connections)使得网络能够更深,优化效率更高。

#### 残差块结构详解

残差网络的核心是残差块,每一个残差块都包含有一条或几条“捷径”,这些捷径直接将前面层的输出连接到后面的层上。具体来说,残差块中的一个典型操作是将输入 \(x\) 经过一些卷积操作得到 \(F(x)\),然后将 \(F(x)\) 和输入 \(x\) 相加得到 \(y = F(x) + x\)。通过这种方式,网络可以学习到一个残差映射 \(F(x) = y - x\),而不是直接学习原始映射。

```python

import keras

from keras.layers import Input, Conv2D, Add, BatchNormalization, Activation

from keras.models import Model

def residual_block(x, filters, kernel_size=3, stride=1, conv_shortcut=False):

shortcut = x

# 第一个卷积分支

x = Conv2D(filters, kernel_size, strides=stride, padding='same')(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

# 第二个卷积分支

x = Conv2D(filters, kernel_size, strides=stride, padding='same')(x)

x = BatchNormalization()(x)

# 如果输入和输出维度不一致,需要进行维度调整

if conv_shortcut:

shortcut = Conv2D(filters, 1, strides=stride, padding='same')(shortcut)

shortcut = BatchNormalization()(shortcut)

# 将两个分支相加

x = Add()([x, shortcut])

x = Activation('relu')(x)

return x

# 创建一个输入层

input_layer = Input(shape=(64, 64, 1))

x = residual_block(input_layer, 64, conv_shortcut=True)

model = Model(inputs=input_layer, outputs=x)

```

在上述代码中,构建了一个包含残差块的网络。如果输入和输出的维度不匹配,可以通过额外的卷积层(`conv_shortcut`)来调整维度,确保跳跃连接的可行性。

### 2.2.2 反卷积与生成对抗网络(GAN)

反卷积(Deconvolution)是一种技术,它在某些文献中也被称作转置卷积(Transposed Convolution)。虽然名字听起来像是卷积操作的逆过程,但实际上反卷积通常指的是一种用来放大图像尺寸的特殊卷积操作,常用于生成对抗网络(GAN)的生成器部分。

#### 反卷积操作详解

反卷积操作的目的是从低分辨率的特征图中重建出高分辨率的图像。反卷积操作通常与一个简单的卷积操作相反,其中权重是可训练的,并且通常伴随着上采样(upsampling)步骤。在上采样过程中,通常使用最近邻插值或双线性插值方法。

在GAN的生成器中,反卷积层可以用来逐步增加特征图的空间大小,将潜在空间的点转换成更加详细的图像。以下是一个简单的反卷积层的Keras实现示例:

```python

from keras.layers import Conv2DTranspose

# 假设输入是5x5的特征图,要通过反卷积操作得到10x10的输出

input_layer = Input(shape=(5, 5, 64))

x = Conv2DTranspose(64, (3, 3), strides=(2, 2), padding='same')(input_layer)

x = Activation('relu')(x)

model = Model(inputs=input_layer, outputs=x)

```

#### 生成对抗网络结构

生成对抗网络由两部分组成:生成器(Generator)和判别器(Discriminator)。生成器的任务是生成尽可能真实的数据样本,而判别器的任务是区分真实样本和生成器生成的假样本。两者在训练过程中不断对抗,以达到一个动态平衡。生成对抗网络在图像生成、超分辨率等任务中表现出色。

```python

from keras.layers import Dense, Reshape, Conv2D, Flatten, Input

from keras.models import Sequential

# 构建生成器模型

generator = Sequential([

Dense(256 * 2 * 2, activation='relu'),

Reshape((2, 2, 256)),

Conv2DTranspose(128, (5, 5), strides=(2, 2), padding='same', activation='relu'),

Conv2DTranspose(64, (5, 5), strides=(2, 2), padding='same', activation='relu'),

Conv2DTranspose(1, (5, 5), strides=(2, 2), padding='same', activation='tanh')

])

# 构建判别器模型

discriminator = Sequential([

Conv2D(64, (5, 5), strides=(2, 2), padding='same', input_shape=(64, 64, 1)),

Activation('relu'),

Dropout(0.3),

Conv2D(128, (5, 5), strides=(2, 2), padding='same'),

Activation('relu'),

Dropout(0.3),

Flatten(),

Dense(1, activation='sigmoid')

])

```

在上述示例中,生成器使用全连接层和反卷积层来从潜在空间中的点生成图像,而判别器则采用卷积层来区分真实图像和生成图像。

### 2.2.3 网络优化技术与正则化方法

网络优化技术在训练深度神经网络时扮演着至关重要的角色。这些技术的目标是加速训练过程并提高模型的性能。常见的优化技术包括动量优化、自适应学习率算法等。

#### 网络优化技术详解

动量优化(Momentum)是一种加速梯度下降的技术。它不仅考虑当前的梯度,还考虑之前梯度的累积效应。动量项可以减少梯度更新中的振荡,有助于快速找到最小值。

自适应学习率算法如Adam(Adaptive Moment Estimation)和RMSprop,是目前训练深度学习模型中最常用的方法之一。这些算法通过调整每个参数的学习率来提高模型的收敛速度和泛化能力。

```python

from keras.optimizers import Adam

# 创建Adam优化器实例,设置学习率和其他参数

adam = Adam(lr=0.001, beta_1=0.9, beta_2=0.999, epsilon=1e-08)

***pile(optimizer=adam, loss='binary_crossentropy', metrics=['accuracy'])

```

#### 正则化方法的实现

正则化方法是防止深度学习模型过拟合的常用手段。L1和L2正则化是最基本的正则化方法,它们通过在损失函数中加入权重的绝对值(L1)或平方值(L2)来限制模型的复杂度。

```python

from keras.regularizers import l1_l2

# 在全连接层中添加L1和L2正则化

model.add(Dense(128, activation='relu', kernel_regularizer=l1_l2(l1=0.01, l2=0.01)))

```

在上述代码中,为模型的全连接层添加了L1和L2正则化,其中L1和L2正则化项的系数均设置为0.01。这样的设置可以限制权重的大小,防止模型过度依赖于训练数据中的噪声和细节,从而提高模型的泛化能力。

# 3. 卷积神经网络的数学原理

## 3.1 线性代数在CNN中的应用

### 3.1.1 张量和向量的操作

卷积神经网络(CNN)中使用的基础数学结构是张量和向量。张量可以看作是高维数组,在CNN中用于表示特征图(feature maps)和卷积核(kernels)。向量则是张量的特殊情况,可以被视作单个的特征向量。在卷积操作中,卷积核实际上是一个低维的张量,通过在输入特征图上滑动并进行元素级的乘积累加,输出一个新的特征图。

在编程实现中,张量的操作一般借助于高级数值计算库,比如TensorFlow或PyTorch,这些库提供了张量的基本操作如加法、乘法等。例如,下面展示了一个简单的张量操作代码块,假设我们有两个张量`A`和`B`,我们需要对它们进行逐元素加法操作:

```python

import tensorflow as tf

# 创建两个随机张量

A = tf.random.normal((2, 3))

B = tf.random.normal((2, 3))

# 张量加法

C = tf.add(A, B)

# 输出结果

print(C.numpy())

```

在上述代码中,`tf.random.normal`用于生成符合正态分布的随机张量,`tf.add`用于执行两个张量的逐元素加法操作。输出的张量`C`是`A`和`B`的和。

### 3.1.2 卷积运算的数学表示

卷积运算在CNN中起着至关重要的作用。在数学上,二维离散卷积可以定义为输入特征图`F`与卷积核`K`的运算,输出为特征图`G`:

```

G[i,j] = ΣΣ F[m,n] * K[i+m,j+n]

```

其中`ΣΣ`表示对所有相关位置进行求和。

在实际操作中,卷积运算通常包含填充(padding)和步长(stride)的概念,这样可以更灵活地控制输出特征图的大小和信息提取的粒度。步长表示卷积核每次移动的像素数量,而填充则是指在输入特征图的边缘外围添加额外的行或列,以保持特征图的尺寸不变或按预期变化。

这里展示了一个使用卷积操作的简单例子,其中使用了填充和步长的概念:

```python

import tensorflow as tf

# 定义输入数据和卷积核

input_data = tf.random.normal((5, 5, 1, 1)) # 假设有一个5x5的单通道输入

kernel = tf.random.normal((3, 3, 1, 1)) # 3x3的卷积核

# 卷积操作,使用padding和stride参数

conv_layer = tf.keras.layers.Conv2D(filters=1, kernel_size=3, strides=1, padding='SAME')

output = conv_layer(input_data)

# 输出卷积结果

print(output.numpy())

```

在这个例子中,`Conv2D`是一个卷积层,其中`filters`定义了卷积核的数量,`kernel_size`定义了卷积核的尺寸,`strides`定义了卷积操作的步长,`padding`设为'SAME'表示使用零填充以保持输出特征图尺寸不变。

## 3.2 概率论与优化算法

### 3.2.1 损失函数的理解与选择

在训练CNN模型时,损失函数(Loss Function)是一个衡量模型预测值和实际值之间差异的函数。选择合适的损失函数对于模型的优化至关重要。在分类问题中,常用的损失函数有交叉熵损失(Cross-Entropy Loss);而在回归问题中,则可能使用均方误差损失(Mean Squared Error Loss)。

交叉熵损失函数的数学定义如下:

```

L(y, ŷ) = -Σ (y_i * log(ŷ_i) + (1 - y_i) * log(1 - ŷ_i))

```

其中,`y_i`是实际标签的二进制值,`ŷ_i`是模型预测的概率分布。

下面的例子展示了如何在Keras框架中使用交叉熵损失函数进行模型编译:

```python

import tensorflow as tf

from tensorflow.keras import losses

# 编译模型时,使用交叉熵损失函数

***pile(optimizer='adam', loss=losses.BinaryCrossentropy())

```

### 3.2.2 反向传播算法的深入探讨

反向传播算法是深度学习模型训练中的核心算法。它通过计算损失函数相对于模型参数的梯度来实现权重的优化。反向传播包括两个主要步骤:正向传播和反向传播。在正向传播中,数据通过网络产生预测;在反向传播中,计算损失函数关于每个权重的梯度,并通过梯度下降算法更新权重。

反向传播算法的数学表达可以概括为链式法则的应用,其核心是梯度的计算:

```

δL/δw_i = δL/δy * δy/δw_i

```

这里`L`表示损失函数,`w_i`是网络中某个权重,`y`是网络的输出,`δ`表示导数。

### 3.2.3 梯度下降法及其变体

梯度下降是一种优化算法,用于更新网络参数以最小化损失函数。标准梯度下降法每次迭代更新所有参数,而其变体如随机梯度下降(SGD)、批量梯度下降(Batch GD)、以及Mini-batch梯度下降则提供了不同粒度的数据更新机制,以提高训练效率并减少内存需求。

以下是一个简单的梯度下降更新权重的例子:

```python

# 假设有一个损失函数L对某个参数w的导数

gradient = compute_gradient_of_loss_with_respect_to_w()

# 更新参数的梯度下降步骤

w = w - learning_rate * gradient

```

在上述代码中,`compute_gradient_of_loss_with_respect_to_w`代表一个函数,它计算了损失函数关于参数`w`的梯度。然后,参数`w`根据计算出的梯度和学习率进行更新。

梯度下降的变体有如下特点:

- **随机梯度下降(SGD)**:每次更新使用一个样本来计算梯度,可能会导致更新过程不稳定。

- **批量梯度下降**:每次更新使用所有样本来计算梯度,较为稳定但计算成本高。

- **Mini-batch梯度下降**:介于两者之间,每次更新使用一个批次的样本来计算梯度,是实际中最常用的梯度下降方式。

# 4. 物体识别任务中的CNN应用

在深度学习的众多应用领域中,物体识别是最具挑战性和实用性之一。卷积神经网络(CNN)作为处理图像数据的利器,已经被广泛应用于物体识别任务。本章节将深入探讨在物体识别任务中应用CNN所面临的难点,以及如何通过实操技巧提高识别效率和准确性。

### 4.1 物体识别的技术难点

物体识别技术的难点主要体现在两个方面:图像数据的复杂性和识别任务的多样性。

#### 4.1.1 识别任务的挑战与需求

物体识别需要模型能够从图像中识别和定位不同的物体,这涉及到图像分割、分类和定位等多个环节。此外,实际应用中往往对识别的准确性和实时性有着极高的要求,比如在自动驾驶车辆中,对于交通标志、行人和其他车辆的实时准确识别是保障行车安全的关键。因此,挑战不仅在于如何设计一个准确率高的模型,还要考虑到模型的实时性、稳定性和可扩展性。

#### 4.1.2 数据集的构建与预处理

一个高效准确的CNN模型需要大量高质量的训练数据。数据集的构建需要考虑多样性、覆盖面和平衡性。数据预处理则包括图像的归一化、尺寸调整、增强等操作。预处理能减少过拟合的风险,提高模型的泛化能力。

### 4.2 CNN在物体识别中的实操技巧

在实际操作中,构建一个高效的物体识别系统需要在数据、模型和系统层面进行精细化操作。

#### 4.2.1 数据增强与模型选择

数据增强是一种有效的技术手段,它通过对原始图像进行旋转、缩放、裁剪、颜色变换等操作,人为地扩大训练集的规模和多样性。一个常见的实践是使用在线数据增强技术,如随机裁剪(Random Cropping)、水平翻转(Random Flipping)等。

在模型选择方面,根据实际需求选择合适的网络架构至关重要。目前较为流行的物体识别模型包括YOLO、SSD、Faster R-CNN等。这些模型在速度和准确性之间取得了不同程度的平衡。

```python

# 示例:使用Keras进行图像数据增强

from keras.preprocessing.image import ImageDataGenerator

data_gen = ImageDataGenerator(

rotation_range=30,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest')

# 使用data_gen生成增强后的图像数据

train_generator = data_gen.flow_from_directory(

'path_to_train_data',

target_size=(224, 224),

batch_size=32,

class_mode='categorical')

```

在上述代码中,我们使用了Keras的ImageDataGenerator来进行在线数据增强。通过设置不同的参数,如旋转范围、尺寸变化、剪切变换等,我们可以生成新的训练样本,增加数据的多样性。

#### 4.2.2 实时物体识别系统构建

对于需要实时响应的应用场景,如视频监控或自动驾驶,构建一个高效的实时物体识别系统是关键。这通常需要一个优化过的模型,能够在保持准确性的同时降低计算资源的消耗。在模型优化方面,可以采用一些模型压缩技术,例如剪枝、量化、知识蒸馏等。

```mermaid

graph LR

A[原始模型] --> B[剪枝技术]

B --> C[模型裁减]

C --> D[量化与二值化]

D --> E[知识蒸馏]

E --> F[优化后的高效模型]

```

在上图中,我们通过模型压缩技术来优化原始模型,依次进行剪枝、量化和知识蒸馏,最后得到一个既快速又准确的模型。

#### 4.2.3 模型训练、验证与测试

模型训练和评估是任何机器学习项目的基石。在物体识别任务中,需要对模型进行充分的训练和验证,同时要保证评估指标的全面性和准确性。通常会使用准确率、召回率、mAP(mean Average Precision)等多种指标对模型进行评估。

```python

# 示例:使用mAP评估模型性能

from sklearn.metrics import average_precision_score

# 假设predictions是模型的输出预测,labels是真实标签

average_precision = average_precision_score(labels, predictions)

print(f"mAP: {average_precision:.3f}")

```

在上述代码中,我们使用了`sklearn`库的`average_precision_score`函数来计算模型的mAP值。mAP是物体识别任务中常用的评估指标,它综合考虑了不同类别物体的识别准确度。

物体识别是计算机视觉领域中一个非常活跃的研究方向,随着技术的不断进步,我们期待未来CNN在物体识别任务中将展现出更大的潜力和应用前景。

# 5. ```

# 第五章:CNN优化与性能提升策略

在上一章中,我们深入了解了卷积神经网络(CNN)在物体识别任务中的应用和实操技巧。本章将探讨如何进一步提升CNN的性能和优化模型,包括模型压缩与加速技术以及如何提高模型的泛化能力。我们将深入到具体的实现细节,并分析如何将这些策略应用到实际问题中去。

## 5.1 模型压缩与加速技术

随着深度学习模型变得越来越复杂,它们对计算资源的需求也不断增加。对于需要在资源受限的设备上运行的模型,或者需要优化运行时间以实现实时应用的情况,模型压缩和加速技术显得尤为重要。

### 5.1.1 网络剪枝与量化

网络剪枝是一种有效减少模型大小和计算需求的方法。它通过移除神经网络中不重要的连接或神经元来“剪掉”网络的“冗余”部分,以达到简化模型的目的。

**代码块示例:网络剪枝伪代码**

```python

def prune_network(model, sparsity_target):

# 初始化剪枝参数

weights = model.get_weights()

pruned_weights = []

pruned_structure = []

for layer in model.layers:

# 对于每一层,找到权重绝对值最小的那些连接

weight_shape = layer.get_weights()[0].shape

flat_weights = layer.get_weights()[0].flatten()

threshold = np.percentile(np.abs(flat_weights), sparsity_target)

# 生成新的权重结构,排除掉权重值小于阈值的连接

new_weights = np.where(np.abs(flat_weights) >= threshold, flat_weights, 0).reshape(weight_shape)

pruned_weights.append(new_weights)

pruned_structure.append(new_structure)

# 重新设置模型权重

model.set_weights(pruned_weights)

return model

# 假设 sparsity_target 是剪枝的目标稀疏度,例如 0.5 表示保留 50% 的连接。

```

**参数说明和逻辑分析:**

在上述伪代码中,我们首先获取模型的权重,并将它们展平。然后,我们计算每个权重的百分位数阈值,这个阈值用来决定哪些权重将被剪枝掉。在本例中,如果`sparsity_target`设为0.5,那么所有权重绝对值小于它们各自层权重百分位数中50%的权重将被置为0。最后,我们将修剪后的权重重新设置到模型中。

### 5.1.2 硬件加速与部署平台

为了进一步提高CNN的运行速度,可以利用专用硬件,如GPU、TPU或FPGA等,进行加速。此外,使用深度学习框架提供的模型部署解决方案,如TensorRT或ONNX,可以帮助我们在不同的平台上部署经过优化的模型。

**表格展示:不同部署平台与加速器比较**

| 平台/加速器 | 适用场景 | 优势 | 劣势 |

| ------------ | --------- | ---- | ---- |

| TensorFlow Lite | 移动和嵌入式设备 | 轻量化、优化的运行时环境 | 模型大小和性能优化之间需要权衡 |

| NVIDIA TensorRT | 数据中心 | 针对GPU优化,高性能推理 | 仅限NVIDIA硬件 |

| OpenVINO | 边缘计算 | 优化跨平台部署 | 可能需要额外的适配工作 |

| ONNX | 多平台 | 标准化的模型格式,易于转换 | 模型优化程度不如专用工具 |

## 5.2 模型泛化能力的提升

泛化能力是指模型对于未知数据的预测能力。在实际应用中,我们往往希望模型不仅在训练数据上表现良好,而且能有效地泛化到新的、未见过的数据。

### 5.2.1 迁移学习在物体识别中的应用

迁移学习是一种机器学习范式,它涉及到将从一个任务中学到的知识迁移到另一个相关但不同的任务上。在物体识别中,可以使用在大规模数据集(如ImageNet)上预训练的模型,并将其迁移到特定物体识别任务中。

**流程图展示:迁移学习流程**

```mermaid

graph TD

A[开始] --> B[预训练模型选择]

B --> C[预处理目标数据集]

C --> D[微调模型]

D --> E[评估和优化模型]

E --> F[部署模型]

```

### 5.2.2 增强学习与多任务学习

增强学习是一种提高模型泛化能力的技术,通过引入经过变换的训练样本,可以迫使模型学习到更鲁棒的特征表示。而多任务学习允许模型在一个共享的表示上学习执行多个相关任务,这有助于提高模型的泛化能力。

**代码块示例:多任务学习框架伪代码**

```python

def multi_task_learning(model, tasks):

# 初始化共享层

shared_layers = create_shared_layers()

# 为每个任务创建专用层

task_specific_layers = []

for task in tasks:

task_layers = create_task_specific_layers()

task_specific_layers.append(task_layers)

# 损失函数汇总

total_loss = 0

for task_layers, task_data in zip(task_specific_layers, tasks):

predictions = forward(shared_layers, task_layers, task_data)

loss = compute_loss(task_data, predictions)

total_loss += loss

# 反向传播和优化

total_loss.backward()

optimizer.step()

return total_loss

# 这里假设已经定义了 create_shared_layers、create_task_specific_layers、forward 和 compute_loss 函数。

```

**参数说明和逻辑分析:**

上述伪代码展示了一个多任务学习框架的基本结构。首先,我们定义了共享层,它们将在所有任务中共享权重。然后,对于每个任务,我们创建了一组专用层,用于学习任务特定的特征。在前向传播过程中,输入数据通过共享层和专用层来生成预测。计算每个任务的损失并将它们汇总,然后进行反向传播和参数更新。这样可以确保模型同时考虑所有任务的损失,从而提高泛化能力。

以上各节详细介绍了提升CNN性能的策略,包括模型压缩和加速技术以及如何提升模型的泛化能力。这些策略可以显著地改善模型的效率和效果,为在各种复杂环境下的应用提供了有力支持。接下来,我们将探讨CNN在现实世界中的应用案例,并展望未来的发展趋势。

```

# 6. 案例分析与未来趋势

在这一章节,我们将深入探讨卷积神经网络(CNN)在不同领域的典型应用案例,并对CNN的未来发展趋势进行展望。通过案例分析,我们将揭示CNN在实际中的强大能力,同时也探讨其在前沿技术影响下可能出现的变革。

## 6.1 典型应用案例研究

CNN在各个行业中得到了广泛应用,不仅限于视觉识别,还包括了语音处理、自然语言处理等多个领域。接下来,我们将以两个子章节来详细探讨CNN在不同场景中的实际应用。

### 6.1.1 行业特定物体识别案例

在医疗行业,CNN被用于病变组织的检测和分类,极大提升了医学图像分析的准确性和效率。通过使用预先训练好的网络,分析医学影像资料,比如X光片、MRI图像等,医生能够迅速发现异常,及时进行诊断。例如,在乳腺癌检测中,CNN可以辅助放射科医师分析哺乳动物摄影图像,从而提高诊断的准确率。

在自动驾驶领域,物体检测是核心任务之一。CNN被广泛应用于实时的交通场景感知,如行人、车辆和交通标志的识别。以特斯拉的Autopilot为例,它使用CNN处理摄像头捕捉的图像,识别路面情况,做出快速反应,确保行驶安全。

### 6.1.2 商业产品中的应用实例

在智能手机领域,许多厂商集成了使用CNN技术的摄影软件来提升拍照质量。例如,苹果的iPhone使用深度学习算法进行场景识别和图像优化,以实现智能HDR、人像模式等功能。

在零售行业,Amazon Go无人便利店运用CNN来实现商品识别和自动结账。顾客只需从货架上拿取商品离开,CNN系统会自动检测并记录顾客的行为,最后通过绑定的账户进行扣款,大大提高了购物效率。

## 6.2 卷积神经网络的未来展望

在不断进步的计算能力、大数据和先进算法的推动下,CNN将继续发展,并在新的技术浪潮中发挥关键作用。接下来,我们将探讨新兴技术对CNN的影响和未来可能的研究方向。

### 6.2.1 新兴技术对CNN的影响

随着量子计算的发展,未来的CNN可能会受益于量子增强的计算能力,实现更高维度的数据处理和复杂模型的优化。同时,边缘计算的兴起也预示着数据处理将逐渐向终端设备转移,这要求CNN模型变得更加轻量级,能够高效运行在资源受限的设备上。

在人工智能伦理和隐私保护方面,联邦学习等技术允许分布式学习而不需要将数据从源头转移,这将对CNN在隐私敏感领域的发展起到推动作用。

### 6.2.2 前沿研究与发展方向

未来的研究可能集中在自适应和可解释的CNN模型上。自适应网络能够根据不同的输入动态调整网络结构,而可解释的模型有助于我们更好地理解模型决策的过程,增强用户对AI系统的信任。

此外,跨模态学习是一个极具潜力的方向,CNN与其他类型的学习模型结合,能够处理和理解多种类型的数据,如图像、音频和文本的综合分析,这将极大地拓展CNN的应用范围。

在CNN的进一步发展过程中,将会有更多前沿技术和研究方法涌现出来,为我们的生活带来更加智能化的变革。

0

0