【深度学习研究前沿】:神经架构搜索在物体识别中的革新进展

发布时间: 2024-09-06 17:49:04 阅读量: 104 订阅数: 32

免费的防止锁屏小软件,可用于域统一管控下的锁屏机制

# 1. 深度学习与物体识别的理论基础

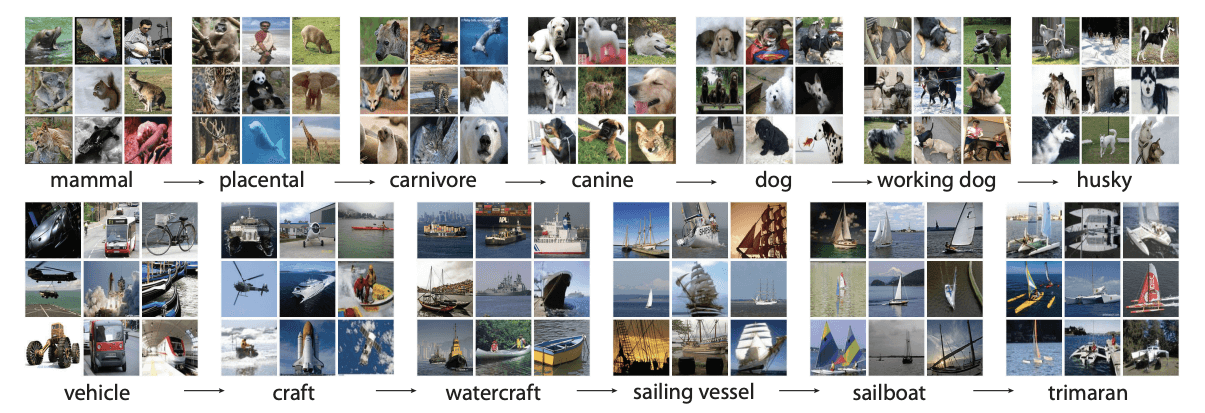

在现代计算机视觉领域,深度学习已经成为推动技术进步的核心力量之一,而物体识别则是深度学习中的一个重要研究方向。物体识别,又称为物体检测或物体分类,是指利用计算机算法识别出图像中的物体并定位其位置的过程。深度学习通过构建多层次的神经网络模型,可以自动学习和提取图像中的特征,这些特征对于物体识别任务至关重要。

### 1.1 深度学习的基本概念

深度学习属于机器学习的范畴,其核心在于利用深度神经网络(Deep Neural Networks,DNN)模拟人脑的工作方式,通过多层非线性变换对高维数据进行特征学习和表示。在物体识别任务中,深度学习模型能够自动提取图像的高级语义特征,进而提高识别的准确度和速度。

### 1.2 卷积神经网络(CNN)的角色

在物体识别中,卷积神经网络(CNN)由于其卓越的图像处理能力而被广泛应用。CNN通过卷积层自动学习图像的局部特征,并通过池化层降低特征维度,最终在全连接层实现分类或定位。在这一过程中,CNN利用其参数共享和局部连接的特性,极大地减少了模型的复杂度,提高了模型的泛化能力。

### 1.3 深度学习与传统机器学习方法的对比

与传统的机器学习方法相比,深度学习模型无需手动设计特征提取器,减少了人为偏见,且能够处理更加复杂和抽象的任务。此外,深度学习方法能够从大规模数据中学习到更加鲁棒和具有区分性的特征表示,这在解决实际的物体识别问题时展现出了显著的优势。尽管深度学习模型的训练过程往往更加复杂,计算资源要求更高,但是随着硬件技术的发展和优化算法的提出,这些难题正在逐步被克服。

通过理解深度学习和物体识别的理论基础,我们为进一步探索神经架构搜索(NAS)技术在物体识别中的应用打下了坚实的基础。NAS作为一种自动化设计深度神经网络的方法,旨在通过搜索来发现最优的网络架构,以实现更高的识别性能和效率。在接下来的章节中,我们将详细探讨NAS的原理、关键算法以及在物体识别中的应用。

# 2. 神经架构搜索(NAS)技术概述

神经架构搜索(Neural Architecture Search, NAS)是深度学习领域的一个创新研究方向,旨在通过自动化的方法寻找最优的神经网络架构,以解决特定任务。NAS通过搜索最佳的网络结构来提升模型性能,并减少人工设计网络架构的时间和精力。

### 2.1 神经架构搜索的定义和原理

#### 2.1.1 NAS的起源和发展历程

NAS的研究起源于计算机视觉领域,它试图解决传统手工设计网络架构存在的效率低和性能局限的问题。NAS技术的发展历程可以追溯到2017年,当时Google提出了基于强化学习的NAS模型,标志着NAS技术的正式诞生。随着研究的深入,NAS技术不断演化,涌现出了基于梯度下降、进化算法以及贝叶斯优化等不同搜索策略的NAS方法。

#### 2.1.2 NAS的基本工作流程

NAS的工作流程通常包括以下几个步骤:

1. **定义搜索空间**:确定可以探索的网络架构的范围,包括层数、类型的连接方式等。

2. **选择搜索算法**:根据问题的复杂度和性能需求,选择合适的搜索算法,如梯度下降、进化算法、强化学习等。

3. **评估候选架构**:使用代理模型或实际训练与验证数据集来评估搜索得到的候选架构性能。

4. **选择最优架构**:从所有候选架构中选择性能最佳的架构作为最终模型。

5. **模型训练与验证**:对选定的架构进行充分训练,并通过测试数据集进行验证,确保模型的泛化能力。

NAS工作流程可以通过下面的表格进一步了解:

| 步骤 | 描述 | 示例方法 |

|------|------|----------|

| 定义搜索空间 | 明确网络架构可能的变化范围 | 限制层数、连接方式等 |

| 选择搜索算法 | 根据问题特性选择搜索策略 | 梯度下降、进化算法、强化学习 |

| 评估候选架构 | 使用代理模型或实际数据集进行性能评估 | 验证集上的准确率、F1分数等 |

| 选择最优架构 | 根据性能指标挑选最佳架构 | 基于性能指标排序 |

| 模型训练与验证 | 对最终架构进行训练和测试 | 使用独立测试集进行评估 |

### 2.2 NAS的关键算法与方法

#### 2.2.1 梯度下降法和进化算法在NAS中的应用

梯度下降法是深度学习中常用的优化算法,其通过计算损失函数关于参数的梯度来迭代优化参数值。在NAS中,梯度下降可以用来优化架构参数,从而引导搜索过程。而进化算法则模拟自然选择过程,通过选择、交叉和变异等操作在多代架构中进化出优秀的网络结构。

下面是一个基于梯度下降法的伪代码示例,用于优化一个简单的网络架构参数(网络层数、层宽度等):

```python

# 伪代码:基于梯度下降法优化网络架构参数

def gradient_descent_architecture_search(architecture_params, loss_function):

learning_rate = 0.01

for epoch in range(num_epochs):

gradients = compute_gradients(architecture_params, loss_function)

architecture_params -= learning_rate * gradients

return architecture_params

# 计算损失函数关于架构参数的梯度

def compute_gradients(architecture_params, loss_function):

# 模拟计算梯度的过程(在实际中需要具体的梯度计算过程)

gradients = ...

return gradients

# 使用梯度下降法进行NAS

optimal_architecture = gradient_descent_architecture_search(initial_architecture_params, loss_function)

```

在使用梯度下降法进行NAS时,需要注意架构参数的离散性问题。通常需要借助一些技巧来处理这种离散性问题,例如通过Gumbel Softmax技巧或基于强化学习的策略。

#### 2.2.2 基于强化学习的NAS方法

强化学习是一种机器学习范式,通过奖惩机制训练智能体(agent)在环境中采取行动,以最大化累积奖励。在NAS中,智能体负责搜索和选择最优的网络架构,而奖励则根据架构在验证集上的性能来确定。

下面是一个基于强化学习的NAS伪代码示例:

```python

# 伪代码:基于强化学习的NAS方法

class NASAgent:

def __init__(self, environment):

self.environment = environment

def act(self, state):

# 智能体根据当前状态采取行动

action = ...

return action

def learn(self, reward):

# 智能体根据收到的奖励更新策略

self.update_policy(reward)

# 创建NAS环境和智能体

nas_environment = NASEnvironment()

agent = NASAgent(nas_environment)

# NAS主循环

for episode in range(num_episodes):

state = nas_environment.reset()

done = False

while not done:

action = agent.act(state)

next_state, reward = nas_environment.step(action)

agent.learn(reward)

state = next_state

```

在这个伪代码中,`NASAgent`代表智能体,它在给定的环境中根据当前状态选择行动,并根据行动后的奖励更新自己的策略。`NASEnvironment`代表NAS环境,它为智能体提供状态信息,并根据智能体的行动更新自己的状态,同时给出相应的奖励。

### 2.3 NAS在物体识别中的优势与挑战

#### 2.3.1 NAS提升物体识别性能的实例

NAS在物体识别任务中展现出了卓越的潜力,能够通过自动化的方式发现前所未有的高性能网络架构。例如,在ImageNet分类任务中,NAS网络可以达到与手工设计网络相媲美的性能,同时减少了大量的人工设计工作。

#### 2.3.2 NAS面临的技术难题和未来方向

NAS技术尽管潜力巨大,但也面临不少挑战,如搜索过程的计算成本高昂、搜索空间的规模庞大且难以确定等。未来NAS的研究方向可能会着重于减少搜索成本、提高搜索效率、提升模型的泛化能力以及增强模型的可解释性。

通过分析NAS技术在物体识别领域中的优势与挑战,可以看出NAS在自动化网络架构设计方面具有广阔的应用前景。随着算法和计算资源的不断进步,NAS有望在更多领域

0

0