【深度学习模型解释性】:揭开物体识别模型背后的秘密,理解模型工作原理

发布时间: 2024-09-06 18:03:24 阅读量: 82 订阅数: 29

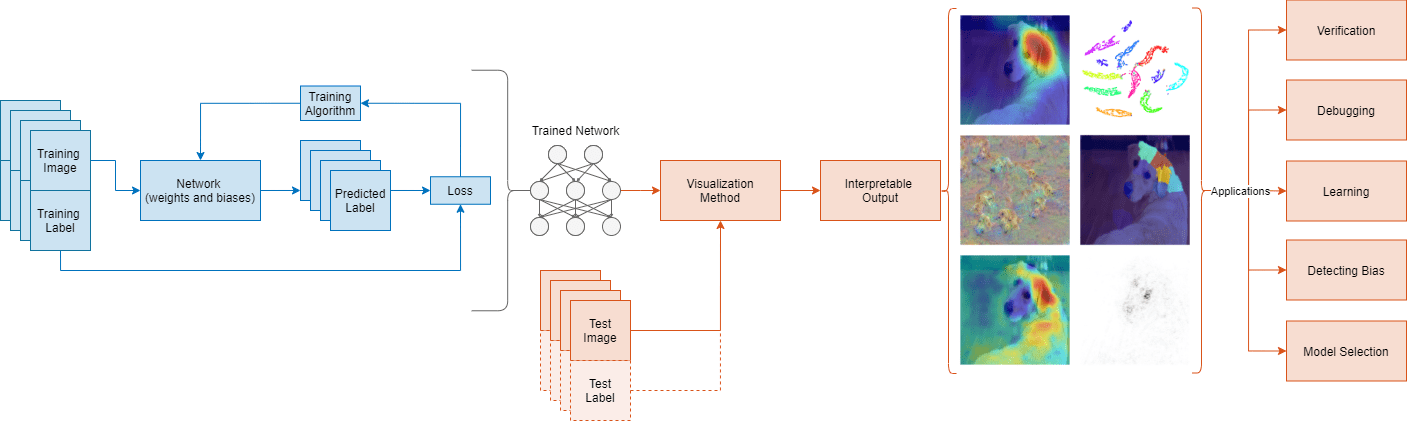

# 1. 深度学习模型解释性的概述

## 深度学习模型解释性的必要性

在深度学习领域,模型的解释性是理解模型预测和决策过程的关键。随着深度学习在众多行业中的广泛应用,模型的可解释性对于提升用户信任、促进透明度以及遵守法律法规变得越来越重要。模型解释性帮助我们识别模型内部的决策过程,评估预测的可靠性,从而对模型做出改进。

## 解释性与深度学习模型的可信赖度

随着深度学习模型的复杂性增加,解释性成为评估和保证模型可信赖度的一个核心要素。缺乏解释性可能导致错误的预测结果,而无法被有效识别和纠正。一个具备良好解释性的模型,其决策过程更加透明,有助于数据科学家和相关利益相关者理解模型的限制和潜在偏差。

## 提升模型透明度的途径

为了增强模型的透明度,研究者和工程师开发了多种技术和方法,比如特征可视化、局部可解释模型-拟合方法(LIME)、SHAP等,这些工具可以从不同角度揭示模型的内部工作机制。在本章,我们将探讨这些方法背后的基本原理,并说明它们如何帮助我们构建更加可靠和可解释的深度学习模型。

# 2. 物体识别模型的基础理论

## 2.1 卷积神经网络(CNN)的工作原理

### 2.1.1 CNN的基本结构和层次

卷积神经网络(CNN)是深度学习领域用于图像和视频识别的主导架构,它被广泛应用于物体识别、图像分类、医疗影像分析等众多领域。CNN通过其独特的层次结构来捕捉输入数据的空间层级关系。

在CNN中,数据以图像的形式输入,并通过一系列的层来处理。这些层主要分为三大类:卷积层、池化层和全连接层。

- **卷积层(Convolutional Layer)**:通过多个卷积核(或滤波器)在输入数据上滑动,进行点乘计算,提取数据的特征。每一个卷积核负责捕捉一个或多个特定特征,如边缘、角点或纹理模式。

- **池化层(Pooling Layer)**:在卷积层之后,负责降低特征图(feature map)的空间尺寸,减少计算量和参数数量,同时保留特征图中的主要信息。常见的池化操作有最大池化(Max Pooling)和平均池化(Average Pooling)。

- **全连接层(Fully Connected Layer)**:在网络的最后阶段,全连接层将前面层提取的特征映射到最终的输出,如分类标签。这一层通常用来进行决策逻辑的建立。

```mermaid

graph LR

A[Input Image] --> B[Convolutional Layer]

B --> C[Pooling Layer]

C --> D[Convolutional Layer]

D --> E[Pooling Layer]

E --> F[Fully Connected Layer]

F --> G[Output]

```

### 2.1.2 卷积层、池化层和全连接层的作用

卷积层的作用在于能够通过学习到的特征提取器(即滤波器)来提取图像的局部特征,这些特征对于图像识别是非常重要的。通过堆叠多层卷积层,CNN可以学习到从低级到高级的特征表示。

池化层主要作用是降低特征维度,减少过拟合的风险,并使特征检测具有一定的空间不变性。比如,最大池化能够保留最显著的特征,忽略掉一些不那么显著的信息。

全连接层则整合了前面层提取的所有特征,并通过加权求和和非线性变换后,给出最终的决策或预测结果。它相当于在进行一个复杂的决策过程,将前面提取的特征进行组合和解读。

```mermaid

flowchart LR

A[Input] --> B[Convolutional Layer]

B --> C[Activation Function]

C --> D[Pooling Layer]

D --> E[Convolutional Layer]

E --> F[Activation Function]

F --> G[Pooling Layer]

G --> H[Fully Connected Layer]

H --> I[Output]

```

## 2.2 深度学习中的特征提取和学习

### 2.2.1 特征图和激活函数的角色

在CNN中,特征图(feature map)是卷积层输出的结果,它记录了每个卷积核在输入图像上的响应。每个卷积核生成一张特征图,不同的特征图代表了对输入图像不同特征的检测。

激活函数用于给网络增加非线性因素,因为现实世界中的数据具有非线性特征,激活函数允许模型捕捉和学习这些非线性特征。最常用的激活函数之一是ReLU(Rectified Linear Unit),它通过设定负值为零来增加非线性,同时也帮助缓解梯度消失的问题。

### 2.2.2 损失函数和反向传播算法

损失函数用来量化模型预测值与真实值之间的差异,它在训练过程中衡量模型的性能。CNN中常用的损失函数是交叉熵损失函数,它适用于多分类问题,衡量预测概率分布与真实概率分布之间的差异。

反向传播算法是深度学习中用于训练神经网络的核心算法,它通过计算损失函数相对于模型参数的梯度来更新网络权重。梯度下降算法用于利用这些梯度来最小化损失函数,不断迭代直至收敛到最小值。

```python

# 以下为使用交叉熵损失函数的简单伪代码

loss = tf.keras.losses.CategoricalCrossentropy(from_logits=True)

***pile(optimizer='adam', loss=loss, metrics=['accuracy'])

```

## 2.3 物体识别模型的训练和验证

### 2.3.1 数据集的准备和预处理

训练一个高效的物体识别模型,首先需要准备一个包含大量标记数据的数据集。数据集的准备包括数据的采集、标注、划分等步骤。对于图像数据来说,预处理通常包括图像大小的统一、归一化、增强等操作。

- **图像大小统一**:确保输入网络的所有图像具有相同的尺寸,便于网络处理。

- **归一化**:将图像的像素值缩放到[0, 1]区间内,有时也会进行Z-score标准化。

- **数据增强**:对图像进行旋转、缩放、裁剪、颜色变换等操作,以增加模型对数据变异的鲁棒性。

### 2.3.2 训练过程中的超参数调优

超参数是模型训练前需要设定的参数,如学习率、批处理大小、网络层数等。超参数的设定对模型性能有很大影响,因此需要通过实验和调优来确定最佳值。

- **学习率(Learning Rate)**:控制权重更新的步长,太大可能导致模型无法收敛,太小可能导致训练效率低下。

- **批处理大小(Batch Size)**:一次用于更新模型权重的样本数量,过大可能导致内存溢出,过小可能影响梯度估计的准确性。

- **网络层数和结构**:增加网络的深度和宽度可以增加模型容量,但也增加了过拟合的风险。

```python

# 简单的Keras模型训练代码片段

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

MaxPooling2D((2, 2)),

Flatten(),

Dense(10, activation='softmax')

])

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

model.fit(x_train, y_train, epochs=5, batch_size=64)

```

在下一章节中,我们将深入探讨深度学习模型的可视化技术,通过可视化的手段让模型的“黑箱”特性逐渐透明化,提高模型的解释性。

# 3. 深度学习模型的可视化技术

## 3.1 权重和激活的可视化方法

### 3.1.1 卷积层权重的可视化

在卷积神经网络中,卷积层权重直接反映了模型对输入数据(如图片)中特征的识别能力。通过将卷积核的权重以图像形式可视化,我们可以直观地看到每个卷积核学习到的特征。对于物体识别模型而言,这样的可视化有助于理解模型是如何从原始像素中提取有用信息的。

下面的代码块展示了如何使用Python和TensorFlow库来提取并可视化一个特定卷积层的所有卷积核权重。

```python

import tensorflow as tf

import matplotlib.pyplot as plt

from tensorflow.keras import models

# 加载训练好的模型

model = models.load_model('path_to_your_model.h5')

# 选择模型中的第一个卷积层

conv_layer = model.layers[0]

# 获取卷积核权重

weights = conv_layer.get_weights()[0]

# 获取卷积核数量

nb_kernels = weights.shape[3]

# 生成一个网格来显示所有的卷积核

fig, axes = plt.subplots(2, nb_kernels // 2, figsize=(15, 7))

for i in range(nb_kernels):

ax = axes[i // (nb_kernels // 2), i % (nb_kernels // 2)]

ax.imshow(weights[:, :, :, i], cmap='gray')

ax.set_xticks([])

ax.set_yticks([])

plt.show()

```

在执行上述代码块之后,你将得到一个可视化的网格,其中每个图像代表一个卷积核的权重。通过观察这些权重,我们可以发现模型倾向于学习哪些类型的特征。

### 3.1.2 内部激活的可视化分析

除了可视化卷积层的权重之外,我们还可以可视化网络内部各层的激活状态。这可

0

0