物体识别中的半监督学习方法:用少量标签达到高效学习

发布时间: 2024-09-06 17:51:26 阅读量: 39 订阅数: 36

# 1. 半监督学习方法概述

半监督学习是一种结合了少量标注数据和大量未标注数据的学习方法,旨在利用未标注数据中蕴含的信息,提升学习模型的性能。这种方法在数据标注成本高昂的场景中特别有用,比如自然语言处理、图像识别等。

## 1.1 半监督学习的优势

半监督学习与纯粹的监督学习相比,能够在标注数据较少的情况下,显著提高学习效果。因为标注数据往往需要专业知识和大量时间,半监督学习通过挖掘未标注数据中的结构信息和模式,有效减少对标注数据的依赖。

## 1.2 半监督学习的应用场景

在互联网、生物信息学和物联网等领域,半监督学习正逐步成为研究热点。这些领域的数据量巨大,标注困难且成本高昂,因此,半监督学习方法能够大幅降低数据处理的成本,同时维持甚至提高学习效果。

通过后续章节的深入探讨,我们将进一步理解半监督学习在物体识别等领域的具体应用,并掌握实验设计、评估策略以及面临的挑战和未来的研究方向。

# 2. 半监督学习的理论基础

半监督学习是介于监督学习与无监督学习之间的一种学习方式,在拥有少量标记数据和大量未标记数据的情况下,半监督学习能够有效地提高学习性能。本章节将详细探讨半监督学习的基本理论和关键技术。

## 2.1 半监督学习的基本概念

### 2.1.1 从监督学习到半监督学习

监督学习需要大量的标记数据来训练模型,但在实际应用中获取大量标注数据往往耗时耗力且成本高昂。半监督学习的出现,旨在解决这一难题。半监督学习通过利用未标记数据来辅助模型学习,提高了学习效率和模型性能。其中,模型通过少量标记数据理解数据结构和特征,再利用未标记数据增强模型的泛化能力。

### 2.1.2 半监督学习的核心假设

半监督学习的核心假设是“流形假设”,即假设数据位于一个低维流形内,并且同类数据倾向于聚集在流形的某些区域。这一假设是许多半监督学习算法的出发点。在此基础上,算法尝试通过未标记数据的学习,进一步理解数据的分布结构,从而辅助模型更好地预测未见过的数据。

## 2.2 半监督学习的关键算法

### 2.2.1 自训练算法

自训练算法是最基本的半监督学习方法之一。算法首先在少量标记数据上训练一个基础分类器,然后用此分类器预测未标记数据的标签。接着,将预测置信度高的数据添加到训练集中,用更新后的数据集重新训练模型,如此迭代直到满足特定条件。

```python

# 示例代码:自训练算法的基础实现框架

import numpy as np

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 加载数据集,这里以鸢尾花数据集为例

iris = datasets.load_iris()

X, y = iris.data, iris.target

# 分割数据集为有标签和无标签部分

X_labeled, X_unlabeled, y_labeled, _ = train_test_split(X, y, test_size=0.5, random_state=42)

# 初始化分类器

clf = RandomForestClassifier()

# 在有标签数据上训练分类器

clf.fit(X_labeled, y_labeled)

# 进行标签预测,并选择置信度高的无标签数据添加至训练集

predictions = clf.predict(X_unlabeled)

probabilities = clf.predict_proba(X_unlabeled)

# 这里设定阈值,选取置信度高于阈值的预测结果

threshold = 0.9

selected_indices = np.where(np.max(probabilities, axis=1) > threshold)[0]

```

### 2.2.2 图基础方法

图基础方法将数据点建模为图的节点,节点之间的边表示数据点之间的相似度。图拉普拉斯算子有助于揭示数据的内在结构。算法通过最小化图拉普拉斯的能量函数来对节点进行分类。

### 2.2.3 协同训练算法

协同训练算法假定每个样本拥有多个视角(或称为视图),即有多个条件独立的特征集,算法基于不同的视图训练多个分类器,并相互协作改进对方的性能。

## 2.3 损失函数和优化策略

### 2.3.1 损失函数在半监督学习中的作用

在半监督学习中,损失函数不仅需要考虑对有标签数据的预测误差,还应反映无标签数据的分布。一些常用损失函数包括最小二乘损失、交叉熵损失和结构风险最小化损失。

### 2.3.2 优化策略的选择和应用

选择适当的优化策略对于半监督学习的性能至关重要。梯度下降法及其变种(如随机梯度下降法)、拟牛顿法等优化算法在半监督学习中有着广泛应用。优化策略的选择取决于具体的损失函数、数据集规模和计算资源。

通过以上章节的内容,我们已经对半监督学习的理论基础进行了深入的探讨,为后续章节中半监督学习在具体任务中的应用提供了坚实的理论支撑。接下来,我们将关注半监督学习在物体识别任务中的应用和实践技巧。

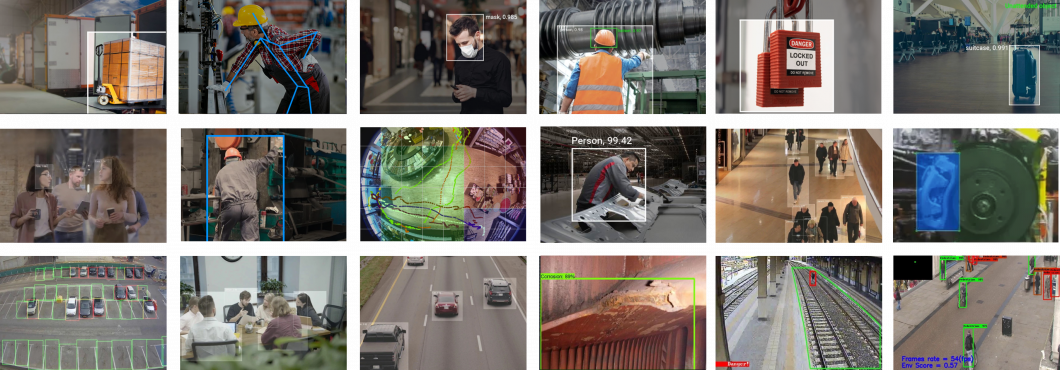

# 3. 物体识别中的半监督学习技术

在本章中,我们将深入探讨半监督学习技术在物体识别任务中的应用。物体识别作为一个关键的计算机视觉应用领域,其处理的图像数据量巨大,而半监督学习通过使用少量标记数据和大量未标记数据来训练模型,对于降低成本和提高识别准确率具有重要意义。我们将首先概述物体识别任务及其挑战,然后重点介绍半监督学习在物体识别中的应用,并提供实

0

0