【深度学习入门】:掌握物体识别,从基础到实践的完整指南

发布时间: 2024-09-06 16:51:59 阅读量: 79 订阅数: 37

# 1. 深度学习与物体识别概述

深度学习作为人工智能领域的一次革命性进步,已经深深影响了我们生活的方方面面,尤其在物体识别领域。物体识别,这个曾经让人望而却步的难题,现今已随着深度学习的发展逐步被攻破。深度学习通过模仿人脑处理信息的方式,能够从大量数据中自动学习并提取信息,它在物体识别中的应用正引领着技术潮流。

## 1.1 物体识别技术的重要性

物体识别技术是计算机视觉领域的一个核心问题,它使得机器能够像人类一样理解和识别图像中的物体。这项技术的应用广泛,从自动驾驶汽车的环境感知,到智能监控系统的人体行为分析,再到增强现实技术中的场景理解等,都离不开精准的物体识别技术。

## 1.2 深度学习的发展背景

深度学习之所以在物体识别领域取得突破,是因为它强大的特征学习能力。传统的图像处理方法往往依赖于手工特征,而深度学习模型,尤其是卷积神经网络(CNN),能够自动从原始数据中学习到层次化的特征表示。这使得深度学习在面对复杂的视觉任务时,能够达到前所未有的准确度和鲁棒性。

# 2. 深度学习理论基础

### 2.1 神经网络的结构和原理

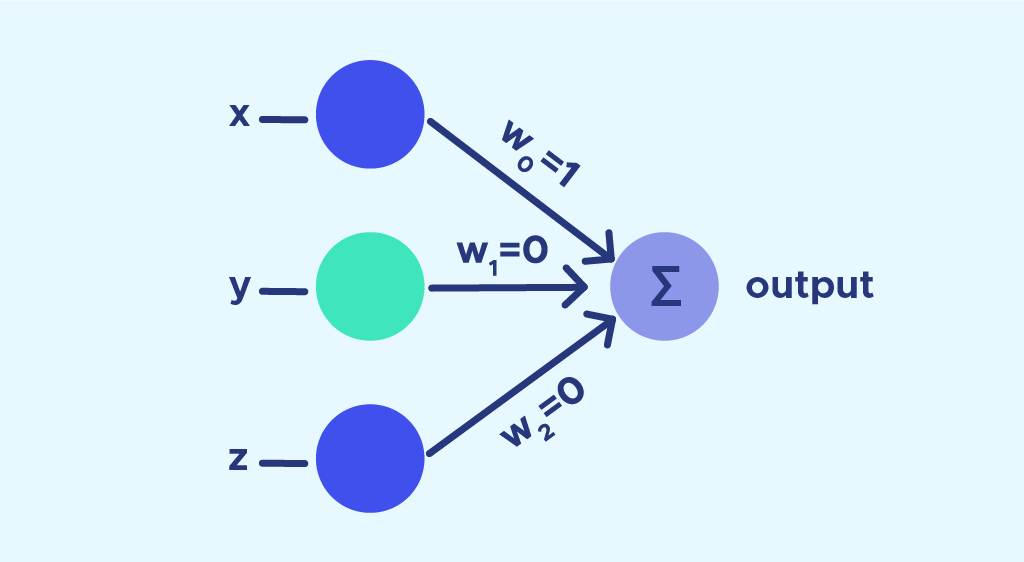

神经网络是深度学习的核心,它模仿了生物神经网络的工作方式,由大量相互连接的节点组成,每个节点称为一个神经元。神经网络的每一层都包含多个神经元,而不同层的神经元通过权重连接。学习过程就是调整这些权重,使得网络在给定任务上表现得更好。

#### 2.1.1 人工神经网络的基本组成

人工神经网络(Artificial Neural Network, ANN)的基本组成单元包括输入层、隐藏层和输出层。输入层接收原始数据,隐藏层负责处理和特征提取,输出层则生成最终结果。每一层的神经元可以使用非线性激活函数,如ReLU、sigmoid或tanh,以便网络能够学习和模拟复杂的函数映射。

#### 2.1.2 前向传播与反向传播算法

前向传播是输入数据通过网络从输入层流向输出层的过程。每一层的神经元接收到上一层的输出,计算加权和,并通过激活函数产生输出。反向传播算法用于训练神经网络,通过计算损失函数相对于网络参数的梯度,实现误差的逆向传递,从而调整权重以最小化误差。梯度下降法是常用的优化算法,用于根据梯度更新网络参数。

### 2.2 卷积神经网络(CNN)的原理

CNN是深度学习中最常用的网络架构之一,尤其适用于图像识别任务。它的设计思想受到了生物视觉皮层的启发,能够自动并且有效地从图像中提取特征。

#### 2.2.1 卷积层的工作机制

卷积层是CNN的核心组件,它通过一组可学习的滤波器(或称为卷积核)进行操作。每个滤波器在输入数据上滑动,并在特定区域上执行元素乘法和求和操作,生成一个二维激活图。卷积操作能够提取局部特征,并保持空间关系,这对于图像处理尤为重要。

#### 2.2.2 池化层的作用和影响

池化层(Pooling Layer)通常跟在卷积层之后,它的作用是减少参数的数量,从而减少计算量和内存占用,并控制过拟合。池化层通过对卷积层的输出进行下采样操作,提取局部特征的最重要的信息,最常见的池化操作包括最大池化(Max Pooling)和平均池化(Average Pooling)。

#### 2.2.3 全连接层及其在CNN中的角色

全连接层(Fully Connected Layer)位于CNN的末端,紧接在一系列卷积层和池化层之后。这一层的每个神经元与前一层的所有激活输出相连,执行加权求和和非线性变换操作,用于整合前一层提供的特征信息。全连接层的目的是将抽象的特征表示映射到最终的分类或回归任务的输出。

### 2.3 损失函数与优化算法

损失函数(Loss Function)衡量了模型预测值和实际值之间的差异,是模型训练的关键,因为损失函数定义了优化的方向。

#### 2.3.1 常用的损失函数解析

在深度学习中,不同任务通常会使用不同的损失函数。例如,分类任务经常使用交叉熵损失函数(Cross-Entropy Loss),回归任务则使用均方误差损失函数(Mean Squared Error, MSE)。交叉熵损失衡量的是预测概率分布与真实概率分布之间的差异,而MSE损失则是预测值与真实值差的平方的平均值。

#### 2.3.2 优化算法的选择和影响

优化算法负责调整网络参数以最小化损失函数。梯度下降是最基础的优化算法,而其变种如Adam、RMSprop和SGD with momentum等在实践中更常用。这些算法通过在参数空间中以不同的方式迭代更新,以找到损失函数的最小值点。优化算法的选择会直接影响到模型训练的速度、稳定性和最终性能。

下表总结了一些常见的损失函数和优化算法:

| 损失函数类型 | 应用场景 | 优化算法类型 | 算法描述 |

| --- | --- | --- | --- |

| Cross-Entropy Loss | 分类问题 | Adam | 自适应学习率优化算法,结合了RMSprop和Momentum的优点 |

| Mean Squared Error | 回归问题 | SGD with momentum | 利用动量加速梯度下降,防止陷入局部最小值 |

| Hinge Loss | 支持向量机 | RMSprop | 适应性学习率,对振荡较大的参数进行了优化 |

| KL Divergence | 生成对抗网络 | AdaGrad | 自适应梯度算法,对频繁出现的参数降低学习率 |

在实际应用中,选择合适的损失函数和优化算法对于模型训练有着至关重要的影响。例如,在训练神经网络进行物体识别时,选择交叉熵损失函数配合Adam优化器通常能够取得较好的效果,因为它们在多数情况下可以提供稳定的收敛速度和较为理想的训练结果。

代码示例如下:

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 定义模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

# 定义网络结构

self.conv1 = nn.Conv2d(1, 10, kernel_size=5)

self.pool = nn.MaxPool2d(2, 2)

self.fc = nn.Linear(10 * 4 * 4, 10)

def forward(self, x):

# 定义前向传播

x = self.pool(torch.relu(self.conv1(x)))

x = x.view(-1, 10 * 4 * 4)

x = self.fc(x)

return x

model = Net()

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 假设的输入数据和标签

inputs = torch.randn(1, 1, 28, 28)

labels = torch.randint(0, 10, (1,))

# 训练网络

outputs = model(inputs)

loss = criterion(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

```

在上述代码块中,我们创建了一个简单的卷积神经网络模型,并定义了损失函数和优化器。接着,我们进行了一个训练步骤,其中网络接收了随机生成的输入数据和标签,执行前向传播,计算损失,并使用优化算法执行了一次反向传播和权重更新。这个过程通常会重复进行多次,直到模型在验证集上的性能达到满意的水平。

# 3. 物体识别中的深度学习技术

物体识别是深度学习技术的重要应用领域之一,其挑战在于能够从图像数据中准确识别出物体的存在、种类以及位置。本章节将介绍物体识别领域中的技术挑战与方法,深入探讨深度学习如何在其中发挥作用。

## 3.1 物体识别的挑战与方法

### 3.1.1 图像分类与物体识别的区别

图像分类和物体识别都是计算机视觉任务,但它们有本质的区别。图像分类是确定输入图像属于哪个类别,即整个图像只有一个主要对象。而物体识别是确定图像中有哪些对象,并识别每个对象的位置和类别,这可能涉及到多个对象的识别。

在深度学习领域中,图像分类任务通常通过构建一个深度神经网络,该网络能够将图像映射到一个或多个类别标签。而物体识别则更复杂,需要网络不仅能够分类,还能够定位图像中的物体。这通常通过目标检测算法实现,该算法将图像划分为多个区域,然后对每个区域进行分类,并预测每个类别的边界框(bounding box)。

### 3.1.2 传统物体识别方法回顾

在深度学习出现之前,物体识别技术主要依赖于手工特征提取方法,例如使用SIFT(尺度不变特征变换)、HOG(方向梯度直方图)等。这些方法通常会结合机器学习算法,如支持向量机(SVM)进行分类。

手工特征提取依赖于专家知识来设计特征提取器,且这些方法往往难以适应复杂的场景和多变的光照条件。随着数据集的扩大和计算能力的提升,手工特征提取的方法逐渐被端到端的深度学习方法所取代,因为深度学习能自动学习到从原始像素到高级语义信息的映射。

## 3.2 深度学习在物体识别中的应用

### 3.2.1 卷积神经网络在物体识别中的关键作用

卷积神经网络(CNN)是物体识别中应用最为广泛的深度学习模型。CNN通过卷积层能够有效提取图像的局部特征,并通过池化层实现空间降维。这些操作使得网络能够在处理图像时具有平移不变性,并且具有较强的特征抽象能力。

CNN在物体识别中的一个关键应用是目标检测。目标检测模型如R-CNN、Fast R-CNN、Faster R-CNN等,通过构建候选区域并对其进行分类和边界框预测,实现了高效准确的物体识别。

```python

import tensorflow as tf

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

# 一个简单的CNN模型示例

model = tf.keras.models.Sequential([

Conv2D(32, (3,3), activation='relu', input_shape=(224, 224, 3)),

MaxPooling2D((2,2)),

Conv2D(64, (3,3), activation='relu'),

MaxPooling2D((2,2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

```

以上代码展示了构建一个基础的CNN模型,该模型通过卷积层和池化层逐层提取特征,之后将特征展平并进行分类。每一层的作用和参数如下:

- `Conv2D`层用于提取图像特征,卷积核大小为3x3,激活函数为ReLU。

- `MaxPooling2D`层用于降低特征的空间维度,池化窗口大小为2x2。

- `Flatten`层将2D特征图转换为1D向量,以便能够输入到全连接层。

- `Dense`层是全连接层,用于学习非线性映射。

### 3.2.2 预训练模型与迁移学习

预训练模型指的是在大型数据集(如ImageNet)上预训练好的模型。在处理特定物体识别任务时,可以通过迁移学习的方式使用这些模型。迁移学习允许我们将预训练模型作为特征提取器,并在特定任务上进行微调,以适应新的数据集。

```python

from tensorflow.keras.applications import VGG16

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Dense, Flatten

# 加载预训练的VGG16模型

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 添加自定义层以适应新的分类任务

x = Flatten()(base_model.output)

x = Dense(256, activation='relu')(x)

predictions = Dense(10, activation='softmax')(x)

# 构建最终模型

model = Model(inputs=base_model.input, outputs=predictions)

```

在这个例子中,我们使用了VGG16的预训练权重,但在顶部添加了自定义的全连接层。这些层是为特定的分类任务学习的,而底部的卷积层权重则保持不变,或者可以进行微调。

### 3.2.3 边界框回归与非极大值抑制

边界框回归是目标检测中的一个关键步骤,用于精确预测物体的位置。它通过学习一个偏移量对候选框进行微调,从而更准确地定位物体边界。

非极大值抑制(Non-Maximum Suppression,NMS)是一种处理重叠检测框的方法。NMS会从一组检测到的边界框中选择最佳框,方法是基于置信度得分和框之间的重叠度,移除重叠度过高的框。

## 3.3 物体识别的评价指标

### 3.3.1 精确度、召回率和mAP的理解

精确度(Precision)和召回率(Recall)是评估分类模型性能的两个基本指标。精确度衡量了正类预测中实际为正类的比例,召回率衡量了实际为正类中被正确识别的比例。精确度和召回率之间往往存在一个权衡,因此通常需要综合考虑。

平均精度均值(mean Average Precision, mAP)是目标检测任务中常用的评价指标,它是在一系列不同的召回率水平上计算的平均精度。mAP不仅考虑了分类的准确性,还考虑了物体定位的准确性。

### 3.3.2 评价指标的选择与应用场景

在不同的应用场景下,评价指标的选择可能会有所不同。例如,在对实时性能要求较高的应用中,可能需要牺牲一些精确度以换取更快的处理速度。

```markdown

| 指标 | 应用场景 |

| --- | --- |

| 精确度 | 需要最小化误报的应用,如医疗影像分析 |

| 召回率 | 假阴性代价很高的应用,如灾害识别 |

| mAP | 综合评价物体检测算法性能 |

```

在实际操作中,可以根据项目需求和资源选择适合的评价指标,以准确评估模型的性能表现。

```mermaid

graph TD;

A[开始评估] --> B[收集测试数据集]

B --> C[模型预测]

C --> D[计算评价指标]

D --> E[分析结果]

E -->|需要优化| F[调整模型参数]

F --> C

E -->|满足要求| G[模型部署]

```

以上流程图展示了模型评估的标准过程。在测试数据集上进行模型预测后,通过计算评价指标来分析模型的性能。如果评价结果不符合要求,则需要返回调整模型参数,直至满足性能要求。

下一章,我们将深入了解深度学习框架与环境搭建的过程,为实际的深度学习项目打下坚实的基础。

# 4. 深度学习框架与环境搭建

## 4.1 深度学习框架概览

深度学习框架是构建和训练深度神经网络的软件平台。随着技术的发展,多种深度学习框架应运而生,为开发者提供了更加快捷和高效的工具来实现复杂的深度学习算法。本节将重点介绍目前较为流行的两个深度学习框架:TensorFlow与Keras的关系和使用,以及PyTorch的动态计算图。

### 4.1.1 TensorFlow与Keras的关系和使用

TensorFlow是由谷歌开发的一个开源深度学习框架,它被广泛应用于研究和生产环境中。其核心API设计用于大规模的数值计算,并支持多种语言接口。Keras则是一个高级神经网络API,被设计成一个简洁、模块化、可扩展的神经网络库,它在TensorFlow之上提供了一个更高级的抽象层。

Keras最初是作为一个独立的深度学习库而开发的,但自从2017年以来,它已经被集成到了TensorFlow中,成为了其高层API。这意味着开发者可以直接使用Keras中的功能而无需安装独立的Keras库。

一个典型的使用例子如下:

```python

import tensorflow as tf

from tensorflow import keras

# 构建一个简单的序列模型

model = keras.Sequential([

keras.layers.Dense(512, activation='relu', input_shape=(784,)),

keras.layers.Dropout(0.2),

keras.layers.Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='rmsprop',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 用模型进行训练和评估

model.fit(train_images, train_labels, epochs=5, batch_size=128)

test_loss, test_acc = model.evaluate(test_images, test_labels)

```

这个例子展示了如何使用Keras API构建一个简单的全连接神经网络。代码中`***pile`、`model.fit`和`model.evaluate`等方法均来自Keras API,可以直接在TensorFlow环境中使用。

### 4.1.2 PyTorch的动态计算图解析

PyTorch由Facebook推出,它的一个显著特点是动态计算图(也称为定义即运行)机制。这一特性使得它特别适合研究人员使用,因为它允许开发者在运行时构造计算图,从而实现更加灵活的编程模型。

动态计算图与静态计算图(如TensorFlow)的主要区别在于,动态图在每次迭代时可以改变计算图的结构,而静态图则需要事先定义好整个网络结构。PyTorch的这种动态性是通过自动微分引擎实现的。

下面是使用PyTorch构建和训练一个简单神经网络的例子:

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个简单的全连接网络

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc = nn.Linear(784, 10)

def forward(self, x):

x = x.view(-1, 784)

x = self.fc(x)

return x

# 实例化网络、优化器和损失函数

model = SimpleNet()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

criterion = nn.CrossEntropyLoss()

# 假设train_images和train_labels已定义

for epoch in range(5):

optimizer.zero_grad()

outputs = model(train_images)

loss = criterion(outputs, train_labels)

loss.backward()

optimizer.step()

# 测试网络性能

# 假设test_images和test_labels已定义

model.eval()

with torch.no_grad():

predictions = model(test_images)

correct = (predictions.argmax(1) == test_labels).sum().item()

total = test_labels.size(0)

print(f'Accuracy: {correct}/{total} = {100 * correct / total}%')

```

这个例子中,我们首先定义了一个全连接层组成的神经网络`SimpleNet`。之后,我们实例化了这个网络,设置了优化器和损失函数,并进行了训练。在测试阶段,我们评估了模型在测试集上的准确率。

## 4.2 实践环境的搭建

搭建深度学习的实践环境包括多个方面,如硬件环境的选择、软件依赖的管理、以及开发工具的配置等。本小节将介绍GPU加速与CUDA配置,以及如何管理虚拟环境和依赖。

### 4.2.1 GPU加速与CUDA配置

GPU加速是指使用图形处理单元(Graphics Processing Unit)来加速深度学习模型的训练和推理过程。GPU并行处理的能力使得在处理大规模矩阵和向量运算时比CPU更有效率。CUDA(Compute Unified Device Architecture)是由NVIDIA推出的并行计算平台和编程模型,它允许开发者直接使用NVIDIA的GPU进行通用计算。

为了在深度学习框架中使用GPU加速,首先需要确保你的计算机安装了NVIDIA的GPU,并且已经安装了与之对应的CUDA版本。以TensorFlow为例,你可以通过以下代码检查是否成功配置了GPU:

```python

import tensorflow as tf

# 检查GPU可用性

print("Num GPUs Available: ", len(tf.config.experimental.list_physical_devices('GPU')))

# 设置TensorFlow使用GPU

gpus = tf.config.experimental.list_physical_devices('GPU')

if gpus:

try:

# Currently, memory growt hthrottling is happen ing only with Nvidia GPUs

for gpu in gpus:

tf.config.experimental.set_memory_growth(gpu, True)

except RuntimeError as e:

# Memory growth must be set before GPUs have been initialized

print(e)

```

这段代码首先尝试列出所有可用的GPU设备,如果成功,则设置每个GPU允许动态分配内存。

### 4.2.2 虚拟环境与依赖管理

虚拟环境是Python中用于隔离项目依赖关系的一种机制。对于每个Python项目,我们都推荐使用独立的虚拟环境,以避免不同项目之间依赖库版本的冲突。

Python的虚拟环境模块venv可以用于创建和管理虚拟环境。下面是一个创建和激活虚拟环境的例子:

```bash

# 创建名为myenv的虚拟环境

python3 -m venv myenv

# 激活虚拟环境(在Windows系统中)

myenv\Scripts\activate

# 激活虚拟环境(在Unix或MacOS系统中)

source myenv/bin/activate

# 退出虚拟环境

deactivate

```

在虚拟环境中安装依赖,通常使用`pip`工具,可以指定依赖包的版本,例如:

```bash

pip install numpy==1.18.5

```

通过上述步骤,你可以为每个项目创建一个隔离的环境,从而管理项目的依赖关系。虚拟环境和依赖管理不仅有助于项目的复现,而且在协作开发时,也是维护一致性的关键步骤。

以上内容总结了深度学习框架的概览与实践环境的搭建过程。理解这些基础知识对于搭建高效的深度学习工作环境至关重要,并将为后续的项目实战奠定坚实基础。

# 5. 物体识别

## 5.1 数据集的准备与预处理

物体识别是一个数据密集型的任务,因此数据集的准备和预处理是成功模型训练的基石。数据集的准确性和多样性直接关系到模型的泛化能力。

### 5.1.1 下载并理解常用物体识别数据集

在进行深度学习物体识别项目时,选择合适的数据集至关重要。标准的数据集有助于模型更好地学习和泛化。

一个常用的物体识别数据集是**Pascal VOC**,它提供了包括人物、动物、车辆等多种类别的标注信息。另一个则是**COCO(Common Objects in Context)**数据集,它广泛用于目标检测、分割、图像描述等任务,因为它提供了丰富和高质量的图像与标注。

此外,**ImageNet**数据集是一个大规模的视觉识别任务挑战赛数据集,它包含了1000个类别,每类包含500至1000张训练图像,是研究和开发深度学习模型的重要资源。

### 5.1.2 图像增强与归一化处理

为了提高模型的泛化能力,对原始数据进行图像增强是一种有效的方法。这包括:

- **旋转**:旋转图像可以帮助模型学习到物体的旋转不变性。

- **缩放**:通过缩放图像,模型可以学会识别不同大小的目标。

- **剪切**:随机剪切图片的某个区域可以增加数据的多样性。

- **颜色变换**:调整亮度、对比度等,提高模型对色彩变化的鲁棒性。

以下是使用Python的`imageio`库进行图像旋转的示例代码:

```python

import imageio

from skimage.transform import rotate

# 加载图像

img = imageio.imread('path_to_image.jpg')

# 将图像旋转90度

rotated_img = rotate(img, angle=90, mode='nearest', cval=255)

# 保存或进一步处理旋转后的图像

imageio.imwrite('path_to_rotated_image.jpg', rotated_img)

```

归一化处理通常是将图像像素值缩放到[0, 1]区间或进行标准化,让数据符合模型输入的要求。

## 5.2 构建和训练物体识别模型

### 5.2.1 设计CNN模型结构

构建一个有效的CNN模型结构是实现优秀物体识别性能的关键。一个基本的CNN模型通常包含多个卷积层、池化层,以及一个或多个全连接层。

#### 卷积层

卷积层通过应用多个卷积核对输入图像进行过滤,提取出不同的特征图(feature maps)。

```python

from keras.layers import Conv2D

from keras.models import Sequential

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(img_height, img_width, img_channels)))

```

#### 池化层

池化层通过对特征图进行下采样,降低特征图的空间尺寸,从而减少计算量,同时保留重要信息。

```python

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D((2, 2)))

```

#### 全连接层

最后,一个或多个全连接层将学习到的高级特征进行组合,用于分类或其他任务。

```python

model.add(Flatten())

model.add(Dense(64, activation='relu'))

model.add(Dense(num_classes, activation='softmax'))

```

### 5.2.2 实现训练流程与模型评估

#### 训练流程

训练深度学习模型通常涉及定义损失函数、选择优化器和设置训练周期(epochs)。

```***

***pile(optimizer=Adam(),

loss='categorical_crossentropy',

metrics=['accuracy'])

model.fit(train_images, train_labels, epochs=10, validation_data=(val_images, val_labels))

```

#### 模型评估

在训练结束后,我们需要在测试集上评估模型性能。准确率和损失值是最常用的指标。

```python

test_loss, test_acc = model.evaluate(test_images, test_labels)

print('Test accuracy:', test_acc)

```

在本小节中,我们讲述了设计和训练一个基本CNN模型的基本步骤。在下一小节中,我们将深入讨论如何对模型进行优化,以提高识别准确率和减少训练时间。

## 5.3 模型的优化与部署

### 5.3.1 超参数调优技巧

深度学习模型有许多超参数,比如学习率、批量大小、卷积核数量等。正确的超参数设置对模型的性能有很大影响。

#### 学习率的选择

学习率是影响模型训练速度和收敛性的关键因素。过于小的学习率会使得训练过程过慢,而过大的学习率可能会导致模型无法收敛。可以通过学习率衰减策略来优化,例如在训练过程中逐渐减小学习率。

```python

from keras.callbacks import LearningRateScheduler

def scheduler(epoch, lr):

if epoch < 10:

return lr

else:

return lr * tf.math.exp(-0.1)

callbacks = [LearningRateScheduler(scheduler)]

model.fit(train_images, train_labels, epochs=50, callbacks=callbacks)

```

#### 批量大小的调整

批量大小也会影响训练的稳定性和速度。通常,较大的批量大小会加速训练,但可能会降低模型泛化能力,而较小的批量大小虽然有助于提高模型泛化能力,但训练速度较慢。

### 5.3.2 模型部署与应用示例

训练完成后,将模型部署到实际的应用程序中是项目成功的最终目的。部署可以采取多种方式,例如通过Web API或嵌入式设备。

#### Web API部署

可以使用Flask或Django等Python Web框架将训练好的模型封装为Web服务。以下是一个简单的Flask示例:

```python

from flask import Flask, request, jsonify

from keras.models import load_model

import numpy as np

app = Flask(__name__)

model = load_model('path_to_model.h5')

@app.route('/predict', methods=['POST'])

def predict():

data = request.get_json()

img = data['image']

# 进行必要的预处理

img = preprocess_image(img)

prediction = model.predict(img)

# 返回预测结果

return jsonify({'prediction': prediction.tolist()})

if __name__ == '__main__':

app.run(debug=True)

```

在这个示例中,模型被加载并准备接收图像数据进行预测。客户端应用程序可以使用HTTP请求发送图像数据,并获取预测结果。

#### 嵌入式设备部署

对于边缘计算或移动设备,可能需要使用TensorFlow Lite等轻量级框架将模型转换为TFLite格式。该格式专为移动和嵌入式设备设计,以实现更快的推理速度和更小的内存占用。

本章节介绍了深度学习在物体识别项目中的实战应用,包括数据集的准备、模型的设计与训练、以及超参数的调整和模型部署。通过本章节的学习,您可以开始构建自己的物体识别系统。在下一章节中,我们将展望深度学习在物体识别领域的未来,并探讨持续学习的资源。

# 6. 未来展望与深度学习的持续学习

## 6.1 物体识别的最新进展

物体识别作为计算机视觉的核心任务,随着深度学习技术的快速发展,其在精度和应用范围上都取得了显著的进展。我们不妨深入探索这些前沿的动态和趋势。

### 6.1.1 强化学习与物体识别

近年来,强化学习的加入使得物体识别系统可以从环境中学习,并通过试错来改善其识别准确性。这通过奖励机制来实现,其中模型在正确识别物体时收到正面奖励,在错误识别时收到负反馈。这样的学习过程使模型在复杂场景下,能够更好地适应和识别物体。

在实践中,强化学习通常与深度学习结合使用,形成深度强化学习(Deep Reinforcement Learning, DRL)。通过这种方式,物体识别模型不仅能够从标记好的数据集中学习,还能从与环境的实时交互中学习。例如,一个基于DRL的自动驾驶车辆中的物体识别系统能够在行驶过程中实时优化其识别性能。

代码示例和执行逻辑说明可能包括:

- 使用DRL算法(如DDPG或PPO)来训练一个代理在模拟环境中进行物体识别任务。

- 代码块展示如何定义奖励函数来引导代理学习更准确的识别策略。

### 6.1.2 跨模态物体识别的探索

跨模态物体识别是将不同模态的信息(如图像、文本、声音等)结合在一起,以提高识别的准确性和鲁棒性。这种方法利用了不同模态之间的互补信息,如图像提供视觉信息,文本提供描述信息,声音提供环境信息等。

在深度学习领域,神经网络被设计来处理和整合多模态数据。例如,使用卷积神经网络(CNN)处理图像数据,并使用循环神经网络(RNN)处理序列化的文本数据,最后通过融合层将不同模态的信息综合起来。

这个方向的最新研究可能包括:

- 使用多模态深度学习框架,如MAttNet,它能在多个模态之间共享知识。

- 通过实验分析不同模态之间的信息如何相互增强,提高识别的准确度。

## 6.2 深度学习领域的持续学习资源

深度学习是一个不断进化的领域,新的理论、技术、框架和工具不断涌现。因此,深度学习专家需要不断学习和更新知识。

### 6.2.1 在线课程与认证项目

互联网上有许多高质量的深度学习资源,包括免费的在线课程、专业认证项目和互动式学习平台。这些资源涵盖了从基础知识到高级应用的广泛主题。

例如,知名平台如Coursera、edX、Udacity提供了深度学习专项课程。其中,由Andrew Ng教授主导的Deep Learning Specialization在业界广受好评,提供了全面的深度学习课程体系。

对于那些希望获得专业认可的深度学习实践者来说,参加认证项目是一个不错的选择。这不仅增强了个人的技能,也提供了行业认可的资格证明。企业如Google、NVIDIA也提供专项认证,这些认证通常涉及实战项目,帮助学习者巩固所学知识。

### 6.2.2 研究论文与专业社区

阅读最新的研究论文是了解深度学习最前沿进展的有效方式。不同的期刊和会议,如NeurIPS、ICML、CVPR、arXiv等,是发表和讨论深度学习研究的平台。

此外,深度学习社区如Reddit、Stack Overflow等提供了丰富的讨论和问答机会,这里可以找到其他专业人士,分享知识、讨论问题,并获得来自全球专家的即时反馈。

同时,加入专业组织或社团,例如IEEE、ACM的计算机分会,也是扩大知识网络和了解最新动态的重要方式。通过参加这些组织举办的研讨会、讲座和会议,不仅可以学习到深度学习的新发展,还可以结识行业内的领导者和其他专业人士。

这些资源和平台构成了深度学习持续学习的生态系统,为从业者提供了无限的学习和发展机会。

0

0