深度解析:卷积神经网络背后的数学原理

发布时间: 2024-09-05 10:39:52 阅读量: 99 订阅数: 50

# 1. 卷积神经网络简介

在当今的人工智能和机器学习领域中,卷积神经网络(Convolutional Neural Networks, CNNs)已经成为了一个不可或缺的重要组成部分。CNNs在图像识别、视频分析、医学影像处理,甚至自然语言处理等领域取得了前所未有的成功。它是一种深度学习模型,特别擅长于捕捉和处理具有网格结构的数据,如像素网格。

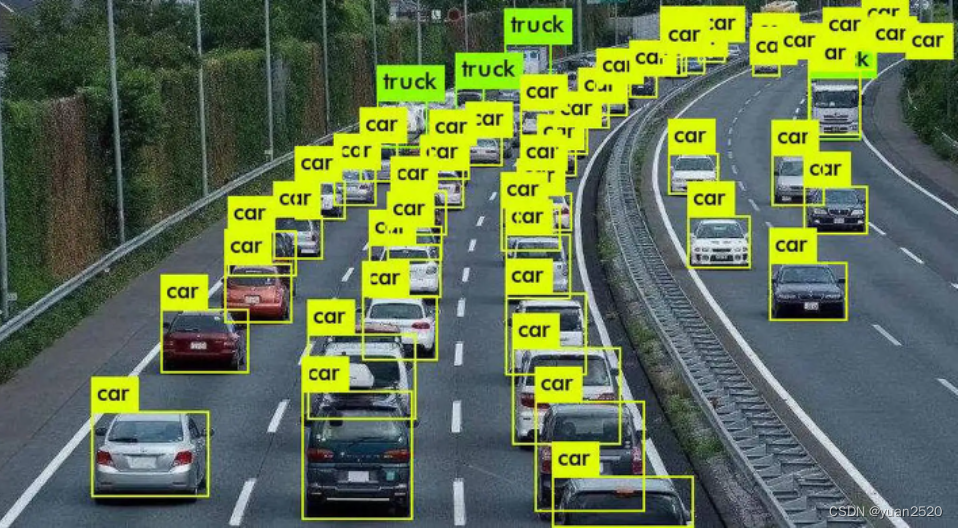

简单来说,卷积神经网络是一种专门用来处理带有类似网格结构的数据的深度神经网络,主要应用在图像和视频数据处理上。它模仿了人类视觉系统处理图像的方式,通过层次化的结构有效地从数据中学习特征的层级表示。这使得CNN在多个任务上都展示出了出色的性能,包括图像分类、物体检测、图像分割等。

接下来的章节,我们将深入探讨CNN的数学基础、结构组件,以及如何在实践中应用它,并讨论它的高级应用和面临的挑战。通过了解和掌握CNN的这些关键知识,读者能够更加深入地理解并应用这一强大的技术来解决现实世界的问题。

# 2. 卷积神经网络的核心数学基础

## 2.1 线性代数在卷积中的应用

### 2.1.1 张量和矩阵的运算

卷积神经网络(CNN)是深度学习中一种非常强大的模型,特别是在处理图像数据方面。其背后的数学基础之一是线性代数。线性代数中的张量和矩阵运算在CNN中扮演着核心角色。张量可以视为一个多维数组,而矩阵则是一个二维张量。在图像处理中,一张图片可以被看作是一个三维的张量,包含宽度、高度和颜色通道。而卷积操作可以被看作是在这些三维张量上进行的一种特定的线性变换。

让我们以一个简单的二维卷积操作为例,来说明张量和矩阵是如何在其中起作用的:

```python

import numpy as np

# 创建一个2x2的矩阵(实际上是一个二阶张量)

matrix_a = np.array([[1, 2],

[3, 4]])

# 创建一个2x2的卷积核(滤波器)

kernel = np.array([[1, 0],

[0, -1]])

# 进行二维卷积操作,通过矩阵乘法模拟

conv_result = np.dot(matrix_a, kernel)

print(conv_result)

```

在这个例子中,我们创建了一个2x2的矩阵`matrix_a`,和一个2x2的卷积核`kernel`。通过模拟的矩阵乘法操作来模拟卷积,我们得到卷积结果。在实际的CNN中,矩阵通常会是更高维度的张量,而卷积核会移动并覆盖整个输入图像进行操作,以提取特征。

### 2.1.2 卷积操作的数学表达

卷积操作在数学上被定义为两个函数的积分运算,这个操作在CNN中是以离散形式进行的。例如,对于一个二维离散信号(或图像)和一个二维卷积核,卷积操作可以表达为:

来高效计算。

## 2.2 概率论与统计学基础

### 2.2.1 概率分布与卷积网络

概率论为我们提供了理解随机变量及其分布的基础。在卷积神经网络中,概率分布的概念至关重要,因为它有助于我们理解网络中层与层之间权重的初始化和更新。在CNN中,权重的初始化通常采用正态分布或均匀分布的方式,这需要对数据的分布特性有所了解。权重更新,如使用梯度下降方法,也涉及到概率分布的概念。

考虑下面的初始化权重的代码:

```python

import tensorflow as tf

# 创建一个正态分布的权重初始化器

init = tf.keras.initializers.RandomNormal(mean=0.0, stddev=0.05)

# 假设我们有5x5的卷积核和6个滤波器

kernel_shape = (5, 5, 1, 6)

kernel_weights = init(kernel_shape)

print(kernel_weights)

```

在此代码中,权重是使用均值为0,标准差为0.05的正态分布进行初始化的。选择适当的初始化参数对于确保网络的收敛和性能是至关重要的。

### 2.2.2 激活函数的概率解释

激活函数在CNN中引入了非线性,从而允许网络学习复杂的模式。从概率论的角度来看,激活函数可以被视为随机变量的变换。例如,ReLU(Rectified Linear Unit)函数将负值映射为零,而保持正值不变,可以被解释为一种概率变换,它过滤掉了一半的概率空间。

下面是一个ReLU激活函数的代码实现:

```python

import numpy as np

def relu(x):

return np.maximum(0, x)

# 测试激活函数

x = np.array([-1, 0, 1])

print(relu(x))

```

在此代码中,`relu`函数对每个输入值进行操作,如果输入小于零,则输出为零;否则,它保持原始值。这可以被看作是根据概率分布选择性地激活某些神经元的过程。

## 2.3 微积分在CNN优化中的角色

### 2.3.1 梯度下降法的数学原理

梯度下降法是CNN中用于权重优化的最常见算法。通过计算损失函数相对于网络权重的梯度,梯度下降法可以决定在参数空间中沿哪个方向移动以降低损失。具体来说,它按照损失函数梯度的反方向更新权重。

让我们通过一个例子来演示如何计算损失函数关于参数的梯度,并进行更新:

```python

# 假设我们有损失函数L关于参数w的导数

def gradient_of_loss(w):

return 2*w # 这是一个示例导数函数

# 损失函数的当前参数值

w = 5.0

learning_rate = 0.1

# 使用梯度下降更新参数

w -= learning_rate * gradient_of_loss(w)

print(w)

```

在上面的代码中,我们定义了一个损失函数关于参数`w`的导数函数。然后,我们使用梯度下降公式更新参数`w`。通过不断迭代这一过程,我们期望找到损失函数的最小值。

### 2.3.2 反向传播算法的推导

反向传播算法是CNN中训练过程中用于高效计算梯度的关键技术。它依赖于链式法则来逐层反向传播误差信号。算法的核心思想是,损失函数关于某个层的权重的梯度可以通过误差信号乘以该层激活函数的导数来计算。

一个简化的反向传播计算梯度的代码如下:

```python

import tensorflow as tf

# 假设我们有一个模型,一个层的输出为output,损失函数关于output的导数为grad_output

layer_output = tf.Variable(initial_value=[[0.5, -0.3], [0.2, 0.9]])

grad_output = tf.constant([[-0.2, 0.5], [0.1, -0.3]])

# 计算激活函数(例如R

```

0

0