大数据平台实战:从MySQL到可视化分析

版权申诉

"大数据运维技术第17章主要讲解了如何构建和应用大数据平台,以满足某招聘网站通过大数据分析人才趋势的需求。课程内容涵盖了项目背景、实施目标、业务处理流程以及具体的大数据组件在各个层面上的应用。"

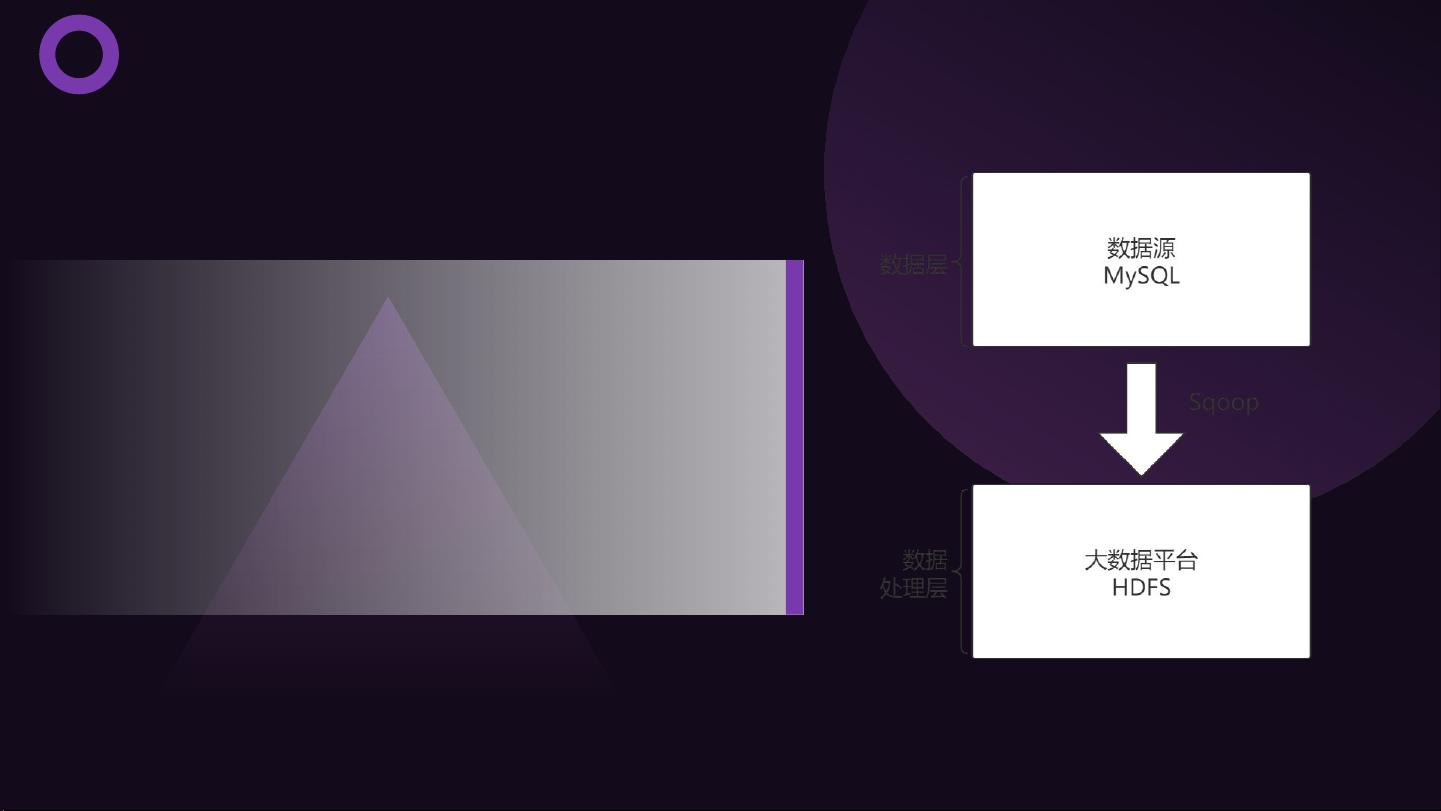

在本章节中,大数据平台的构建是为了高效地处理和分析招聘网站的数据。项目背景描述了一个典型的业务场景,即原始数据无法直接满足业务需求,需要经过一系列处理才能提供有价值的洞察。项目实施目标明确指出,数据将经过Sqoop从MySQL导出至HDFS,再通过MapReduce进行预处理,接着导入Hive进行数据分析,之后的结果会再次通过Sqoop导出到MySQL,最后通过数据可视化工具展示。

大数据平台的业务处理流程分为四个层次:数据源层、数据处理层、数据应用层和数据访问层。数据源层负责获取原始数据,数据处理层执行数据清洗、规约和提取,数据应用层进行数据挖掘、建模和分析,而数据访问层则负责将处理后的数据以可视化的方式展示出来。在这一过程中,Sqoop扮演了关键角色,确保数据在传输过程中的完整性和一致性。

数据处理层主要借助MapReduce技术,这是一种分布式计算模型,用于大规模数据集的并行处理。MapReduce将任务分解为Map阶段和Reduce阶段,便于并行计算和结果整合。

数据应用层则使用Hive进行数据分析。Hive是一个基于Hadoop的数据仓库工具,能将结构化的数据文件映射为一张数据库表,并提供SQL查询功能,适合大数据的离线分析。

数据访问层的实现则采用了Flask作为后台框架,Echarts作为前端框架,这两者结合可以创建交互式的数据可视化界面,将处理结果以图形化的方式展示,方便用户理解。

整个过程中,原始数据从生产环境的MySQL数据库导入,利用Sqoop工具将其批量转移到Hadoop的HDFS中。在HDFS上,MapReduce程序对数据进行预处理,预处理后的数据导入到Hive,Hive进行复杂的SQL查询和分析,最后将分析结果导回MySQL,供前端展示。这种架构有效地支持了大数据的处理和分析,实现了对招聘网站人才分析趋势的高效洞察。

2022-06-22 上传

2023-02-26 上传

2023-05-26 上传

2023-05-26 上传

2023-06-02 上传

2023-03-21 上传

2023-05-26 上传

2023-05-29 上传

知识世界

- 粉丝: 366

- 资源: 1万+

最新资源

- 计算机人脸表情动画技术发展综述

- 关系数据库的关键字搜索技术综述:模型、架构与未来趋势

- 迭代自适应逆滤波在语音情感识别中的应用

- 概念知识树在旅游领域智能分析中的应用

- 构建is-a层次与OWL本体集成:理论与算法

- 基于语义元的相似度计算方法研究:改进与有效性验证

- 网格梯度多密度聚类算法:去噪与高效聚类

- 网格服务工作流动态调度算法PGSWA研究

- 突发事件连锁反应网络模型与应急预警分析

- BA网络上的病毒营销与网站推广仿真研究

- 离散HSMM故障预测模型:有效提升系统状态预测

- 煤矿安全评价:信息融合与可拓理论的应用

- 多维度Petri网工作流模型MD_WFN:统一建模与应用研究

- 面向过程追踪的知识安全描述方法

- 基于收益的软件过程资源调度优化策略

- 多核环境下基于数据流Java的Web服务器优化实现提升性能