深度解析自注意力机制:Transformer架构在机器学习中的应用

需积分: 1 115 浏览量

更新于2024-07-04

收藏 16.28MB PDF 举报

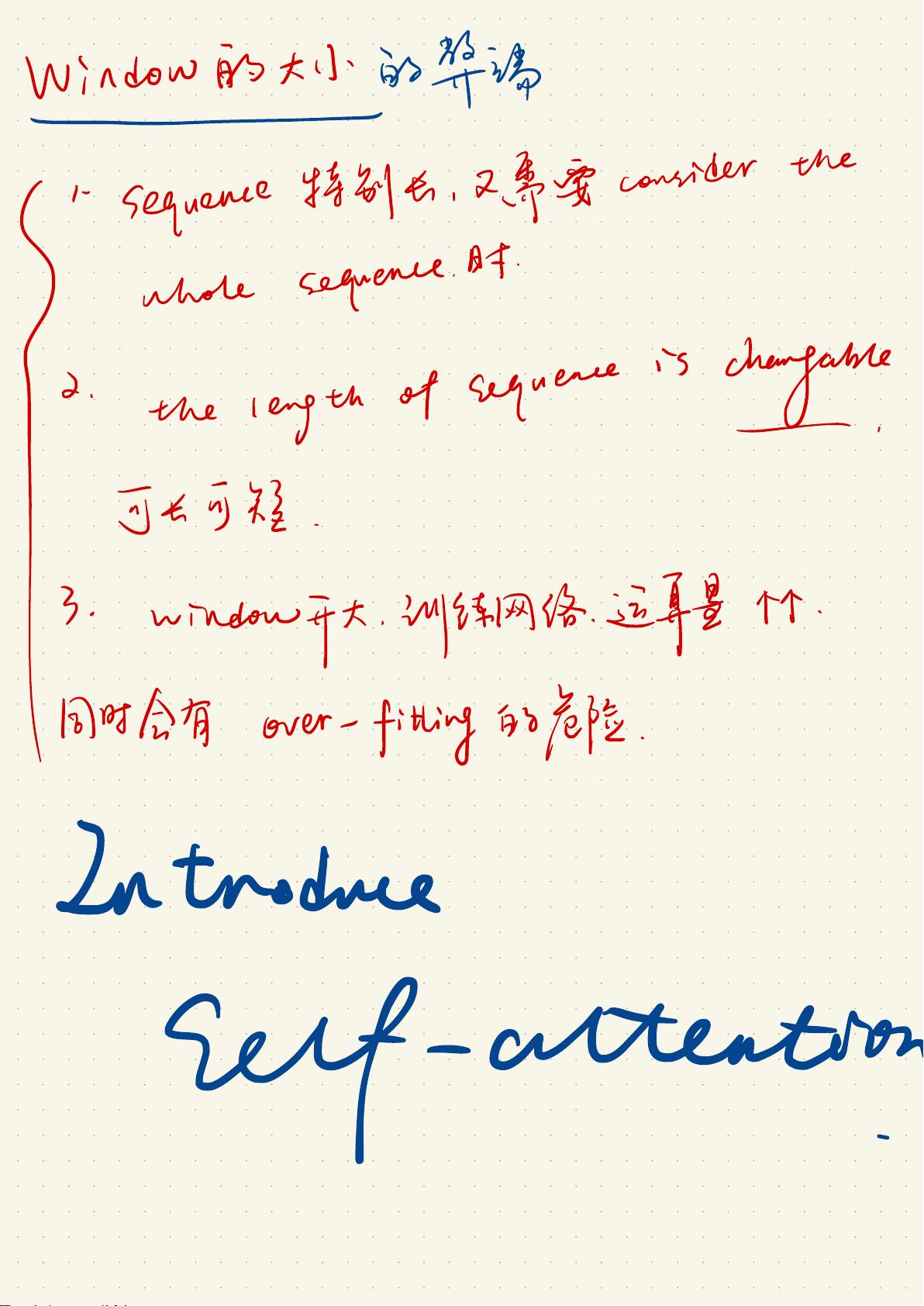

在台大李宏毅教授的21年机器学习课程中,关于self-attention和Transformer模块的讲解深入且详尽。Attention机制,特别是自注意力(Self-Attention)和Transformer架构,是深度学习领域中的重要概念,主要应用于自然语言处理(NLP)和计算机视觉(CV)等领域,特别是在序列模型中处理变长输入。

Self-Attention的核心思想是让模型在计算每个位置的隐藏状态时,不仅依赖于前一时刻的上下文,还同时考虑整句话所有位置的信息。它通过三个关键步骤实现:Query、Key和Value的映射,形成注意力权重,然后将这些权重与对应的Value进行加权求和,得到当前位置的新表示。这个过程允许模型捕捉全局上下文,解决了传统RNN中信息传播受限的问题。

Transformer模型是基于自注意力机制的,其核心组成部分包括多头注意力(Multi-Head Attention)、点积注意力(Dot Product Attention)、以及位置编码(Positional Encoding),使得模型能够处理并行计算,大大提高了效率。它由编码器(Encoder)和解码器(Decoder)构成,编码器用于捕捉输入序列的全局信息,而解码器则在生成序列时逐步结合编码器的上下文信息。

然而,Transformer并非没有挑战。例如,当序列长度过长时,计算复杂度会显著增加,可能导致内存消耗过大;同时,如果模型容量过大,可能会出现过拟合问题。因此,实践中通常采用合理的网络结构设计、剪枝方法和正则化策略来优化模型性能。

此外,Transformer模型的注意力机制可以灵活调整,如论文中提到的交替使用全注意力(Full Attention)和部分注意力(Partial Attention),或者在不同的head中学习不同的关注重点。这种灵活性使得模型能够适应不同任务的需求,并通过学习到的参数进行动态调整。

最后,Transformer中的参数共享和矩阵运算,如权重矩阵乘法,体现了模型的简洁性和高效性。通过将输入矩阵与几个不同头部的矩阵相乘,然后加总,模型能够提取出多种视角的信息,这在一定程度上实现了对输入内容的深度理解和抽象。

注意力机制和Transformer在机器学习中扮演着至关重要的角色,它们通过提供全局视角、并行计算和高效信息处理能力,极大地推动了NLP等领域的研究和应用。理解这些原理和技巧对于深入学习和实践深度学习技术至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2019-07-15 上传

2021-03-20 上传

2021-08-29 上传

2021-09-27 上传

点击了解资源详情

点击了解资源详情