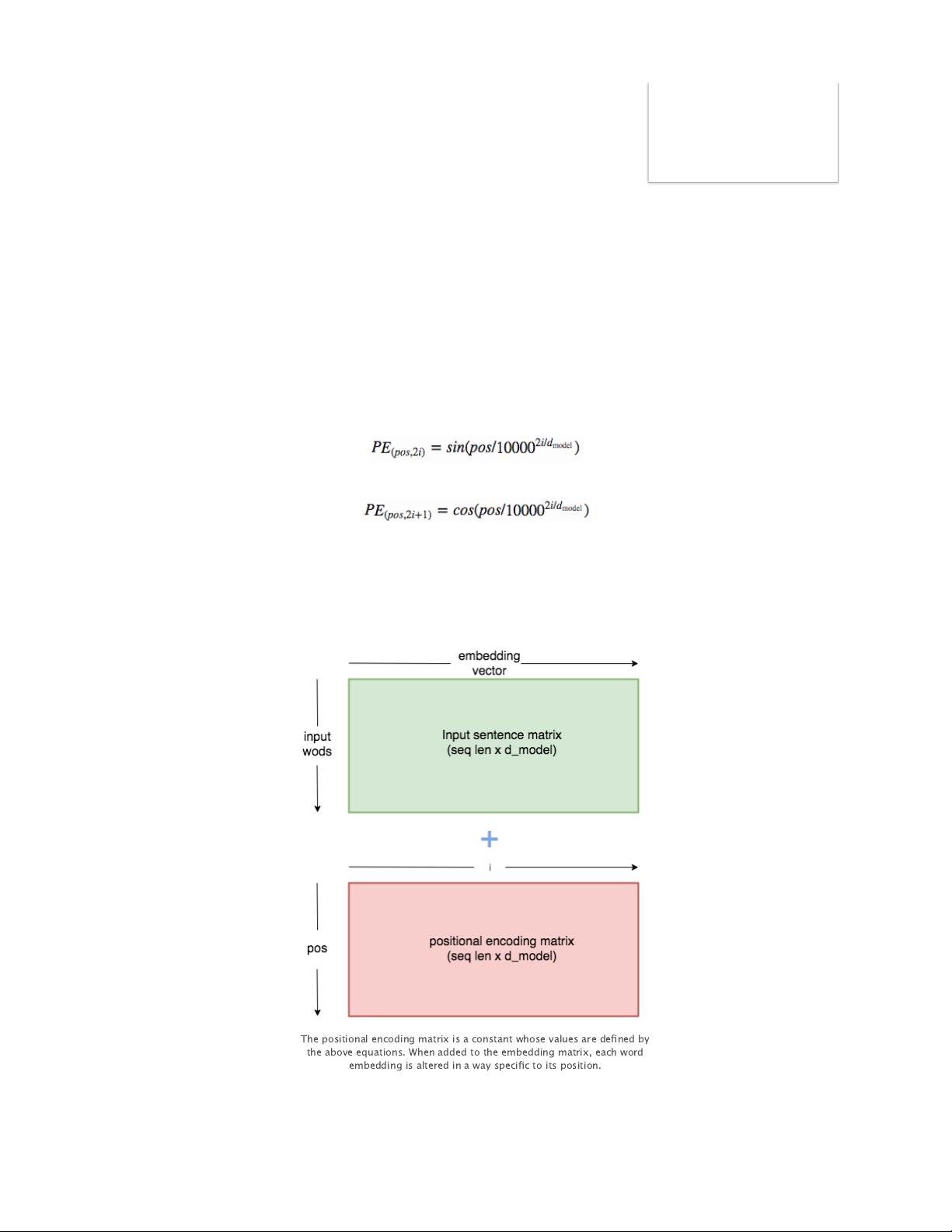

"这篇文章主要介绍了如何使用PyTorch实现Transformer模型,Transformer是一种在自然语言处理(NLP)领域中广泛使用的神经网络架构,由Vaswani等人在2017年的论文《Attention is All You Need》中提出。它通过自注意力机制(Self-Attention)替代了传统的循环神经网络(RNN),提高了处理序列数据的效率,尤其在大规模并行计算中表现出色。作者Samuel Lynn-Evans分享了他的实现过程,包括模型的构建和训练,并提供了一个在GitHub上的实现链接供读者实践和探索。" 在PyTorch中实现Transformer,首先需要理解其基本组成部分:编码器(Encoder)和解码器(Decoder)。编码器由多个相同的层组成,每个层又包含两个关键部分——自注意力层(Self-Attention Layer)和前馈神经网络层(Feed-Forward Neural Network Layer)。自注意力允许模型同时考虑输入序列的全部信息,而不仅仅是当前的上下文状态。前馈神经网络则进一步处理这些注意力加权后的信息。 解码器同样由多层构成,除了自注意力层,还添加了遮罩自注意力层(Masked Self-Attention Layer)以防止当前位置访问到未来位置的信息,以及一个额外的编码器-解码器注意力层(Encoder-Decoder Attention Layer),使解码器可以关注编码器的输出,获取整个输入序列的上下文信息。 训练Transformer模型通常涉及以下步骤: 1. **数据预处理**:获取适合序列到序列任务的双语语料库,如WMT'14英法翻译数据集,并将其转化为适合模型训练的格式。 2. **构建模型**:根据Transformer的结构定义编码器和解码器的网络层,包括嵌入层、自注意力层、前馈神经网络层等。 3. **损失函数与优化器**:选择合适的损失函数,如交叉熵损失,以及优化算法,如Adam。 4. **训练模型**:通过批量梯度下降策略进行训练,利用PyTorch的自动求导功能计算损失的梯度。 5. **评估与测试**:在验证集上评估模型性能,并在测试集上进行最终测试。 作者提到,他在三天内用Transformer模型训练了一个基于200万对法英句子的翻译器,这显示了Transformer在训练速度和效果上的优势。此外,他提供了GitHub上的代码实现,让读者可以亲自尝试和了解Transformer的工作原理。 PyTorch实现Transformer是NLP领域的热门话题,因为它为处理序列数据提供了新的高效方法,尤其是在大规模并行计算环境中。通过阅读Samuel Lynn-Evans的文章和实践他的代码,读者可以深入理解Transformer的内部工作机制,并可能应用到自己的项目中。

剩余14页未读,继续阅读

- 粉丝: 64

- 资源: 304

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

最新资源

- Lombok 快速入门与注解详解

- SpringSecurity实战:声明式安全控制框架解析

- XML基础教程:从数据传输到存储解析

- Matlab实现图像空间平移与镜像变换示例

- Python流程控制与运算符详解

- Python基础:类型转换与循环语句

- 辰科CD-6024-4控制器说明书:LED亮度调节与触发功能解析

- AE particular插件全面解析:英汉对照与关键参数

- Shell脚本实践:创建tar包、字符串累加与简易运算器

- TMS320F28335:浮点处理器与ADC详解

- 互联网基础与结构解析:从ARPANET到多层次ISP

- Redhat系统中构建与Windows共享的Samba服务器实战

- microPython编程指南:从入门到实践

- 数据结构实验:顺序构建并遍历链表

- NVIDIA TX2系统安装与恢复指南

- C语言实现贪吃蛇游戏基础代码

信息提交成功

信息提交成功