深度解析循环神经网络在序列学习中的关键作用

需积分: 15 106 浏览量

更新于2024-07-17

收藏 1.03MB PDF 举报

本文是一篇关于循环神经网络(Recurrent Neural Networks, RNNs)在序列学习中的关键回顾。随着众多领域对处理顺序数据的需求增加,如图像描述、语音合成、音乐生成以及时间序列预测、视频分析和音乐信息检索等,RNNs因其独特的结构而变得尤为重要。这些模型通过网络节点中的循环连接来捕捉序列数据中的动态,使其能够处理任意长度的上下文信息。

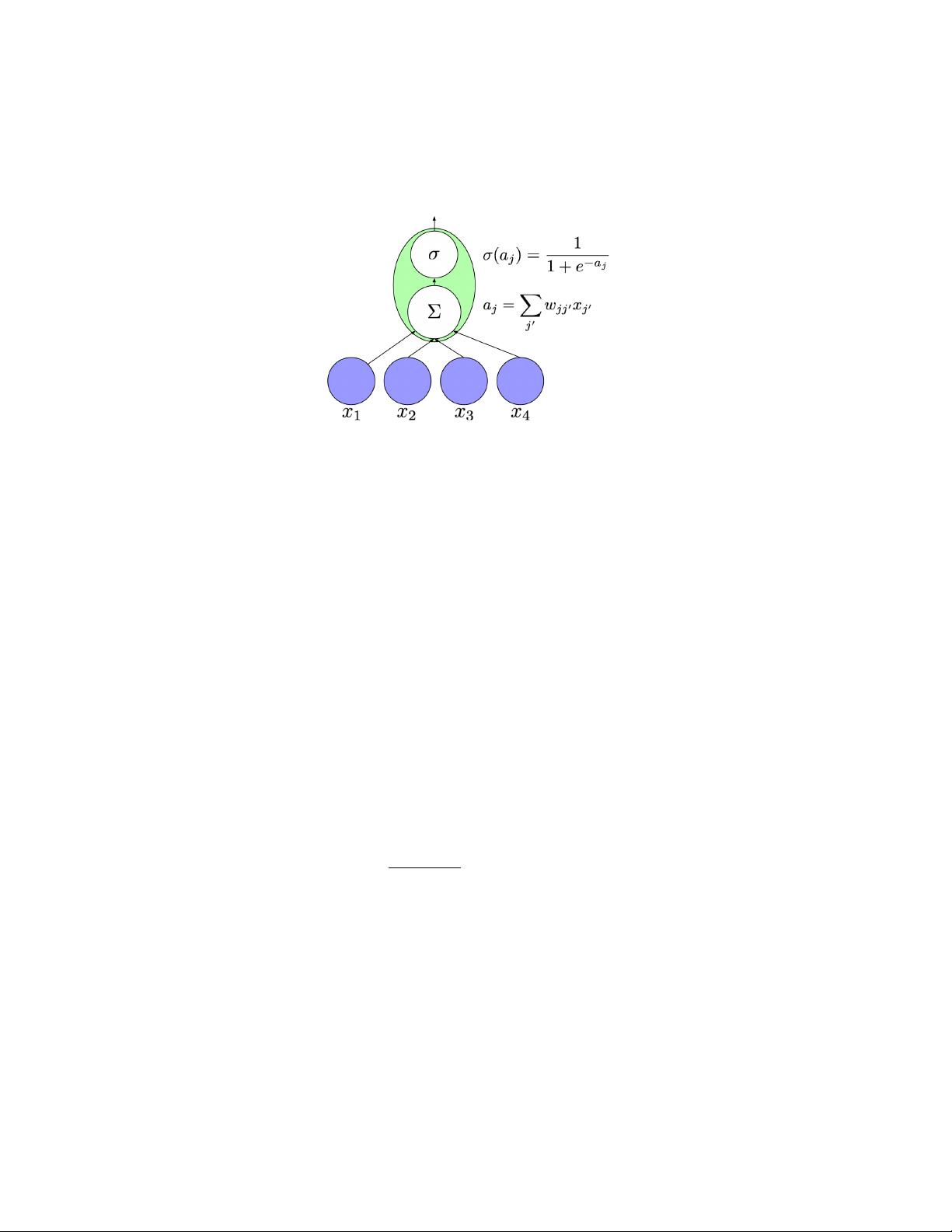

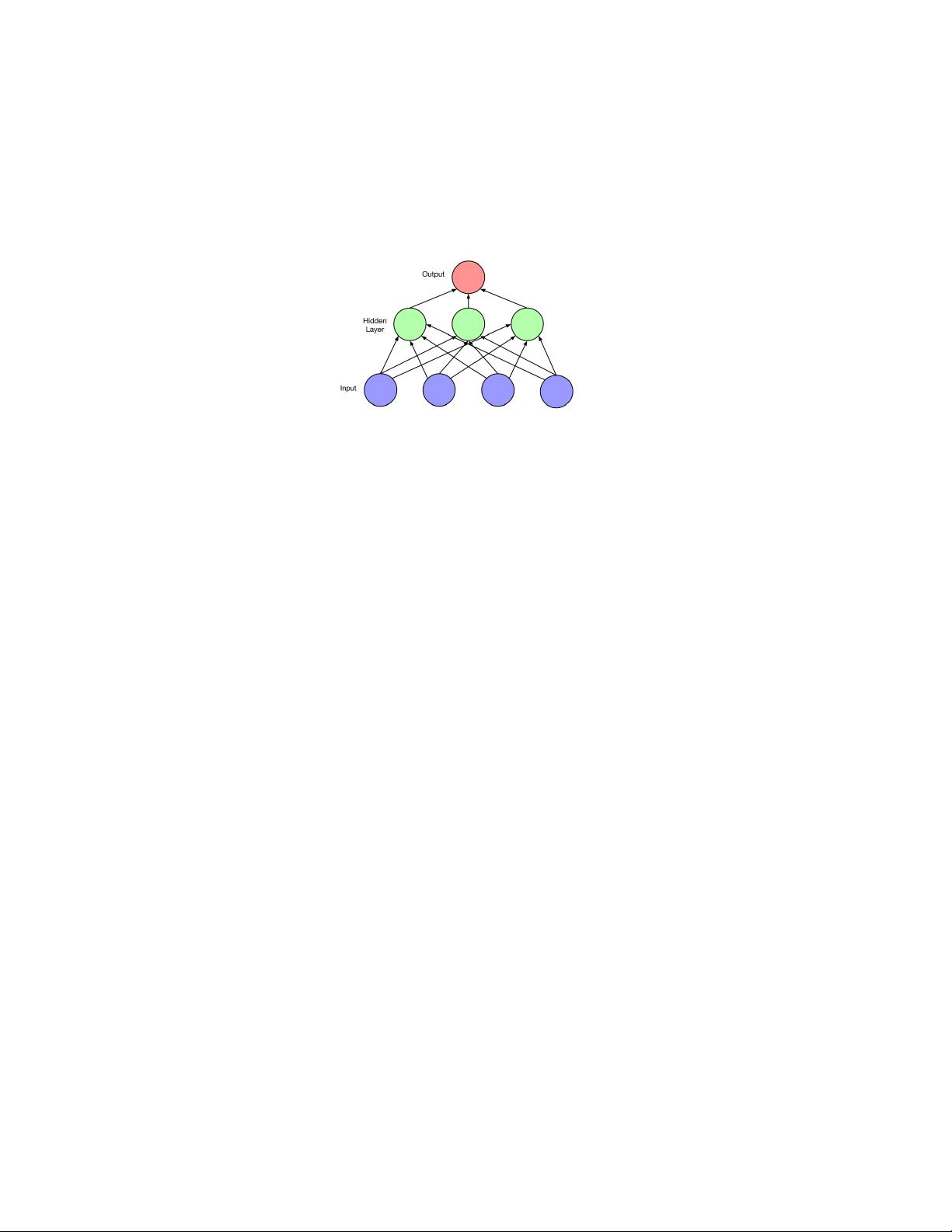

标准的前馈神经网络(Feedforward Neural Networks, FNNs)与RNN的主要区别在于,RNN能够在处理序列时保持一个状态(或称为记忆),这使得它们能够处理具有时间依赖性的输入,比如自然语言翻译、对话交互和机器人控制等任务。这些任务通常需要同时具备生成和理解序列的能力。

尽管RNN在理论上非常强大,但它们的传统训练往往面临挑战,因为它们包含了大量的参数,容易导致梯度消失或爆炸问题,尤其是在长期依赖性(long-term dependencies)的情境下。然而,近年来的研究显著改进了RNN的架构和优化方法,如长短时记忆网络(LSTM)和门控循环单元(GRU)的引入,这些问题得到了一定程度的缓解。这些新设计的单元更好地管理了内部状态更新,使得RNN在实际应用中表现更加稳定和有效。

此外,论文还探讨了其他关键主题,例如:

1. **模型训练的优化策略**:新的训练技术,如批标准化(Batch Normalization)、自适应学习率调整(Adaptive Learning Rates)和更高效的优化算法(如Adam)被提出,以提高RNN的训练效率和性能。

2. **序列到序列学习(Sequence-to-Sequence, Seq2Seq)模型**:RNN在编码器-解码器框架下的应用,这种模型广泛用于机器翻译、文本摘要和对话系统中,通过端到端的学习实现了序列数据的转换。

3. **注意力机制(Attention Mechanisms)**:如何结合RNN与注意力机制,以聚焦于输入序列中的关键部分,提高了模型对复杂序列的理解和生成能力。

4. **深度学习和多层RNN**:多层次的设计允许RNN捕获更复杂的序列模式,增强了模型的表达能力。

5. **RNN的应用局限性及未来研究方向**:尽管取得了显著进步,RNN在某些情况下仍面临计算效率和内存消耗的问题。论文提出了对未来研究可能的方向,如轻量级RNN架构、并行化训练方法以及RNN与Transformer等新型模型的融合。

总结来说,这篇批判性回顾文章深入剖析了RNN在序列学习中的核心原理、优势与挑战,展示了其在处理各种序列任务中的重要作用,并展望了未来的研究趋势,为该领域的研究人员和实践者提供了宝贵的参考。

2008-10-15 上传

点击了解资源详情

点击了解资源详情

2023-02-28 上传

2023-05-31 上传

2023-03-29 上传

2023-03-10 上传

2023-03-16 上传

qq_26493017

- 粉丝: 0

- 资源: 12

最新资源

- 计算机人脸表情动画技术发展综述

- 关系数据库的关键字搜索技术综述:模型、架构与未来趋势

- 迭代自适应逆滤波在语音情感识别中的应用

- 概念知识树在旅游领域智能分析中的应用

- 构建is-a层次与OWL本体集成:理论与算法

- 基于语义元的相似度计算方法研究:改进与有效性验证

- 网格梯度多密度聚类算法:去噪与高效聚类

- 网格服务工作流动态调度算法PGSWA研究

- 突发事件连锁反应网络模型与应急预警分析

- BA网络上的病毒营销与网站推广仿真研究

- 离散HSMM故障预测模型:有效提升系统状态预测

- 煤矿安全评价:信息融合与可拓理论的应用

- 多维度Petri网工作流模型MD_WFN:统一建模与应用研究

- 面向过程追踪的知识安全描述方法

- 基于收益的软件过程资源调度优化策略

- 多核环境下基于数据流Java的Web服务器优化实现提升性能