使用sklearn实现线性与非线性逻辑回归

PDF格式 | 580KB |

更新于2024-08-31

| 89 浏览量 | 举报

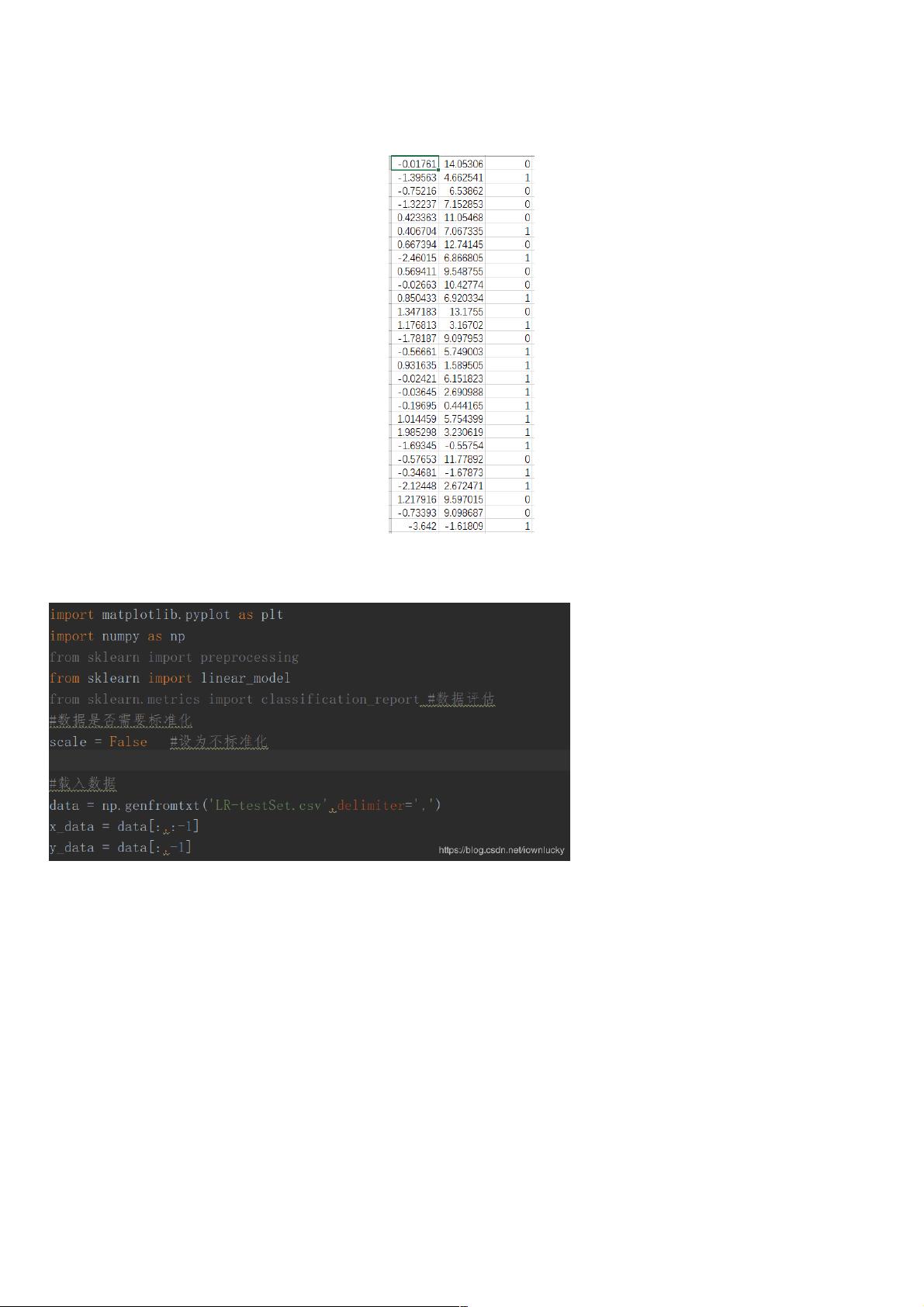

"这篇文章主要介绍了如何在Python中使用sklearn库实现线性逻辑回归和非线性逻辑回归。文中通过示例代码详细讲解了这两种回归方法,并提供了数据可视化和模型评估的结果。"

线性逻辑回归(Linear Logistic Regression)是一种广泛应用的分类算法,尤其适用于二分类问题。它基于线性函数来预测概率,即假设模型的决策边界是线性的。在sklearn库中,可以使用`LogisticRegression`类实现线性逻辑回归。以下是一个简单的实现步骤:

1. 导入必要的库:首先需要导入sklearn库中的`LogisticRegression`,以及数据处理和绘图的相关库,如`numpy`,`pandas`,`matplotlib`和`seaborn`。

2. 加载数据:加载训练数据,这里的数据包含两个特征和对应的标签。

3. 数据预处理:如果需要,可以进行数据清洗、缺失值处理和标准化。

4. 创建模型:实例化`LogisticRegression`对象,可以设置参数如正则化强度(C)、优化算法(solver)等。

5. 模型拟合:使用`fit`方法将数据输入模型进行训练。

6. 预测:使用`predict`方法进行预测,可以获取预测的类别。

7. 评估:计算模型的性能,如准确率、召回率、F1值等。sklearn库提供了`classification_report`函数方便进行这些计算。

非线性逻辑回归(Nonlinear Logistic Regression)则使用非线性函数作为决策边界,通常需要通过特征工程增加数据的维度,例如使用多项式特征。在sklearn中,可以结合`PolynomialFeatures`类来实现这一点。

1. 多项式特征转换:使用`PolynomialFeatures`将原始特征转换为更高次幂的特征,增加数据的复杂性。

2. 创建模型:实例化`LogisticRegression`,但这次可能需要设置合适的正则化参数以防止过拟合。

3. 模型拟合和预测:与线性逻辑回归类似,拟合转换后的数据并进行预测。

4. 评估:同样计算模型的性能指标。

两种逻辑回归的核心区别在于预估函数,线性逻辑回归采用线性函数,而非线性逻辑回归则是通过多项式或其他非线性变换构建更复杂的决策边界。它们共享相同的代价函数——对数似然损失函数,但非线性逻辑回归的预测能力更强,可以处理更复杂的非线性关系。在实际应用中,应根据数据的特性选择合适的逻辑回归模型。

相关推荐

weixin_38673235

- 粉丝: 3

最新资源

- 免费教程:Samba 4 1级课程入门指南

- 免费的HomeFtpServer软件:Windows服务器端FTP解决方案

- 实时演示概率分布的闪亮Web应用

- 探索RxJava:使用RxBus实现高效Android事件处理

- Microchip USB转UART转换方案的完整设计教程

- Python编程基础及应用实践教程

- Kendo UI 2013.2.716商业版ASP.NET MVC集成

- 增强版echarts地图:中国七大区至省详细数据解析

- Tooloop-OS:定制化的Ubuntu Server最小多媒体系统

- JavaBridge下载:获取Java.inc与JavaBridge.jar

- Java编写的开源小战争游戏Wargame解析

- C++实现简易SSCOM3.2功能的串口调试工具源码

- Android屏幕旋转问题解决工具:DialogAlchemy

- Linux下的文件共享新工具:Fileshare Applet及其特性介绍

- 高等应用数学问题的matlab求解:318个源程序打包分享

- 2015南大机试:罗马数字转十进制数代码解析