斯坦福Boyd与UCLA Vandenberghe教授的向量、矩阵与最小二乘法讲义概要

需积分: 9 74 浏览量

更新于2024-07-18

1

收藏 3.92MB PDF 举报

在"向量、矩阵与最小二乘法:应用线性代数导论"的讲座幻灯片中,作者Stephen Boyd和Lieven Vandenberghe以深入浅出的方式介绍了数学在机器学习中的基础概念。这门课程作为斯坦福大学EE103和加州大学洛杉矶分校EE133A课程的主要教材,由剑桥大学出版社出版,旨在帮助学生理解基本的数学工具。

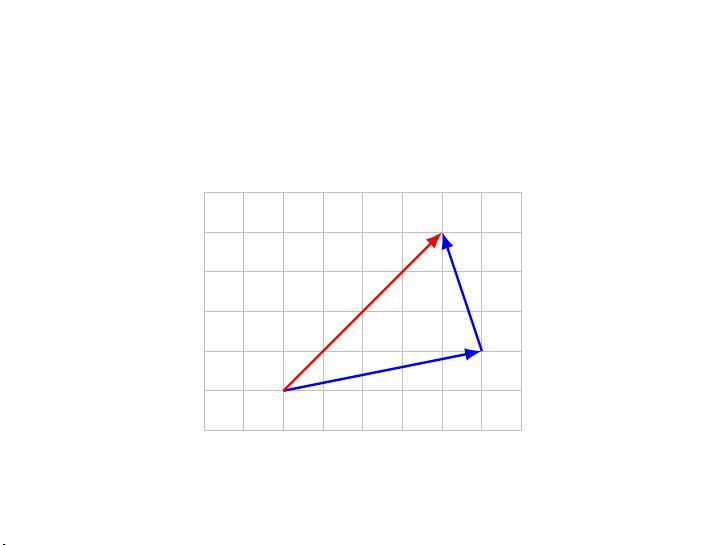

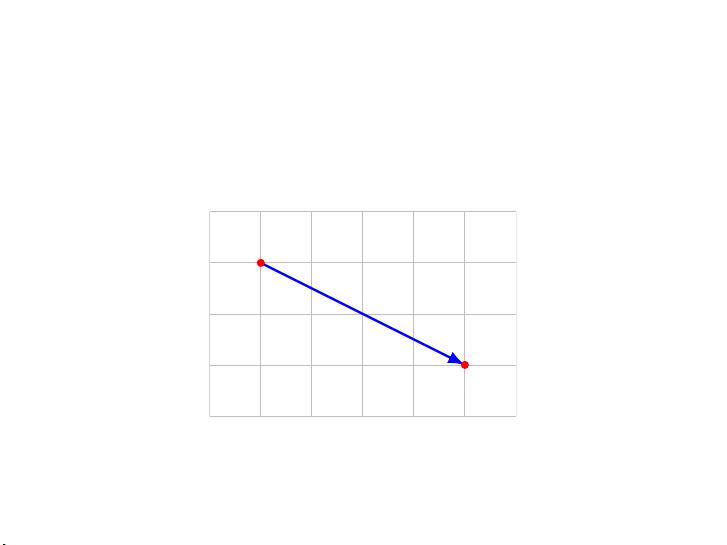

首先,讲座从向量的概念入手。向量被定义为有序的数值列表,可以表示为一个矩阵或数组,如上例中的列向量,包含四个元素(-1.1, 0.0, 3.6, -7.2),每个数值称为向量的分量或系数。向量的大小或维度是指其元素数量,例如上述向量的维度为4。一个有n个元素的向量通常被称为n维向量,比如n-向量。这里的向量通常用符号如a、X、p、β或者E来表示,其中的a3代表向量a的第三个分量。

符号系统中,用下标i来标识向量中的元素,例如在a向量中,a_i表示第i个元素。对于一个n维向量,i的取值范围从1到n。值得注意的是,有时候i可能指的是向量列表中的第i个向量,这可能导致混淆,因此在讨论中需要明确指明。

矩阵和向量的运算包括基本的加法和标量乘法。向量的加法是对应位置的元素相加,而标量乘法则是将一个标量(数字)与整个向量的每个元素相乘。内积(也称点积或标量积)是两个向量之间的一种特殊运算,它计算的是对应元素的乘积之和,并且在计算时要求向量的维度相等。

最小二乘法是这部分内容的核心,它是一种优化技术,在许多机器学习问题中用于拟合数据,通过找到最佳拟合直线或曲线来最小化实际数据与预测之间的误差。这个方法在处理线性回归、特征工程和模型训练中扮演着关键角色。

向量、矩阵和最小二乘法的学习是理解机器学习算法的基础,这些概念包括向量的表示、运算规则、内积的意义以及如何通过最小化误差来解决实际问题。掌握这些数学工具不仅对理论学习至关重要,也是应用于实际工程项目的必备技能。通过Boyd和Vandenberghe的教材,学生能够建立起扎实的数学基础,从而在机器学习的道路上稳步前行。

2020-12-09 上传

2019-11-13 上传

2018-11-02 上传

2023-05-27 上传

2023-05-26 上传

2023-07-14 上传

2023-04-28 上传

2023-04-01 上传

2023-03-31 上传

chaihahaha

- 粉丝: 0

- 资源: 25

最新资源

- 十种常见电感线圈电感量计算公式详解

- 军用车辆:CAN总线的集成与优势

- CAN总线在汽车智能换档系统中的作用与实现

- CAN总线数据超载问题及解决策略

- 汽车车身系统CAN总线设计与应用

- SAP企业需求深度剖析:财务会计与供应链的关键流程与改进策略

- CAN总线在发动机电控系统中的通信设计实践

- Spring与iBATIS整合:快速开发与比较分析

- CAN总线驱动的整车管理系统硬件设计详解

- CAN总线通讯智能节点设计与实现

- DSP实现电动汽车CAN总线通讯技术

- CAN协议网关设计:自动位速率检测与互连

- Xcode免证书调试iPad程序开发指南

- 分布式数据库查询优化算法探讨

- Win7安装VC++6.0完全指南:解决兼容性与Office冲突

- MFC实现学生信息管理系统:登录与数据库操作