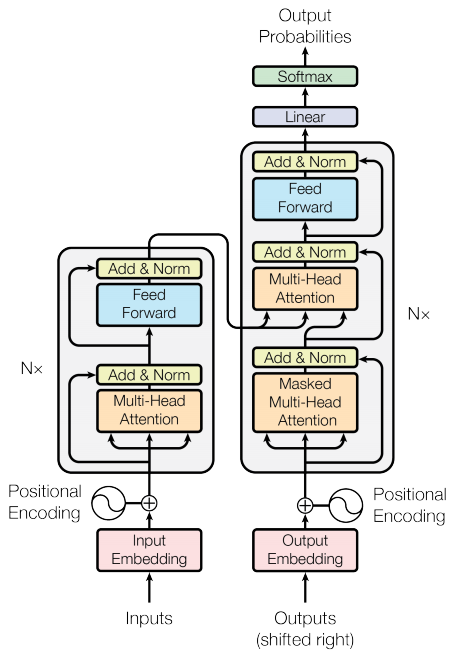

transformer模型网络结构图

时间: 2024-10-17 21:02:01 浏览: 64

Transformer是一种基于自注意力机制(Self-Attention)的深度学习模型,最初由Google在2017年提出的BERT模型中广泛应用。其核心特点是没有传统的循环神经网络(RNN)或卷积神经网络(CNN)那样的局部依赖结构,而是通过全序列计算实现了对输入序列的全局理解。

Transformer模型的基本网络结构包含以下几个关键组件:

1. **编码器(Encoder)**:它由多个相同的编码层组成,每个编码层包括自注意力层、前馈神经网络(FFN)和位置编码。自注意力层负责捕捉输入序列中任意两个元素之间的关联,而FFN则用于加深深度。

2. **解码器(Decoder)**:与编码器类似,也由多个解码层构成,但通常有自注意力层受到限制,只能看到前面的编码器输出,防止了信息泄漏。每个解码层也有自注意力层和FFN。

3. **自注意力层(Self-Attention)**:允许模型同时考虑输入序列中的所有位置,提高了处理长距离依赖的能力。

4. **前馈神经网络(Feedforward Network, FFN)**:通常是两层全连接网络,用于非线性变换和增深模型。

5. **位置编码(Positional Encoding)**:为了给模型提供序列顺序的信息,会将位置信息添加到输入向量中。

相关问题

Transformer模型的结构图

Transformer 模型的结构图大致如下:

1. 输入层:将输入的句子中的每个词表示成一个向量,然后输入到 Transformer 模型中。

2. 词嵌入层:将输入层的向量作为输入,将每个词转化成一个更高维度的向量,以便模型可以更好地处理这些信息。

3. 编码器和解码器层:Transformer 模型的核心部分,它包含了若干个编码器和解码器层,负责将输入序列编码成一个稠密的向量表示,然后将这个向量解码成输出序列。

4. 输出层:将解码器层的输出转化成输出序列中的词的概率分布。

5. 注意力机制:在编码器和解码器层中,注意力机制负责根据当前输入和之前的输出计算出一个权重分布,表示当前输出需要关注哪些输入信息。

显示一下Transformer模型的结构图像

Transformer 模型是一种注意力机制和并行计算的神经机器翻译模型,由谷歌在 2017 年提出。下图是 Transformer 的结构图像。

图中,输入的句子被编码成维度为 d 的嵌入张量,然后经过多个编码器层和多个解码器层。每个编码器和解码器层包含多个注意力机制和前馈网络。最后,解码器输出被映射回词汇表中的词,生成最终的翻译句子。

阅读全文