深度解析哨兵一号数据预处理:掌握自动化处理与高级脚本应用

发布时间: 2024-12-23 17:49:45 阅读量: 3 订阅数: 3

哨兵一号数据Snap预处理指导书

# 摘要

随着大数据时代的到来,数据预处理成为数据科学和分析的关键步骤。本文首先概述了数据预处理的重要性及其在保证数据质量方面的作用。随后,深入分析了哨兵一号数据的特定格式与特征,突出了数据预处理的必要性,包括处理数据质量问题和实现数据预处理目标。接着,文章探讨了自动化数据预处理流程,包括工具的选择、数据清洗、转换和归一化的策略。本文还特别关注了高级脚本语言在数据预处理中的应用,强调了Python的优势,并提供了使用高级脚本实现复杂数据处理和优化性能的策略。最后,通过哨兵一号数据的案例实践,展示了预处理脚本的编写、执行和验证过程,以及如何将预处理结果应用于业务并提出持续改进的建议。整体上,本研究为数据预处理提供了全面的理论与实践框架,旨在提升数据分析的效率和准确性。

# 关键字

数据预处理;哨兵一号;自动化工具;数据清洗;Python脚本;性能评估

参考资源链接:[哨兵一号数据预处理操作指南:从校准到辐射校正](https://wenku.csdn.net/doc/6412b4b6be7fbd1778d408dc?spm=1055.2635.3001.10343)

# 1. 数据预处理概述

数据预处理是整个数据分析流程中的基石,它确保了数据质量和后续分析的准确性。预处理包括数据清洗、转换、归一化等多个步骤,其主要目的是将原始数据转化为适合分析的格式。数据预处理不仅能修正数据中的错误和不一致,还能提升数据的可用性,为数据挖掘和机器学习等高级分析工作奠定基础。有效的数据预处理能显著提高分析模型的性能,是决定数据科学项目成功与否的关键环节。在本章中,我们将探讨数据预处理的基本概念、重要性以及如何着手开始数据预处理工作。

# 2. 哨兵一号数据格式和特征

## 2.1 哨兵一号数据格式解析

### 2.1.1 数据格式介绍

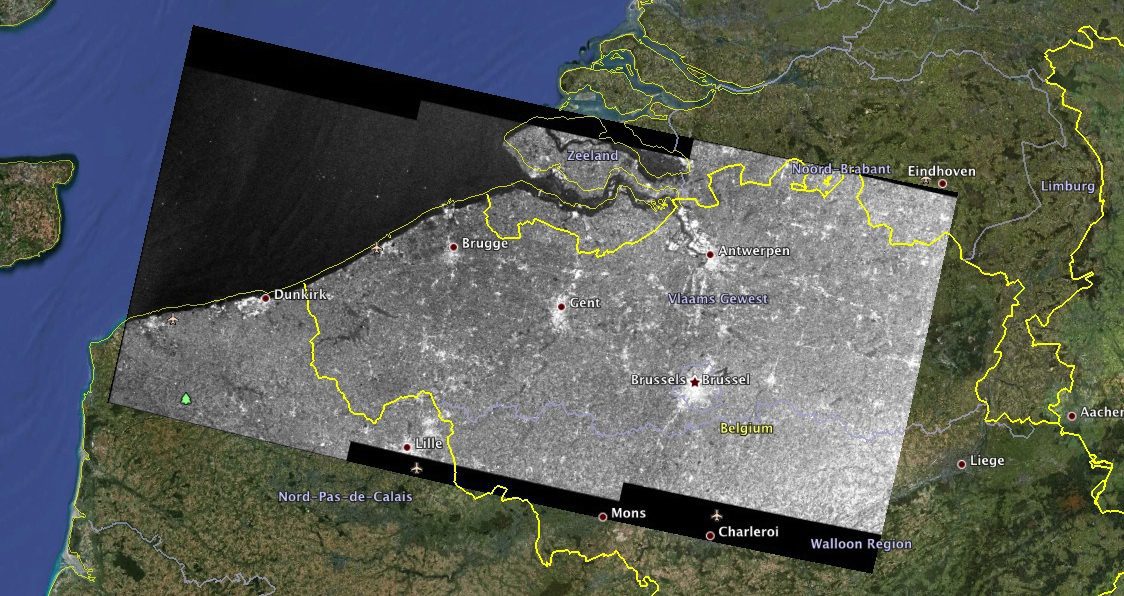

哨兵一号(Sentinel-1)是由欧洲空间局(ESA)发射的一系列地球观测卫星,它们携带的C波段合成孔径雷达(SAR)传感器能够在全天候、全天时条件下提供高分辨率的地球表面图像。哨兵一号的数据格式主要包括以下几种:

- **GRD(Ground Range Detected)**:地面距离检测的产品,是最常用的数据格式,已经包含了辐射校正,便于用户直接分析和使用。

- **SLC(Single Look Complex)**:单视复数数据格式,保留了幅度和相位信息,适用于干涉测量等高级处理。

- **OCN(Ocean)**:专门为海洋应用设计的数据产品。

每种数据格式都有其特定的用途,用户可根据需要选择合适的数据格式进行分析。

### 2.1.2 数据结构深入分析

哨兵一号数据遵循了欧洲空间局的标准数据格式,包含多个信息层次,例如:

- **manifest.safe**:包含数据集的元数据信息,提供关于产品信息、传感器参数、处理信息等。

- **measurement**:包括辐射亮度、灰度等数据,直接反映了地表信息。

- **annotation**:提供地表高度、斜距、方位角等信息,用于地理定位和后续分析。

深入理解这些数据结构,有助于我们利用这些数据进行高效、准确的分析和应用。

## 2.2 数据预处理的必要性

### 2.2.1 数据质量问题

数据质量问题通常是由于传感器缺陷、大气影响、地面特征复杂性等因素导致的。哨兵一号数据也不例外,可能会遇到以下质量问题:

- **斑点噪声**:由于SAR图像自身的成像机理,使得图像出现类似噪声的斑点。

- **视角差异**:由于卫星观测角度不同,地物的反射特性可能会发生变化,导致数据解释不一致。

- **地理坐标失真**:由于地球曲率和卫星观测角度的不同,直接使用数据可能会造成地理坐标的失真。

### 2.2.2 数据预处理的目标和作用

数据预处理的目标主要是解决上述质量问题,并确保数据质量,提高数据的可用性和准确性。其作用包括:

- **标准化数据格式**:确保数据格式统一,便于后续的自动化处理和分析。

- **增强数据质量**:通过各种数据清洗和增强技术,提升数据的可读性和可靠性。

- **数据融合与校正**:将哨兵一号数据与其他来源的数据融合,进行地理编码、地形校正等操作,以适应不同的分析需求。

通过数据预处理,我们可以让原始数据更加贴近实际的地理和物理特性,为进一步的科研和业务应用奠定坚实的基础。

# 3. 自动化数据预处理流程

## 3.1 自动化工具选择与应用

### 3.1.1 常用的自动化处理工具

随着技术的发展,数据预处理的自动化工具日益丰富,为数据科学家提供了极大的便利。在众多的自动化工具中,我们可以根据需要选择适合自己的工具。常见的自动化数据预处理工具有:Apache NiFi、Apache Spark、KNIME、Talend等。这些工具各有千秋,例如Apache NiFi以其易于配置和流程设计的直观性著称,而Apache Spark则以高效的数据处理能力闻名。

```mermaid

flowchart LR

A[开始] --> B[数据收集]

B --> C[数据清洗]

C --> D[数据转换]

D --> E[数据归一化]

E --> F[数据存储]

F --> G[结束]

```

### 3.1.2 工具的优劣分析

尽管自动化工具提供了很多便利,但不同的工具在处理数据时会有不同的优势和局限性。例如,Apache Spark在大数据场景下有出色的表现,但在处理小规模数据集时,可能会显得过于重量级。KNIME则适合非技术用户,通过图形化界面进行操作,但可能会限制了数据处理的复杂度。因此,在选择自动化工具时,应充分考虑数据集的大小、结构复杂度以及团队的技术栈。

```mermaid

graph TD

A[选择自动化工具] --> B[Apache NiFi]

A --> C[Apache Spark]

A --> D[KNIME]

A --> E[Talend]

B --> F[易于配置]

C --> G[高效大数据处理]

D --> H[图形化操作]

E --> I[丰富的集成]

F --> J[适合轻量级任务]

G --> K[适合大规模任务]

H --> L[用户友好度高]

I --> M[集成多种技术]

J --> N[评估结果]

K --> N

L --> N

M --> N

```

## 3.2 数据清洗策略

### 3.2.1 缺失值处理

在数据预处理中,缺失值是一个常见的问题。处理缺失值的方法有很多,常见的包括删除含有缺失值的记录、用平均值/中位数/众数填充缺失值、使用预测模型来估计缺失值等。每种方法都有其适用的场景,如当缺失值比例较低时,可以考虑删除;若数据集较大,使用平均值填充较为方便。这里提供一个使用Python进行缺失值处理的简单示例:

```python

import pandas as pd

# 加载数据集

df = pd.read_csv("data.csv")

# 检测并处理缺失值

df.fillna(df.mean(), inplace=True) # 使用平均值填充

# 或者

# df.dropna(inplace=True) # 删除含有缺失值的行

```

### 3.2.2 异常值处理

异常值检测和处理是数据清洗的一个重要环节。异常值可以由多种原因造成,例如数据输入错误、测量误差或者真实的离群值。识别异常值的方法包括标准差方法、箱形图、基于聚类的方法等。根据异常值的类型和业务需求,可以采取不同的处理措施,如修正或删除异常值。

```python

import numpy as np

# 使用箱形图方法识别异常值

Q1 = df.quantile(0.25)

Q3 = df.quantile(0.75)

IQR = Q3 - Q1

# 定义异常值为IQR的1.5倍之外的值

outliers = df[~((df >= (Q1 - 1.5 * IQR)) & (df <= (Q3 + 1.5 * IQR))).all(axis=1)]

```

### 3.2.3 噪声数据处理

噪声数据通常指那些由于各种随机误差造成的不准确数据。在处理噪声数据时,可以使用滤波技术、平滑技术或者信号处理方法来减少噪声的影响。例如,移动平均法可以有效地减少时间序列数据中的随机波动。

```python

# 移动平均法处理时间序列数据中的噪声

def moving_average(data, window_size):

return data.rolling(window=window_size).mean()

# 应用移动平均法

df['smoothed_column'] = moving_average(df['target_column'], 3)

```

## 3.3 数据转换和归一化

### 3.3.1 数据类型转换

数据类型转换是将数据从一种类型转换为另一种类型的过程,这在数据预处理中非常常见。例如,将日期字符串转换为日期时间类型,或者将分类数据转换为数值类型。在Python中,可以使用pandas库来实现这一转换:

```python

# 将字符串类型日期转换为日期时间类型

df['date_str'] = pd.to_datetime(df['date_str'])

```

### 3.3.2 数据归一化方法

数据归一化是将数据按比例缩放,使之落入一个小的特定区间。常见的归一化方法包括最小-最大归一化、Z分数标准化等。这些方法可以减少不同特征间量纲的影响,使得模型的收敛速度加快。

```python

# 最小-最大归一化

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

df_scaled = scaler.fit_transform(df)

```

### 3.3.3 数据离散化技术

在处理连续特征时,数据离散化是一个重要的预处理步骤。数据离散化将连续的特征值分成若干离散的区间。这有利于处理非线性关系,并且可以提高模型的泛化能力。离散化方法包括等宽分箱、等频分箱等。

```python

# 等宽分箱离散化

import numpy as np

# 定义分箱边界

bins = np.linspace(df['feature'].min(), df['feature'].max(), 10)

# 应用分箱

df['binned'] = pd.cut(df['feature'], bins)

```

以上为数据预处理流程的三个主要环节:自动化工具选择与应用、数据清洗策略以及数据转换和归一化。在实际操作中,应针对数据集的特点和业务需求,灵活选择合适的预处理方法和工具,以达到最优的数据质量。

# 4. 高级脚本在数据预处理中的应用

## 4.1 Python脚本在数据预处理中的优势

### 4.1.1 Python的库与模块支持

Python之所以在数据预处理领域广受欢迎,部分原因在于其强大的库和模块生态系统。在数据科学和工程中,Python的标准库提供了一系列的工具,可用于执行文件操作、处理数据结构、网络通信等。此外,其丰富的第三方库极大地方便了数据分析和预处理工作。

以`pandas`库为例,它提供了DataFrame和Series数据结构,这对于表格数据的处理尤为方便。`numpy`库则支持高效数值计算,能够处理大型多维数组。对于数据可视化,`matplotlib`和`seaborn`提供了丰富的图表绘制功能。在机器学习领域,`scikit-learn`库提供了一整套算法和工具进行数据的预处理和模型构建。

Python的模块化设计使得开发人员可以轻松地将不同的库组合在一起,构建出复杂的数据处理流程。这使得Python成为了数据预处理自动化脚本开发的理想选择。

```python

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

from sklearn.preprocessing import StandardScaler

# 示例:使用pandas读取数据,numpy进行计算,matplotlib绘图

data = pd.read_csv('data.csv')

data_array = np.array(data)

# 计算平均值和标准差

mean = np.mean(data_array, axis=0)

std_dev = np.std(data_array, axis=0)

# 数据标准化

scaler = StandardScaler()

data_normalized = scaler.fit_transform(data_array)

# 绘制结果图

plt.plot(mean, label='Mean')

plt.plot(std_dev, label='Standard Deviation')

plt.legend()

plt.show()

```

### 4.1.2 Python在数据预处理的案例分析

在实际的数据预处理任务中,Python可以通过组合不同的库来执行一系列的预处理操作。下面展示一个具体的案例分析,该案例将从数据清洗到数据转换,使用Python脚本实现完整流程。

```python

# 数据清洗:处理缺失值

df = pd.read_csv('dirty_data.csv')

df_cleaned = df.dropna() # 删除含有缺失值的行

# 数据转换:字符串到数值

df_cleaned['category'] = df_cleaned['category'].map({'category1': 1, 'category2': 2})

# 数据离散化

df_cleaned['age_range'] = pd.cut(df_cleaned['age'], bins=5, labels=False)

# 数据归一化

scaler = StandardScaler()

df_cleaned[['feature1', 'feature2']] = scaler.fit_transform(df_cleaned[['feature1', 'feature2']])

```

通过上述步骤,我们可以看到Python如何使用不同的库来完成数据预处理的各项任务。在数据清洗、转换和归一化的过程中,Python脚本的可读性和灵活性都非常高,能够清晰地表达处理逻辑,并且易于维护和扩展。

## 4.2 利用高级脚本实现复杂数据处理

### 4.2.1 正则表达式处理文本数据

在处理文本数据时,正则表达式是不可或缺的工具。Python通过内置的`re`模块支持正则表达式,可以用于搜索、匹配和替换文本中的模式。

```python

import re

# 示例:从一段文本中提取所有的电子邮件地址

text = "Please contact us at: support@example.com, sales@example.org"

pattern = r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b'

emails = re.findall(pattern, text)

print(emails) # 输出提取到的电子邮件地址列表

```

### 4.2.2 高级函数进行数据映射和转换

Python中的高阶函数如`map`和`reduce`提供了强大的数据处理能力。这些函数可以与自定义的lambda函数结合使用,实现复杂的映射和转换逻辑。

```python

# 示例:将数据框中的字符串转换为小写

df = pd.DataFrame(['Python', 'Java', 'C++', 'JavaScript'])

df['language'] = df[0].apply(lambda x: x.lower())

print(df)

```

### 4.2.3 脚本自动化任务调度

Python脚本的自动化不仅限于数据处理本身,它还能够集成任务调度工具,例如`schedule`库,来实现定时任务。

```python

import schedule

import time

def job():

print("Running data preprocessing script...")

# 定义定时任务,每天的9点执行job函数

schedule.every().day.at("09:00").do(job)

while True:

schedule.run_pending()

time.sleep(1)

```

## 4.3 脚本优化与性能评估

### 4.3.1 脚本代码优化策略

在执行大规模数据处理任务时,脚本的性能至关重要。优化可以从多个层面展开,包括代码级别的优化、算法选择的优化以及硬件资源的优化。

```python

# 代码级别优化:使用列表推导式替代循环

# 不优化:

result = []

for item in range(10000):

result.append(item ** 2)

# 优化后:

result = [item ** 2 for item in range(10000)]

```

### 4.3.2 性能评估方法与工具

性能评估通常需要借助于工具和指标。例如,可以使用`timeit`模块来测量代码执行时间,使用`memory_profiler`来监控内存使用情况。

```python

import timeit

# 测试列表推导式和循环的性能差异

time_loop = timeit.timeit('result = []\nfor item in range(10000):\n result.append(item ** 2)', number=10)

time_comprehension = timeit.timeit('result = [item ** 2 for item in range(10000)]', number=10)

print(f"Loop time: {time_loop}")

print(f"Comprehension time: {time_comprehension}")

```

通过性能评估,我们可以识别出代码中的瓶颈,并针对性地进行优化,从而提高数据处理脚本的整体效率。

# 5. ```

# 第五章:哨兵一号数据预处理案例实践

## 5.1 实际案例研究

### 5.1.1 案例背景介绍

哨兵一号是欧洲空间局(ESA)发射的一系列地球观测卫星,旨在提供全球范围内的连续监测。这些卫星产生的数据对于自然灾害管理、气候变化研究等具有极其重要的价值。在本案例中,我们关注的是如何对哨兵一号的影像数据进行预处理,以便于后续分析。

### 5.1.2 需求分析与预处理策略

对哨兵一号数据进行预处理的需求主要集中在两个方面:提高数据质量以及使其适用于机器学习模型。数据质量问题包括有云层遮挡、地表覆盖度不足、影像分辨率不一致等。预处理策略将包括云层和噪声的移除、数据裁剪和格式转换等步骤。

## 5.2 编写高级脚本执行预处理

### 5.2.1 脚本编写过程

在编写Python脚本的过程中,我们使用了GDAL库进行影像数据的读写,同时应用了Scikit-image库进行图像处理。以下是脚本的一个简化示例,用于移除影像中的云层。

```python

import gdal

from skimage import filters, morphology

def remove_clouds(input_image, output_image):

# 读取影像数据

dataset = gdal.Open(input_image)

band = dataset.GetRasterBand(1)

cloud_mask = filters.threshold_otsu(band.ReadAsArray())

# 使用阈值化来创建云层的掩膜

cloud_map = band.ReadAsArray() < cloud_mask

# 使用形态学操作清理掩膜中的小噪声

cleaned_clouds = morphology.remove_small_objects(cloud_map, min_size=1000)

# 使用掩膜移除云层

clean_data = band.ReadAsArray()

clean_data[cleaned_clouds] = 0

# 保存预处理后的影像

driver = gdal.GetDriverByName('GTiff')

out_dataset = driver.Create(output_image, band.XSize, band.YSize, 1, gdal.GDT_Float32)

out_band = out_dataset.GetRasterBand(1)

out_band.WriteArray(clean_data)

out_band.FlushCache()

remove_clouds('input.tif', 'output.tif')

```

### 5.2.2 脚本执行与结果验证

执行脚本后,我们需要验证处理结果的有效性。这通常涉及到人工检查处理后的图像以确认云层和噪声已被适当移除,以及使用自动化方法评估影像质量。可以使用如下的Python代码片段进行自动检查:

```python

def validate_processing(image_path):

dataset = gdal.Open(image_path)

band = dataset.GetRasterBand(1)

clean_data = band.ReadAsArray()

# 确认云层已被清除

cloud_map = clean_data < filters.threshold_otsu(clean_data)

assert not cloud_map.any(), "Remaining cloud cover detected."

print("Validation successful, no cloud cover found.")

validate_processing('output.tif')

```

## 5.3 结果分析与业务应用

### 5.3.1 预处理结果分析

预处理的影像数据在视觉上显示出更清晰的地表特征,云层和噪声已被有效移除。这些改进对于后续的分析工作,例如植被覆盖度计算、土地利用分类等,将提供更可靠的数据基础。

### 5.3.2 数据预处理在业务中的应用

通过预处理,哨兵一号的数据可以被用于实时的灾害监测系统中,对于洪水、火灾等灾害的快速响应至关重要。这些数据还可以用于长期的环境监测项目,从而为政策制定提供科学依据。

### 5.3.3 持续改进与优化建议

尽管预处理流程已取得一定的成效,但仍需定期回顾和评估,考虑包括算法定位、计算资源分配和执行时间等因素。此外,随着计算机视觉和机器学习技术的发展,可以探索应用深度学习模型来进一步优化数据预处理流程,提供更智能、更高效的处理能力。

```

0

0