哨兵一号数据预处理进阶指南:全面理解数据转换、映射及错误处理

发布时间: 2024-12-23 17:59:45 阅读量: 5 订阅数: 5

# 摘要

本文旨在全面探讨数据预处理过程中的关键步骤,强调其在数据分析和科学中的重要性。首先,文章介绍了数据转换的理论基础和实践技巧,包括数据类型转换原则、标准化/归一化方法以及使用Python和Pandas库的高级转换技术。接着,文章深入探讨数据映射的策略和应用,涵盖映射的作用、类型和数据一致性,以及不同技术平台下映射的实现和常见错误处理。最后,文章通过零售和社交媒体数据预处理的实际案例,综合运用转换、映射和错误处理的最佳实践,提出了一套完整的数据预处理流程。

# 关键字

数据预处理;数据转换;数据映射;错误处理;Python;Pandas

参考资源链接:[哨兵一号数据预处理操作指南:从校准到辐射校正](https://wenku.csdn.net/doc/6412b4b6be7fbd1778d408dc?spm=1055.2635.3001.10343)

# 1. 数据预处理概述与重要性

数据预处理是数据分析和数据科学项目中的第一步,但也是最重要的步骤之一。它涉及对原始数据进行清洗、整合和转换,以使得数据适合进一步分析。数据预处理的重要性在于,原始数据往往包含噪声、缺失值、异常值等问题,这些问题会直接影响到后续分析的准确性和可靠性。

在本章中,我们将深入了解数据预处理的概念及其在整个数据分析流程中的关键角色。通过对数据预处理重要性的讨论,我们将揭示为何这项工作在数据驱动决策中至关重要。这为随后章节中将要讨论的数据转换和数据映射等主题奠定了基础。

为了更好地掌握数据预处理的重要性,我们还将通过案例和实例来展示未经处理的数据和经过精心预处理的数据之间的差异。这将帮助读者理解,在数据科学的世界里,数据预处理是一项不可忽视的工作。

```plaintext

[数据预处理的步骤]

1. 数据收集

2. 数据清洗

3. 数据转换

4. 数据规约

5. 数据离散化

```

数据预处理包括上述基本步骤,通过这些步骤,我们可以将原始数据转换成高质量、可分析的数据集。高质量的数据预处理是确保最终分析结果有效性和精确性的基石。

# 2. 数据转换的理论与实践

## 2.1 数据转换的理论基础

### 2.1.1 数据类型及其转换原则

在数据科学的处理过程中,数据类型是基本的构建块,它们为数据提供了结构。理解不同的数据类型以及它们之间的转换原则是进行数据转换不可或缺的一部分。数据类型可以分为两大类:原始数据类型和复杂数据类型。

原始数据类型通常包括数值、字符串、布尔和日期时间类型。这些类型的数据通常具有明确的表示方式,并在不同的编程语言中以类似的形式存在。例如,整数和浮点数用于表示数值,字符序列用于表示字符串,逻辑值真或假用于布尔类型,而特定格式的字符串用于表示日期和时间。

复杂数据类型包括数组、对象、集合、映射等,它们可以包含多个数据元素或以结构化的方式存储数据。在进行数据转换时,需要理解数据类型的层级关系和相互转换的原则。

数据类型转换通常遵循以下原则:

- **准确性**:在转换过程中,确保数据的原始含义不丢失或不被误解。

- **最小损失**:在转换为较低精度的数据类型时,尽可能保留数据的细节和准确性。

- **一致性**:确保转换后的数据类型与其他数据类型的表示方式保持一致,以便于处理和分析。

- **可逆性**:在可能的情况下,支持数据类型的可逆转换,使数据能够还原为原始形式。

## 2.1.2 标准化和归一化转换方法

为了确保数据在不同系统和平台间的一致性和兼容性,数据标准化和归一化转换方法被广泛采用。这两种技术分别解决了数据范围和数据分布的问题。

标准化是将数据调整为具有均值为0和标准差为1的分布。这一过程消除了不同变量之间因单位或尺度不同所导致的影响。标准化处理经常应用于机器学习算法中,因为它有助于提升算法的收敛速度并防止梯度消失问题。

标准化的公式如下:

```python

X_standardized = (X - X_mean) / X_std

```

其中,`X` 是原始数据集,`X_mean` 是数据的均值,`X_std` 是数据的标准差。

归一化则是将数据缩放到一个特定的范围,通常是0到1之间。这种转换对于那些在算法性能上依赖于输入数据范围的算法特别重要。归一化的公式如下:

```python

X_normalized = (X - X_min) / (X_max - X_min)

```

在实际应用中,选择标准化还是归一化取决于数据的性质和所采用的模型。

## 2.2 数据转换的工具和技巧

### 2.2.1 使用Python进行数据类型转换

Python是数据转换领域的强大工具之一,因为它具有丰富的内置函数和库。Python的数据类型转换通常是通过内置函数`int()`, `float()`, `str()`等来完成的,它们可以显式地将变量从一种类型转换为另一种类型。

例如,下面的代码演示了如何将浮点数转换为整数:

```python

float_number = 3.14159

int_number = int(float_number) # 结果为 3

```

Python还提供了更复杂的转换方法,如将字符串转换成日期类型,或者在对象之间进行转换。

### 2.2.2 利用Pandas库进行高级数据转换

Pandas库提供了一组强大的数据处理功能,特别是在数据框(DataFrame)对象上的转换操作。Pandas中的`astype()`函数允许用户将列转换为不同的数据类型,如将字符串转换为日期时间格式,或者将数值转换为布尔类型。

例如,下面的代码演示了如何使用Pandas将字符串列转换为日期时间列:

```python

import pandas as pd

# 创建一个包含日期字符串的DataFrame

df = pd.DataFrame({'date_str': ['2023-01-01', '2023-01-02']})

# 将字符串列转换为日期时间格式

df['date'] = pd.to_datetime(df['date_str'])

```

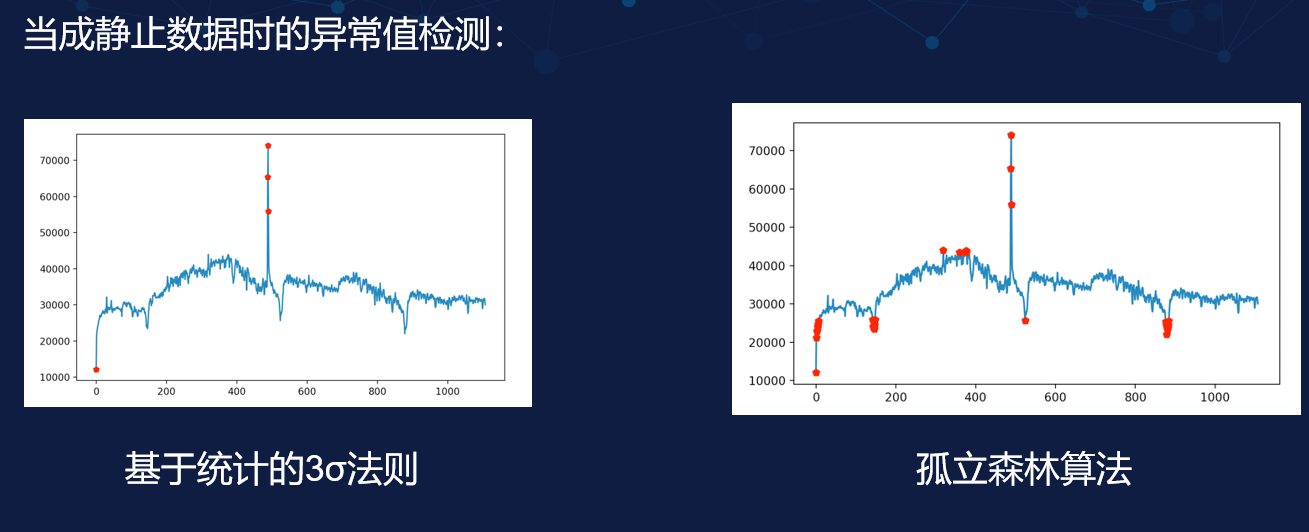

### 2.2.3 处理缺失值和异常值

在数据转换过程中,处理缺失值和异常值是不可或缺的一步。缺失值可能是由于数据收集过程中的错误、不完整或数据损坏导致的。异常值则可能是由于数据录入错误或真正的业务异常情况所导致的。

Pandas库提供了处理这些问题的多种方法。例如,可以使用`dropna()`删除包含缺失值的行,或者使用`fillna()`填充缺失值。处理异常值时,可以使用Z-score方法或者基于IQR(四分位距)的方法来识别和处理。

```python

# 删除含有缺失值的行

df_cleaned = df.dropna()

# 用均值填充缺失值

df_filled = df.fillna(df.mean())

```

## 2.3 数据转换的案例分析

### 2.3.1 金融数据转换应用实例

在金融领域,数据转换用于增强数据的可用性和准确性。例如,在信用评分模型中,需要将多种格式和尺度的客户数据转换为统一的格式以供分析。

假设我们有一组关于贷款申请的数据集,其中包含申请人的收入和债务信息。这些数据可能来自不同的银行和金融机构,并且使用不同的单位表示。首先,我们需要将所有数据标准化到相同的尺度,如千美元,然后进行标准化处理,以便可以公平比较。

```python

import numpy as np

# 假设dataframe df包含不同银行的贷款申请数据

# 列 'Income' 和 'Debt' 分别表示收入和债务的原始值

# 将 'Income' 和 'Debt' 标准化到统一的尺度

df['Income'] = df['Income'] / 1000 # 将收入转换为千美元

df['Debt'] = df['Debt'] / 1000

# 进行标准化处理

df['Income标准化'] = (df['Income'] - df['Income'].mean()) / df['Income'].std()

df['Debt标准化'] = (df['Debt'] - df['Debt'].mean()) / df['Debt'].std()

```

### 2.3.2 生物信息学数据转换案例

生物信息学数据通常包括基因表达量、蛋白质相互作用等复杂的生物标记物。这些数据具有高度的维度和复杂性,因此,在分析前需要进行适当的数据转换。

一个常见的生物信息学数据转换案例是基因表达矩阵的标准化。基因表达矩阵的每一行代表一个基因,每一列代表一个样本。基因表达值通常具有较大的动态范围,并且在不同的实验和样本之间可能有显著差异。因此,在比较基因表达模式或进行后续分析之前,需要将表达值归一化到统一的尺度。

```python

# 假设dataframe gene_expression_df包含基因表达数据

# 'Sample1', 'Sample2', ..., 'SampleN' 是样本列

# 计算每个样本的z-score进行标准化

for sample in gene_expression_df.c

```

0

0