快速精通哨兵一号数据Snap预处理:一步到位的数据清洗与标准化入门指南

发布时间: 2024-12-23 17:32:35 阅读量: 137 订阅数: 40

# 摘要

本文详细探讨了哨兵一号数据Snap在数据预处理的理论基础、清洗实践、标准化流程及其应用案例分析。首先概述了数据Snap的概况,并强调了数据预处理在提高数据质量中的关键作用。接着,文章深入分析了数据清洗和数据标准化的常用技术与方法论,以及不同工具和平台的选择和应用实例。本文还通过具体案例,展示了在实际应用中如何进行数据缺失值、异常值处理和一致性校验,以及标准化技术和数据类型转换的具体步骤。最后,评估了预处理的效果,并提出了优化建议,旨在为数据科学家提供一套完整的数据预处理指南,提高数据分析的准确性和可靠性。

# 关键字

数据预处理;数据清洗;数据标准化;异常值检测;数据一致性;案例分析

参考资源链接:[哨兵一号数据预处理操作指南:从校准到辐射校正](https://wenku.csdn.net/doc/6412b4b6be7fbd1778d408dc?spm=1055.2635.3001.10343)

# 1. 哨兵一号数据Snap概述

随着技术的发展,"哨兵一号"这样的先进数据监控系统已经成为现代企业不可或缺的一部分。在数据管理与分析的过程中,哨兵一号数据Snap作为一种关键资源,扮演着至关重要的角色。它能够实时捕获和处理海量数据,确保企业在动态多变的市场中保持竞争力。

哨兵一号数据Snap不仅仅是原始数据的简单集合,它是在收集、存储和分析等多个环节进行优化后的数据产品。这种数据通常经过预处理、清洗、标准化等步骤,以确保其质量符合分析和决策需求。本章我们将从数据Snap的基本概念开始,概览其在数据分析和商业智能中的应用。

## 数据预处理的重要性

在深入探讨哨兵一号数据Snap之前,我们需要先了解数据预处理的重要性。数据预处理包括数据清洗、数据转换、数据规约等一系列步骤,目的是为了改善数据质量、提升数据的可用性,为后续的数据分析工作打下坚实的基础。

### 数据质量对分析的影响

数据质量差会直接影响分析结果的准确性和可靠性。例如,数据中的错误、不一致性和缺失值等问题,都可能导致分析结果出现偏差,进而影响决策。因此,对数据进行高质量的预处理是确保分析有效的前提。

### 数据预处理的目标与步骤

数据预处理的目标是将原始数据转化为适合进行分析的高质量数据集。这通常涉及以下步骤:数据清洗、数据集成、数据转换和数据规约。每个步骤都旨在解决数据中的具体问题,以提升数据整体的质量。

本章为哨兵一号数据Snap的探索提供了一个良好的起点,为后续章节的深入讨论奠定了基础。接下来的章节将详细介绍数据预处理的理论基础以及实践操作,帮助读者全面掌握数据Snap的管理和优化技巧。

# 2. 数据预处理的理论基础

### 2.1 数据预处理的重要性

#### 2.1.1 数据质量对分析的影响

数据预处理是确保数据质量的关键环节,它直接影响到数据分析的准确性和后续模型的有效性。数据质量不佳可能会导致分析结果出现偏差,比如在机器学习模型训练中,如果使用了含有噪声、不一致或不完整数据,模型的泛化能力可能会大打折扣,导致预测结果的不可靠性。数据质量差也会影响数据挖掘的效率,数据预处理需要花费更多的时间和资源来清洗和整合数据,从而延长了整个分析流程的周期。因此,良好的数据预处理工作是数据分析和建模成功的基础。

#### 2.1.2 数据预处理的目标与步骤

数据预处理的目标通常包括提高数据质量,减少噪声和重复,以及提高数据的可解释性。为了实现这些目标,数据预处理一般分为以下步骤:

- 数据清洗:识别并处理数据集中的错误和不一致性。

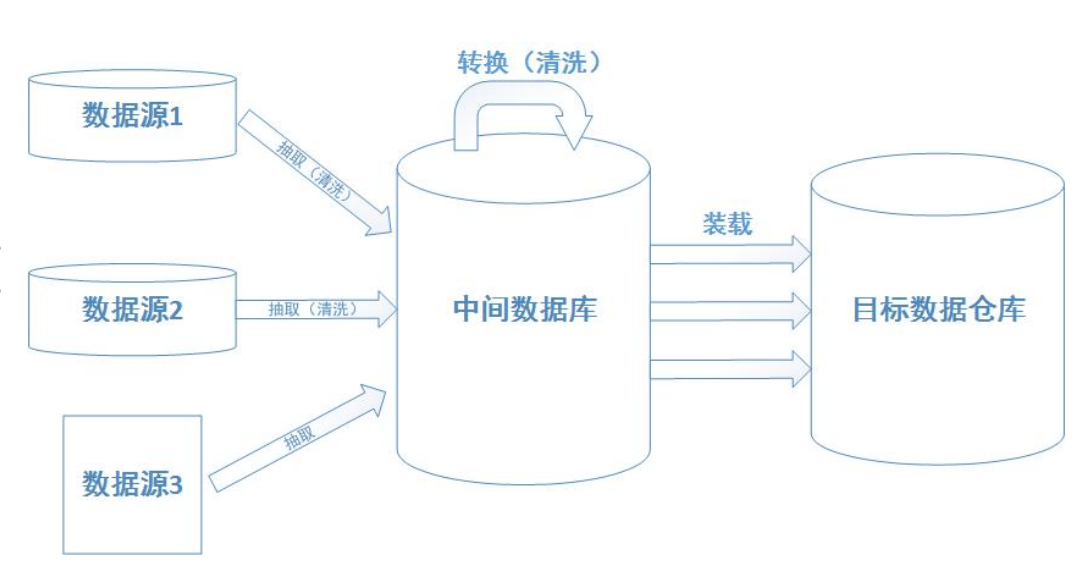

- 数据集成:将来自多个源的数据合并到一起。

- 数据转换:数据规范化、归一化或缩放以满足分析工具的需求。

- 数据缩减:减少数据集的大小,但保留重要的信息。

- 数据离散化:连续数据转换为有意义的区间或类别。

### 2.2 常见的数据预处理技术

#### 2.2.1 数据清洗的方法论

数据清洗是预处理的首要步骤,目标是识别和处理数据集中的错误、缺失值和不一致性。常见的数据清洗方法包括:

- 使用统计分析来识别异常值,例如通过计算均值和标准差来识别离群点。

- 用特定规则填充缺失值,例如使用均值、中位数或众数。

- 采用数据挖掘算法检测异常值,例如基于聚类的异常检测。

- 利用字符串处理和正则表达式清洗文本数据。

- 应用数据质量工具进行数据一致性检查。

#### 2.2.2 数据标准化的策略与算法

数据标准化是将数据缩放到特定范围的过程,常见的标准化方法有:

- Z-score 标准化:通过减去均值并除以标准差将数据标准化到一个标准正态分布,适用于正态分布数据。

- 最小-最大标准化:将数据按比例缩放到特定范围,通常是[0,1]或[-1,1]。适用于最小值和最大值已知的情况。

- 小数定标:将数据乘以10的幂次方以移除小数部分。

### 2.3 数据预处理的工具和平台

#### 2.3.1 选择合适的数据预处理工具

选择合适的数据预处理工具对于提高工作效率至关重要。好的工具应具有以下特点:

- 易于使用,提供直观的用户界面。

- 支持多种数据源和数据格式。

- 集成数据清洗、转换、集成等多种功能。

- 提供脚本支持,方便自动处理。

- 可扩展性,易于集成第三方数据处理工具。

当前市场上的数据预处理工具多种多样,如Python的Pandas库、R语言、KNIME和Apache Spark等。

#### 2.3.2 数据预处理平台的应用实例

数据预处理平台的应用实例可以参考开源社区提供的解决方案。这里我们以Pandas库为例,其在Python环境下广泛应用于数据清洗和处理。以下是使用Pandas进行数据清洗的一个简单实例:

```python

import pandas as pd

# 加载数据集

df = pd.read_csv('dataset.csv')

# 识别缺失值

missing_values = df.isnull().sum()

# 填充缺失值

df.fillna(df.mean(), inplace=True)

# 数据清洗:移除重复项

df.drop_duplicates(inplace=True)

# 数据标准化:Z-score标准化方法

df = (df - df.mean()) / df.std()

# 数据类型转换:将字符串转换为日期类型

df['date_column'] = pd.to_datetime(df['date_column'], errors='coerce')

```

在应用实例中,我们通过上述代码实现了基本的数据清洗和标准化流程。每一步的操作逻辑都很清晰,且Pandas库提供了强大的功能来支持数据预处理的各个环节。

# 3. 哨兵一号数据Snap清洗实践

## 3.1 数据缺失值处理

### 3.1.1 缺失值的识别与分析

数据在收集过程中可能会因为多种原因导致部分数据项丢失,这被称为数据缺失。缺失值的存在可能会对数据分析和挖掘的结果产生影响,因此,在数据预处理阶段,识别和分析缺失值是至关重要的一步。

要识别缺失值,首先需要借助于数据处理工具,比如Python的Pandas库,可以快速得到数据集中的缺失值统计信息。使用Pandas的`isnull()`函数可以检测出数据集中的所有缺失值,并通过`sum()`函数统计每一列的缺失值数量。如果缺失值的数量较多,可能需要结合数据的具体应用场景,采取不同的缺失值处理策略。

### 3.1.2 缺失值的填充技术

处理缺失值通常有多种方法,包括删除缺失值所在的行或列、填充缺失值等。在填充缺失值时,常用的策略包括使用均值、中位数、众数或者基于模型的预测值。

例如,使用均值填充缺失值时,可以采用如下代码:

```python

import pandas as pd

# 假设df是已经加载的包含缺失值的数据框(DataFrame)

df.fillna(df.mean(), inplace=True) # 使用均值填充

```

在选择填充技术时,需要注意数据的分布和业务逻辑。例如,对于时间序列数据,可能需要使用基于时间的插值方法,如线性插值。而对于分类数据,众数可能是更好的选择。

## 3.2 数据异常值处理

### 3.2.1 异常值检测的方法

异常值指的是那些与其他数据显著不同的观测值,它们可能是由于测量误差或其他原因导致。异常值检测对于数据清洗非常重要,因为它能够帮助识别和处理潜在的噪声,从而提高数据质量。

异常值检测的方法有很多,包括基于统计的方法(如标准差、四分位距IQR)、基于密度的方法(如局部异常因子LOF)、以及基于聚类的方法等。下面介绍如何使用标准差方法来检测异常值:

```python

import numpy as np

# 计算数据列的均值和标准差

mean = df['data_column'].mean()

std = df['data_column'].std()

# 标准差方法检测异常值

outliers = df[np.abs(df['data_column'] - mean) > (2 * std)]

```

### 3.2.2 异常值的处理策略

一旦检测出异常值,就需要根据数据的特性和业务需求来决定如何处理这些值。常见的处理方法包括删除异常值、使用中位数或均值替代、或者应用模型预测值进行替换。此外,还可以保留异常值,但需要在后续的数据分析中特别关注,因为它们可能是数据的“宝藏”,提供了有用的洞察。

## 3.3 数据一致性校验

### 3.3.1 数据一致性的定义与重要性

数据一致性是指数据在存储、处理和传递过程中保持一致性,不受污染、损坏或错误的影响。数据的一致性对于数据分析的结果准确性至关重要,尤其是当数据跨越多个系统和平台时。

### 3.3.2 实现数据一致性的方法

为了确保数据的一致性,可以采取多种方法。例如,可以通过数据比对技术来检查数据在不同时间点或不同系统中的差异。还可以实施数据校验规则,比如使用正则表达式来确保格式一致性,或者使用数据字典对数据项进行约束。

例如,使用Python进行数据格式校验的代码段如下:

```python

# 正则表达式校验电话号码格式是否一致

import re

# 假设df是已经加载的包含电话号码数据框

df['phone'] = df['phone'].apply(lambda x: re.sub(r'[^0-9x]+', '', x)) # 移除非数字字符

# 校验电话号码是否符合预期的固定位数格式

if (df['phone'].apply(lambda x: len(x)) == 10).all(): # 假设正确的电话号码长度应为10位

print("All phone numbers are consistent")

else:

print("Some phone numbers are inconsistent")

```

在数据一致性校验中,数据清洗和数据标准化通常是迭代进行的,这有助于确保数据质量逐步提高,为后续的数据分析和建模提供更为可靠的数据基础。

# 4. 哨兵一号数据Snap标准化流程

数据标准化是数据预处理的一个核心环节,目的是为了消除不同量纲之间的差异,减少变量间数值大小对分析结果的影响。数据标准化方法众多,本文将重点介绍两种常用的数据标准化技术:Z-score标准化方法和最小-最大标准化方法,并探讨数据类型转换和数据编码与分箱技术。

## 4.1 数据标准化技术

### 4.1.1 Z-score标准化方法

Z-score标准化,也称作标准分数(Standard Score),它衡量的是数据点距离其均值的标准化距离,其公式如下:

\[ z = \frac{(x - \mu)}{\sigma} \]

其中,\( x \)是原始数据点,\( \mu \)是数据集的均值,\( \sigma \)是数据集的标准差。

这种方法对于异常值较为敏感,因为异常值会影响均值和标准差的计算。下面展示一个简单的Python代码实现Z-score标准化:

```python

import numpy as np

# 假设data是需要标准化的一维数组数据

data = np.array([10, 20, 30, 40, 50])

mu = np.mean(data)

sigma = np.std(data)

# Z-score标准化

z_scores = (data - mu) / sigma

print(z_scores)

```

### 4.1.2 最小-最大标准化方法

最小-最大标准化是将数据按比例缩放,使之落入一个特定的范围,通常是0到1之间。公式如下:

\[ x_{\text{norm}} = \frac{(x - x_{\text{min}})}{(x_{\text{max}} - x_{\text{min}})} \]

其中,\( x_{\text{norm}} \)是标准化后的数据,\( x \)是原始数据点,\( x_{\text{min}} \)和\( x_{\text{max}} \)分别是数据集的最小值和最大值。

这种方法不会改变数据的分布,适用于数据量较小且没有离群值的情况。下面的Python代码展示了如何实现最小-最大标准化:

```python

# 最小-最大标准化

min_max_scaler = preprocessing.MinMaxScaler()

data_norm = min_max_scaler.fit_transform(data.reshape(-1, 1))

data_norm = np.ndarray.flatten(data_norm)

print(data_norm)

```

## 4.2 数据类型转换

### 4.2.1 离散数据与连续数据的转换

在数据预处理中,离散数据与连续数据的转换是一个常见的任务。通常,我们将离散数据转换为连续数据,以便使用一些连续数据的算法。

例如,我们可以使用标签编码(Label Encoding)将类别特征转换为连续整数,或者使用独热编码(One-Hot Encoding)将类别特征转换为多维向量。

### 4.2.2 文本数据的数值化处理

文本数据的数值化是将非数值型的文本转换为数值型数据的过程。常见的方法包括词袋模型(Bag of Words)、TF-IDF等。文本数据转换为数值型数据后,便于使用机器学习算法进行处理。

## 4.3 数据编码与分箱

### 4.3.1 标签编码与独热编码的应用

标签编码和独热编码是处理分类数据的两种常用编码方式。标签编码是将类别变量转换为整数编码,适用于二分类和多分类问题。独热编码是将每个类别特征转换为二进制(0或1),用于处理多分类问题。

### 4.3.2 分箱技术在数据标准化中的运用

分箱(Binning)是一种数据预处理技术,它将连续特征的值分到一定数量的“箱子”或区间中。这样可以减少数据的噪声和离群值的影响。分箱在决策树等模型中非常有用,同时也为特征工程提供了更多可能性。

通过本章的介绍,我们学习了数据标准化的不同技术及其应用,掌握了数据类型转换以及编码分箱方法。在接下来的章节中,我们将运用这些理论知识,通过实际案例来展示数据预处理在哨兵一号数据Snap中的应用。

# 5. 哨兵一号数据Snap预处理案例分析

## 5.1 实际数据集的选择与准备

在进行数据预处理之前,我们必须精心选择合适的数据集,并对其进行全面的准备。这包括理解数据集的来源、特点以及对数据集进行初步的探索性分析。

### 5.1.1 数据集的来源与特点

在我们的案例中,哨兵一号数据Snap来自于一个综合性的遥感平台。该平台每天都会收集全球范围内的卫星图像,并通过一系列的处理得到地表覆盖、环境变化等多维数据。因此,该数据集具有以下特点:

- **时间序列数据**:随着时间变化,数据具有很强的时序特性。

- **多维数据**:包含波段信息、地表反射率、温度等多个维度。

- **数据量大**:每次收集可能覆盖几千平方公里,数据量级达到TB级别。

### 5.1.2 数据集预处理前的探索性分析

在预处理之前,需要对数据集进行探索性分析,理解数据的基本分布和可能存在的问题。常用的方法包括:

- **数据概览**:查看数据的维度大小、数据类型、缺失值情况。

- **统计分析**:计算数据的基本统计量(如均值、标准差、分位数等)。

- **可视化**:绘制直方图、箱线图等,直观展示数据分布情况。

代码示例:

```python

import pandas as pd

# 读取数据集

data = pd.read_csv('sentinel_data.csv')

# 数据概览

print(data.head())

print(data.describe())

# 绘制直方图查看数据分布

import matplotlib.pyplot as plt

data.hist(bins=50, figsize=(20, 15))

plt.show()

```

在上述代码块中,我们使用`pandas`库对数据集进行初步查看,并使用`matplotlib`库绘制直方图,可视化数据的分布情况。

## 5.2 数据预处理步骤的详细执行

数据预处理包括数据清洗、数据标准化等多个步骤,每个步骤都对数据质量有着重大影响。

### 5.2.1 数据清洗的具体操作

数据清洗的主要目的是处理数据中的缺失值、异常值以及不一致性等问题。

- **缺失值处理**:可以采用删除、填充或插值等方法。对于时间序列数据,可以使用前后值填充或者线性插值。

- **异常值处理**:采用统计检测方法,如箱线图方法,然后使用删除、替换或者变换等技术。

代码示例:

```python

# 缺失值处理 - 使用均值填充

data.fillna(data.mean(), inplace=True)

# 异常值检测与处理 - 使用箱线图方法

Q1 = data.quantile(0.25)

Q3 = data.quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 处理异常值

data = data[(data < upper_bound) & (data > lower_bound)]

```

### 5.2.2 数据标准化的实施

数据标准化是为了消除不同量纲的影响,使得数据在统一的尺度下进行比较和分析。

- **Z-score标准化**:根据均值和标准差对数据进行标准化处理。

- **最小-最大标准化**:将数据缩放到0和1之间。

代码示例:

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# Z-score标准化

scaler_z = StandardScaler()

data_z = scaler_z.fit_transform(data)

# 最小-最大标准化

scaler_m = MinMaxScaler()

data_m = scaler_m.fit_transform(data)

```

在这段代码中,我们使用了`sklearn`中的`StandardScaler`和`MinMaxScaler`分别实现了Z-score标准化和最小-最大标准化。

## 5.3 预处理效果的评估与优化

在实施预处理步骤后,评估预处理的效果并进行必要的优化是非常重要的一步。

### 5.3.1 预处理效果的评价指标

对于数据预处理效果的评价,通常可以使用以下几个指标:

- **数据完整性**:确保预处理后数据没有丢失。

- **数据一致性**:保证数据在预处理过程中没有产生矛盾。

- **标准化效果**:观察数据是否均匀分布或是否符合预期的范围。

### 5.3.2 预处理流程的优化建议

对于预处理流程的优化,我们可以从以下几个方面考虑:

- **参数调整**:针对不同的数据集调整预处理参数。

- **自动化流程**:开发自动化脚本以减少重复性操作和人为错误。

- **反馈循环**:在后续的分析中不断收集反馈,根据反馈调整预处理策略。

在整个数据预处理过程中,不断迭代和优化是提升数据质量的关键。通过持续的评估和调整,我们可以确保数据预处理的质量,为后续的数据分析和模型训练打下坚实的基础。

0

0