【代理与会话】:网络爬虫必备——Requests库代理使用详解

发布时间: 2024-12-07 14:59:40 阅读量: 17 订阅数: 18

Python3网络爬虫中的requests高级用法详解

# 1. 网络爬虫与代理的基本概念

## 网络爬虫的定义及其重要性

网络爬虫(Web Crawler),又称为网络蜘蛛(Web Spider)或网络机器人(Web Robot),是一种自动提取网页内容的程序。它通过访问互联网上的网站,解析网页数据,并按特定的算法进行遍历,从而获取大量信息。网络爬虫在搜索引擎索引、数据采集、市场分析等多个领域扮演着至关重要的角色。

## 代理的作用与应用场景

代理服务器(Proxy Server)在计算机网络中充当客户端和互联网之间的中间人角色,为网络请求提供转发服务。使用代理可以隐藏真实IP地址,保护用户隐私,突破IP限制等。在爬虫技术中,代理的应用非常广泛,它可以提升爬虫的匿名性,帮助绕过反爬机制,实现对目标网站的大规模数据抓取。

## 网络爬虫与代理技术的结合

将网络爬虫与代理技术相结合,可以让爬虫在执行任务时更具有灵活性和隐蔽性。通过合理的代理策略和配置,爬虫可以在不同的IP地址下访问同一网站,模拟正常的用户行为,从而降低被封禁的风险,保证数据采集的连续性和稳定性。这对于开发高效的网络爬虫程序来说,是不可或缺的技术组合。

接下来的文章将继续深入探讨如何利用Python编程语言中的Requests库进行网络爬虫的开发,并详细讨论如何合理运用代理和会话管理来优化爬虫程序,以及在实际案例中应用这些技术的具体实践。

# 2. Requests库的安装与基础使用

在这一章节中,我们将深入了解Python中广泛使用的Requests库,它作为一个HTTP库,能够让开发者以简单的方式实现HTTP请求。我们会探讨库的安装、配置和基础使用技巧,同时了解如何进行异常处理来增强爬虫程序的鲁棒性。

## 2.1 Requests库的安装与配置

### 2.1.1 安装Requests库

Requests库不是Python的标准库,因此需要单独安装。我们可以使用pip包管理工具轻松安装它。请按照以下步骤进行:

```bash

pip install requests

```

在安装过程中,如果遇到权限问题,可以使用`sudo`命令(适用于Linux和MacOS用户)或在命令前加上`python -m`(适用于Windows用户):

```bash

python -m pip install requests

```

安装完成后,我们可以通过Python解释器检查是否安装成功:

```python

import requests

print(requests.__version__)

```

如果上述命令没有引发错误,并且打印出了版本号,那么表示安装成功。

### 2.1.2 Requests库的基本配置

安装完Requests库后,接下来需要对其进行一些基本配置,以便在项目中使用。在进行网络请求前,根据不同的需求,我们可能需要配置超时时间、代理、会话等。

配置超时时间示例:

```python

import requests

# 设置连接和读取的超时时间为10秒

timeout = 10

response = requests.get('http://example.com', timeout=timeout)

```

配置代理示例:

```python

import requests

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'http://10.10.1.10:1080',

}

response = requests.get('http://example.com', proxies=proxies)

```

## 2.2 Requests库的请求方法

### 2.2.1 GET请求

GET请求是最简单的HTTP请求方法,通常用于请求数据。使用Requests库发送GET请求非常直接:

```python

import requests

# 发送GET请求

response = requests.get('http://example.com')

# 打印响应的内容

print(response.text)

```

### 2.2.2 POST请求

POST请求常用于提交数据。以下是如何使用Requests库发送POST请求的示例:

```python

import requests

# 发送POST请求

response = requests.post('http://example.com/post', data={'key': 'value'})

# 获取响应内容

content = response.content

```

在发送POST请求时,通常需要在`data`参数中提供一个字典(或其他可迭代对象),这样服务器才能理解你想要提交的数据。

### 2.2.3 其他请求方法

除了GET和POST之外,Requests库还支持PUT、DELETE、HEAD、OPTIONS等HTTP方法。使用这些方法的代码模式与GET和POST类似。

```python

# PUT请求示例

requests.put('http://example.com/put', data={'key': 'value'})

# DELETE请求示例

requests.delete('http://example.com/delete')

```

## 2.3 网络爬虫中的异常处理

### 2.3.1 异常的类型与处理

在网络爬虫程序中,网络请求可能会因为各种原因失败,比如连接超时、连接错误、服务端错误等。Requests库会抛出不同类型的异常来应对这些情况,我们可以根据异常类型来进行特定的处理。

一个常见的异常处理代码结构如下:

```python

import requests

try:

response = requests.get('http://example.com')

response.raise_for_status() # 检查请求是否成功

# 请求成功后的处理逻辑

print(response.text)

except requests.exceptions.HTTPError as errh:

print("Http Error:", errh)

except requests.exceptions.ConnectionError as errc:

print("Error Connecting:", errc)

except requests.exceptions.Timeout as errt:

print("Timeout Error:", errt)

except requests.exceptions.RequestException as err:

print("OOps: Something Else", err)

```

### 2.3.2 自定义异常处理策略

除了使用Requests库提供的异常处理之外,我们还可以定义自己的异常处理策略。例如,当请求出现429 Too Many Requests错误时,我们可以选择短暂等待然后重试。

```python

import requests

from time import sleep

def request_with_retry(url, max_retries=3):

retries = 0

while retries <= max_retries:

try:

response = requests.get(url)

response.raise_for_status()

return response

except requests.exceptions.HTTPError as e:

if response.status_code == 429 and retries < max_retries:

sleep_time = 2 ** retries # 指数退避策略

print(f"Rate limit exceeded. Retrying in {sleep_time} seconds...")

sleep(sleep_time)

retries += 1

else:

raise

except Exception as e:

raise

# 使用自定义请求函数

response = request_with_retry('http://example.com')

```

通过使用`request_with_retry`函数,我们可以控制在特定情况下是否要重试,以及重试的次数和等待时间。这种方式可以根据实际需要进行定制。

在这一章节,我们介绍了Requests库的基础知识和使用技巧。学习如何安装库、配置请求、处理常见HTTP请求方法,以及如何处理可能遇到的异常。这些基本技能为构建更复杂的网络爬虫奠定了基础。接下来的章节中,我们将深入了解代理的使用和异常处理技巧,以及如何通过Session维持会话状态,进一步提升爬虫程序的效率和稳定性。

# 3. 代理的理论基础与实践应用

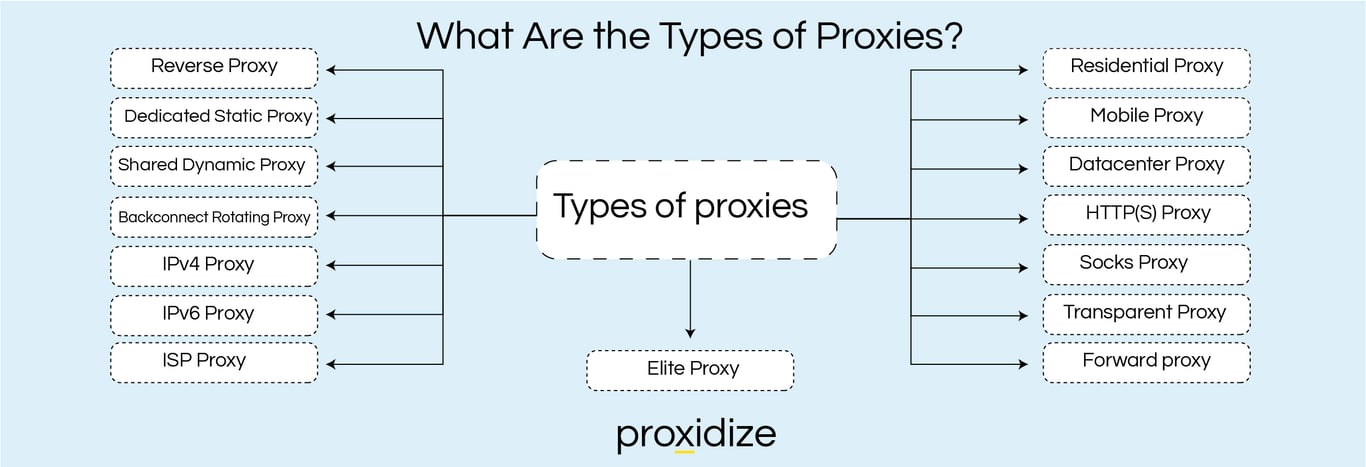

## 3.1 代理的分类与工作原理

### 3.1.1 透明代理、匿名代理和高匿名代理

代理服务器是一种特殊的网络服务,它允许一个客户端通过这个服务与另一个网络服务进行非直接的连接。根据代理服务器的不同,代理可以分为透明代理、匿名代理和高匿名代理。

透明代理会向Web服务器透露其代理行为,客户端的真实IP地址也会被传输。这使得Web服务器知道用户正在通过代理进行访问,因此透明代理在隐私保护方面几乎没什么作用。

匿名代理则会向Web服务器隐藏客户端的真实IP地址,

0

0