激活函数参数化探讨:可学习激活函数的优劣分析

发布时间: 2024-11-25 17:43:38 阅读量: 5 订阅数: 10

# 1. 可学习激活函数的基本概念

激活函数是神经网络中决定网络性能的关键组成部分。它不仅为网络引入非线性特性,而且对网络的学习能力、模型的表达能力以及网络的泛化能力都有深远影响。本章我们将介绍激活函数的基础知识,帮助读者理解激活函数在神经网络中的作用和重要性。我们首先介绍激活函数的定义,然后讨论其在前馈神经网络中的位置和角色,以及为什么需要非线性激活函数。在深入学习可学习激活函数之前,我们将回顾一些传统激活函数,如Sigmoid、ReLU等,并探讨它们在实际应用中的优势与局限性。通过本章内容,读者应能对激活函数建立初步认识,并为后续章节的学习打下坚实基础。

# 2. 可学习激活函数的理论基础

### 2.1 激活函数的类型和作用

#### 2.1.1 常见的固定激活函数

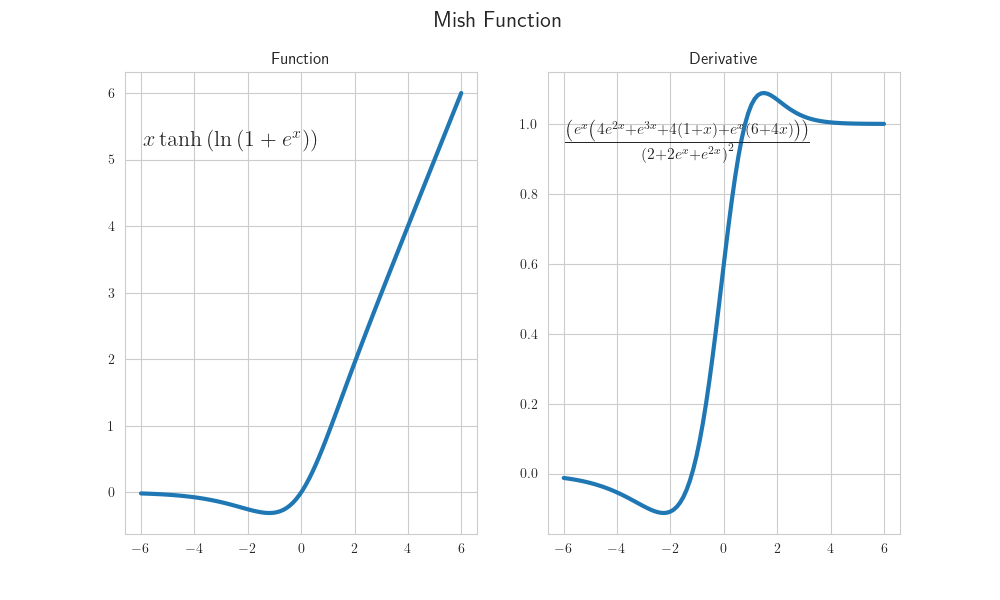

在神经网络的诸多组件中,激活函数扮演着至关重要的角色。它们为网络引入了非线性特性,使得网络能够学习和表示复杂的函数映射。常见的固定激活函数包括Sigmoid、Tanh和ReLU等。

- **Sigmoid函数**:它的数学表达式是\(f(x) = \frac{1}{1 + e^{-x}}\),输出范围是(0, 1),Sigmoid函数在早期深度学习模型中非常流行,但由于其梯度消失问题,现在已经较少单独使用。

- **双曲正切函数(Tanh)**:其表达式为\(f(x) = \frac{e^x - e^{-x}}{e^x + e^{-x}}\),输出范围是(-1, 1)。它与Sigmoid类似,但输出均值为0,这在某些情况下会比Sigmoid函数表现得更好。

- **修正线性单元(ReLU)**:其表达式为\(f(x) = max(0, x)\),ReLU函数在大量实践中显示出优越性,因为其计算效率高且有助于缓解梯度消失问题。但是ReLU在负区间内梯度为零,有时候会导致所谓的"死神经元"问题。

#### 2.1.2 激活函数的选择对模型性能的影响

选择合适的激活函数对于模型的训练速度、性能和收敛性都有显著影响。不同的激活函数在特定任务上可能会有不同的表现。例如,在图像处理中,ReLU及其变种往往因为其简单和快速而被广泛应用。而在需要输出概率的场景中,Sigmoid和Softmax通常更为合适。

为了最大化神经网络的性能,需要根据具体问题来选择或者设计激活函数。这就引出了可学习激活函数的概念,即通过参数化激活函数来使其能够根据数据进行自我优化。

### 2.2 可学习激活函数的工作原理

#### 2.2.1 参数化的思想与方法

可学习激活函数是通过引入一组参数来实现对激活函数形状的调整。这些参数可以通过模型训练过程中的反向传播算法进行优化。参数化通常通过以下方式实现:

- **参数化Sigmoid (Parametric ReLU)**:将ReLU的固定斜率替换为一个可学习的参数,形式上可以表示为\(f(x) = max(0, x) + \alpha min(0, x)\),其中α是一个学习参数。

- **LSTM中的激活函数参数化**:在长短时记忆网络(LSTM)中,门控机制的Sigmoid函数也被参数化,通过引入额外的向量来控制信息的流动。

#### 2.2.2 训练过程中的动态调整机制

在训练过程中,这些激活函数的参数会根据损失函数的梯度进行动态调整。具体来说,网络通过前向传播计算输出和损失,然后通过反向传播算法计算损失函数相对于激活函数参数的梯度。这些梯度用于更新激活函数的参数,从而改进网络性能。

这种方法的关键在于,通过数据驱动的方式确定激活函数的最优形状,而不是依赖于固定的函数形式。这种灵活性使得网络在处理不同类型的数据时能够更好地适应和泛化。

### 2.3 可学习激活函数的优势分析

#### 2.3.1 提升模型泛化能力的策略

可学习激活函数的引入,对提升模型泛化能力有显著作用。原因在于:

- **自适应性**:可学习激活函数允许模型在训练过程中根据数据特性自适应地调整激活函数的形状,从而使得模型能够更好地拟合训练数据,同时避免过拟合。

- **多样性的探索**:由于激活函数形状的多样性,模型可以探索更多的函数空间,增加找到更优解的机会。

#### 2.3.2 与传统激活函数的对比

与传统的固定激活函数相比,可学习激活函数提供了更高的灵活性。例如,相比于ReLU,可学习激活函数可以通过学习过程中获得的参数来避免"死神经元"现象。在与Sigmoid的对比中,可学习激活函数克服了梯度消失的问题,并提高了模型训练的速度和效率。

在实践中,可学习激活函数往往能够使得模型在不增加复杂度的情况下,达到更高的准确率和更好的泛化能力。然而,它们的引入也带来了额外的参数,需要更仔细地进行调参和正则化。

# 3. 可学习激活函数的实现与应用

在本章中,我们将深入探讨可学习激活函数的构建方法,实验设置,以及应用案例。我们将通过构建过程中的关键步骤、常用的优化算法和技巧,以及如何在深度学习框架中应用可学习激活函数来解决特定问题进行详细解析。

## 3.1 可学习激活函数的构建方法

构建一个高效的可学习激活函数是深度学习模型成功的关键。这一过程涉及一系列关键技术的选择和优化,接下来将详细解析构建过程的关键步骤和常用的优化技巧。

### 3.1.1 构建过程中的关键步骤

在构建可学习激活函数时,以下关键步骤是必不可少的:

1. **选择基础激活函数**:首先要决定是基于哪种固定激活函数进行参数化。常见的基础激活函数包括ReLU、Sigmoid和Tanh等。

2. **定义参数化模型**:这一步是将选定的激活函数通过引入可学习的参数进行扩展。这可能涉及权重、偏置或其他超参数。

3. **初始化参数**:合理地初始化可学习参数对确保训练过程的收敛至关重要。

4. **前向传播设计**:在前向传播过程中,激活函数应能够根据输入数据和参数化模型计算激活值。

5. **梯度计算与反向传播**:设计梯度下降算法来更新可学习参数,这将涉及到链式法则的应用。

```python

import torch

import torch.nn as nn

# 定义一个简单的可学习激活函数类

class LearnableActivation(nn.Module):

def __init__(self):

super(LearnableActivation, self).__init__()

self.alpha = nn.Parameter(torch.ones(1)) # 初始化可学习参数alpha

def forward(self, x):

return torch.relu(x) * self.alpha # 基于ReLU函数参数化扩展

# 实例化模型并应用可学习激活函数

model = LearnableActivation()

input = torch.randn(10, 3)

output = model(input)

```

在上述代码中,我们创建了一个`LearnableActivation`类,其中包含一个可学习参数`alpha`。在前向传播中,我们使用ReLU函数作为基础,并根据`alpha`对其进行调整。

### 3.1.2 常用的优化算法和技巧

为了提高可学习激活函数的效果,以下是一些常用的优化方法和技巧:

- **权重初始化策略**:如He初始化或Xavier初始化,可以改善训练初期的梯度流动。

- **正则化方法**:包括L1、L2正则化或Drop

0

0