【大数据分析利器】:R语言处理大规模数据集的必备技能

发布时间: 2024-11-03 11:42:40 阅读量: 111 订阅数: 42

# 1. R语言简介与数据处理基础

## 1.1 R语言的起源与特点

R语言是一种用于统计分析、图形表示和报告的语言和环境。它诞生于1990年代初,由新西兰奥克兰大学的Ross Ihaka和Robert Gentleman共同开发。R语言以其灵活性、强大的数据分析能力和社区支持而闻名。作为一个开源项目,R语言不断吸收来自全球数据科学家的贡献,包括新的函数、方法和工具包。它特别适合数据挖掘和机器学习任务,得到了广泛的行业认可和应用。

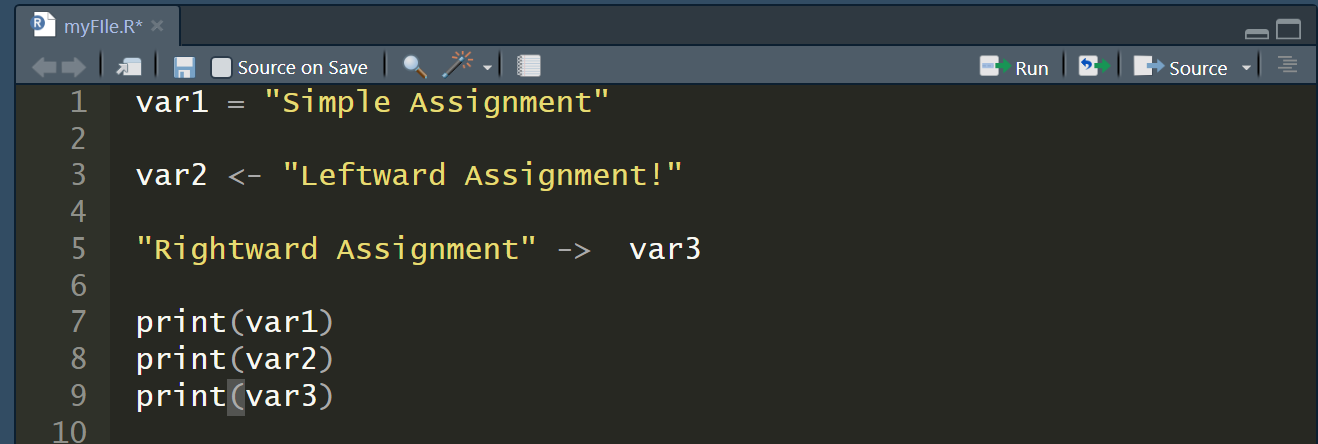

## 1.2 R语言的基本语法和操作

在R语言中,变量不需要显式声明类型,你只需将数据赋值给一个名称即可创建变量。例如:

```r

x <- 10

y <- "text"

```

R语言使用函数来进行大部分的操作。函数调用的格式通常为`function_name(arg1, arg2, ...)`, 其中`arg1`, `arg2`等是传递给函数的参数。例如,创建一个向量可以使用`c()`函数:

```r

vector <- c(1, 2, 3, 4, 5)

```

基础数据类型包括向量(vector)、矩阵(matrix)、数组(array)、因子(factor)、数据框(data frame)等。R语言支持向量化操作,这意味着你可以对整个向量进行数学运算,而无需循环每个元素。

## 1.3 R语言中的数据处理基础

数据处理是数据分析的核心环节。在R语言中,数据处理的基础操作包括数据的导入、清洗、转换和子集化。

数据通常可以通过`read.csv()`, `read.table()`, `read.xlsx()`等函数从外部文件导入到R环境中。例如,导入CSV文件:

```r

data <- read.csv("path/to/file.csv")

```

数据清洗是通过识别和修正数据中的错误、不一致或缺失值来提高数据质量。R语言提供了如`na.omit()`, `complete.cases()`等函数来处理缺失值,以及`subset()`函数进行数据子集化。

转换和标准化数据是将数据调整到适合进一步分析的格式,这可能包括重新编码分类变量为因子,或者对数值进行标准化处理。例如,将字符型数据转换为因子型:

```r

data$category <- as.factor(data$category)

```

R语言的数据处理能力极其强大,其丰富的包和函数库为用户提供了无数处理数据的工具。随着我们对R语言和数据处理的深入探讨,你将掌握如何高效地处理和分析复杂数据集。

# 2. R语言在大规模数据集处理中的优势

### 3.1 数据导入导出方法

在处理大规模数据集时,R语言提供了一系列的数据导入导出方法,这些方法能够让用户轻松地读取和保存不同格式的数据文件。此外,R语言的数据导入导出功能还支持将数据导出到文件或数据库中,使得数据处理和分析更加灵活高效。

#### 3.1.1 读取不同格式的数据文件

R语言能够读取多种格式的数据文件,包括CSV、TXT、Excel、JSON、XML等。利用R语言的基础包,如`utils`和`readr`,我们可以导入这些格式的数据。下面提供一个读取CSV文件的示例代码:

```r

# 读取CSV文件

data <- read.csv('path/to/your/csvfile.csv', header = TRUE, sep = ',')

```

逻辑分析:

- `read.csv`函数用于读取CSV格式的文件。

- 第一个参数`'path/to/your/csvfile.csv'`指定了要读取的文件路径。

- `header = TRUE`参数表示CSV文件的第一行包含列名。

- `sep = ','`参数定义了字段之间的分隔符。

扩展性说明:

在处理大数据时,读取和写入速度是关键因素。对于特别大的CSV文件,可以考虑使用`fread`函数在`data.table`包中,这个函数在读取大数据集时效率更高。

#### 3.1.2 数据的导出到文件或数据库

R语言同样支持将数据导出到多种格式的文件中,或者直接导出到数据库。例如,使用`write.csv`函数将数据框(data frame)保存为CSV文件:

```r

# 导出数据到CSV文件

write.csv(data, file = 'path/to/your/output.csv', row.names = FALSE)

```

逻辑分析:

- `write.csv`函数用于将数据框导出为CSV文件。

- 第一个参数是数据框对象。

- `file = 'path/to/your/output.csv'`指定了输出文件的路径。

- `row.names = FALSE`参数表示在导出时不包括行名。

扩展性说明:

在将数据导出到数据库时,可以使用R语言的数据库连接包,如`RMySQL`或`RPostgreSQL`,这使得大数据分析的结果可以直接存储到数据库系统中,便于后续的查询和管理。

### 3.2 数据清洗和预处理

数据清洗是数据处理的一个关键步骤,它涉及到识别和修正(或删除)数据集中不准确、不一致或不完整的数据。在R语言中,我们可以使用多种工具和方法来进行数据清洗和预处理。

#### 3.2.1 缺失值和异常值处理

缺失值和异常值的处理在数据清洗中尤其重要。R语言提供了多种方法来识别和处理这些值。

```r

# 查找并处理缺失值

data[is.na(data)] <- mean(data, na.rm = TRUE) # 用均值填充缺失值

```

逻辑分析:

- `is.na(data)`用于检测数据集中的缺失值。

- `mean(data, na.rm = TRUE)`计算数据集中非缺失值的均值。

- 将均值赋值给所有缺失值的位置,从而完成缺失值的处理。

#### 3.2.2 数据类型转换与标准化

数据类型转换是将数据从一种类型转换为另一种类型的过程,而数据标准化是将数据缩放到一个标准范围的过程。这些处理对于后续的数据分析至关重要。

```r

# 数据类型转换

data$column <- as.factor(data$column) # 将某列转换为因子类型

# 数据标准化

data$column <- (data$column - min(data$column)) / (max(data$column) - min(data$column))

```

逻辑分析:

- 第一个代码块中使用`as.factor()`函数将数据列转换为因子类型,这在处理分类数据时非常有用。

- 第二个代码块通过计算极差并将数据映射到[0, 1]区间内,实现了数据的标准化。

#### 3.2.3 数据集的合并与分割

数据集的合并和分割是数据预处理的常见任务。R语言通过提供如`merge`和`split`函数等工具,使得这些任务变得简单快捷。

```r

# 数据集合并

new_data <- merge(data1, data2, by = 'common_column') # 合并两个数据集

# 数据集分割

split_data <- split(data, data$group) # 根据group列分割数据集

```

逻辑分析:

- 在合并数据集时,`merge`函数根据`common_column`列将`data1`和`data2`两个数据集合并为一个。

- `split`函数根据`data$group`列将数据集`data`分割为多个子集,每个子集对应一个group的值。

扩展性说明:

在处理复杂的数据结构时,可能需要运用到更高级的数据处理技术,比如使用`dplyr`和`tidyr`包中的函数进行数据处理的链式操作,这可以大大提升数据预处理的效率和可读性。

表格展示:

下面展示一个数据集的分割示例表,使用的是R语言内置的`mtcars`数据集。

| group | cylinders | mpg | disp | hp | drat |

|-------|-----------|-------|------|-----|------|

| 1 | 4 | 22.8 | 108 | 93 | 3.85 |

| 2 | 6 | 21 | 160 | 110 | 3.9 |

| ... | ... | ... | ... | ... | ... |

在实际应用中,数据集分割可以更复杂,包含多个变量和多个分组。

以上章节内容仅是一个概览,为了深入理解R语言在大规模数据集处理中的优势,下一节将详细介绍R语言在数据导入导出及清洗的具体技巧,包括缺失值和异常值处理、数据类型转换与标准化以及数据集的合并与分割。这些技巧都是数据预处理过程中不可或缺的环节。

# 3. R语言数据导入导出及清洗技巧

## 3.1 数据导入导出方法

### 3.1.1 读取不同格式的数据文件

在数据分析和数据科学的实践中,数据的导入导出是一个常见的任务。R语言作为数据处理的强大工具,提供了多种读取和导出数据的函数。这些数据文件可以是简单的CSV格式,也可以是更为复杂的如JSON或者特定的数据库文件格式。

CSV文件是最常见的数据格式之一,R语言内置了`read.csv()`和`write.csv()`函数用于

0

0