【模型压缩对AI性能的影响】:深度分析模型压缩技术对AI性能的影响及优化策略

发布时间: 2024-09-04 01:15:50 阅读量: 111 订阅数: 38

深度学习模型压缩方法及产品研究.pdf

# 1. 模型压缩技术概述

模型压缩技术是AI优化领域的重要分支,它致力于缩小深度学习模型的体积,并提高模型的推理速度,同时尽可能地保持模型的性能。随着深度学习模型的快速增长,模型压缩技术变得越来越重要,尤其是在移动设备和边缘设备上部署时,硬件资源的限制要求模型必须足够轻巧高效。模型压缩可以分为权重剪枝、知识蒸馏和参数量化等多种方法,这些方法在减少计算量和存储需求方面各有特点和优势。本章将对模型压缩技术的概念、分类及应用做一个初步的介绍,为后续章节的深入探讨奠定基础。

# 2. 模型压缩技术原理

### 2.1 权重剪枝与稀疏化

#### 2.1.1 权重剪枝的基本方法

权重剪枝是一种减少模型复杂性的有效技术,主要通过消除神经网络中不重要的权重来实现模型压缩。通常,剪枝可以分为结构化剪枝和非结构化剪枝两类。

在结构化剪枝中,权重被沿着特定的结构进行剪除,如剪除整个滤波器(filter)或权重通道(channel)。这使得模型在硬件上实现起来更高效,因为大多数硬件加速器都依赖于结构化的数据流。例如,在卷积神经网络中,可以将整个卷积核中值较小的权重置零,并在训练时忽视这些权重的更新。

```python

# 一个简单的权重剪枝函数的伪代码示例

def weight_pruning(model, pruning_threshold):

for layer in model.layers:

# 获取层的权重矩阵

weights = layer.get_weights()

# 计算权重的绝对值

abs_weights = np.abs(weights)

# 应用阈值,剪除权重

weights[abs_weights < pruning_threshold] = 0

# 更新层的权重

layer.set_weights(weights)

```

在非结构化剪枝中,权重可以被随机地剪除,无需考虑它们的组织结构。这种方法提供了更大的灵活性,但可能导致存储不连续,使得实际硬件加速的效率降低。

权重剪枝技术的关键是选择一个合适的剪枝率(pruning rate),这个比率决定了保留的权重比例。剪枝率的选择依赖于网络的冗余程度,以及我们希望达到的模型压缩程度和性能损失之间的权衡。

#### 2.1.2 稀疏矩阵表示及其优势

当通过剪枝获得稀疏矩阵后,如何高效地存储和计算变得至关重要。稀疏矩阵表示可以通过忽略零值来减少存储空间和计算资源的使用。

稀疏矩阵表示有多种,包括坐标列表(COO)、压缩稀疏行(CSR)或列(CSC)格式等。在这些表示方法中,CSR是被广泛采用的一种格式,它适用于快速矩阵操作。CSR格式将稀疏矩阵存储为三个一维数组,分别包含非零元素的值、行索引和列索引,以及一个指示每行非零元素数量的数组。

```python

# 使用CSR格式表示稀疏矩阵的简单示例

from scipy.sparse import csr_matrix

# 创建一个稀疏矩阵

sparse_matrix = csr_matrix([[1, 0, 0, 0], [0, 2, 0, 3], [4, 0, 0, 5]])

# 打印CSR格式的信息

print("Data:", sparse_matrix.data)

print("Indices:", sparse_matrix.indices)

print("Indptr:", sparse_matrix.indptr)

print("Shape:", sparse_matrix.shape)

```

稀疏矩阵表示的优势在于减少了存储需求,因为大部分存储空间被用于非零元素,同时加快了矩阵乘法的计算速度,尤其是对于大型稀疏矩阵。这直接转化为提升模型推理速度和降低计算资源消耗,特别是在资源受限的设备如手机或嵌入式设备上。

### 2.2 知识蒸馏

#### 2.2.1 知识蒸馏的概念与过程

知识蒸馏是一种模型压缩技术,它将一个大型复杂的“教师”模型的知识迁移到一个小型的“学生”模型中。在这个过程中,学生模型尝试学习教师模型的输出分布信息,而不仅仅是标签信息。这种方法允许学生模型即使在结构上比教师模型简单得多,也能保持较好的性能。

知识蒸馏涉及的主要步骤包括训练教师模型、生成软标签(soft labels)和训练学生模型:

1. 训练一个大型、高准确率的教师模型。

2. 使用教师模型对原始训练数据进行预测,生成软标签,即每类的预测概率。

3. 利用这些软标签训练学生模型,同时保留原始硬标签(one-hot encoded labels)作为辅助。

```python

# 一个简化的知识蒸馏过程的伪代码

def knowledge_distillation(teacher_model, student_model, data_loader, temperature):

# 训练学生模型

for inputs, labels in data_loader:

# 获取教师模型的软标签

teacher_predictions = teacher_model(inputs)

# 对教师的预测结果进行温度缩放

soft_labels = tf.nn.softmax(teacher_predictions / temperature)

# 同时获取硬标签

hard_labels = tf.one_hot(labels, num_classes)

# 使用软标签和硬标签来训练学生模型

student_model.train(inputs, [soft_labels, hard_labels])

```

蒸馏过程中温度参数(temperature)的选取至关重要。温度参数能够控制软标签的“软化”程度。温度越高,输出概率分布越平滑,反之则越接近硬标签。

#### 2.2.2 蒸馏过程中损失函数的设计

在蒸馏过程中,设计合适的损失函数是提高学生模型性能的关键。损失函数通常包含两部分:一部分与硬标签相关,用于确保模型能够正确分类;另一部分与软标签相关,用于使学生模型的输出与教师模型的输出尽可能接近。

一个通用的损失函数可以表示为:

$$L_{total} = \alpha L_{hard} + (1 - \alpha) L_{soft}$$

其中,$L_{total}$ 是总损失,$L_{hard}$ 是与硬标签相关的损失(如交叉熵损失),$L_{soft}$ 是与软标签相关的损失(通常也是交叉熵损失),$\alpha$ 是平衡两部分损失的超参数。

使用软标签损失函数的一个优点是它能够迫使学生模型学习到教师模型的不确定性,从而在一定程度上防止过拟合,并提高泛化能力。

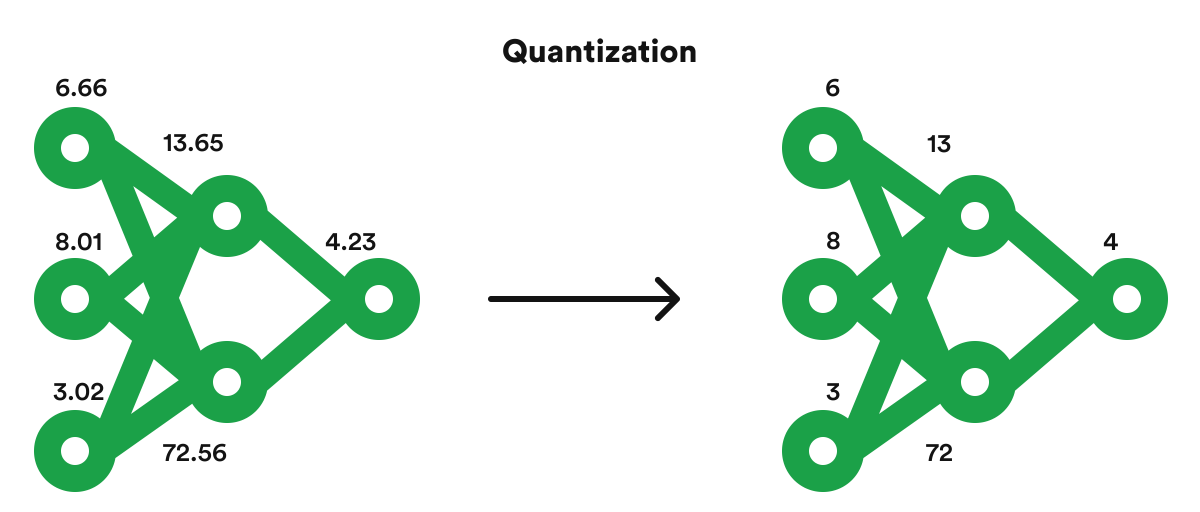

### 2.3 参数量化

#### 2.3.1 量化技术的类型与原理

参数量化是另一种重要的模型压缩技术,旨在减少模型中参数的位宽。这种方法通常涉及将模型中的浮点数参数转换为低精度的表示,如整数或二进制。量化可以分为后训练量化和训练时量化。

后训练量化(Post-training Quantization, PTQ)涉及在训练完成后,将模型参数从浮点数转换为定点数或二进制表示。这种转换通常通过选取适当的量化算法来最小化量化引起的精度损失。

```python

# 后训练量化的伪代码示例

def post_training_quantization(model, calibration_dataset, num_bits):

# 使用校准数据集来确定量化参数

quantization_params = compute_quantization_params(model, calibration_dataset)

# 应用量化参数到模型

quantized_model = apply_quantization_params(model, quantization_params)

# 将模型中的参数转换为num_bits位宽

quantized_model.quantize_parameters(num_bits)

return quantized_model

```

训练时量化(Quantization-aware Training, QAT)则在模型训练的过程中加入量化的影响,通过训练过程模拟量化后的效果,使模型能够学习到如何在量化情况下表现良好。

```python

# 训练时量化的伪代码示例

def quantization_aware_training(model, training_dataset, num_bits):

# 将量化模型插入训练过程

q_model = insert_quantization_nodes(model, num_bits)

# 使用训练数据集对模型进行训练

q_model.train(training_dataset)

return q_model

```

量化技术能显著减少模型的存储大小和计算资源需求。例如,在移动设备或边缘计算设备上,使用8位定点数代替32位浮点数进行运算,可以加快推理速度并减少能耗。

#### 2.3.2 量化对模型精度的影响

尽管量化能够提供巨大的存储和性能优势,但不可避免地会对模型精度产生一定的影响。由于量化过程中数值范围和精度的损失,模型在进行量化后可能无法达到与原始模型完全相同的性能。

为了最小化量化带来的精度损失,需要仔细选择量化策略,例如动态量化或分层量化。动态量化在推理时对权重进行量化,而分层量化则为不同层应用不同位宽的量化。研究显示,在许多情况下,精度损失可以通过适当的量化策略和校准过程来控制。

```mermaid

flowchart LR

A[开始量化] --> B{选择量化类型}

B --> C[动态量化]

B --> D[分层量化]

C --> E[量化权重和激活]

D --> F[对不同层应用不同位宽]

E --

```

0

0