【深度神经网络剪枝实战】:掌握剪枝技术,提升AI性能的黄金法则

发布时间: 2024-09-04 00:52:51 阅读量: 94 订阅数: 39

基于深度神经网络剪枝的两阶段遥感图像目标检测.pdf

# 1. 深度神经网络剪枝技术概述

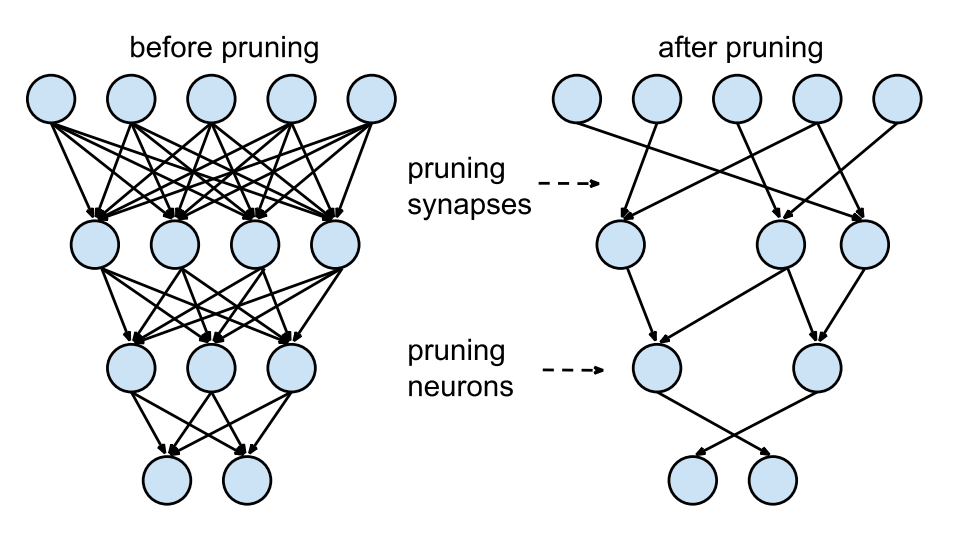

在深度学习领域中,模型的性能往往与其复杂性成正比。然而,随着网络层数的增加,模型不仅在计算上变得越来越昂贵,而且对存储和带宽的需求也在不断提升。为了解决这些问题,研究者们提出了深度神经网络剪枝技术,旨在移除模型中的冗余部分,从而达到减少计算负担、加快推理速度和提升模型泛化能力的目的。

深度神经网络剪枝技术的核心在于识别并剔除那些对模型预测影响较小的神经元或连接。这种方法不仅可以降低模型的存储需求,还能减少模型对计算资源的依赖,使其更适合在资源受限的设备上部署。此外,剪枝技术也是模型压缩的一种有效手段,有助于提升模型在实际应用中的可扩展性。

本章节将为读者提供对深度神经网络剪枝技术的初步了解,并介绍其在优化模型性能方面的关键作用。随后的章节将深入探讨剪枝的理论基础、具体方法和实施步骤,以及剪枝技术在实际中的应用案例和未来的发展方向。

# 2. 剪枝理论基础与方法

## 2.1 剪枝的理论背景

### 2.1.1 深度学习中的冗余现象

在深度学习模型中,尤其是在大型神经网络中,冗余现象普遍存在。冗余现象指的是模型参数中存在大量不影响模型最终性能的参数。这种现象有以下几个主要原因:

1. **过度复杂的模型结构**:随着网络层数和参数数量的增加,模型复杂度上升,容易出现参数冗余。

2. **数据增强和正则化**:为了防止过拟合,数据增强和各种正则化方法(如Dropout)可能使模型学习到多个相似的特征表示。

3. **参数初始化**:在训练过程中,部分参数可能因为初始化不当或优化算法的特性,最终对模型的输出没有实质性的贡献。

### 2.1.2 剪枝对模型性能的影响

剪枝技术通过删除冗余的网络参数来减小模型体积,从而提高模型的运行效率。然而,这并不意味着性能的下降是不可避免的。理论上,合适的剪枝技术应当在减少模型大小的同时保持甚至提高模型的性能。

1. **准确性保持**:剪枝不当可能会删除关键的参数,导致准确率下降。因此,剪枝方法需要设计得足够精细,以保证剪枝后的网络仍能保持较高的准确性。

2. **计算效率提升**:剪枝后模型参数减少,使得模型运行速度得到提升,计算资源消耗降低,这对于资源受限的环境(如移动设备)来说尤为重要。

3. **泛化能力增强**:剪枝可能会移除过拟合的参数,从而提高模型的泛化能力。这是因为在一些情况下,剪枝能够使模型更加聚焦于关键特征。

## 2.2 剪枝策略与方法

### 2.2.1 基于权重的剪枝

基于权重的剪枝是最直接的剪枝方法之一,它依赖于权重的大小来判断参数的重要性。权重值较小的参数被认为是冗余的,可以被剪枝掉。这种方法简单易行,但也有缺点。

1. **绝对阈值剪枝**:设定一个固定阈值,将小于该阈值的所有参数剪枝。

2. **相对阈值剪枝**:通过设置一个百分比来决定要剪枝的参数数量,例如剪枝掉占总参数20%的最小权重值。

```python

def absolute_threshold_pruning(model, threshold):

for layer in model.parameters():

layer_pruned = layer.data.abs() < threshold

layer.data[layer_pruned] = 0

return model

```

参数说明:`model`是待剪枝的模型,`threshold`是预设的阈值。代码会遍历模型中所有的参数,将绝对值小于阈值的参数设置为0。

### 2.2.2 基于梯度的剪枝

基于梯度的剪枝方法考虑了参数梯度的信息。参数的梯度大小反映了其对模型输出的影响程度,因此,梯度较小的参数被认为是不太重要的。

1. **单次迭代剪枝**:仅利用当前一次迭代中的梯度信息进行剪枝。

2. **多次迭代累积剪枝**:累积多个迭代周期内的梯度信息,从而更全面地评估参数的重要性。

### 2.2.3 基于优化器的剪枝

基于优化器的剪枝方法关注于优化器在训练过程中对参数的更新。如果一个参数长时间未被优化器更新,那么它可能是冗余的。

1. **动量剪枝**:利用动量项来追踪参数的更新情况,长时间不动的参数更容易被剪除。

2. **优化器敏感性剪枝**:通过敏感性分析来评估参数对优化器更新的敏感性,敏感性低的参数更易被剪枝。

## 2.3 剪枝的评估指标

### 2.3.1 准确率保持

评估剪枝对模型性能影响的关键指标之一是准确率保持率。它是指剪枝后模型在测试集上的准确率与剪枝前模型准确率的比值。

$$ 准确率保持率 (\%) = \left( \frac{剪枝后准确率}{剪枝前准确率} \right) \times 100 $$

### 2.3.2 模型压缩率

模型压缩率是剪枝带来的模型大小减小的比率,它表示了剪枝技术在减少模型参数方面的能力。

$$ 模型压缩率 (\%) = \left( \frac{原始模型参数数量 - 剪枝后模型参数数量}{原始模型参数数量} \right) \times 100 $$

### 2.3.3 推理速度提升

除了模型压缩率外,剪枝后的模型通常能提供更快的推理速度。推理速度提升可以通过测试剪枝前后模型在相同硬件上的推理时间来评估。

$$ 推理速度提升 (\%) = \left( \frac{剪枝前模型推理时间 - 剪枝后模型推理时间}{剪枝前模型推理时间} \right) \times 100 $$

在本章中,我们深入探讨了深度神经网络剪枝的理论背景,包括深度学习中的冗余现象及其对模型性能的影响。我们还介绍了几种剪枝策略和方法,包括基于权重、梯度和优化器的剪枝方法,以及它们的优缺点。最后,我们定义了剪枝评估的关键指标,包括准确率保持、模型压缩率和推理速度提升,这些指标为评估剪枝效果提供了具体的方向。在下一章中,我们将步入深度神经网络剪枝实战技巧,提供一些实践中的技巧和挑战解决方案。

# 3. 深度神经网络剪枝实战技巧

随着深度学习在各种应用中的广泛部署,模型的复杂性和计算需求的增长对计算资源提出了更高的要求。在这样的背景下,深度神经网络剪枝成为了解决这一问题的关键技术之一。本章将深入探讨深度神经网络剪枝实战中的一些关键技巧,帮助读者理解和掌握如何在实际应用中有效地进行模型优化。

## 3.1 实战前的准备工作

在深入剪枝技术之前,实战前的准备工作是必不可少的步骤。这包括模型的选择与预训练,以及环境配置与工具选

0

0