【AI模型参数编码革新】:掌握编码压缩技巧,开启AI模型优化新篇章

发布时间: 2024-09-04 00:59:58 阅读量: 107 订阅数: 38

# 1. AI模型参数编码的重要性

AI模型参数的编码是模型训练和部署中的关键步骤。优秀的编码策略能够显著减少模型的大小,提升模型的运行速度,同时保持或提高模型性能。在当前深度学习模型日趋庞大、计算资源日益紧张的背景下,有效地进行参数编码,对于实现模型的轻量化、优化资源使用具有重要的现实意义。

在本章中,我们将探讨为何在AI领域,参数编码技术至关重要,以及如何通过编码压缩技术进一步优化AI模型。我们将从编码压缩技术对模型性能和效率的影响开始,为接下来的章节内容做好铺垫,引导读者理解编码压缩在AI模型优化中的核心地位。

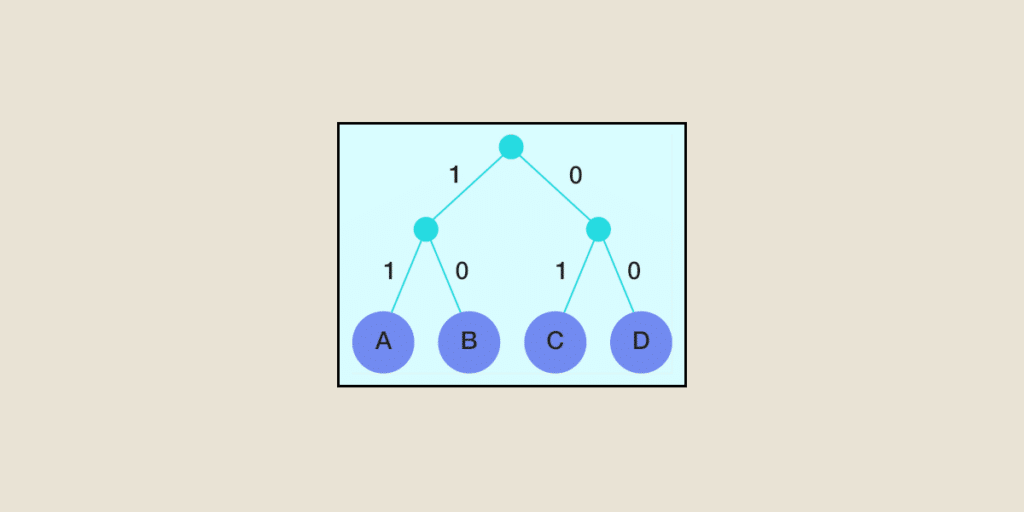

```mermaid

graph LR;

A[AI模型参数编码] --> B[模型大小与速度优化]

B --> C[资源使用的优化]

C --> D[AI模型优化的现实意义]

```

在下一章中,我们将深入探讨编码压缩技术的理论基础,包括参数编码的定义、作用以及编码压缩与模型优化之间的关系。通过深入解析量化理论、稀疏化理论和知识蒸馏理论,为读者提供编码压缩技术的理论支撑,帮助读者构建起理解和实施AI模型编码压缩的整体框架。

# 2. 理论基础 - 编码压缩技术的原理

## 2.1 参数编码的基本概念

### 2.1.1 参数编码的定义与作用

参数编码是机器学习和人工智能领域中一种重要的模型压缩技术。它通过特定的数学方法对模型中的参数进行编码,以减少参数的存储需求和加快计算速度。在深度学习模型中,参数通常以权重的形式存在,代表了不同神经元之间的连接强度。参数的数量通常与模型的复杂度成正比,这就导致了模型在实际部署中需要大量的内存和计算资源。

参数编码的核心思想是找到一个有效的表示方法,使得模型参数可以在保持原有功能的同时,以更少的空间进行存储。这通常涉及对参数矩阵进行近似表示,通过有损或无损的压缩技术来实现。例如,在量化编码中,连续的参数值会被映射到离散的有限集合中,从而减少表示每个参数所需的位数。

### 2.1.2 编码压缩与模型优化的关系

编码压缩技术对于模型优化至关重要。随着深度学习模型的日益复杂和参数的不断增多,未经过压缩的模型很难在边缘设备(如手机、IoT设备)上部署和运行。编码压缩技术可以显著降低模型的存储需求,加速模型的推理过程,从而使得模型更加适用于资源受限的环境。

此外,通过编码压缩技术减少模型大小,还能够降低模型加载到内存的时间,以及减少从存储设备到内存的数据传输次数。这不仅可以提高模型的运行效率,还能够在一定程度上提升模型的计算精度,因为压缩过程可能会移除掉一些对模型性能影响较小的冗余参数。

## 2.2 编码压缩的理论模型

### 2.2.1 量化理论

量化是将参数从浮点数格式转换为整数格式的过程,目的是为了减少存储空间和计算量。例如,通常使用8位整数替代32位浮点数来表示参数。在量化理论中,参数编码需要考虑精度损失和量化误差,以确保在降低资源消耗的同时,尽可能保持模型的性能。

量化过程涉及确定量化级别(即量化后的位数),选择量化方法(如均匀量化或对称量化),以及确定量化函数(将连续值映射到离散值的过程)。在模型训练之后,可以使用各种量化算法来压缩模型的参数。量化可以是训练后量化(Post-Training Quantization)或训练时量化(Quantization Aware Training),后者会在模型训练过程中模拟量化效果,以获得更好的性能。

### 2.2.2 稀疏化理论

稀疏化是一种通过去除神经网络中一些不重要的连接,从而减少参数数量的技术。在稀疏化理论中,网络的参数矩阵被转换成一个稀疏矩阵,即大部分元素值为零的矩阵。稀疏化不仅减少了模型的参数量,也减少了计算量,因为零值参数不需要参与计算。

稀疏化通常与正则化技术结合使用,如L1正则化,以促进模型的稀疏性。稀疏化的实现可以是结构化的或非结构化的。结构化稀疏指的是在特定的结构上(比如每层固定数量的通道)实现稀疏性,而非结构化的稀疏则不遵循任何特定的模式。稀疏化的一个挑战是如何在减少参数的同时最小化模型精度的损失。

### 2.2.3 知识蒸馏理论

知识蒸馏是一种训练一个小的、高效的模型来模仿一个大的、复杂的模型的行为的技术。在这个过程中,大模型的“知识”被“蒸馏”到小模型中。知识蒸馏理论强调模型能力的转移和保存,在保留原始模型性能的同时实现模型压缩。

蒸馏过程通常涉及到训练小模型时使用大模型的输出作为“软标签”,这些软标签包含温度扩展后的概率分布信息,帮助小模型学习到大模型的内在表达。蒸馏过程中,不仅需要关注模型的性能,还需平衡压缩率和准确性,以确保最终模型的实用性和有效性。

## 2.3 编码压缩的评价标准

### 2.3.1 准确性与效率的权衡

在编码压缩技术的评价中,准确性与效率的权衡是一个核心考量因素。准确性通常是指模型在测试集上的表现,而效率则指模型的资源消耗,包括模型大小、运行时间和内存占用等。在实施编码压缩时,我们往往需要在保持模型准确性的同时尽可能提高模型的效率。

权衡的实现需要深入理解不同编码压缩技术对模型性能的影响。例如,一些量化技术可能会因为参数舍入而导致精度降低,而某些稀疏化方法可能因为过度剪枝而导致模型性能大幅下降。因此,在选择合适的编码压缩技术时,开发者需要根据实际应用场景的需求,平衡性能与资源消耗的折中方案。

### 2.3.2 压缩比与模型性能的评估

压缩比是指压缩后的模型大小与原始模型大小的比率,是衡量编码压缩效果的直接指标。在实际应用中,压缩比可以作为衡量模型部署便利性的一个重要指标,尤其是在对内存和存储有严格限制的设备上。

评估模型性能时,除了使用标准的精确度指标(如准确率、召回率、F1分数等)外,还需要考虑其他性能指标,如模型的运行速度、内存占用和功耗。这些指标对于在边缘计算和移动设备上部署模型尤为重要。高效的编码压缩技术可以使模型在保持高精度的同时,也具备良好的实时性和节能性,从而极大地拓宽了模型的应用场景。

在本章节中,我们详细探讨了编码压缩技术的理论基础,从基本概念到具体的理论模型,再到评估标准。这为进一步的实践探索和案例分析奠定了坚实的理论基础。在下一章节中,我们将深入探讨实现这些编码压缩技术的具体方法和应用实例。

# 3. 实践指南 - 编码压缩的实现方法

## 3.1 量化技术的实现与应用

### 3.1.1 量化技术的分类

量化技术是编码压缩的一个重要分支,它旨在减少模型参数的比特数,从而降低存储和计算需求。根据精度的降低程度,量化技术可以大致分为三类:

- **全精度量化(Full-precision Quantization)**:几乎不降低参数精度,仅对数据的表达形式进行压缩,保持了较高的计算精度,但压缩效果有限。

- **低精度量化(Low-precision Quantization)**:以牺牲一定计算精度为代价,显著降低模型大小和运算速度。通常采用8位整数(INT8)或更低位宽的参数表示。

- **二值化/三值化量化(Binary/Ternary Quantization)**:将参数量化为只有-1、0和1的二值或三值,大幅度减少参数比特数,但在很多情况下会带来较大的精度损失。

### 3.1.2 实现量化的步骤与工具

实现量化需要遵循以下步骤:

1. **分析原始模型**:首先对原始模型进行分析,了解其结构和参数分布。

2. **选择量化策略**:根据模型和应用需求,选择合适的量化精度。例如,移动设备上可能更倾向低精度量化,而服务器端可能接受全精度或低精度量化。

3. **训练量化模型**:使用专门的量化感知训练方法,调整模型权重以适应量化后的精度。

4. **实现量化操作**:使用框架如TensorFlow或PyTorch的量化API,将模型参数和激活进行量化转换。

这里是一个简化的代码示例,展示了如何使用PyTorch实现量化:

```python

import torch

import torch.nn.quantized as nnq

# 假设已经有了一个训练好的模型model

# 创建一个量化版本的模型

quantized_model = nnq.Quantize(

scale=1.0, zero_point=0, dtype=torch.qint8)

quantized_model.load_state_dict(model.state_dict())

# 将模型置于评估模式并进行量化转换

quantized_model.eval()

# 使用QuantStub和DeQuantStub来包装输入和输出,以便在量化和反量化间转换

class QuantizedModel(nn.Module):

def __init__(self):

super(QuantizedModel, self).__init__()

self.quant = torch.quantization.QuantStub()

self.dequant = torch.quantization.DeQuantStub()

# ...其他层和操作

def forward(self, x):

x = self.quant(x)

# ...正常前向传播操作

x = self.dequant(x)

return x

# 实例化量化模型并开始推理

quantized_model = QuantizedModel()

quantized_model = torch.quantization.prepare(quantized_model)

quantized_model(x)

```

### 3.1.3 量化的实际应用案例

在实际应用中,量化的案例可以是将一个训练好的深度学习模型部署到移动设备上。考虑一个图像分类模型,比如ResNet,其原始模型可能有数千万参数,对存储和计算资源有较高要求。通过实施量化,可以将模型参数减少到原来的1/8甚至更少,同时还能维持可接受的精度损失,使得模型能够高效运行在资源受限的移动设备上。

## 3.2 稀疏化技术的实现与应用

### 3.2.1 稀疏化技术的原理与方法

稀疏化技术旨在移除模型中不重要的参数,达到压缩模型的目的。在数学上,一个稀疏矩阵是大部分元素为零的矩阵。在神经网络中,通过设置一个阈值,可以将小于该阈值的权重置为零,从而实现模型的稀疏化。稀疏化可以分为结构化稀疏和非结构化稀疏:

- **结构化稀疏**:将权重矩阵

0

0