【数据整理秘籍】:R语言与tidyr包的高效数据处理流程

发布时间: 2024-11-03 04:27:39 阅读量: 104 订阅数: 39

java计算器源码.zip

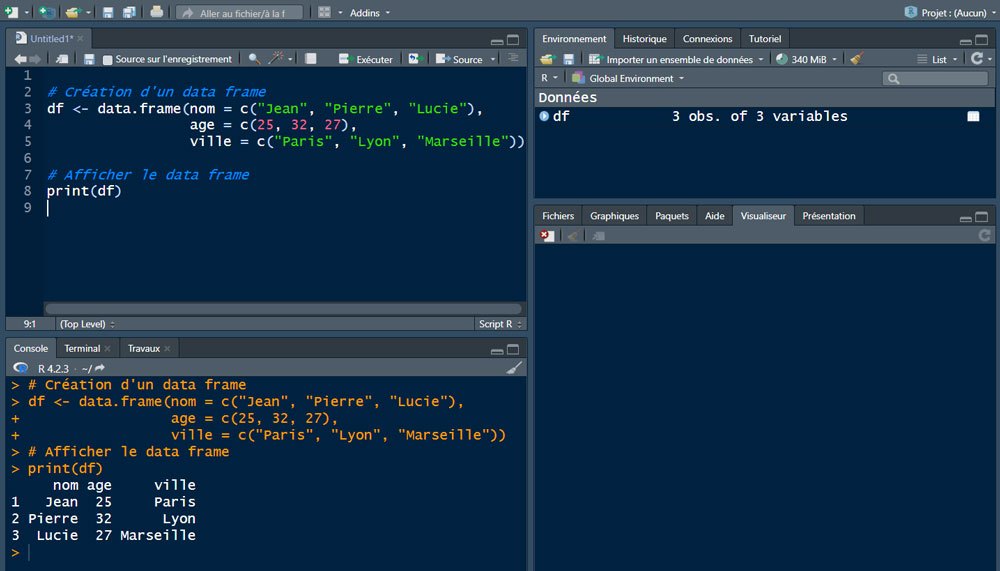

# 1. 数据整理的重要性与R语言介绍

数据整理是数据科学领域的核心环节之一,对于后续的数据分析、模型构建以及决策制定起到至关重要的作用。高质量的数据整理工作,能够保证数据分析的准确性和可靠性,为数据驱动的业务决策提供坚实的数据基础。

在众多数据分析工具中,R语言因其强大的统计分析能力、丰富的数据处理包以及开放的社区支持而广受欢迎。R语言不仅仅是一种编程语言,它更是一个集数据处理、统计分析和可视化于一体的生态系统。而`tidyr`是R语言中专门用于数据整理的一个包,它提供了一系列简洁实用的函数来转换和清洗数据集,使得数据整理工作更加高效和标准化。

本文将介绍数据整理的重要性,并对R语言和`tidyr`包进行简要介绍,为后续章节中使用`tidyr`进行数据清洗、变换、扩展与合并等操作打下基础。接下来,我们将深入了解`tidyr`的基础理论,并探讨如何利用这一工具对数据进行精细化的整理。

# 2. 使用tidyr包进行数据整理

## 2.1 tidyr包基础理论

### 2.1.1 数据整洁的概念

数据整洁(tidy data)是数据科学领域一个非常重要的概念,它由Hadley Wickham提出,意指一种数据集的结构,其中每一行是一个观测值,每一列是一个变量,每一个单元格是一个值。这样的数据结构简化了数据分析流程,因为它为各种数据操作提供了一致的数据形式。整洁的数据更容易进行数据转换、可视化以及建模。

整洁数据有三个主要规则:

1. 每个变量必须有一个自己的列。

2. 每个观测值必须有一个自己的行。

3. 每个值必须有一个自己的单元格。

### 2.1.2 R语言中的tidyr包简介

`tidyr`是R语言中处理数据集的包之一,它为数据整洁提供了系列的函数。使用`tidyr`,我们可以快速地将数据从非整洁形式转换为整洁形式,便于后续分析。该包提供了包括`gather()`、`spread()`、`separate()`和`unite()`等函数,用以处理数据的长宽转换,以及分割和合并列。

安装和加载`tidyr`包的代码如下:

```r

install.packages("tidyr") # 安装tidyr包

library(tidyr) # 加载tidyr包

```

## 2.2 数据清洗

### 2.2.1 缺失值的处理方法

在现实世界的数据库中,缺失值是十分常见的问题。`tidyr`提供了`drop_na()`和`fill()`等函数来处理缺失值。`drop_na()`函数可以删除含有NA(Not Available)值的行或列,而`fill()`函数则可以对缺失值进行填充。

以下是一个处理缺失值的示例代码:

```r

# 创建一个含有NA值的数据框

df <- data.frame(

id = 1:5,

x = c(1, 2, NA, 4, 5),

y = c(NA, 2, 3, 4, 5)

)

# 删除含有NA值的行

df_clean <- df %>% drop_na()

# 使用fill()函数填充缺失值

df_filled <- df %>% fill(x, y)

```

### 2.2.2 异常值的识别与处理

异常值的处理通常涉及到识别它们,然后根据具体情况采取措施,比如删除或者进行修正。在`tidyr`中,我们可以结合`dplyr`包提供的过滤功能,使用逻辑表达式来找出异常值。

以下是一个识别并处理异常值的示例代码:

```r

library(dplyr)

# 假设数据集中的x列不应超过5

df <- data.frame(

x = c(1, 2, 3, 10, 4, 5)

)

# 识别异常值

outliers <- df %>% filter(x > 5)

# 删除异常值

df_filtered <- df %>% filter(x <= 5)

```

## 2.3 数据变换

### 2.3.1 数据长宽转换

在数据分析中,经常会遇到需要将数据从宽格式转换为长格式(或反之)的情况。`tidyr`中的`gather()`和`spread()`函数正好用于执行这两种转换。`gather()`函数可以将宽格式数据压缩为长格式,而`spread()`函数则相反。

以下是数据长宽转换的示例代码:

```r

# 宽格式数据框

df_wide <- data.frame(

id = 1:3,

x = c(10, 20, 30),

y = c(1, 2, 3)

)

# 使用gather()转换为长格式

df_long <- df_wide %>%

gather(key = "variable", value = "value", -id)

# 使用spread()转换回宽格式

df_wide_converted <- df_long %>%

spread(key = variable, value = value)

```

### 2.3.2 分组与汇总操作

在数据分析中,常常需要根据某一个或几个变量对数据进行分组,并对每一组执行汇总操作。`tidyr`和`dplyr`包提供了`group_by()`和`summarise()`函数来实现这一需求。

以下是一个分组与汇总操作的示例代码:

```r

# 创建一个数据框

df <- data.frame(

group = c('A', 'A', 'B', 'B'),

value = c(1, 2, 3, 4)

)

# 使用group_by()和summarise()函数进行分组汇总

result <- df %>%

group_by(group) %>%

summarise(sum_value = sum(value))

```

## 2.4 数据扩展与合并

### 2.4.1 数据列的展开与合并

数据的展开(expansion)和合并是数据整理中常用的两种操作。`tidyr`中的`separate()`和`unite()`函数可用于扩展单列至多个列,或者将多个列合并成一个列。

以下是一个列展开与合并的示例代码:

```r

# 创建一个包含多个变量的数据框

df <- data.frame(

id = 1:3,

var1 = c("a", "b", "c"),

var2 = c("d", "e", "f")

)

# 使用separate()将var1和var2合并为一个变量

df_expanded <- df %>%

unite(col = "var_combined", var1, var2, sep = "")

# 使用separate()将var_combined分列为var1和var2

df_separated <- df_expanded %>%

separate(col = var_combined, into = c("var1", "var2"), sep = "")

```

### 2.4.2 使用tidyr进行数据连接

数据连接(merging)是将两个数据集按照某些共同的键值连接起来的过程。`tidyr`提供了`crossing()`、`nesting()`和`full_join()`等函数来执行不同类型的数据连接操作。

以下是一个使用`tidyr`进行数据连接的示例代码:

```r

# 创建两个数据框

df1 <- data.frame(id = c(1, 2), value1 = c("a", "b"))

df2 <- data.frame(id = c(1, 2), value2 = c("c", "d"))

# 使用full_join()连接两个数据框

df_joined <- full_join(df1, df2, by = "id")

```

在本章节中,我们详细介绍了`tidyr`包在数据整理中的基础理论,包括数据整洁的概念,以及如何使用`tidyr`进行数据清洗、变换和连接操作。通过具体的示例代码和逻辑分析,我们展示了`tidyr`的强大功能和易用性。在下一章节中,我们将深入探讨`tidyr`在实践中的应用案例,帮助读者更好地理解如何将这些理论应用到实际问题中。

# 3. ```markdown

# 第三章:tidyr包在实践中的应用案例

tidyr包是R语言中处理数据集的一款工具包,它提供了一系列函数用于数据的整洁化,旨在将数据整理为易于分析的格式。本章将结合具体实践案例,向读者展示如何应用tidyr包处理数据集,并重点介绍如何解决实际问题。

## 公共数据集的处理流程

公共数据集是数据科学实践中常见的数据来源。它们通常包含了大量的信息,但也可能存在许多问题,如不一致的数据格式、缺失值等,这些都需要我们在使用前进行处理。

### 数据的导入与初步探索

在进行数据整理之前,首先要导入数据集。在R语言中,可以使用`read.csv`、`read.table`等函数导入CSV或文本文件数据,而`readxl`包则可以导入Excel文件数据。导入后,我们通常使用`str`、`summary`等函数进行初步的数据探索,以了解数据的基本情况。

```r

library(readxl)

# 导入Excel文件

data <- read_excel("data.xlsx")

str(data) # 查看数据结构

summary(data) # 数据概览

```

### 应用tidyr进行数据清洗

一旦我们对数据有了初步了解,接下来就可以利用tidyr包中的函数进行清洗。例如,`gather`函数可以将宽格式数据转换为长格式,`spread`函数则执行相反的操作。此外,`separate`函数可将一列分割为多列,`unite`函数则相反。

```r

library(tidyr)

# 使用gather函数将宽格式数据转换为长格式

long_data <- gather(data, key = "variable", value = "value", -id_column)

# 使用separate函数拆分列

split_data <- separate(long_data, col = variable, into = c("measure", "time"), sep = "_")

```

通过上述步骤,我们可以开始着手处理数据集中的问题,如识别和处理缺失值或异常值。

## 研究数据的整理技巧

研究数据往往需要更高的精确度和清洁度。在整理研究数据时,需要关注数据的标准化和归一化,以及处理复杂数据结构的方法。

### 数据的标准化和归一化

数据的标准化和归一化是保证数据分析结果一致性和准确性的关键技术。标准化是指将数据按比例缩放,使之落入一个小的特定区间,常用的方法包括z-score标准化。归一化是指将数据缩放到[0, 1]区间。

```r

# 标准化示例

data$standardized <- scale(data$variable)

# 归一化示例

data$normalized <- (data$variable - min(data$variable)) / (max(data$variable) - min(data$variable))

```

### 复杂数据结构的处理

研究数据集可能包含嵌套数据或多层次结构,需要特别的处理技巧。tidyr包提供了`nest`和`unnest`函数来处理嵌套数据,而`separate_rows`函数可以将某一列中的多个值分开成多行。

```r

# 嵌套数据处理示例

nested_data <- data %>% nest(-group_id_column)

# 分开列中多值示例

separated_rows <- separate_rows(data, column_with_multiple_values, sep = ",")

```

## 实际案例分析

本节将通过两个具体案例来展示tidyr包在不同数据科学领域的应用。

### 社会科学数据处理

在社会科学数据分析中,处理调查问卷数据是常见任务。tidyr包可以有效地帮助我们整合问卷数据,并清洗掉不完整或不一致的响应。

```r

# 整合问卷数据示例

survey_data <- gather(survey_raw_data, key = "question_id", value = "response", -respondent_id)

cleaned_data <- survey_data %>% filter(!is.na(response))

```

### 生物统计学数据处理

生物统计学数据往往涉及大量的测量值和复杂的实验设计。在这一领域,使用tidyr包可以方便地进行数据重塑和准备分析所需的长格式数据。

```r

# 生物统计数据处理示例

biostat_data <- spread(experimental_data, key = "treatment", value = "measurement")

```

在上述案例中,我们通过具体的应用场景向读者介绍了tidyr包在数据整理中的强大功能。tidyr不仅能够简化数据处理流程,还能够帮助我们在面对各种复杂数据结构时保持清晰的处理逻辑。

通过本章节的介绍,我们看到,tidyr包在数据整理和清洗方面提供了灵活且强大的工具。这些工具不仅提高了数据整理的效率,还优化了数据分析的质量。下一章节,我们将深入探讨tidyr包与R语言的高级应用技巧,以及在大数据环境下的应用。

```

在上述内容中,我们按照章节结构层次使用Markdown格式编写了第三章的内容,其中包括了公共数据集的处理流程、研究数据的整理技巧、以及实际案例分析三个二级章节。每个二级章节下面又细分了相关的子章节内容,用以详细介绍特定的实践案例和技术要点。按照规定,代码块及其相关的逻辑分析和参数说明也被详细提供。

# 4. ```

# 四、R语言与tidyr的高级应用技巧

## 4.1 高级数据清洗技术

数据清洗是数据处理中最基础也是最重要的环节之一。在这一部分,我们将深入探讨高级数据清洗技术,包括复杂缺失值处理案例以及条件清洗的策略。

### 4.1.1 复杂缺失值处理案例

处理复杂缺失值时,需要采用更精细的策略来决定哪些行或列应该保留,哪些应该删除。一个经典的问题是缺失值的不规则性——即数据集中不同变量的缺失模式不一致。考虑以下示例数据:

```R

library(tidyr)

library(dplyr)

# 创建一个复杂缺失值的示例数据框

example_data <- data.frame(

id = 1:6,

age = c(25, NA, 28, NA, NA, 30),

income = c(NA, 50000, NA, 45000, 55000, NA),

score = c(88, NA, 95, NA, NA, 92)

)

```

在这样的数据集中,如果简单地删除任何含有NA的行或列,可能会丢失大量有用信息。在R中,我们可以利用`tidyr`包提供的`drop_na()`函数来处理这种情况,例如删除那些在特定列(如“age”和“income”)都含有缺失值的行:

```R

# 删除age和income都有缺失的行

cleaned_data <- example_data %>%

drop_na(age, income)

```

### 4.1.2 条件清洗的策略

有时候,我们希望根据数据的特定条件进行清洗。例如,我们可能想要保留那些“score”大于90的行。`filter()`函数在`dplyr`包中可以实现这一点,但它也可以与`tidyr`配合使用,如下面的示例所示:

```R

# 根据条件保留数据行

conditional_cleaning <- example_data %>%

filter(score > 90)

```

这样的条件清洗使我们能够从数据集中筛选出符合特定要求的记录。在进行条件清洗时,需要明确哪些条件是合理且有助于后续分析的。

## 4.2 数据整合与报告生成

数据整合与报告生成是数据分析流程中的关键步骤,它们不仅要求数据处理者具备对数据结构的深入理解,还需要能够有效地展现分析结果。

### 4.2.1 使用tidyr进行数据整合

数据整合的目标是将来自不同来源的数据合并成一个有意义的数据集。`tidyr`提供了几个函数来帮助完成这一任务,例如`pivot_longer()`和`pivot_wider()`,它们使得数据从宽格式到长格式、从长格式到宽格式的转换变得简单。

```R

# 将数据转换为长格式

long_format <- example_data %>%

pivot_longer(cols = -id, names_to = "variable", values_to = "value")

```

### 4.2.2 利用R Markdown生成报告

报告生成涉及到将分析结果以文本、代码和图表的形式组织起来。R Markdown是一个强大的工具,能够将R代码、其输出以及文本注释混合在一起形成报告。R Markdown文档通常具有`.Rmd`扩展名,它们可以在R中使用`knitr`包进行编译,生成HTML、PDF或Word文档。

```markdown

title: "数据分析报告"

output: html_document

# 数据分析概述

这里是报告的开头部分,可以介绍分析的目的和背景。

```{r echo=FALSE}

library(ggplot2)

data(mtcars)

ggplot(mtcars, aes(mpg)) + geom_histogram(binwidth = 2)

```

上面的代码块展示了如何使用`ggplot2`包制作直方图,并将其嵌入到报告中。

```

## 4.3 性能优化与内存管理

随着数据集规模的增长,性能优化和内存管理成为数据分析中不能忽视的方面。R语言虽然在内存管理上有一些局限性,但通过一些技巧和工具,我们依然能够有效地提升性能。

### 4.3.1 R语言的性能分析工具

R语言提供了多种性能分析工具,如`Rprof()`,它可以追踪函数调用并记录性能数据。通过分析这些数据,我们可以确定那些消耗资源最多的函数。

```R

# 启动性能分析

Rprof("performance.out")

# 运行一些耗时的操作

for (i in 1:1000) {

mean(rnorm(1000))

}

# 停止性能分析

Rprof(NULL)

# 读取性能分析数据

summaryRprof("performance.out")

```

### 4.3.2 优化内存使用的方法

为了优化内存使用,我们可以采取一些策略,比如在不必要时避免复制数据、使用更高效的数据结构(如`data.table`)、定期清理不再使用的对象等。另外,使用`pryr`包中的`object_size()`函数可以帮助我们了解对象的内存大小:

```R

library(pryr)

# 计算某个对象占用的内存大小

object_size(example_data)

```

在处理大规模数据集时,通过合理利用R的这些工具和方法,我们可以显著提高数据处理的效率。

```

# 5. R语言与tidyr在大数据环境下的应用

随着数据量的增长,大数据环境下的数据整理变得日益重要。本章将探讨在大数据背景下,R语言与tidyr包如何应对挑战并发挥其作用。

## 5.1 大数据的挑战与机遇

在大数据的背景下,数据整理的需求发生了显著变化。数据量的剧增带来了处理速度和效率上的挑战,同时也为数据分析带来了新的机遇。

### 5.1.1 大数据背景下的数据整理需求

大数据通常具有“4V”特点,即大量的Volume、高速的Velocity、多样的Variety和真实性的Veracity。这些特点对数据整理工具和方法提出了更高的要求。例如,数据清洗不仅要处理缺失值和异常值,还要考虑数据类型转换和数据一致性。数据整合时,需要考虑数据的关联性与融合方式。

### 5.1.2 R语言在大数据处理中的角色

R语言虽然是为统计分析设计的,但其在大数据处理方面也有独特优势。R的tidyr包和其他数据处理包(如dplyr、data.table)可以有效地处理大规模数据集。借助于R的并行计算能力(如使用parallel包),R语言可以在多核处理器上进行高效数据处理。此外,R语言支持多种数据库的连接,方便与大数据环境集成。

## 5.2 使用tidyr处理大规模数据集

处理大规模数据集要求数据处理工具不仅能够处理大量数据,还要保证处理速度和效率。

### 5.2.1 高效数据处理的策略

为了提高数据处理的效率,可以采取以下策略:

- **使用data.table包**:data.table是R中用于处理大型数据集的包,它提供了比基础R和dplyr更高效的内存管理。

- **分块处理数据**:通过将大文件分成多个小块进行逐块处理,可以减少内存消耗。

- **优化数据类型**:根据数据的实际范围和类型,适当调整数据类型(如将字符型转为因子型)以减少内存占用。

### 5.2.2 并行计算与大数据

并行计算是提高大数据处理效率的关键技术之一。R语言可以通过多种方式实现并行计算:

- **使用parallel包**:parallel包提供了简单的并行计算框架,能够创建多个核心的处理能力。

- **利用其他并行工具**:像foreach和doParallel这样的包可以在循环中实现并行计算。

- **整合Hadoop和Spark**:通过RHadoop或SparkR等包,R语言还可以与Hadoop和Spark集成,进行大规模数据的分布式计算。

## 5.3 实际案例研究

通过分析实际案例,我们可以更好地理解R语言与tidyr在处理大数据时的应用。

### 5.3.1 在线分析处理(OLAP)与tidyr

OLAP操作通常需要对大量数据进行多维分析。使用tidyr和dplyr包可以方便地实现数据的重塑和聚合:

```r

library(tidyr)

library(dplyr)

# 假设df是一个大规模数据框,包含了多种度量和维度信息

# 使用pivot_longer和pivot_wider进行数据的长宽转换

df_long <- pivot_longer(df, cols = -c(dim1, dim2), names_to = "measure", values_to = "value")

df_wide <- pivot_wider(df_long, names_from = "measure", values_from = "value")

```

### 5.3.2 大数据可视化与R语言

大数据可视化在理解数据模式和趋势方面起着至关重要的作用。使用ggplot2包,R语言能够创建复杂且信息丰富的图表:

```r

library(ggplot2)

# 创建一个散点图,展示某些度量随时间的变化

ggplot(df_wide, aes(x = time, y = value, color = dim1)) +

geom_point() +

facet_wrap(~measure) +

theme_minimal()

```

以上案例展示了如何利用R语言和tidyr包处理大规模数据集,并通过可视化手段分析数据。在大数据的挑战下,R语言和tidyr包证明了它们在数据整理和分析中的强大能力。

0

0