【数据完整性验证与修复手册】:Hadoop如何识别并修复损坏数据块

发布时间: 2024-10-28 15:17:38 阅读量: 73 订阅数: 27

# 1. Hadoop数据完整性基础

在现代数据存储领域,Hadoop作为大数据处理的领军者,其数据完整性的保障显得尤为重要。本章将深入探讨Hadoop数据完整性的基础概念,为读者建立一个坚实的理解基础。

## 1.1 数据完整性的定义

数据完整性是指数据在存储、传输、处理过程中保持原始状态的准确性和一致性。在Hadoop生态系统中,数据完整性不仅影响计算结果的正确性,还直接关联到系统稳定运行和数据安全。

## 1.2 Hadoop数据完整性的必要性

由于Hadoop支持分布式存储大量数据,数据可能因硬件故障、网络问题或其他意外情况而损坏。确保数据完整性是Hadoop系统可靠性的关键,也对用户信任和数据价值维护至关重要。

## 1.3 数据完整性保障机制概览

Hadoop通过一系列机制来维护数据完整性,包括数据冗余(多副本)、心跳机制、校验和检查和故障检测与自动恢复。在后续章节中,我们将详细分析这些机制的工作原理和应用实践。

在本章的最后,我们已经对数据完整性的概念以及其在Hadoop生态系统中的重要性有了基本的了解。在接下来的章节中,我们将逐步深入了解如何识别和修复Hadoop中的数据损坏,以及如何通过高级应用和最佳实践来保证数据的完整性。

# 2. Hadoop数据块损坏的识别机制

### 2.1 Hadoop数据块损坏的理论基础

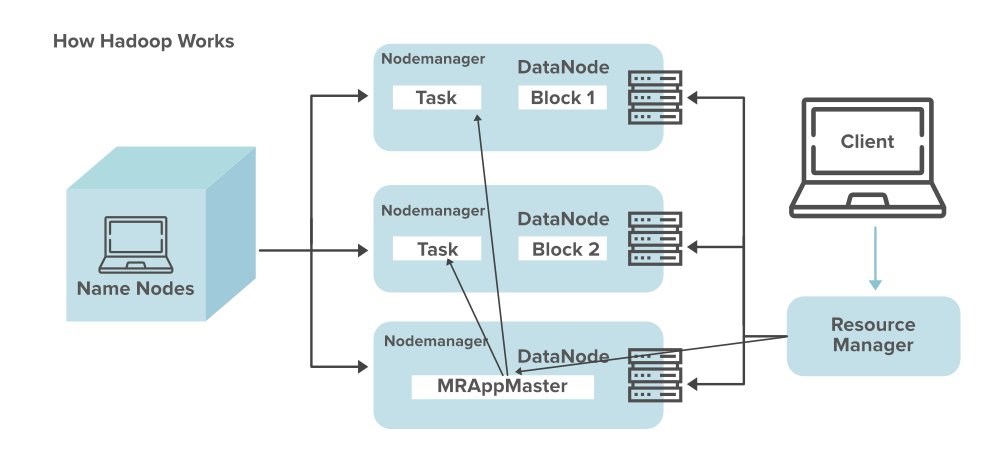

Hadoop作为大数据处理领域的主要技术之一,其分布式文件系统HDFS的设计确保了对数据的高效管理以及容错性。HDFS通过将大文件分割成固定大小的数据块(block)进行存储,以适应大规模数据的存储和处理。然而,数据块损坏是Hadoop集群中不可忽视的问题,它会影响数据的完整性和计算的准确性。

#### 2.1.1 Hadoop数据块的存储结构

在HDFS中,每个文件被分成一个或多个数据块,这些数据块默认大小为128MB(在Hadoop 2.x版本以前),而在Hadoop 2.x及以后的版本中,这个默认值可被配置。每个数据块被复制到多个DataNode上,以保证即使部分节点故障,数据依然可用。

数据块的存储结构设计上,除了数据本身,还包括元数据(metadata),即描述数据的信息。这些信息包括数据块的大小、复制因子、存储位置等。通过这些元数据,HDFS可以快速定位和管理数据块。

#### 2.1.2 数据块损坏的类型与特征

数据块损坏主要分为几种类型,包括物理损坏、逻辑损坏和元数据损坏。物理损坏指的是存储介质上的实际损坏,如硬盘故障导致数据无法读取。逻辑损坏是指数据块的内容被意外改变或损坏,但存储介质本身未受到损害。元数据损坏则是描述数据块的元数据信息出现错误,导致数据块无法被正确访问或识别。

识别这些损坏类型对Hadoop集群的稳定性和数据的安全性至关重要。接下来,将深入探讨Hadoop如何识别数据块损坏,并采取相应的措施。

### 2.2 Hadoop数据块损坏的识别技术

为了确保数据的完整性,Hadoop采用了一系列技术来识别潜在的数据块损坏。

#### 2.2.1 HDFS心跳机制与数据块健康检查

心跳机制是Hadoop集群健康状态检测的核心。每个DataNode周期性地向NameNode发送心跳信号,表明自己处于活动状态。这个过程中,DataNode也会报告它存储的数据块的状态,以及是否发现了数据损坏的情况。

心跳机制结合数据块健康检查,定期检测数据块的完整性。如果检测到数据块损坏,DataNode将立即报告给NameNode,并进行相应的数据块复制操作来恢复数据。

#### 2.2.2 数据完整性校验算法的应用

HDFS使用校验和(checksum)来维护数据块的完整性。每当数据写入HDFS时,HDFS会计算数据块的校验和,并将校验和与数据块一起存储。读取数据时,系统会重新计算校验和,并与存储的校验和进行对比,以确认数据块是否在写入后被修改。

```java

// Java示例代码:计算数据块的校验和

import java.util.zip.Checksum;

public class BlockChecksum {

public static void main(String[] args) {

Checksum checksum = java.util.zip.CRC32::new;

// 假设这是数据块的内容

byte[] blockData = "sample data block".getBytes();

// 计算校验和

checksum.update(blockData, 0, blockData.length);

long checksumVal = checksum.getValue();

// 输出校验和值

System.out.println("Checksum value: " + checksumVal);

}

}

```

在上面的Java代码示例中,我们创建了一个`Checksum`对象来计算字符串数据的校验和。实际应用中,数据块数据会以字节流的形式输入。

#### 2.2.3 副本机制在数据损坏识别中的作用

Hadoop通过创建数据块的多个副本确保了数据的高可用性。默认情况下,每个数据块都有三个副本(包括原始副本和两个副副本),存储在不同的DataNode上。当检测到数据块损坏时,系统会选择另一个副本来进行数据修复。

副本机制不仅可以用于数据损坏的检测和修复,还可以进行负载均衡,减少数据访问的瓶颈。然而,副本管理也引入了额外的存储开销和管理复杂性。因此,Hadoop提供了配置选项以满足不同场景下对数据块副本数量的需求。

### 2.3 Hadoop数据损坏的监控与告警

为了及时发现和响应数据块损坏的情况,Hadoop提供了多种监控和告警机制,以保障数据的安全和集群的健康。

#### 2.3.1 Hadoop集群监控工具的介绍

Hadoop生态系统中包含许多监控工具,比如Ambari、Ganglia、Nagios等。这些工具提供了集群状态、数据块健康和节点可用性的实时视图。

例如,Ambari提供了一个Web界面来监控Hadoop集群的健康状态,它可以显示节点状态、资源使用情况、服务健康状况等信息。当检测到数据块损坏时,Ambari可以发出警告,并提供进一步的诊断信息。

#### 2.3.2 数据损坏告警机制的实现

告警机制通常是与监控工具配合工作的,以实现实时警报。告警可以配置为通过邮件、短信或者应用程序推送的方式发送给集群管理员。

告警机制的实现依赖于事件触发器,当监控工具检测到数据块损坏或其他潜在问题时,触发器会被激活,并执行预设的操作,如发送告警通知。

通过深入理解Hadoop数据块损坏的识别机制,IT专业人员可以更好地维护数据完整性,保障集群的稳定性。接下来,我们将讨论如何修复Hadoop中已经识别出的数据损坏问题。

# 3. Hadoop数据损坏的修复策略

## 3.1 自动修复机制的原理与实践

### 3.1.1 自动数据块复制与恢复流程

在Hadoop集群中,自动修复机制是保证数据完整性的关键组成部分。这一机制确保了当检测到数据块损坏时,系统能自动触发复制和恢复流程,以最小化数据丢失风险。自动修复的数据块复制与恢复流程通常包括以下几个步骤:

1. **故障检测**:Hadoop通过心跳机制检测DataNode是否正常工作。当一个DataNode无法发送心跳信息时,NameNode将其标记为宕机。

2. **数据块状态检查**:对于疑似宕机的DataNode上的数据块,系统会通过其他DataNode上的副本进行数据块状态的检查。

3. **数据复制**:如果发现数据块损坏,NameNode会启动复制流程,将数据块从健康的副本复制到其他DataNode上,确保数据块有三个以上的有效副本。

4. **数据块更新**:在复制完成后,NameNode会更新文件系统的元数据,将损坏的数据块标记为无效,以避免数据读取错误。

下面是一个简单的代码示例,展示如何使用Hadoop的shell命令查看文件的健康状态:

```shell

hdfs fsck / -files -blocks -locations

```

**参数说明**:

- `/`:指定要检查的文件系统路径。

- `-files`:显示文件的健康状态。

- `-blocks`:显示数据块的详细信息。

- `-locations`:显示数据块的位置。

**逻辑分析**:

此命令会输出HDFS上所有文件的健康状态,包括哪些文件或数据块存在问题,以及它们的位置信息。通过这个命令,管理员可以快速定位到需要进行修复的数据块,并根据输出信息采取相应的修复措施。

### 3.1.2 多副本数据块的校验与同步

在

0

0