经济学需求预测:线性回归模型的权威指南

发布时间: 2024-11-20 06:50:45 阅读量: 42 订阅数: 29

电力需求预测:用于预测需求的线性回归模型

# 1. 线性回归模型的基础概念

在统计学和数据科学领域,线性回归是一种广泛使用的预测建模技术。它旨在分析两个或多个变量之间的关系,其中一个变量被视为因变量,而其他变量被视为自变量。线性回归模型特别关注如何在保持其他变量不变的情况下,用一个或多个自变量来预测因变量的值。

线性回归模型的基础概念包括了解“线性”的含义,即模型的预测结果与输入变量之间存在线性关系。直观来看,可以通过一条直线最好地描述这种关系。尽管在线性回归模型中只使用直线来描述数据关系,但它实际上能够处理各种形式的数据。这是因为多项式关系可以通过特征转换变成线性关系。

学习线性回归模型时,理解其基础概念是第一步。我们将会深入探讨线性回归模型的定义、假设条件以及其在实际数据分析中的重要性和应用。通过掌握这些基础知识,我们能够为后续深入学习线性回归模型的理论基础和实践应用打下坚实的基础。

# 2. 线性回归模型的理论基础

线性回归是统计学中一种非常重要的模型,它可以帮助我们理解一个变量是如何随其他变量的变化而变化的。在这一章节中,我们将深入探讨线性回归模型的理论基础,包括其基本原理、参数估计方法以及模型检验方式。

### 2.1 线性回归模型的基本原理

#### 2.1.1 线性回归模型的定义

线性回归模型是研究一个或多个自变量与因变量之间线性关系的统计模型。它假定因变量与自变量之间存在线性关系,即因变量可以通过自变量的线性组合加上一个误差项来预测。

在形式上,简单线性回归模型可以表示为:

\[ Y = \beta_0 + \beta_1X + \epsilon \]

其中,\(Y\) 是因变量,\(X\) 是自变量,\(\beta_0\) 是截距项,\(\beta_1\) 是斜率,而 \(\epsilon\) 表示误差项,通常假设为独立同分布的随机变量。

#### 2.1.2 线性回归模型的假设条件

线性回归模型的准确性高度依赖于其基本假设条件。这些假设包括:

- 线性关系:自变量和因变量之间存在线性关系。

- 误差项的独立性:各个观测值的误差项之间相互独立。

- 误差项的正态性:误差项服从均值为0的正态分布。

- 同方差性:不同观测值的误差项具有相同的方差。

- 自变量的非随机性:自变量 \(X\) 是固定且非随机的。

### 2.2 线性回归模型的参数估计

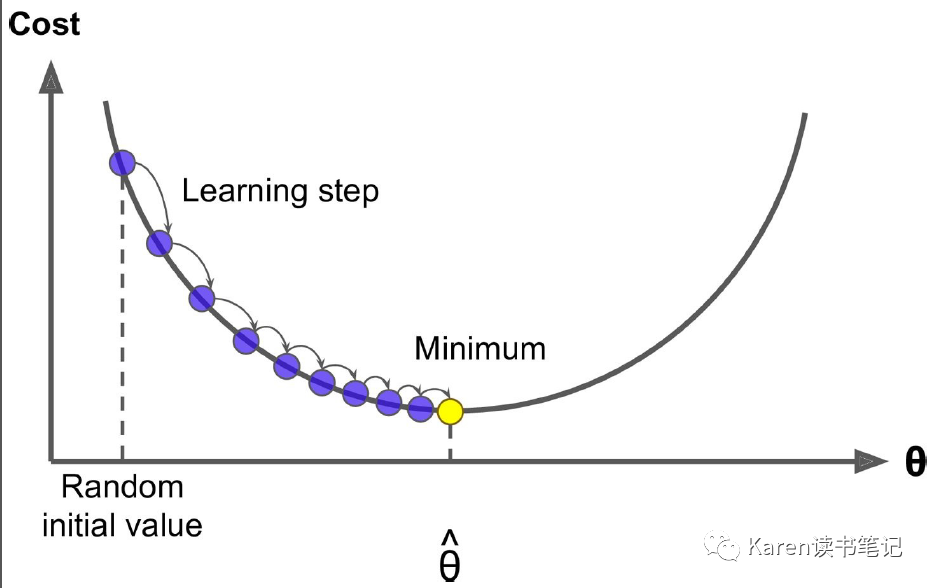

#### 2.2.1 最小二乘法的基本原理

最小二乘法是一种常用于回归分析的参数估计方法。它的目标是最小化因变量的实际观测值与模型预测值之差(残差)的平方和。

公式可以表示为:

\[ \text{最小化} \sum_{i=1}^{n} (Y_i - (\beta_0 + \beta_1X_i))^2 \]

其中,\(Y_i\) 是第 \(i\) 个观测值,\(X_i\) 是对应的自变量值,\(n\) 是观测值的总数。

#### 2.2.2 参数估计的数学推导

为了找到最小化残差平方和的 \(\beta_0\) 和 \(\beta_1\),我们通常采用求导数并令导数为0的方法。

对于 \(\beta_0\) 和 \(\beta_1\) 的估计值 \(\hat{\beta_0}\) 和 \(\hat{\beta_1}\),可以通过下面的正规方程(Normal Equations)得到:

\[ \hat{\beta_1} = \frac{\sum_{i=1}^{n}(X_i - \bar{X})(Y_i - \bar{Y})}{\sum_{i=1}^{n}(X_i - \bar{X})^2} \]

\[ \hat{\beta_0} = \bar{Y} - \hat{\beta_1}\bar{X} \]

其中,\(\bar{X}\) 和 \(\bar{Y}\) 分别是 \(X\) 和 \(Y\) 的样本均值。

#### 2.2.3 参数估计的实际应用

在实际应用中,通常会使用统计软件来进行最小二乘法的参数估计。例如,在Python中,我们可以使用`scikit-learn`库中的`LinearRegression`模型来实现这一过程。

### 2.3 线性回归模型的检验

#### 2.3.1 模型的整体检验

模型的整体检验包括确定模型对数据的拟合程度。最常用的指标是决定系数(\(R^2\)),它衡量了模型解释变异的比例。

\[ R^2 = 1 - \frac{\sum_{i=1}^{n}(Y_i - \hat{Y}_i)^2}{\sum_{i=1}^{n}(Y_i - \bar{Y})^2} \]

其中,\(\hat{Y}_i\) 是第 \(i\) 个观测值的预测值。

#### 2.3.2 参数的显著性检验

参数的显著性检验用于检验模型参数是否具有统计学上的显著性。通常使用t检验来检验单个参数的显著性,而F检验则用于检验整个模型的显著性。

t检验的统计量可以表示为:

\[ t = \frac{\hat{\beta_1}}{SE(\hat{\beta_1})} \]

其中,\(SE(\hat{\beta_1})\) 是 \(\hat{\beta_1}\) 的标准误差。

### 总结

在本章节中,我们深入探讨了线性回归模型的理论基础,从模型定义到参数估计,再到模型检验,形成了对线性回归模型基本原理的全面理解。为了进一步加深理解,我们可以在实际数据集上进行操作,应用最小二乘法和检验方法来实现线性回归模型,并通过实际案例分析来掌握模型的应用场景。接下来的章节中,我们将介绍如何在不同的编程语言中实现线性回归模型,并探讨线性回归在实际应用中的案例。

# 3. 线性回归模型的实践应用

## 3.1 线性回归模型的实现

### 3.1.1 使用Python实现线性回归模型

在实际应用中,Python已成为数据分析和机器学习的首选语言之一,这得益于其强大的科学计算库,如NumPy、Pandas以及绘图库Matplotlib,还有专门用于统计分析和机器学习的库如SciPy和scikit-learn。下面展示如何使用Python结合这些库来实现一个基本的线性回归模型。

首先,需要导入必要的库:

```python

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

```

为了演示,我们创建一个简单的数据集,包含一些自变量(X)和因变量(y):

```python

# 生成模拟数据

np.random.seed(0)

X = 2 * np.random.rand(100, 1)

y = 4 + 3 * X + np.random.randn(100, 1)

```

接下来,分割数据集为训练集和测试集:

```python

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=0)

```

创建线性回归模型,并拟合训练数据:

```python

model = LinearRegression()

model.fit(X_train, y_train)

```

模型已经训练完毕,我们可以查看模型的参数:

```python

print(f"Coefficient: {model.coef_}")

print(f"Intercept: {model.intercept_}")

```

为了评估模型性能,我们可以预测测试集的结果,并计算预测值和真实值之间的均方误差(MSE):

```python

y_pred = model.predict(X_test)

mse = np.mean((y_test - y_pred) ** 2)

print(f"Mean Squared Error: {mse}")

```

最后,我们可以将模型的预测结果绘制出来,与真实数据进行对比:

```python

plt.scatter(X_test, y_test, color='blue', label='Actual')

plt.plot(X_test, y_pred, color='red', label='Predicted')

plt.title('Linear Regression Model')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.show()

```

通过上述步骤,我们不仅完成了线性回归模型的实现,而且对模型的预测性能进行了初步评估。

### 3.1.2 使用R语言实现线性回归模型

R语言在统计分析领域同样具有举足轻重的地位,其丰富的统计包和图形包使得数据分析工作变得更加简便。接下来,演示如何使用R语言实现线性回归模型。

首先,创建一个模拟数据集:

```R

set.seed(0)

X <- matrix(rnorm(100 * 1), ncol = 1)

y <- 4 + 3 * X + rnorm(100)

```

使用`lm`函数拟合线性模型:

```R

model <- lm(y ~ X)

```

查看模型摘要,了解参数估计值:

```R

summary(model)

```

通过模型摘要,我们不仅可以看到斜率和截距,还可以进行显著性检验。

预测测试集的值:

```R

X_test <- matrix(rnorm(20 * 1), ncol = 1)

y_pred <- predict(model, X_test)

```

绘制实际值与预测值的对比图:

```R

plot(X, y, col = "blue", pch = 16, main = "Linear Regression Model")

abline(model, col = "red")

points(X_test, y_pred, col = "green", pch = 16)

```

以上步骤演示了如何使用R语言简洁地完成线性回归模型的构建和评估。

## 3.2 线性回归模型的应用实例

### 3.2.1 经济学中的需求预测实例

在经济学中,需求预测是关键问题之一,线性回归模型在这一领域得到了广泛的应用。以下是如何应用线性回归模型对某个产品的需求量进行预测的实例。

首先,我们需要收集相关数据,包括产品价格、市场供需、消费者收入水平等变量。为了简化,这里只考虑价格和需求量的关系:

```python

price = np.array([10, 15, 20, 25, 30, 35])

demand = np.array([300, 280, 250, 220, 180, 150])

```

我们使用线性回归来分析价格对需求量的影响:

```python

from sklearn.linear_model import LinearRegression

import matplotlib.pyplot as plt

# 创建数据点

points = np.array([price, demand]).T

points = points.reshape(-1, 1)

# 拟合模型

model = LinearRegression()

model.fit(points, price)

print(f"Intercept: {model.intercept_}")

print(f"Coefficient: {model.coef_}")

# 绘制散点图和线性回归拟合线

plt.scatter(price, demand, color="blue")

plt.plot(price, model.predict(points), color="red")

plt.xlabel('Price')

plt.ylabel('Demand')

plt.title('Demand Forecasting')

plt.show()

```

通过这个例子,我们可以看到价格与需求量之

0

0