HDFS读写过程中数据一致性问题的分析与对策:专家级解决方案

发布时间: 2024-10-25 19:08:39 阅读量: 56 订阅数: 34

大数据开发:HDFS数据节点与名称节点的通信机制.docx

# 1. HDFS数据一致性问题概述

在分布式存储系统中,数据一致性问题是一个核心议题。特别是对于Hadoop分布式文件系统(HDFS),数据的一致性是其设计和优化的关键目标之一。本章节将对HDFS数据一致性问题进行简单概述,为读者提供一个了解HDFS在处理数据时可能出现的一致性挑战和解决策略的起点。

## 1.1 数据一致性的定义与重要性

数据一致性指的是存储系统中数据的一致状态,确保所有数据副本在任何时候都保持同步。对于HDFS来说,由于其在分布式环境中运行,节点故障、网络分区等因素均可能导致数据一致性问题。数据一致性对于保证数据分析的准确性和可靠性至关重要,因此,HDFS设计了多种机制来应对这些挑战。

## 1.2 HDFS数据不一致性的常见表现

在HDFS中,数据不一致性可能导致诸如读取过时数据、数据损坏、或写入操作失败等问题。这些情况会直接影响到数据处理的正确性和整个系统的稳定性。为了解决这些问题,HDFS采取了包括数据复制、心跳检测、数据校验等多种机制,以确保数据状态的一致性。

## 1.3 本章小结

本章介绍了数据一致性在HDFS中的重要性及常见的不一致性问题。读者应理解数据一致性对于分布式系统的重要性,并对其在HDFS中的基本表现有所了解。接下来,第二章将深入探讨HDFS的数据存储机制和一致性模型,以帮助读者更好地理解HDFS是如何解决数据一致性的。

# 2. HDFS的数据存储机制和一致性模型

Hadoop Distributed File System (HDFS) 是一种高度容错性的系统,适合在廉价硬件上运行。HDFS 提供了高吞吐量的数据访问,非常适合大规模数据集的应用。在深入探讨 HDFS 数据一致性问题之前,我们首先需要了解 HDFS 的基本架构和数据存储机制,以及它的一致性模型。

## 2.1 HDFS的基本架构和组件

HDFS 采用主/从(Master/Slave)架构。主要由两类节点组成:NameNode 和 DataNode。NameNode 负责管理文件系统的元数据,而 DataNode 则负责管理存储在节点上的实际数据。

### 2.1.1 NameNode与DataNode的角色和功能

#### NameNode

NameNode 是 HDFS 的核心,它维护了文件系统的命名空间,记录了每个文件中各个块所在的 DataNode 节点信息。为了支持高可用性,HDFS 可以配置多个 NameNode,通过主备机制提供故障恢复。NameNode 虽然不会存储实际数据,但会记录所有数据块的元数据,包括文件名、权限、块列表、块位置等。

#### DataNode

DataNode 负责存储和检索数据块,数据块是文件系统中数据的物理存储单位。每个文件被切分成一个或多个块,存储在一组 DataNode 上。DataNode 会定期向 NameNode 发送心跳信号和块报告来注册自身状态,并报告存储的块信息。

```mermaid

flowchart LR

A[NameNode] <--> B[DataNode1]

A <--> C[DataNode2]

A <--> D[DataNode3]

style A fill:#f9f,stroke:#333,stroke-width:2px

style B fill:#ccf,stroke:#333,stroke-width:2px

style C fill:#ccf,stroke:#333,stroke-width:2px

style D fill:#ccf,stroke:#333,stroke-width:2px

```

### 2.1.2 HDFS文件系统的命名空间和数据块

#### 命名空间

HDFS 通过目录树来管理文件系统资源,类似传统的文件系统。每个文件或目录都被视为一个节点。文件系统中的所有文件都由一个称为“命名空间”的树状结构表示。

#### 数据块

HDFS 中的数据以块的形式存储,块的默认大小是 128MB(Hadoop 2.x 中是 64MB)。将文件切分成块有若干好处,包括支持大数据文件的存储、提高系统的容错性、简化数据副本的管理。

## 2.2 HDFS的一致性模型

HDFS 提供了一个以写操作为中心的一致性模型。一旦数据成功写入,HDFS 将保证数据在整个文件系统中保持一致。

### 2.2.1 HDFS数据复制机制

#### 数据复制策略

为了保证数据的可靠性,HDFS 会自动复制每个文件的数据块到多个 DataNode 上。默认情况下,每个数据块会有三个副本,分布在不同的节点上,一个副本为原始节点上的主副本,另外两个为从副本。

```mermaid

flowchart LR

A[客户端] -->|写入数据| B[NameNode]

B -->|分配副本| C[DataNode1]

B -->|分配副本| D[DataNode2]

B -->|分配副本| E[DataNode3]

style A fill:#f9f,stroke:#333,stroke-width:2px

style B fill:#ccf,stroke:#333,stroke-width:2px

style C fill:#ccf,stroke:#333,stroke-width:2px

style D fill:#ccf,stroke:#333,stroke-width:2px

style E fill:#ccf,stroke:#333,stroke-width:2px

```

#### 副本管理

HDFS 会周期性地运行一个称为“心跳检测”和“块报告”的进程,以确保数据块副本的数量和位置符合预期。如果发现副本数不足,HDFS 会自动复制缺失的副本,直到达到预期的副本数。

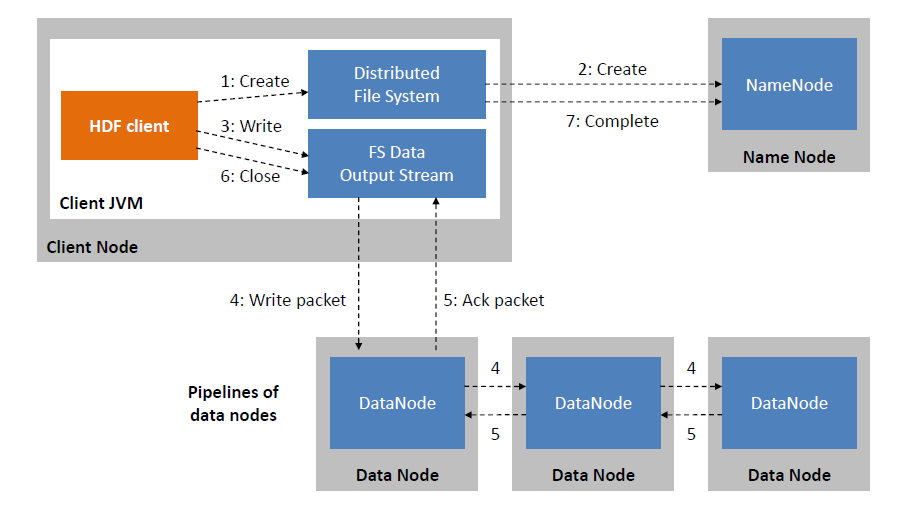

### 2.2.2 HDFS数据写入过程中的数据一致性保证

数据写入 HDFS 是通过一个称为“管道”的机制完成的,客户端会向管道中写入数据到多个 DataNode 上。在写入数据之前,客户端需要从 NameNode 获取数据块的列表以及可以写入的 DataNode 地址。

#### 写入步骤:

1. 客户端连接到 NameNode,请求写入文件。

2. NameNode 返回可写入的 DataNode 列表(即管道)。

3. 客户端将数据推送到管道中的 DataNode。

4. DataNode 将数据写入本地文件系统,并返回写入成功信号给客户端。

5. 客户端收到所有 DataNode 的成功响应后,告知 NameNode 写入完成。

6. NameNode 更新元数据,将文件状态标记为“已提交”。

#### 数据一致性保证

HDFS 中数据一致性保证的关键在于写入过程中数据的原子性。这意味着在发生故障时,要么写入操作完全成功,要么完全不写入。HDFS 不提供记录级别的原子写入保证,但是通过块级别的原子写入和故障恢复机制来确保数据的最终一致性。

## 2.3 HDFS数据一致性面临的挑战

### 2.3.1 网络分区和节点故障对一致性的影响

HDFS 在设计时采用了高容错性的策略。网络分区或节点故障不会直接导致数据不一致,但会影响系统在故障恢复时数据的一致性状态。

#### 网络分区

在发生网络分区时,HDFS 会尝试保证操作的原子性,但是网络分区可能导致一些节点无法及时收到更新信息。HDFS 通过租约(Lease)机制来解决这个问题,确保在租约有效期内完成写入操作。

#### 节点故障

HDFS 通过心跳和副本机制来应对节点故障。当检测到节点故障时,NameNode 会将该节点上的副本标记为不可用,并启动副本复制来恢复数据副本数。

### 2.3.2 数据读写延迟和并发控制问题

HDFS 的设计目标是优化吞吐量而非低延迟,因此数据的读写延迟可能会较长。同时,HDFS 需要处理并发写入问题,保证数据的一致性。

#### 读写延迟

在 HDFS 中,读写操作的延迟主要来自于网络通信和磁盘I/O。为了提高性能,HDFS 采用了一种流水线的方式来优化写入性能,将数据分块并行写入不同的 DataNode。

#### 并发控制

HDFS 通过租约机制来控制文件的并发写入。Name

0

0