YOLOv8与其他目标检测算法的对比分析

发布时间: 2024-05-01 13:11:46 阅读量: 618 订阅数: 162

# 1. 目标检测算法概述**

目标检测是计算机视觉中一项重要的任务,它旨在识别和定位图像或视频中的目标。目标检测算法通常分为两类:两阶段算法和单阶段算法。两阶段算法,如Faster R-CNN,首先生成目标候选区域,然后对每个候选区域进行分类和回归。单阶段算法,如YOLOv8,直接从输入图像或视频中预测目标的边界框和类别。

# 2. YOLOv8的架构与原理

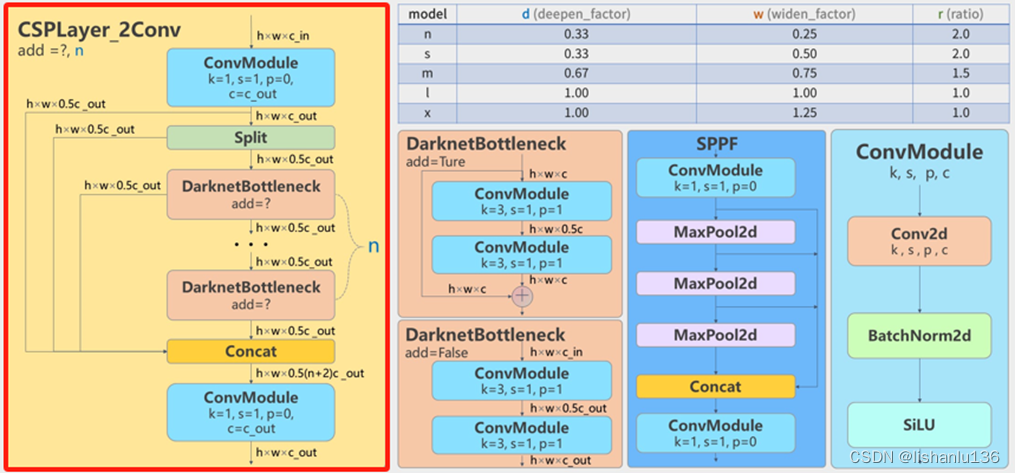

### 2.1 YOLOv8的网络结构

YOLOv8采用了一个深度卷积神经网络(CNN)作为其骨干网络,该网络由以下组件组成:

- **输入层:**接收输入图像,通常为416x416像素。

- **卷积层:**提取图像特征,使用3x3和1x1卷积核。

- **池化层:**通过最大池化或平均池化降低特征图的分辨率。

- **激活函数:**非线性激活函数,如Leaky ReLU或Mish。

- **跳跃连接:**将较低层的特征图与较高层的特征图连接起来,以增强梯度流。

- **Neck网络:**融合来自不同层级的特征图,以获得多尺度特征表示。

- **检测头:**预测边界框和类概率。

YOLOv8的网络结构可以表示为:

```mermaid

graph LR

subgraph Backbone

InputLayer --> ConvLayer1 --> PoolingLayer1 --> ConvLayer2 --> PoolingLayer2 --> ... --> ConvLayerN --> PoolingLayerN

end

subgraph Neck

Backbone --> NeckLayer1 --> NeckLayer2 --> ... --> NeckLayerM

end

subgraph DetectionHead

Neck --> DetectionLayer1 --> DetectionLayer2 --> ... --> DetectionLayerK

end

Backbone --> Neck

Neck --> DetectionHead

```

### 2.2 YOLOv8的训练过程

YOLOv8的训练过程主要包括以下步骤:

1. **数据预处理:**将图像调整为416x416像素,并应用数据增强技术,如随机裁剪、翻转和颜色抖动。

2. **模型初始化:**使用预训练的权重初始化网络。

3. **损失函数:**使用复合损失函数,包括分类损失、边界框损失和置信度损失。

4. **优化器:**使用Adam或SGD优化器。

5. **训练循环:**迭代地更新模型权重,以最小化损失函数。

### 2.3 YOLOv8的推理过程

YOLOv8的推理过程主要包括以下步骤:

1. **输入图像:**接收输入图像,通常为416x416像素。

2. **前向传播:**将图像通过网络,提取特征并预测边界框和类概率。

3. **非极大值抑制(NMS):**去除重叠的边界框,只保留置信度最高的边界框。

4. **后处理:**将预测的边界框和类概率转换为最终的检测结果。

代码块:

```python

import cv2

import numpy as np

# 加载模型

net = cv2.dnn.readNet("yolov8.weights", "yolov8.cfg")

# 预处理图像

image = cv2.imread("image.jpg")

image = cv2.resize(image, (416, 416))

# 前向传播

blob = cv2.dnn.blobFromImage(image, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

net.setInput(blob)

detections = net.forward()

# 后处理

for detection in detections:

# 解析边界框和类概率

confidence = detection[5]

if confidence > 0.5:

x, y, w, h = detection[0:4] * np.array([image.shape[1], image.shape[0], image.shape[1], image.shape[0]])

class_id = np.argmax(detection[5:])

# 绘制边界框

cv2.rectangle(image, (int(x - w / 2), int(y - h / 2)), (int(x + w / 2), int(y + h / 2)), (0, 255, 0), 2)

```

逻辑分析:

- `cv2.dnn.readNet()`:加载YOLOv8模型。

- `cv2.dnn.blobFromImage()`:将图像预处理为模型输入。

- `net.setInput()`:将预处理后的图像设置为模型输入。

- `net.forward()`:执行前向传播,预测边界框和类概率。

- `np.argmax()`:获取类概率中最大值的索引,即类ID。

- `cv2.rectangle()`:在图像上绘制检测到的边界框。

# 3. YOLOv8与其他目标检测算法的对比

### 3.1 与Faster R-CNN的对比

#### 3.1.1 算法架构对比

YOLOv8和Faster R-CNN都是单阶段目标检测算法,但它们的算法架构存在差异。Faster R-CNN采用两阶段检测流程,包括区域提议网络(RPN)和目标分类网络。RPN生成候选区域,然后目标分类网络对这些候选区域进行分类并回归边界框。

相比之下,YOLOv8采用单阶段检测流程,直接将输入图像映射到边界框和类别概率。它使用一个单一的网络来执行目标检测,无需生成候选区域。

| 特征 | YOLOv8 | Faster R-CNN |

|---|---|---|

| 检测流程 | 单阶段 | 两阶段 |

| 候选区域生成 | 无 | RPN |

| 网络结构 | 单一网络 | RPN + 分类网络 |

#### 3.1.2 性能对比

在性能方面,YOLOv8和Faster R-CNN各有优劣。

| 指标 | YOLOv8 | Faster R-CNN |

|---|---|---|

| 检测速度 | 更快 | 更慢 |

| 检测精度 | 稍低 | 更高 |

| 内存占用 | 更小 | 更大 |

YOLOv8的检测速度更快,因为它采用单阶段检测流程,无需生成候选区域。Faster R-CNN的检测精度更高,因为它采用两阶段检测流程,可以对候选区域进行更精细的分类和回归。

### 3.2 与SSD的对比

#### 3.2.1 算法架构对比

YOLOv8和SSD都是单阶段目标检测算法,但它们的算法架构也存在差异。SSD使用多个卷积层和锚框来生成边界框和类别概率。它使用一个单一的网络来执行目标检测,无需生成候选区域。

相比之下,YOLOv8使用一个主干网络和一个检测头来生成边界框和类别概率。主干网络负责提取图像特征,检测头负责对这些特征进行处理并生成检测结果。

| 特征 | YOLOv8 | SSD |

|---|---|---|

| 检测流程 | 单阶段 | 单阶段 |

| 候选区域生成 | 无 | 锚框 |

| 网络结构 | 主干网络 + 检测头 | 多个卷积层 |

#### 3.2.2 性能对比

在性能方面,YOLOv8和SSD也各有优劣。

| 指标 | YOLOv8 | SSD |

|---|---|---|

| 检测速度 | 更快 | 稍慢 |

| 检测精度 | 稍低 | 更高 |

| 内存占用 | 更小 | 更大 |

YOLOv8的检测速度更快,因为它使用一个主干网络和一个检测头,可以更有效地处理图像特征。SSD的检测精度更高,因为它使用多个卷积层和锚框,可以生成更精细的边界框。

# 4. YOLOv8的实践应用

### 4.1 图像目标检测

#### 4.1.1 YOLOv8的部署和使用

**部署步骤:**

1. 安装YOLOv8库。

2. 下载预训练模型。

3. 加载模型并初始化。

4. 预处理输入图像。

5. 执行目标检测。

6. 后处理检测结果。

**代码示例:**

```python

import cv2

import numpy as np

import yolov8

# 加载模型

model = yolov8.load_model("yolov8.pt")

# 加载图像

image = cv2.imread("image.jpg")

# 预处理图像

image = cv2.resize(image, (640, 640))

image = image / 255.0

# 执行目标检测

results = model(image)

# 后处理检测结果

for result in results:

label = result["label"]

confidence = result["confidence"]

bbox = result["bbox"]

cv2.rectangle(image, (bbox[0], bbox[1]), (bbox[2], bbox[3]), (0, 255, 0), 2)

cv2.putText(image, label, (bbox[0], bbox[1] - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 显示检测结果

cv2.imshow("Image", image)

cv2.waitKey(0)

```

#### 4.1.2 目标检测的实际应用

* **安防监控:**实时检测和识别可疑人员或物体,触发警报。

* **医疗影像分析:**辅助医生诊断疾病,如X光片中病变的检测。

* **工业检测:**自动检测生产线上的缺陷产品,提高质量控制效率。

* **自动驾驶:**实时检测行人、车辆和其他障碍物,确保驾驶安全。

### 4.2 视频目标检测

#### 4.2.1 YOLOv8在视频中的部署和使用

**部署步骤:**

1. 安装YOLOv8库。

2. 下载预训练模型。

3. 加载模型并初始化。

4. 打开视频流。

5. 逐帧执行目标检测。

6. 后处理检测结果。

**代码示例:**

```python

import cv2

import numpy as np

import yolov8

# 加载模型

model = yolov8.load_model("yolov8.pt")

# 打开视频流

cap = cv2.VideoCapture("video.mp4")

# 逐帧执行目标检测

while True:

ret, frame = cap.read()

if not ret:

break

# 预处理图像

frame = cv2.resize(frame, (640, 640))

frame = frame / 255.0

# 执行目标检测

results = model(frame)

# 后处理检测结果

for result in results:

label = result["label"]

confidence = result["confidence"]

bbox = result["bbox"]

cv2.rectangle(frame, (bbox[0], bbox[1]), (bbox[2], bbox[3]), (0, 255, 0), 2)

cv2.putText(frame, label, (bbox[0], bbox[1] - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 显示检测结果

cv2.imshow("Frame", frame)

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# 释放视频流

cap.release()

cv2.destroyAllWindows()

```

#### 4.2.2 视频目标检测的实际应用

* **视频监控:**实时检测和识别视频中的可疑人员或物体,触发警报。

* **运动分析:**分析运动员的动作,提供训练反馈和改进建议。

* **交通管理:**检测和计数道路上的车辆,优化交通流。

* **野生动物监测:**监测野生动物的活动和种群分布,进行保护和研究。

# 5. YOLOv8的优化与改进

### 5.1 模型优化

#### 5.1.1 模型剪枝

**原理:**

模型剪枝是一种模型优化技术,通过移除不重要的神经元或连接来减小模型的大小和计算成本。

**具体操作:**

- **网络结构剪枝:**移除不重要的层或模块。

- **权重剪枝:**移除不重要的权重,例如权重绝对值较小的权重。

**代码示例:**

```python

import torch

from torch.nn.utils import prune

# 定义模型

model = torch.nn.Sequential(

torch.nn.Linear(100, 50),

torch.nn.ReLU(),

torch.nn.Linear(50, 10)

)

# 剪枝网络结构

prune.random_unstructured(model, amount=0.2)

# 剪枝权重

prune.l1_unstructured(model, amount=0.2)

```

**逻辑分析:**

- `prune.random_unstructured` 函数随机移除 20% 的网络结构。

- `prune.l1_unstructured` 函数基于 L1 范数移除 20% 的权重。

#### 5.1.2 量化

**原理:**

量化是一种模型优化技术,将浮点权重和激活值转换为低精度数据类型,例如 int8 或 int16。

**具体操作:**

- **权重量化:**将浮点权重转换为低精度数据类型。

- **激活值量化:**将浮点激活值转换为低精度数据类型。

**代码示例:**

```python

import torch

from torch.quantization import QuantStub, DeQuantStub

# 定义模型

model = torch.nn.Sequential(

QuantStub(),

torch.nn.Linear(100, 50),

DeQuantStub(),

torch.nn.ReLU(),

QuantStub(),

torch.nn.Linear(50, 10),

DeQuantStub()

)

# 量化模型

torch.quantization.quantize_dynamic(model, {torch.nn.Linear}, dtype=torch.qint8)

```

**逻辑分析:**

- `QuantStub` 和 `DeQuantStub` 模块用于标记量化和反量化的位置。

- `torch.quantization.quantize_dynamic` 函数将模型量化为动态 int8。

### 5.2 算法改进

#### 5.2.1 损失函数的改进

**原理:**

损失函数用于衡量模型的预测与真实标签之间的差异。改进损失函数可以提高模型的性能。

**具体操作:**

- **Focal Loss:**一种针对类别不平衡问题的损失函数。

- **IoU Loss:**一种衡量预测框和真实框重叠程度的损失函数。

**代码示例:**

```python

import torch

from torch.nn import BCEWithLogitsLoss, MSELoss

# 定义 Focal Loss

focal_loss = BCEWithLogitsLoss(reduction='none')

# 定义 IoU Loss

iou_loss = MSELoss(reduction='none')

```

**逻辑分析:**

- `BCEWithLogitsLoss` 函数用于计算二分类交叉熵损失。

- `MSELoss` 函数用于计算均方差损失。

#### 5.2.2 数据增强策略的改进

**原理:**

数据增强可以增加训练数据的多样性,提高模型的泛化能力。

**具体操作:**

- **随机裁剪:**从图像中随机裁剪出不同大小和宽高比的区域。

- **随机旋转:**将图像随机旋转一定角度。

- **随机翻转:**将图像随机水平或垂直翻转。

**代码示例:**

```python

import torchvision.transforms as transforms

# 定义数据增强策略

transform = transforms.Compose([

transforms.RandomCrop(224),

transforms.RandomRotation(15),

transforms.RandomHorizontalFlip()

])

```

**逻辑分析:**

- `transforms.RandomCrop` 函数随机裁剪图像。

- `transforms.RandomRotation` 函数随机旋转图像。

- `transforms.RandomHorizontalFlip` 函数随机水平翻转图像。

# 6.1 YOLOv8的未来发展方向

YOLOv8作为目标检测领域的标杆算法,其未来发展方向主要集中在以下几个方面:

- **模型轻量化:**随着边缘设备和移动端的普及,对轻量级目标检测模型的需求不断增长。YOLOv8的未来发展将致力于进一步优化模型结构,减少计算量和内存占用,使其能够在资源受限的设备上部署。

- **精度提升:**虽然YOLOv8在精度方面已经取得了显著进步,但仍有提升空间。未来的研究将探索新的网络架构、特征提取方法和损失函数,以进一步提高模型的检测精度。

- **泛化能力增强:**YOLOv8在不同场景和数据集上的泛化能力还有待提高。未来的研究将重点关注模型的鲁棒性,使其能够适应各种环境和目标类型,提高在实际应用中的适用性。

- **实时性优化:**对于实时目标检测应用,推理速度至关重要。YOLOv8的未来发展将探索并行计算、模型压缩和硬件优化等技术,以进一步提升推理效率,满足实时性要求。

- **多任务融合:**目标检测算法与其他计算机视觉任务,如图像分割、姿态估计和动作识别,具有高度的协同性。YOLOv8的未来发展将探索多任务融合技术,使其能够同时执行多种任务,提高模型的实用性和效率。

## 6.2 目标检测算法的未来趋势

除了YOLOv8的特定发展方向外,目标检测算法的整体未来趋势也值得关注:

- **端到端学习:**传统的目标检测算法通常分为目标建议和分类两个阶段。未来的研究将探索端到端学习方法,将这两个阶段融合为一个统一的网络,简化模型结构并提高推理效率。

- **自监督学习:**自监督学习技术利用未标记数据进行模型训练,可以有效降低对标注数据的依赖。未来的研究将探索将自监督学习应用于目标检测算法,以提高模型的泛化能力和鲁棒性。

- **可解释性增强:**目标检测算法的决策过程通常是黑盒化的,难以理解。未来的研究将致力于提高模型的可解释性,使其能够提供对检测结果的合理解释,增强用户对模型的信任度。

- **跨模态融合:**目标检测算法通常依赖于单模态数据,如图像或视频。未来的研究将探索跨模态融合技术,将不同模态的数据结合起来,提高模型的感知能力和理解力。

- **应用场景拓展:**目标检测算法在安防监控、自动驾驶、医疗影像等领域有着广泛的应用。未来的研究将探索将目标检测技术应用于更多新兴领域,如工业自动化、环境监测和智慧城市建设等。

0

0