Hadoop与YARN:资源管理演进全解析及安全漏洞防范

发布时间: 2024-10-26 06:40:34 阅读量: 33 订阅数: 23

hadoop-yarn-api-python-client:Hadoop:registered:YARN API的Python客户端

# 1. Hadoop与YARN的基本概念

在大数据处理领域,Hadoop作为一种广泛使用的分布式存储与计算框架,已经成为了行业的标准。Hadoop通过其核心子项目YARN(Yet Another Resource Negotiator)实现了资源管理的创新,为高效处理大数据提供了强大的支持。理解Hadoop与YARN的基本概念,是掌握现代大数据处理技术的基础。

## 1.1 Hadoop的核心概念

Hadoop最初由Apache软件基金会开发,设计目标是通过简单的编程模型,实现高可靠性、高可扩展性和高效率的大数据处理。它主要包括两个核心组件:Hadoop分布式文件系统(HDFS)和MapReduce计算模型。

- **HDFS**:负责数据的存储,通过将大文件分割成块(block),然后跨多台机器存储这些数据块来实现高容错性和扩展性。

- **MapReduce**:处理数据的框架,通过将任务分为map阶段和reduce阶段来并行处理数据,实现了数据的分布式处理。

## 1.2 YARN的出现与演进

随着大数据处理需求的不断提升,传统Hadoop MapReduce框架的局限性开始显现,特别是在资源调度和集群利用率方面。YARN的出现,其核心目标是优化资源调度,提高集群的利用率和扩展性。

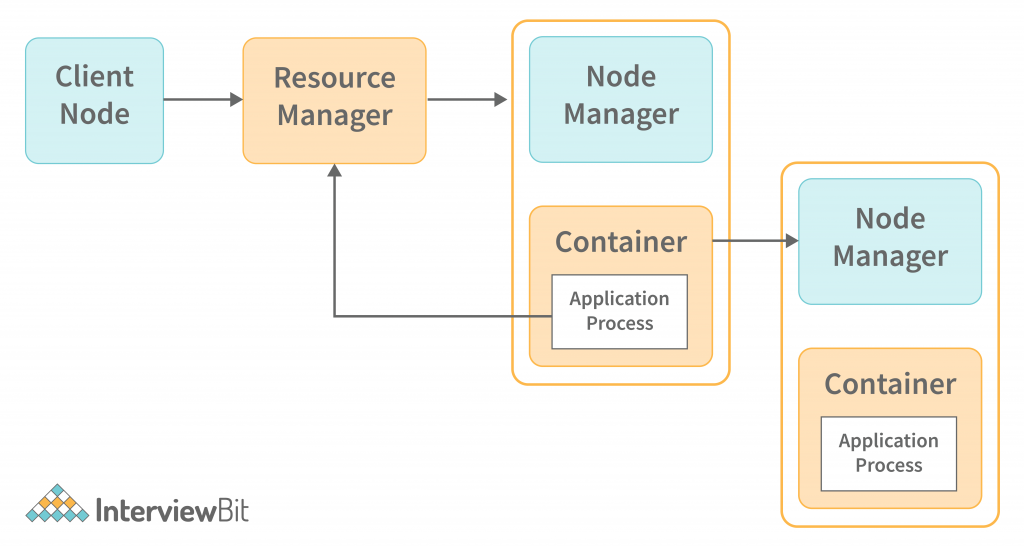

- **资源管理**:YARN通过引入资源管理器(ResourceManager)和节点管理器(NodeManager),实现了资源的集中管理与调度。

- **作业调度**:YARN引入应用程序级别的调度,通过应用程序历史服务器(ApplicationHistoryServer)记录每个应用的执行历史,以及优化资源使用情况。

YARN的引入,不仅极大地提升了Hadoop生态系统的灵活性,也为其后的各种大数据处理技术(如Spark、Hive等)的集成铺平了道路。了解YARN的工作原理,是深入学习大数据技术的必经之路。接下来,我们将深入探讨YARN的架构与工作原理。

# 2. YARN的架构与工作原理

## 2.1 YARN架构总览

YARN(Yet Another Resource Negotiator)是Hadoop 2.0引入的一个新的资源管理框架,它改进了Hadoop的扩展性和资源利用率,能够支持更多种类的计算框架。YARN的核心思想是将资源管理和任务调度/监控分离开来,通过引入一个全局的资源管理器(ResourceManager,简称RM)和每个应用程序的ApplicationMaster(AM),YARN提供了更加灵活和高效的大数据处理能力。

### YARN的组件

YARN的组件主要包括ResourceManager、NodeManager和ApplicationMaster。

#### ResourceManager(RM)

ResourceManager是集群资源的中央管理者,负责整个系统的资源分配和任务调度。它由两部分组成:调度器(Scheduler)和应用程序管理器(ApplicationManager)。

- **调度器**:负责集群中资源的分配,它根据资源需求和资源容量,为各个应用程序分配资源。调度器并不监控或跟踪应用程序的执行状态,仅负责资源的分配。

- **应用程序管理器**:负责接收用户提交的应用程序,协商第一个容器来运行ApplicationMaster,并监控ApplicationMaster的生命周期。

#### NodeManager(NM)

NodeManager是每个节点上的代理,负责单个节点的资源管理,监控节点资源使用情况(比如CPU、内存和磁盘),以及管理容器的生命周期。

#### ApplicationMaster(AM)

每个应用程序有自己的ApplicationMaster,负责与ResourceManager协商资源,并跟踪容器的执行状态,监控应用程序的执行进度。

### YARN工作流程

YARN的工作流程如下:

1. 用户提交应用程序到ResourceManager。

2. ResourceManager启动一个ApplicationMaster容器。

3. ApplicationMaster根据应用程序的需求向ResourceManager申请资源。

4. ResourceManager为ApplicationMaster分配资源,并通知NodeManager启动容器。

5. NodeManager在获得资源后启动容器,并在容器内运行应用程序的任务。

6. 当任务执行完成后,ApplicationMaster释放资源。

7. 应用程序执行完毕后,ApplicationMaster向ResourceManager注销并关闭。

## 2.2 YARN的关键特性

### 容器(Container)

容器是YARN中资源抽象的基本单位,它封装了某个节点上的多维资源,如内存、CPU和磁盘等。应用程序可以请求多个容器,以便并行执行多个任务。

```mermaid

graph LR

A[用户提交应用程序] --> B[ResourceManager启动ApplicationMaster]

B --> C[ApplicationMaster申请资源]

C --> D[ResourceManager分配资源并通知NodeManager]

D --> E[NodeManager启动容器]

E --> F[容器内运行应用程序任务]

F --> G[任务完成释放资源]

G --> H[应用程序执行完毕]

```

### 资源调度器

YARN支持多种调度策略,例如先进先出(FIFO)、容量调度器(Capacity Scheduler)和公平调度器(Fair Scheduler)。这些调度器可以配置不同的调度策略,以便适应不同的应用场景。

### 多租户支持

YARN通过资源管理器的调度器来支持多租户环境,允许多个应用程序同时运行,并在它们之间共享资源。这使得YARN可以为不同的用户或团队公平地分配资源。

## 2.3 YARN的应用实例

### 运行MapReduce任务

MapReduce是Hadoop的一个编程模型,用于处理大规模数据集的计算任务。在YARN环境下,运行MapReduce任务的过程如下:

1. 用户提交MapReduce任务到ResourceManager。

2. ResourceManager启动MapReduce的ApplicationMaster。

3. ApplicationMaster请求ResourceManager为其分配多个Container,用于Map和Reduce任务的执行。

4. ResourceManager分配资源,并由NodeManager启动相应的Container。

5. MapReduce任务在Container内执行,完成后资源被释放。

### 运行Spark任务

Apache Spark是一个开源的快速大数据处理框架,支持内存计算,可以运行在YARN之上。其运行流程与MapReduce类似,但Spark可以利用YARN的调度器,实现更加复杂和高效的内存计算任务。

```mermaid

flowchart LR

A[用户提交Spark任务到ResourceManager]

A --> B[ResourceManager启动Spark ApplicationMaster]

B --> C[ApplicationMaster请求资源]

C --> D[ResourceManager分配资源并通知NodeManager]

D --> E[NodeManager启动容器]

E --> F[容器内运行Spark任务]

F --> G[任务完成资源释放]

```

通过本章节的介绍,我们了解了YARN的架构和工作原理,掌握了其核心组件以及运行流程。在下一章中,我们将详细探讨Hadoop集群的安全机制,了解如何在分布式计算环境中保障数据和资源的安全。

# 3. Hadoop集群的安全机制

Hadoop集群的安全机制是保证大规模分布式存储和计算环境稳定运行的关键。本章节将深入探讨Hadoop集群中的各种安全机制,包括认证、授权、数据加密以及审计等。

## Hadoop认证机制

### 认证机制的基本原理

认证是确保只有授权用户才能访问系统资源的第一步。在Hadoop中,Kerberos认证是默认的认证机制,它提供了一种强大的认证服务,通过在非信任网络环境中对通信双方的身份进行验证。

#### Kerberos认证流程

Kerberos认证涉及三个主要的参与者:客户端、认证服务器(AS)和票据授权服务器(TGS)。整个认证流程如下:

1. 客户端请求认证服务器获得票据授权票据(TGT)。

2. 认证服务器验证客户端身份后发送TGT。

3. 客户端使用TGT请求票据授权服务器的服务票据。

4. 票据授权服务器验证TGT并发送服务票据。

5. 客户端使用服务票据访问服务。

#### 代码逻辑分析

以下是一个简化的Kerberos认证过程的伪代码示例,用以说明其工作原理。

```python

# 客户端请求认证服务器获得TGT

def request_tkt():

client = Client()

tkt_response = AS.request_ticket_granting_ticket(client.name)

client.store_tkt(tkt_response.ticket)

return tkt_response

# 客户端使用TGT请求服务票据

def request_service_ticket(tkt_response):

client = Client()

service_tkt_response = TGS.request_service_ticket(client.name, tkt_response, Service_Name)

client.store_service_tkt(service_tkt_response.ticket)

return service_tkt_response

# 使用服务票据访问服务

def access_service(service_tkt):

client = Client()

service = Service(Service_Name)

if service.is_valid_ticket(service_tkt.ticket):

service.provide_service()

else:

raise Exception("Invalid service ticket")

# 模拟客户端认证和访问服务

tkt_response = request_tkt()

service_tkt_response = request_service_ticket(tkt_response)

access_service(service_tkt_response)

```

每个步骤都会涉及到加密和票据交换,确保整个过程的安全性。

### Kerberos认证配置

在Hadoop集群中配置Kerberos需要编辑配置文件,如`krb5.conf`、`hadoop.security.authentication`等,并确保所有服务使用相同的Kerberos设置。

```ini

[libdefaults]

default_realm = REALM_NAME

```

0

0