R语言全面解析:掌握residuals函数的10个实用技巧

发布时间: 2024-11-04 08:28:51 阅读量: 24 订阅数: 23

# 1. R语言与residuals函数概述

在统计分析和数据科学领域,R语言以其强大的统计计算和图形显示能力著称。在R语言中,`residuals`函数是用于从统计模型中提取残差的一个核心工具。残差是观察值与模型预测值之间的差异,对于评估模型的准确性和发现数据中的异常值至关重要。

本章节将为读者提供一个对R语言及其`residuals`函数的基础理解,并对残差分析的重要性进行介绍。我们将通过实际代码示例来展示如何使用`residuals`函数,并初步介绍如何在数据分析中应用残差。

```r

# 安装和加载基础R包

install.packages("stats") # 包含residuals函数

library(stats)

# 使用lm函数创建一个简单的线性模型

model <- lm(mpg ~ wt, data=mtcars)

# 提取模型的残差

residuals <- residuals(model)

head(residuals) # 显示残差的前几项

```

在接下来的章节中,我们将深入探讨`residuals`函数在基础和高级统计模型中的应用,以及如何通过残差分析提高模型的预测能力和稳健性。

# 2. residuals函数的基础应用

### 2.1 基础统计模型中的残差分析

残差是统计模型中预测值与实际观测值之间的差异。在基础统计模型中,特别是在线性回归模型中,残差分析是评估模型拟合优度的重要手段。

#### 2.1.1 线性回归模型的残差

在R语言中,`residuals()`函数是用于获取线性模型残差的标准方法。线性回归模型的残差可用来检查模型假设,比如残差的独立性和方差的同质性。

```R

# 创建一个简单的线性模型

model <- lm(mpg ~ wt, data=mtcars)

# 计算残差

residuals <- residuals(model)

# 残差的分布可视化

plot(residuals)

abline(h=0, col='red')

```

在上面的代码中,我们首先构建了一个基于mtcars数据集的线性回归模型,该模型试图解释汽车的油耗(mpg)与重量(wt)之间的关系。接着,我们使用`residuals()`函数获取了模型的残差,并通过`plot()`函数绘制了残差图。图中的水平红线表示零残差线,有助于直观地检查残差是否围绕零值对称分布,这是残差独立同分布假设的可视化表示。

#### 2.1.2 残差的图形化展示

残差图是残差分析中非常重要的工具。除了直方图外,还可以使用箱形图和散点图来展示残差。

```R

# 利用箱形图展示残差

boxplot(residuals)

# 使用散点图展示残差与拟合值的关系

plot(fitted(model), residuals)

abline(h=0, col='red')

```

箱形图可以揭示数据的分布情况,包括中位数、四分位数和潜在的离群点。而散点图可以展示残差是否具有某种与拟合值相关的模式,比如曲线关系,这可能表明数据的非线性特征。

### 2.2 高级统计模型中的残差分析

#### 2.2.1 广义线性模型(GLM)的残差

广义线性模型(Generalized Linear Models, GLM)扩展了线性回归模型的适用范围,允许因变量的分布不再是正态分布。`residuals()`函数在处理GLM模型时同样适用,但需要注意残差的类型和假设。

```R

# 创建一个广义线性模型

glm_model <- glm(cbind(success, failure) ~ x, family = binomial, data = mydata)

# 计算残差

residuals_glm <- residuals(glm_model, type = "response")

```

在广义线性模型中,根据不同的分布族,`residuals()`函数计算的残差类型也会有所不同。在上面的代码中,我们使用了二项分布族(family = binomial)来拟合一个包含成功次数和失败次数的模型。

#### 2.2.2 多变量回归的残差

在多变量回归模型中,`residuals()`函数可以用来计算每个观测点的残差。这有助于我们理解模型拟合的优劣,并为后续的模型优化提供信息。

```R

# 创建一个多变量回归模型

multi_model <- lm(mpg ~ wt + disp + hp, data=mtcars)

# 计算残差

residuals_multi <- residuals(multi_model)

# 分析残差与多个自变量的关系

pairs(cbind(residuals_multi, mtcars$wt, mtcars$disp, mtcars$hp))

```

在创建多变量回归模型后,我们计算了模型的残差,并通过`pairs()`函数创建了一个散点图矩阵,用于展示残差与各个自变量之间的关系。这有助于我们直观地检查是否存在潜在的模式,比如在某个自变量范围内残差的系统性偏差。

以上代码和解释展示了在基础统计模型和高级统计模型中,`residuals()`函数如何被用来分析和理解残差。通过这些分析,我们可以评估模型的适用性,并为后续的模型优化提供依据。

# 3. residuals函数的高级技巧

## 3.1 自定义残差计算方法

在数据分析过程中,标准的残差计算方法可能不足以解释数据的复杂性。在这样的背景下,理解如何自定义残差计算方法变得至关重要。本节将探讨两种高级技巧:标准化残差和学生化残差的应用。

### 3.1.1 标准化残差的应用

标准化残差是将残差除以标准误差的估计,其结果便于比较不同数据集中的残差。计算标准化残差的目的是为了识别那些在统计上显著不同于零的残差。这个过程有助于我们理解数据中的异常点和离群值。

标准化残差的计算公式为:

```

标准化残差 = (残差 - 均值) / 标准差

```

在R语言中,我们可以使用residuals函数来获取模型的残差,然后使用scale函数来标准化这些残差。

```r

# 假设lm_model是我们的线性模型对象

residuals <- residuals(lm_model)

standardized_residuals <- scale(residuals)

```

### 3.1.2 学生化残差的应用

学生化残差,又称为内部学生化残差或学生化删除残差,是一种调整了残差标准误差以反映单个观测值对模型拟合影响的方法。这种残差在识别异常值时特别有用,因为它考虑了观测值对模型的影响。

在R语言中,我们可以使用rstudent函数来获取学生化残差。

```r

# 使用rstudent函数获取学生化残差

studentized_residuals <- rstudent(lm_model)

```

## 3.2 残差分析与模型诊断

### 3.2.1 残差分析的诊断图

残差分析的诊断图对于理解模型的拟合程度和识别问题非常重要。在R语言中,可以使用plot函数生成诊断图,它通常包括残差对拟合值的散点图、残差的正态概率图等。

```r

# 使用plot函数绘制残差图

plot(lm_model)

```

这些图形可以帮助我们发现残差的非随机模式,比如异方差性、非线性趋势,或者识别异常值和离群点。

### 3.2.2 异常值和离群点的检测

异常值和离群点是数据集中的观测点,它们的值明显不同于其他数据点。在残差分析中,异常值和离群点的识别是模型诊断的一个重要方面。离群点通常是那些在残差图上远离零点的观测值。

为了在R中检测离群点,我们可以设置一个阈值,比如残差的绝对值大于3的观测点。我们也可以使用 cooks距离(Cook's distance)来识别那些对模型拟合有显著影响的点。

```r

# 使用 cooks距离识别离群点

cook_d <- cooks.distance(lm_model)

influential_points <- which(cook_d > 4 / length(cook_d))

```

在实际分析中,需要综合考虑各种诊断工具和方法来识别并处理异常值和离群点,这对于提高模型的准确性和可靠性至关重要。

在这一章节中,我们深入了解了如何使用residuals函数进行更复杂的残差分析技巧,包括自定义残差计算方法以及如何应用诊断图进行模型诊断。接下来的章节将通过具体的应用案例,展示residuals函数在实践中的应用和模型评估中的作用。

# 4. residuals函数实践应用案例

#### 4.1 实际数据集上的残差分析

##### 4.1.1 数据集的准备和预处理

在深入探讨`residuals`函数在实际数据分析中的应用之前,必须对数据集进行仔细的准备和预处理。这包括数据清洗、转换以及变量的选择,以确保后续分析的准确性和有效性。

首先,数据集的收集是分析的第一步。对于这一阶段,可能需要使用如`read.csv`或`read.table`等函数来读取数据。一旦数据被加载到R中,需要进行初步的检查,看看是否有缺失值或异常值,这可以通过`summary`函数或`str`函数来快速查看数据集的基本情况。

```r

# 读取数据集

data <- read.csv("path_to_data.csv")

# 检查数据集的结构

str(data)

# 查看数据集的基本统计摘要

summary(data)

```

接下来,对于缺失值的处理,我们可以选择删除含有缺失值的行,或使用诸如均值填充的方法。此外,对于分类变量,可能需要使用`factor`函数将其转换为因子类型,以便在后续的模型中正确处理。

```r

# 处理缺失值

data <- na.omit(data) # 删除含有缺失值的行

# 转换分类变量为因子

data$Category <- factor(data$Category)

```

数据预处理的最后一步可能是创建新的变量或者对变量进行变换。例如,对于一些非线性关系,可能需要对一个或多个变量进行对数变换。

```r

# 对变量进行对数变换

data$LogVar <- log(data$OriginalVar)

```

这些预处理步骤都是数据分析中必不可少的,为接下来的模型建立和残差分析打下了坚实的基础。

##### 4.1.2 残差分析的步骤和解释

在完成数据集的准备和预处理后,可以开始进行残差分析。在R中,利用`residuals`函数可以很容易地从各种线性和非线性模型中提取残差。这些残差随后可以用于检查模型的假设和诊断模型的性能。

以线性回归模型为例,首先需要建立模型:

```r

# 建立线性回归模型

model <- lm(dependent_variable ~ independent_variable_1 + independent_variable_2, data = data)

```

接着,使用`residuals`函数来获取残差:

```r

# 获取模型的残差

residuals_model <- residuals(model)

```

获取残差后,我们通常需要对残差进行图形化展示,以直观地了解其分布情况,是否存在模式,或者是否有异常值的存在。常见的图形包括残差散点图、QQ图等。

```r

# 残差散点图

plot(model$residuals ~ model$fitted.values)

abline(h = 0, col = "red")

# QQ图

qqnorm(model$residuals)

qqline(model$residuals)

```

通过这些图,我们可以检查残差的独立性、方差的均等性和正态性假设。如果残差分布看起来存在模式或非随机,这可能意味着模型的某些方面需要改进。

在实际的业务分析中,残差分析是一种诊断工具,可以帮助分析师识别模型中可能存在的问题。例如,残差图上的某些点可能突出显示为异常值,这可能表明异常观测值对模型的影响过大,需要进一步调查。

```r

# 寻找异常值或离群点

outliers <- which(abs(residuals_model) > 2*mean(abs(residuals_model)))

```

残差分析能够提供洞察力,帮助我们更好地理解数据,指导我们对模型进行调整和优化,以提升模型在预测和解释上的准确性和有效性。在下一节中,我们将探讨残差分析在预测模型准确性评估和改进策略中的具体应用。

#### 4.2 残差分析在预测模型中的作用

##### 4.2.1 模型准确性评估

在构建预测模型时,评估其准确性是一个关键步骤。残差分析在此过程中扮演了重要的角色,因为它可以帮助我们识别模型中的不足之处。一个准确的模型的残差应该呈现出随机分布的特性,没有明显的模式或趋势。

在R中,除了之前提及的图形分析之外,还有一些统计指标可以帮助我们评估模型的准确性,比如均方误差(MSE)和均方根误差(RMSE)。这些指标可以通过残差来计算。

```r

# 计算均方误差(MSE)

mse <- mean(residuals_model^2)

# 计算均方根误差(RMSE)

rmse <- sqrt(mse)

```

MSE和RMSE越小,表示模型的预测误差越小,模型的准确性越高。然而,这些指标需要结合残差的图形化展示一起使用,因为有时候小的误差值可能掩盖了模型结构的不当。

另外,决定系数(R^2)也是一个广泛使用的指标来评估模型的拟合程度。它描述了模型预测值与实际值之间的比例关系,通常R^2值越接近1,表明模型拟合程度越好。

```r

# 计算决定系数(R^2)

r_squared <- 1 - sum(residuals_model^2) / sum((data$dependent_variable - mean(data$dependent_variable))^2)

```

残差分析和这些统计指标相结合,为模型的准确性评估提供了一个综合的视角。如果模型准确性不够高,可能需要进一步的特征工程、变量选择或者考虑更复杂的模型结构。

##### 4.2.2 模型改进与优化策略

识别模型中的问题后,下一步就是采取相应的优化策略。残差分析在这一过程中提供了直接的指导。对于线性回归模型而言,如果残差图显示出明显的非线性模式,可能需要考虑添加多项式项或交互项来提高模型的表达能力。

例如,如果残差随拟合值增加而增加,这可能意味着数据存在异方差性,即残差的方差不是恒定的。这时,可以通过加权最小二乘法(WLS)来调整模型,或者对响应变量进行变换。

```r

# 对响应变量进行变换,如对数变换

data$LogDependentVar <- log(data$dependent_variable)

model_transformed <- lm(LogDependentVar ~ independent_variable_1 + independent_variable_2, data = data)

```

此外,如果残差图显示出某些离群点或异常值,可以考虑使用鲁棒回归方法,如`rlm`函数,来减少这些极端值对模型的影响。

```r

# 使用鲁棒回归方法

library(MASS)

model_robust <- rlm(dependent_variable ~ independent_variable_1 + independent_variable_2, data = data)

```

在改进模型时,应该注意到每一步的更改都应有合理的理论支持,并通过交叉验证来验证其有效性。最终,优化的目标是确保模型不仅在训练数据上表现良好,而且在新的、未见过的数据上也能保持稳定的性能。

总之,残差分析是模型优化过程中不可或缺的工具,它能够帮助我们识别模型中的问题并指导我们进行改进,从而提高模型的准确性和可靠性。在下一章中,我们将进一步探讨残差分析的进阶应用,包括对更多统计模型和复杂数据结构的应用案例。

# 5. residuals函数的进阶探索

在前几章中,我们已经了解了residuals函数的基础应用和一些高级技巧。在本章中,我们将深入探讨残差分析的理论扩展,以及在不同软件包和工具中的应用情况。

## 5.1 残差分析的理论扩展

残差分析作为模型诊断的关键步骤,其背后的统计原理是复杂的,但同时也是非常重要的。在模型建立后,我们需要利用残差分析来验证模型的假设,这包括残差的独立性、正态性和同方差性。

### 5.1.1 残差分析的统计原理

残差分析的一个核心原理是确保模型误差项的随机性,这意味着残差应该围绕0随机波动,没有明显的模式。如果残差表现出模式,这可能表明模型中存在未被捕捉到的信息,需要进一步调整模型。

为了更深入理解残差分析的统计原理,我们来看一个例子:

```r

# 假设我们有一个线性模型

model <- lm(y ~ x, data = mydata)

# 获取残差

residuals <- residuals(model)

# 绘制残差和拟合值的散点图

plot(fitted(model), residuals)

abline(h = 0, lty = 2, col = "red")

```

通过这个简单的线性回归模型,我们使用`residuals()`函数获取残差,并通过散点图来检查残差是否满足基本的统计假设。理想情况下,我们应该看到一个没有任何明显模式的随机点云。

### 5.1.2 理论与实践的结合点

在实践中,结合残差分析的理论可以指导我们进行有效的模型诊断。例如,如果残差的Q-Q图显示了显著的偏离,则表明残差可能不是正态分布的。这可能是由于异常值的影响,或者模型不适合数据。

残差分析的理论还可以帮助我们在面对复杂模型时,如何选择适当的残差类型。例如,在广义线性模型中,标准化残差是评估模型拟合质量的有力工具,而学生化残差则对异常值的检测更为敏感。

## 5.2 残差分析软件包和工具

随着统计和数据分析方法的发展,越来越多的软件包和工具出现在R语言的生态系统中,提供了更加强大和灵活的残差分析能力。

### 5.2.1 R语言中其他的残差分析工具

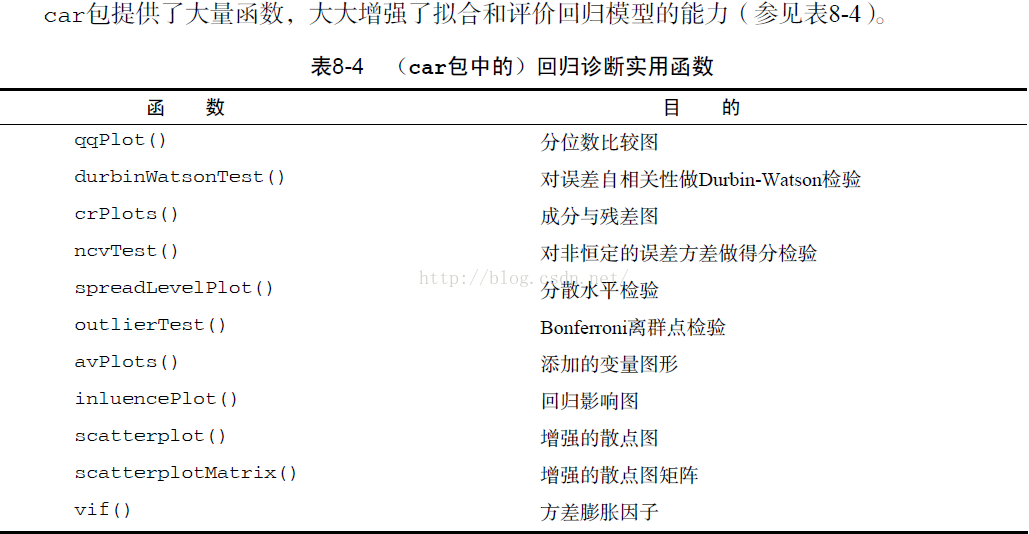

R语言有着强大的社区支持,产生了许多专门用于残差分析的软件包。比如,`car`包中的`residualPlots`函数可以帮助我们快速生成诊断图,而`olsrr`包提供了更深入的模型诊断功能。

例如,使用`car`包的代码如下:

```r

# 安装并加载car包

install.packages("car")

library(car)

# 使用residualPlots函数生成残差图

residualPlots(model)

```

### 5.2.2 残差分析的跨平台应用展望

尽管R语言提供了丰富的工具,但残差分析的需求也出现在其他数据分析平台中。例如,Python的`statsmodels`库也提供了强大的残差分析功能,这使得数据科学家可以在不同的平台上共享和复现结果。

为了说明如何在Python中进行残差分析,让我们来看一个简单的例子:

```python

import statsmodels.api as sm

import matplotlib.pyplot as plt

# 假设我们有一个线性模型

X = sm.add_constant(X) # 添加截距项

model = sm.OLS(y, X).fit()

# 绘制残差图

fig = model.plot_diagnostics(figsize=(8, 6))

plt.show()

```

在Python中,我们使用`statsmodels`库进行线性回归,并利用`plot_diagnostics`方法生成一个包含多个诊断图的图形,其中包括残差的正态性、线性以及均值为零的检验等。

通过不同软件包和工具的探索,我们可以发现,尽管实施平台和工具各异,但残差分析的核心思想和方法论却是相通的。了解这些差异可以更好地在不同的数据科学任务中应用残差分析,以提升模型的准确性和可靠性。

0

0