TensorFlow 2.0学习率调度策略:提升模型性能的关键技术

发布时间: 2025-01-10 10:43:51 阅读量: 4 订阅数: 7

Tensorflow2.0学习(三):线性回归的小例子

# 摘要

本文详细探讨了TensorFlow 2.0中学习率调度策略的理论基础和实践应用。学习率作为深度学习中至关重要的超参数,其选择和调度对模型的收敛速度、泛化能力和过拟合风险有显著影响。文章首先介绍了学习率的基本概念及其重要性,随后详述了不同学习率调度策略的类型和原理,包括固定学习率、动态调整策略以及衰减技术。接着,本文通过实例演示了如何在TensorFlow 2.0中应用这些策略,包括使用预置的调度器和自定义调度策略。此外,还深入分析了学习率调度对模型性能的具体影响,并提供了选择和调整学习率调度策略的指导。最后,本文通过案例研究和实战演练,展示了学习率调度策略在深度学习项目中的实际应用,以及如何通过调优和验证学习率策略来提升模型性能。

# 关键字

TensorFlow 2.0;学习率调度;收敛速度;过拟合;超参数优化;模型性能

参考资源链接:[FLAC 3D收敛标准详解:理解数值分析中的关键要素](https://wenku.csdn.net/doc/ycuz67adqq?spm=1055.2635.3001.10343)

# 1. TensorFlow 2.0概述

TensorFlow 2.0是目前最受欢迎的深度学习框架之一,以其灵活性、可扩展性和强大的社区支持而著称。自2019年发布以来,它在各个方面都进行了重大更新,以适应现代机器学习实践的需求。本章将提供TensorFlow 2.0的基础知识,包括其架构特点、核心API以及如何搭建一个基础的机器学习开发环境。

## TensorFlow 2.0架构特点

TensorFlow 2.0采用了一种更加用户友好的API设计,引入了eager execution模式,该模式允许开发者编写代码时能立即获得反馈,无需构建静态计算图。这种即时的执行方式极大地降低了学习门槛,使得调试和开发更加直观。此外,2.0版本对代码的兼容性也做了改进,使得从旧版本迁移到新版本变得更加平滑。

## 核心API介绍

TensorFlow的核心API可以分为几个主要部分:张量操作(tf.Tensor)、计算图(tf.Graph)、会话(tf.Session)以及高级API Keras。其中,Keras作为TensorFlow的高层API,现在已经被集成为核心模块,提供了快速搭建模型的高层接口。开发者可以轻松地利用Keras的Sequential模型或函数式API来构建复杂的神经网络结构。

## 开发环境搭建

为了开始使用TensorFlow 2.0,需要设置一个合适的工作环境。推荐使用Anaconda来管理Python包和环境,这样可以轻松地安装TensorFlow和其他必要的库。此外,也可以通过Python包管理器pip来安装TensorFlow 2.0。安装完毕后,可以通过编写简单的代码来验证TensorFlow是否已正确安装并运行。

```python

import tensorflow as tf

# 创建一个常量张量

constant_tensor = tf.constant([[1, 2], [3, 4]])

print(constant_tensor)

```

以上代码段将打印出一个简单的2x2常量张量。如果一切设置正确,这将标志着您的TensorFlow 2.0开发环境搭建成功,并为后续章节的学习率调度策略奠定了基础。

# 2. 学习率调度策略的基础理论

## 2.1 学习率的概念及其重要性

### 2.1.1 学习率对模型训练的影响

学习率是神经网络训练过程中最核心的超参数之一。它决定了在优化过程中参数更新的步长。选择合适的学习率对于模型能否有效学习至关重要。

1. **过大学习率**:当学习率设置过大时,模型在寻找最优解的过程中可能会跨过最优点,导致无法收敛或者在最小值点附近震荡。这可以类比为在一座山峰上行走,步长太大可能会导致你无法精确地找到山的最高点(模型的最优解),而是在山顶附近来回徘徊。

2. **过小学习率**:而当学习率设置过小时,虽然能够确保每一步都尽可能地接近最优解,但问题在于整个训练过程会变得非常缓慢,甚至有可能由于小幅度的更新陷入局部最小值。这就类似于在山间小路上缓慢爬行,虽然能够确保每步都踏在最佳位置,但要到达山顶需要消耗很长时间。

因此,合适的学习率是确保模型能够快速且准确学习的重要因素。

### 2.1.2 选择合适学习率的方法

确定一个合适的学习率并非易事,传统方法有试错法和学习率范围测试。而近来,一些更高级的策略,如学习率预热、学习率衰减、循环学习率等,为学习率的设定提供了更丰富的选择。

1. **试错法**:这是一种非常直接的方法,通过多次训练不同的学习率,观察损失函数的变化情况。虽然这种方法简单易行,但成本较高,尤其是在深度网络和大数据集上。

2. **学习率范围测试**:该方法是一种比较高效的策略,通过在训练过程中逐渐增加学习率,观察模型的表现。其思想是在训练初期选择一个较低的学习率,然后逐渐增加,绘制出训练损失和学习率的关系图。一个“U”型曲线的出现通常意味着找到了一个合适的学习率范围。

3. **学习率预热**:与前面的方法不同,学习率预热是一种逐渐增加学习率到一个理想值的方法。它通常用于模型的早期训练阶段,有助于模型的稳定。

4. **学习率衰减**:在训练过程中逐渐减小学习率,可以避免在训练后期过度振荡,有助于模型收敛到一个更好的最小值。

在实际应用中,可以根据具体任务和数据集的特点,选择合适的方法进行学习率的设定。

## 2.2 学习率调度策略的类型

### 2.2.1 固定学习率策略

固定学习率是最简单、最基础的学习率策略,即在整个训练过程中使用恒定不变的学习率。虽然这种方法缺乏灵活性,但它易于实现,并且在一些简单模型或问题中效果显著。

**使用固定学习率的优势**包括:

- **简易性**:无需调整学习率,代码实现简单。

- **稳定性**:避免了学习率不断变化可能带来的不稳定性问题。

**不足之处**为:

- **适应性差**:无法适应数据集的复杂性,可能错过最优的学习率。

### 2.2.2 动态学习率调整策略

动态学习率调整策略是一种更复杂但更有效的方法。它根据模型在训练过程中的表现,动态地调整学习率。常见的动态调整策略包括学习率衰减、周期性调整等。

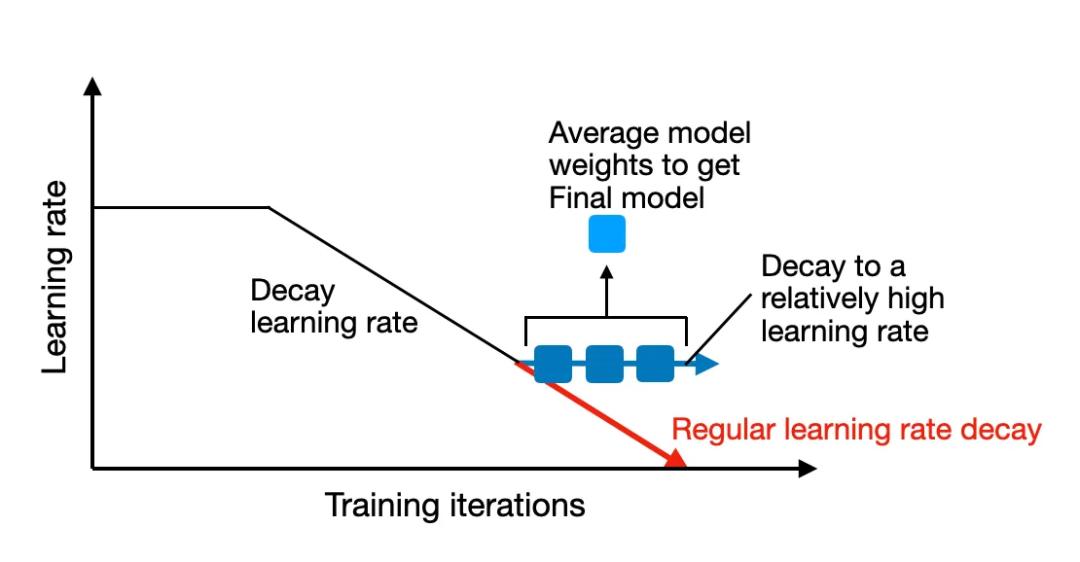

**学习率衰减**是一种常用策略,通常在训练的中后期逐渐减小学习率,帮助模型精细地收敛到最优解。它基于这样一种假设:随着训练的进行,模型参数逐渐接近最优值,此时需要更小的步长来“精细”调整参数。

**周期性调整**学习率则是一种在某些周期内增加或减少学习率的方法。这种方法有时可以“跳出”局部最小值,从而有可能找到一个更好的全局最小值。

## 2.3 学习率衰减技术

### 2.3.1 衰减策略的原理和实现

学习率衰减的原理在于,随着训练的深入,模型逐步学习到了数据的特征,因此需要更细致地调整模型参数。这时,一个较小的学习率能够帮助模型在小范围内“精细”搜索最优解,避免因为过大的步长而错过最优点。

在TensorFlow 2.0中,实现学习率衰减的API函数主要是 `tf.keras.optimizers.schedules` 模块下的各种调度器。这些调度器可以在优化器中被使用来动态地调整学习率。例如,使用 `ExponentialDecay` 可以实现指数衰减的学习率调整。

```python

import tensorflow as tf

# 创建一个学习率调度器,初始学习率为0.1,衰减率为0.96,每100个step衰减一次

lr_schedule = tf.keras.optimizers.schedules.ExponentialDecay(

initial_learning_rate=0.1,

decay_steps=100,

decay_rate=0.96,

staircase=True)

# 创建一个优化器并传入学习率调度器

optimizer = tf.keras.optimizers.Adam(learning_rate=lr_schedule)

# 编译模型时使用这个优化器

model.compile(optimizer=optimizer, ...)

```

### 2.3.2 衰减参数的选择与优化

选择合适的衰减参数对于模型训练至关重要。以下是一些选择和优化衰减参数的建议:

1. **初始学习率**:应根据数据集的大小、复杂性以及模型的深度来调整。通常,更复杂的数据集和模型需要更低的初始学习率。

2. **衰减率和衰减步**:这两个参数是紧密相关的。衰减步决定了学习率衰减的频率,而衰减率决定了衰减的幅度。一个良好的初始选择是设置一个较大的衰减步和较小的衰减率。

3. **衰减策略的选择**:不同的衰减策略适用于不同的问题。例如,指数衰减适用于大多数情况,而对于某些具有周期性变化特征的任务,可以考虑周期性衰减。

学习率衰减策略的选择和优化需要根据实验的结果进行调整。建议在一系列的训练实验中,尝试不同的衰减策略和参数组合,以找到最适合当前任务的配置。

# 3. TensorFlow 2.0中的学习率调度实践

在深度学习领域,学习率调度(Learning Rate Scheduling)策略对于模型性能和训练效率有着显著的影响。学习率决定了参数更新的幅度,过高可能会导致模型无法收敛,过低则会延长训练时间。在TensorFlow 2.0中,提供了多种学习率调度器,本章节将详细介绍这些策略的应用与实践。

## 3.1 基于TensorFlow 2.0的固定学习率应用

### 3.1.1 实例:使用固定的高学习率训练模型

在模型训练的初期,使用较高的学习率可以帮助模型快速跳出局部最小值,进行有效的参数更新。但在TensorFlow 2.0中,如果没有特别指定,优化器默认的学习率是固定的,使用`tf.keras.optimizers.SGD`来定义一个具有固定学习率的优化器,代码示例如下:

```python

import tensorflow as tf

# 定义模型

model = ... # 假设已经构建了模型

model.compile(optimizer=tf.keras.optimizers.SGD(learning_rate=0.01),

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

history = model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val))

```

### 3.1.2 实例:使用固定的低学习率训练模型

相反,如果学习率设定过低,模型的参数更新会非常缓慢,这可能有助于模型在训练过程中达到更精确的局部最小值,但也有可能使模型陷入长时间的“低效震荡”。下面是一个使用低学习率训练模型的示例:

```python

# 定义模型

model = ... # 假设已经构建了模型

# 使用更低的学习率

optimizer = tf.keras.optimizers.SGD(learning_rate=0.0001)

model.compile(optimizer=optimizer,

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

history = model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val))

```

## 3.2 自定义学习率调度策略

### 3.2.1 实例:使用Lambda调度器自定义学习率变化

当训练进入到中后期,通常需要逐渐减小学习率以稳定模型训练。TensorFlow 2.0提供了`tf.keras.optimizers.schedules.LambdaSchedule`,允许我们自定义学习率的变化函数。下面是一个自定义学习率的实例,通过一个lambda函数逐渐降低学习率:

```python

import math

import tensorflow as tf

# 定义自定义学习率的衰减函数

def lr_decay(epoch):

return 0.01 * math.exp(-0.1 * epoch)

lr_schedule = tf.keras.optimizers.schedules.LambdaSchedule(lambda epoch: lr_decay(epoch))

optimizer = tf.keras.optimizers.SGD(learning_rate=lr_schedule)

model = ... # 假设已经构建了模型

# 训练模型

model.compile(optimizer=optimizer,

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

history = model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val))

```

### 3.2.2 实例:使用

0

0