TensorFlow 2.0分布式训练秘笈:如何提高模型训练的效率和效果

发布时间: 2025-01-10 10:16:42 阅读量: 4 订阅数: 8

# 摘要

随着机器学习和深度学习模型的日益复杂化,分布式训练已成为提升训练效率和扩展性的关键技术。本文首先介绍了分布式训练的理论基础,随后深入探讨了在TensorFlow 2.0环境下搭建分布式训练环境的步骤,包括分布式架构解析、集群配置和训练策略。在实践技巧章节中,文章分析了数据并行、模型并行及混合精度训练等高级主题,并提供了性能调优的详细指导。文章进一步探索了自定义分布式操作、内存管理和跨平台与框架训练的高级应用,以及分布式训练的案例实操和最佳实践。最后,文章对分布式训练的未来趋势进行了展望,并讨论了其面临的挑战与发展机遇。

# 关键字

分布式训练;TensorFlow 2.0;集群配置;数据并行;模型并行;性能调优

参考资源链接:[FLAC 3D收敛标准详解:理解数值分析中的关键要素](https://wenku.csdn.net/doc/ycuz67adqq?spm=1055.2635.3001.10343)

# 1. 分布式训练的理论基础

在现代机器学习领域,数据量与模型的规模不断增长,单一计算节点已难以满足对大规模数据处理的需求。分布式训练应运而生,它通过在多个计算节点之间划分任务和数据,实现了高效率的数据处理和模型训练。分布式训练的核心在于利用多台计算机的计算能力来加速大规模数据集上的深度学习模型训练。

## 1.1 分布式训练的优势

分布式训练的优势在于:

- **加速模型训练**:通过多个计算节点并行处理数据和模型参数,显著缩短训练时间。

- **处理大数据集**:分布式系统能够处理单一机器难以存储或处理的大型数据集。

- **提升模型容量**:可以构建更大规模的模型,因为系统总体资源远超单个节点。

## 1.2 分布式训练的挑战

尽管有众多优势,但分布式训练也面临若干挑战:

- **通信开销**:节点间通信会消耗宝贵的计算资源。

- **数据同步**:保持多个节点间数据的一致性需要复杂的同步机制。

- **容错能力**:系统需要能够处理节点故障,确保训练不受影响。

分布式训练的理论基础为后续章节中搭建环境、策略优化和实操案例打下了坚实的基石,为理解其在TensorFlow 2.0中的应用提供了必要的背景知识。

# 2. TensorFlow 2.0分布式训练环境搭建

## 2.1 TensorFlow 2.0分布式架构解析

### 2.1.1 分布式训练组件概览

分布式训练在TensorFlow 2.0中通过将计算任务分散到不同的设备(如CPU和GPU)来加速模型的训练过程。TensorFlow的核心组件包括以下几个部分:

- **客户端(Client)**: 客户端负责构建计算图,定义变量、占位符以及操作,它是训练任务的发起点。

- **参数服务器(Parameter Server)**: 用于存储全局模型参数,并负责梯度的聚合。参数服务器是分布式训练中非常关键的部分。

- **工作节点(Worker)**: 执行实际计算任务的节点,它们可以是单一节点或者由多个GPU和CPU组成的集群。每个工作节点可能同时执行多个任务。

### 2.1.2 分布式训练的数据流和通信机制

分布式训练的数据流和通信机制确保了模型训练的有效性与效率。在TensorFlow 2.0中,使用了如下的数据流和通信机制:

- **数据流**: 在数据并行训练中,每个工作节点接收输入数据的子集,并运行前向传播和反向传播。梯度在工作节点间同步。

- **通信机制**: 通过参数服务器进行参数的更新和同步。工作节点在梯度聚合后,将更新后的梯度发送给参数服务器,然后由参数服务器广播到所有工作节点。

```mermaid

flowchart LR

A[客户端] -->|定义模型| B[参数服务器]

B -.-> |广播参数| C[工作节点1]

B -.-> |广播参数| D[工作节点2]

C -->|梯度更新| B

D -->|梯度更新| B

```

在此流程中,客户端负责定义模型和训练参数,然后将任务分发到不同的工作节点。工作节点在完成计算后,通过参数服务器同步更新的参数。

## 2.2 安装和配置TensorFlow 2.0集群

### 2.2.1 环境依赖和版本兼容性

安装TensorFlow 2.0集群之前,需要确保系统的环境依赖得到满足,并检查TensorFlow版本的兼容性。以下是一些关键依赖项:

- **Python**: 需要Python 3.x版本。

- **操作系统**: 支持Linux、Windows和Mac OS X。

- **TensorFlow版本**: 确保所有工作节点和参数服务器上安装的TensorFlow版本保持一致。

### 2.2.2 集群配置步骤和参数解析

TensorFlow集群配置涉及设置集群的类型、数量以及工作节点的角色。配置通常在启动工作节点和参数服务器的进程中完成:

```python

cluster_spec = tf.train.ClusterSpec({

'worker': ['localhost:2222', 'another_machine:2222'],

'ps': ['localhost:2223', 'another_machine:2223']

})

server = tf.train.Server(cluster_spec, job_name="worker", task_index=0)

```

### 2.2.3 集群通信和监控工具使用

有效的集群通信和监控是确保分布式训练稳定运行的关键。TensorFlow 2.0提供了多种工具和API来帮助监控和调试集群状态:

- **TensorBoard**: 可以用来监控训练过程中的各种指标。

- **tf.distribute.Strategy**: 这是一个高级API,用于设置分布式训练策略。

- **tf.keras**: TensorFlow的高级API,对分布式训练提供了原生支持。

## 2.3 分布式训练的策略和技巧

### 2.3.1 GPU与CPU混合训练策略

在GPU资源有限的情况下,可以使用CPU与GPU混合训练策略来提高训练效率。关键点如下:

- **任务分配**: 将模型的不同部分分配给GPU或CPU,例如,将数据预处理放在CPU上执行,而将模型运算放在GPU上。

- **数据流优化**: 确保数据在GPU与CPU间高效流转,减少I/O瓶颈。

### 2.3.2 内存和资源管理技巧

管理好内存和资源对于分布式训练至关重要。有效管理技巧包括:

- **内存池化**: 利用内存池来管理内存分配,减少内存碎片。

- **资源动态调整**: 使用TensorFlow的自动资源管理功能,动态地根据负载分配资源。

```python

# 示例代码:动态资源分配

# 这里是使用tf.resource_variable_ops.ResourceVariable来创建可动态调整大小的变量

# 其他资源管理细节根据具体框架和API来调整

def create_dynamic_variable():

return tf.Variable(tf.zeros([1024, 1024]), trainable=False, collections=[tf.VariableSynchronization.OFF, tf.VariableChecksums.OFF])

```

### 2.3.3 异常处理和稳定性优化

在分布式训练中,异常处理和稳定性优化是不可忽视的。常见措施包括:

- **容错机制**: 设置超时重试机制,处理节点故障。

- **状态备份**: 定期备份训练状态,以防崩溃导致的进度丢失。

```python

# 示例代码:异常处理策略

try:

# 运行训练循环

except tf.errors.OpError as e:

# 处理TensorFlow操作错误

print("A TensorFlow operation failed: ", e)

except Exception as e:

# 处理其他类型的错误

print("An unexpected error occurred: ", e)

else:

# 训练成功完成

print("Training completed successfully.")

finally:

# 清理资源

print("Cleaning up resources.")

```

以上详细介绍了TensorFlow 2.0分布式训练环境搭建的过程,从架构解析、集群配置到执行策略和异常处理。在理解这些基础内容后,我们将进一步探索分布式训练的实践技巧。

# 3. 分布式训练的实践技巧

在深入理解分布式训练的基础理论和环境搭建之后,本章节将探索实践中提升分布式训练效果的关键技巧。我们将深入探讨数据并行与模型并行的技术细节,混合精度训练带来的优势,以及如何通过性能调优进一步提升训练效率。

## 数据并行与模型并行

### 数据并行的工作原理和实践

数据并行是分布式训练中最常见的一种策略,它通过将数据集分割成小块并分布到不同的计算节点上来实现。每个节点拥有完整的模型副本,并对分配到的数据块进行训练,然后将梯度同步更新。

#### 实践数据并行的步骤

1. **数据集分割**:将整个数据集分割成多个部分,每个数据部分对应一个节点上的批次。

2. **模型复制**:在每个计算节点上复制模型参数。

3. **训练与梯度聚合**:每个节点独立执行前向和反向传播,计算梯度,并将梯度发送到参数服务器。

4. **梯度同步更新**:参数服务器聚合所有节点的梯度,更新全局模型参数,再将更新后的模型参数广播给所有节点。

5. **同步与迭代**:重复上述步骤直至模型收敛。

数据并行的关键在于梯度同步机制,通常使用诸如Parameter Server、Ring-Allreduce等技术。

### 模型并行的策略和案例分析

模型并行则侧重于将模型的不同部分分配给不同的计算资源,适用于模型过于庞大无法一次性加载到单个计算节点的情况。

#### 模型并行的策略

- **层并行**:将模型的不同层分配到不同的计算设备。

- **管道并行**:将模型前向和反向传播分成多个阶段,在不同节点上顺序执行,这种策略适合在多GPU节点间进行。

#### 案例分析

一个实际的案例是在训练大型语言模型时,由于模型参数数量巨大,通常会采用模型并行策略。例如,BERT超大型模型在训练过程中就采用了模型并行,以分散内存压力和加速计算。

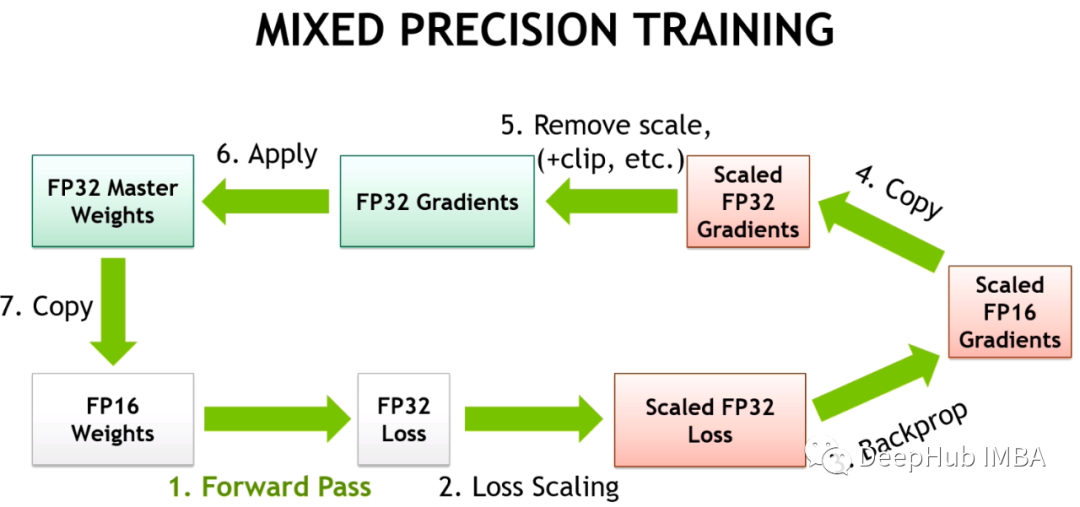

## 混合精度训练

### 混合精度训练的原理

混合精度训练是一种利用半精度浮点数(FP16)来加速和提高训练效率的技术。它减少了模型占用的内存和带宽需求,同时可以利用现代GPU的Tensor Core加速运算。

#### 实现混合精度训练的步骤

1. **环境配置**:确保GPU和框架支持FP16操作。

2. **混合精度策略**:将模型的权重和激活从FP32转换为FP16,同时保持某些操作如梯度累积在FP32中进行以保证数值稳定性。

3. **动态损失缩放**:在训练过程中动态调整缩放因子,以避免FP16数值范围限制导致的梯度消失问题。

### 混合精度训练的优势与局限

混合精度训练可以显著提升训练速度,尤其是在支持Tensor Core的GPU上。但其局限性在于可能需要更仔细地调整超参数,并且不所有的模型或问题都适合使用混合精度训练。

## 分布式训练的性能调优

#

0

0