TensorFlow 2.0回调函数:监控、调试训练过程的最佳实践

发布时间: 2025-01-10 10:39:03 阅读量: 6 订阅数: 8

# 摘要

本文全面介绍了TensorFlow 2.0中回调函数的概念、类型及其在模型训练中的应用和重要性。通过阐述回调函数的基本原理,深入探讨了TensorFlow内置的回调函数功能,如模型权重保存、过拟合预防和学习率调整。进一步地,本文详细说明了如何创建和应用自定义回调函数来监控训练过程中的关键指标、调试、日志记录以及超参数调整。最后,本文分析了回调函数在多GPU训练、训练中断恢复以及自动化训练流程等高级场景中的应用,并通过案例研究提出了回调函数的最佳实践和解决方案。

# 关键字

TensorFlow 2.0;回调函数;模型训练;超参数优化;多GPU;自动化训练

参考资源链接:[FLAC 3D收敛标准详解:理解数值分析中的关键要素](https://wenku.csdn.net/doc/ycuz67adqq?spm=1055.2635.3001.10343)

# 1. TensorFlow 2.0回调函数概述

在TensorFlow 2.0中,回调函数作为训练循环的重要组成部分,为机器学习工程师提供了一个强大的机制,以便在训练过程的不同阶段插入自定义的操作。通过回调函数,我们可以灵活地控制和监控模型的学习过程,包括但不限于保存模型状态、调整学习率、提前终止训练以及增加额外的评估和监控指标。

回调函数通常被用来执行以下任务:

- **模型状态的定期保存**,如每隔一定周期保存一次最佳模型。

- **超参数的动态调整**,如在训练过程中基于某些指标调整学习率。

- **提前终止训练**,如果模型的性能不再提升,则停止训练以节省计算资源。

- **监控和记录训练过程中的各种指标**,以便于后续分析。

在下一章节中,我们将深入探讨回调函数的工作原理和类型,并通过TensorFlow 2.0内置的回调函数来展示它们在实际训练中的应用。通过具体的案例分析,我们将逐步揭开回调函数的神秘面纱,并展示如何通过回调函数来优化模型训练过程。

# 2. 深入理解回调函数在训练中的作用

### 2.1 回调函数基本概念与原理

#### 2.1.1 回调函数定义及其重要性

回调函数是 TensorFlow 2.0 中提供的一种灵活机制,它允许在训练的特定阶段插入自定义代码,从而实现对训练过程的精确控制和监控。简单来说,回调函数是一段在模型训练的某个步骤(如每个epoch结束时)自动调用的代码。

回调函数的重要性在于它们提供了模型训练过程的可控性。在深度学习中,训练过程可能需要数小时甚至数天,因此能够实时监控训练进度、保存最佳模型、调整超参数、早期停止过拟合等问题至关重要。回调函数是实现这些高级特性的一种工具。

#### 2.1.2 TensorFlow 2.0中回调函数的类型与用途

TensorFlow 2.0 提供了几种不同类型的回调函数,每种都有其特定用途:

- **ModelCheckpoint**: 用于周期性地保存模型的当前权重。这样可以防止训练中断导致的全部工作丢失,并且可以用于实现早停(early stopping)。

- **EarlyStopping**: 监控指定的性能指标,一旦性能不再提升,就会停止训练。这避免了过拟合,并节省了计算资源。

- **ReduceLROnPlateau**: 学习率调整策略。当监控的指标停止提升时,它会减少学习率,以帮助模型跳出局部最小值。

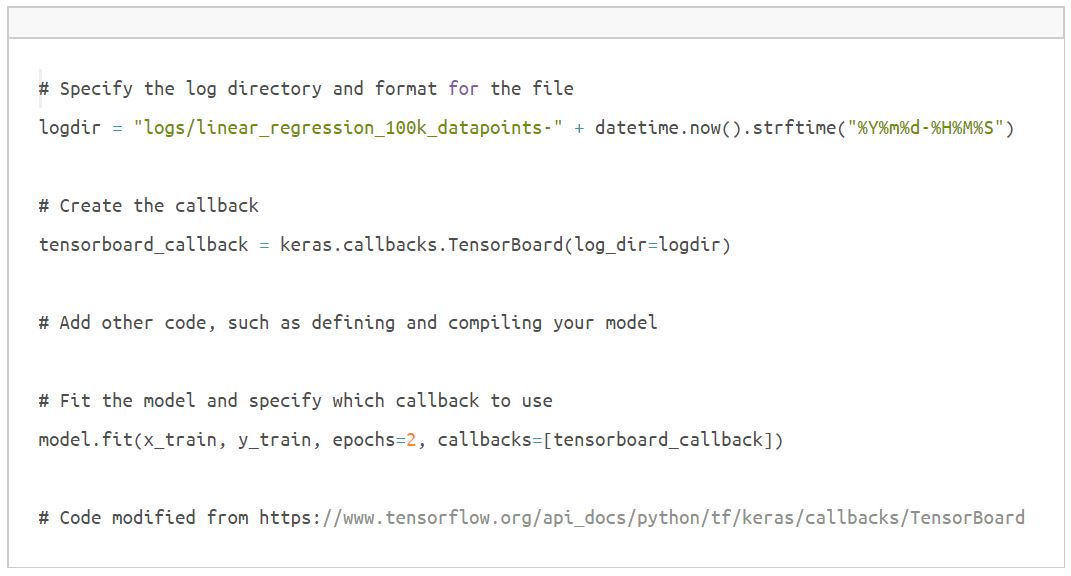

- **TensorBoard**: 提供可视化工具,将训练过程中的各种指标记录下来,方便后续分析。

- **CSVLogger**: 将训练过程中的损失值和性能指标写入CSV文件,便于日后的回溯和分析。

### 2.2 TensorFlow 2.0内置回调函数详解

#### 2.2.1 ModelCheckpoint与权重保存

`ModelCheckpoint` 允许用户指定一个路径来保存模型的权重。这在长周期训练和需要中断恢复的情况下特别有用。使用示例如下:

```python

from tensorflow.keras.callbacks import ModelCheckpoint

checkpoint = ModelCheckpoint('best_model.h5', save_best_only=True, monitor='val_loss', mode='min')

model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val), callbacks=[checkpoint])

```

在上面的代码中,`ModelCheckpoint` 被设置为在验证集损失最低时保存模型。参数 `save_best_only=True` 确保只有在性能改善时才会保存模型。`monitor='val_loss'` 表示监控验证集损失值。`mode='min'` 指定当监控的指标达到最小值时触发保存操作。

#### 2.2.2 EarlyStopping与过拟合预防

`EarlyStopping` 是一个用来预防过拟合的回调函数。通过设置一定的停止条件,它可以在验证性能不再提升时停止训练。以下是使用 `EarlyStopping` 的一个例子:

```python

from tensorflow.keras.callbacks import EarlyStopping

early_stopping = EarlyStopping(monitor='val_loss', patience=3, verbose=1)

model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val), callbacks=[early_stopping])

```

在代码中,`monitor='val_loss'` 表示监控验证集上的损失值。`patience=3` 指定了在等待性能提升时容忍的训练轮数。如果超过这个数值,训练将停止。`verbose=1` 表示在控制台上打印信息。

#### 2.2.3 ReduceLROnPlateau与学习率调整

学习率调整策略 `ReduceLROnPlateau` 是一种能够在学习停滞时自动降低学习率的回调函数。其目的是让模型在局部最小值附近进行更细致的搜索。使用示例如下:

```python

from tensorflow.keras.callbacks import ReduceLROnPlateau

reduce_lr = ReduceLROnPlateau(monitor='val_loss', factor=0.2, patience=2, verbose=1)

model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val), callbacks=[reduce_lr])

```

在这里,`monitor='val_loss'` 表示监控验证集损失值。`factor=0.2` 表示当触发时学习率将变为原来的0.2倍。`patience=2` 表示在两次性能提升之间等待两个epoch。如果在这两个epoch之后没有性能提升,则降低学习率。

### 2.3 自定义回调函数的创建与应用

#### 2.3.1 编写自定义回调函数的步骤

要创建自定义回调函数,需要继承 `tf.keras.callbacks.Callback` 基类,并重写以下关键方法:

- `on_train_begin(self, logs=None)`: 在训练开始时调用。

- `on_train_end(self, logs=None)`: 在训练结束时调用。

- `on_epoch_begin(self, epoch, logs=None)`: 在每个epoch开始时调用。

- `on_epoch_end(self, epoch, logs=None)`: 在每个epoch结束时调用。

- `on_batch_begin(self, batch, logs=None)`: 在每个批次开始时调用。

- `on_batch_end(self, batch, logs=None)`: 在每个批次结束时调用。

自定义回调函数的一个简单例子如下:

```python

class CustomCallback(tf.keras.callbacks.Callback):

def on_epoch_end(self, epoch, logs=None):

if logs.get('loss') < 0.6:

self.model.stop_training = True

```

上面的代码定义了一个简单的回调函数,其作用是当损失值小于0.6时停止训练。

#### 2.3.2 实际案例:自定义监控指标的回调函数

假设我们想要监控模型在训练过程中的预测准确性,并将它保存到CSV文件中。我们可以自定义一个回调函数来完成这一任务:

```python

import pandas as pd

from tensorflow.keras.callbacks import Callback

class AccuracyCallback(Callback):

def __init__(self, validation_data=(), interval=1):

super(AccuracyCallback, self).__init__()

self.interval = interval

self.X_val, self.y_val = validation_data

self.data = []

def on_epoch_end(self, epoch, logs={}):

if epoch % self.interval == 0:

y_pred = self.model.predict(self.X_val, verbose=0)

acc = self.calculate_accuracy(self.y_val, y_pred)

self.data.append((epoch, acc))

print(f"Accuracy at epoch {epoch} is {acc}")

def calculate_accuracy(self, y_true, y_pred):

y_pred_classes = np.argmax(y_pred, axis=1)

y_true_classes = np.argmax(y_true, axis=1)

return np.mean(y_pred_classes == y_true_classes)

def get_accuracy(self):

return pd.DataFrame(self.data, columns=['epoch', 'accuracy'])

# 使用示例

accuracy_callback = AccuracyCallback(validation_data=(x_val, y_val), interval=1)

model.fit(x_train, y_train, epochs=10, validation_d

```

0

0