【中间件选型】:Go开发者视角下的Kafka与RabbitMQ对比分析

发布时间: 2024-10-22 14:03:43 阅读量: 25 订阅数: 19

MQ选型之RabbitMQ

# 1. 中间件基础与选型原则

在现代IT架构中,中间件扮演着至关重要的角色。它位于操作系统和应用软件之间,为应用软件提供了通用的服务,简化了软件的开发和维护。中间件通常包括消息队列、数据库、缓存等。本章将对中间件的基础知识进行概述,并探讨选择中间件时应考虑的关键原则。

## 1.1 中间件的定义与功能

中间件是软件应用程序的一部分,它处于操作系统和应用程序之间,提供服务给应用软件使用。这些服务包括但不限于数据访问、消息传递、事务处理等。中间件抽象了底层平台的复杂性,使得开发者可以集中精力在业务逻辑的实现上。

## 1.2 中间件的分类

中间件按照其功能可以分为消息中间件、分布式对象中间件、数据访问中间件等。消息中间件如Kafka、RabbitMQ等,被广泛应用于系统间的异步通信和数据流处理。

## 1.3 中间件选型原则

选择合适的中间件需要考虑多个因素,包括但不限于应用的性能要求、可用性、易用性、社区支持等。在高性能和低延迟的应用场景中,通常会选择Kafka这类消息中间件。而对于需要保证消息不丢失的应用,RabbitMQ可能是更好的选择。

接下来的章节,我们将深入探索Kafka和RabbitMQ的核心原理和应用实践,以及如何根据不同的业务需求做出合适的技术选型。

# 2. Kafka核心原理与应用实践

## 2.1 Kafka架构概述

### 2.1.1 Kafka的基本组件和工作流程

Apache Kafka是一个分布式流处理平台,主要用于构建实时数据管道和流应用程序。它具备高吞吐量、可扩展性、持久性和可靠性等特点。Kafka的基本组件包括生产者(Producer)、消费者(Consumer)、代理(Broker)、主题(Topic)和分区(Partition)。

Kafka工作流程是这样的:首先,生产者将数据发送到Kafka集群中的一个或多个主题。接着,这些数据被追加到主题的分区中,每个分区都在一个或多个代理上进行复制。消费者订阅主题并从分区中拉取数据。由于分区可以分布在多个代理上,因此可以通过并行处理来提高吞吐量。这种架构设计使得Kafka能够处理大量的数据,并且保证了数据处理的可伸缩性和高可用性。

在Kafka中,为了实现高效的数据处理,生产者可以使用异步发送的方式来减少网络延迟和提高吞吐量。同时,消费者组机制允许多个消费者实例共享一个主题的订阅,实现负载均衡和故障转移。

### 2.1.2 Kafka的存储机制与数据复制

Kafka的数据存储机制是基于分区的。每个主题可以划分成多个分区,分区内的消息是有序的,但是不同分区之间并不保证顺序。数据复制机制保证了Kafka的高可用性,当一个代理出现故障时,分区副本仍然可以在其他代理上继续提供服务。

Kafka中的副本机制遵循领导者和追随者的模型。每个分区都有一个领导者副本(Leader)和多个追随者副本(Follower)。生产者只与领导者副本通信,而追随者副本会从领导者副本同步数据。当领导者副本不可用时,其中一个追随者副本会被选举为新的领导者,确保了数据的持续可用性。

Kafka通过一个称为“_ISR(In-Sync Replicas)”的集合来跟踪追随者的状态。ISR中的追随者副本必须保证与领导者副本的数据同步。如果ISR中的副本数量下降到某个阈值以下,那么这个分区就会变得不可用,以防止数据丢失或不一致。

## 2.2 Kafka的高级特性

### 2.2.1 消费者组和分区机制

消费者组是Kafka支持大规模并发消费的关键机制。消费者组由一组消费者实例组成,这些实例共同消费一个或多个主题的消息。通过将主题分区,Kafka能够将数据负载均衡地分配给消费者组中的各个消费者,实现并行处理。

Kafka中的分区机制允许不同的消费者实例从不同的分区中独立消费数据。每个消费者实例负责消费一个或多个分区的消息,并且在消费过程中维护一个偏移量(Offset),以记录当前消费到的位置。这种设计允许Kafka实现无状态的消费者,也便于消息的顺序处理和并行处理。

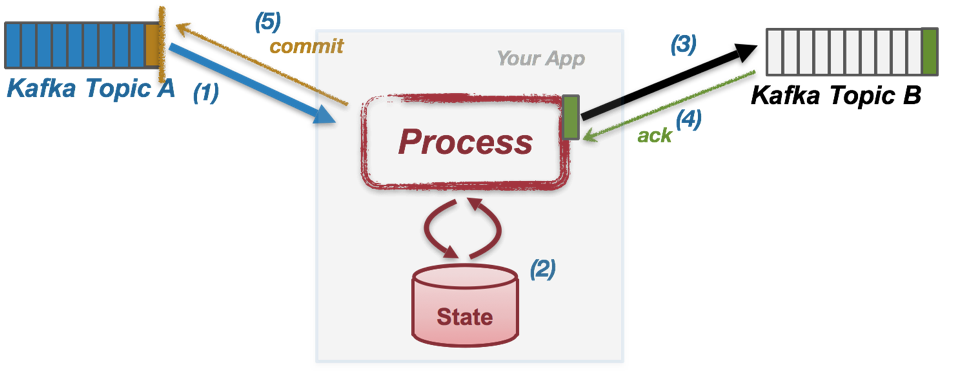

### 2.2.2 Kafka Streams与实时数据处理

Kafka Streams是Kafka提供的一个客户端库,用于构建实时数据处理和分析应用程序。它利用Kafka的分区和消费者组机制,能够方便地处理数据流,并支持复杂的转换和聚合操作。

Kafka Streams采用事件时间(Event Time)和处理时间(Processing Time)来处理流式数据。事件时间依赖于消息本身携带的时间戳,能够解决时区和网络延迟带来的问题。处理时间则是指消息在流处理应用中被处理时的时间戳。

Kafka Streams还提供了状态存储(State Store)功能,使得应用程序可以保存和查询状态信息。状态存储可以与Kafka主题交互,支持数据的持久化和恢复。结合窗口(Window)机制,Kafka Streams可以对数据进行时间维度的聚合计算,例如在固定时间间隔内计算数据的总和、平均值等统计信息。

## 2.3 Kafka实战应用案例

### 2.3.1 实现大规模数据管道

在大规模数据管道的实现中,Kafka常常被用来作为不同系统之间数据传输的媒介。例如,在一个电商平台上,用户的行为数据需要从网站服务器实时传输到分析系统中,然后进行数据挖掘和用户画像的构建。

为了实现这个过程,可以配置Kafka集群来接收来自网站服务器的生产者发送的消息。消息中包含了用户的行为数据,如点击流、购买记录等。这些消息被发送到指定的主题上,然后由分析系统的消费者组负责消费这些消息,并将数据存储到数据库或数据仓库中。

在这个案例中,Kafka集群需要具备高吞吐量和低延迟的特性,以应对大规模的数据流。分区机制在这个场景中起到了关键的作用,确保了数据处理的可伸缩性和容错性。同时,由于数据的重要性,还应该对Kafka集群进行适当的配置,以保证数据的持久性和可靠性。

### 2.3.2 构建实时数据处理平台

实时数据处理平台要求能够快速响应输入数据并产生结果。Kafka在其中的作用是作为数据的接收者和分发者。在构建这样的平台时,Kafka Streams可以被用来开发流处理应用,对实时数据进行处理和分析。

例如,一个实时推荐系统可以使用Kafka来接收用户的行为数据,并使用Kafka Streams进行实时分析,根据用户的行为特征推荐相应的产品。在这个场景中,消息首先会被发送到Kafka,然后被Kafka Streams应用消费,进行数据处理和分析。

为了保证低延迟和高吞吐量,推荐系统的Kafka集群配置和分区策略需要特别设计。可以为不同的数据源配置不同的主题,并根据数据处理的需求设置合适的副本数量和ISR策略。此外,Kafka Streams应用的线程模型和状态存储机制也需要进行优化,以适应实时数据处理的需求。

请注意,本章节的剩余部分及后续章节将根据上述提供的结构和要求继续撰写。

# 3. RabbitMQ核心原理与应用实践

## 3.1 RabbitMQ架构与机制

### 3.1.1 RabbitMQ的基本组成与消息模型

RabbitMQ是一款开源的消息代理软件,它实现了高级消息队列协议(AMQP)。RabbitMQ的架构设计使其能够处理各种消息传递场景,包括异步消息处理、服务间消息传递、分布式系统组件间的通信等。

RabbitMQ的基本组成包括交换机(Exchanges)、队列(Queues)、绑定(Bindings)和消息(Messages)。

- **消息(Messages)**:消息是应用程序之间交换的数据单元。

- **队列(Queues)**:队列是消息的存储地,它是消息的缓冲区,保证消息的可靠存储直到消费端进行处

0

0