神经网络引擎:强化学习的魅力,让机器在互动中学习,解锁人工智能的无限可能

发布时间: 2024-07-13 04:23:48 阅读量: 40 订阅数: 25

# 1. 神经网络引擎:强化学习的理论基础**

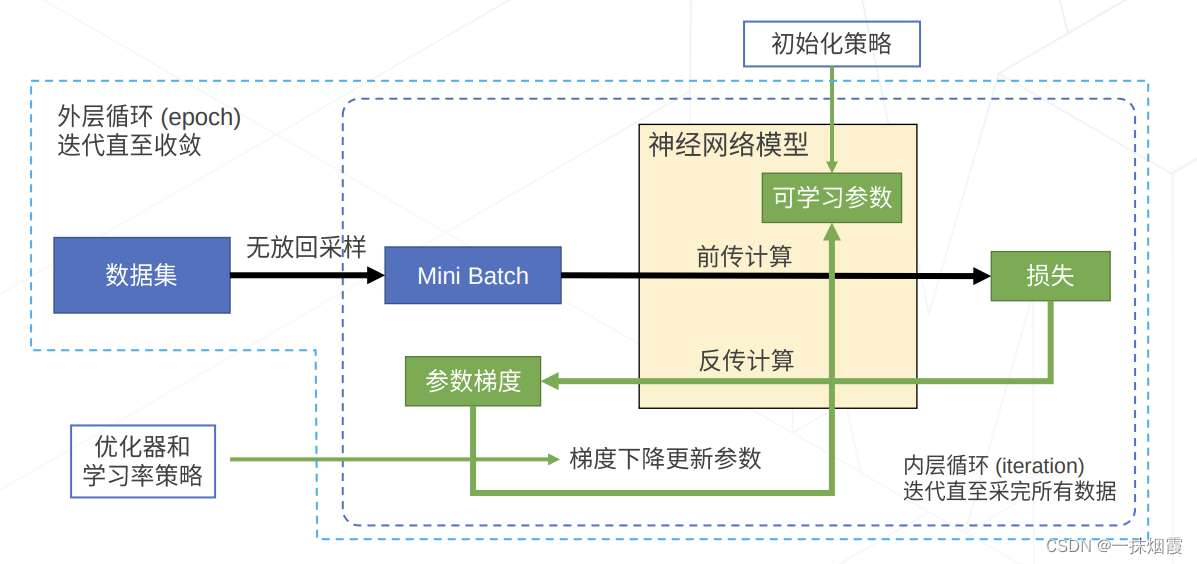

强化学习是一种机器学习范式,它允许智能体通过与环境的交互来学习最佳行为策略。神经网络引擎在强化学习中扮演着至关重要的角色,它为智能体提供了强大的函数逼近能力,使其能够从高维输入中学习复杂的行为模式。

神经网络引擎的层级结构允许智能体提取环境特征并预测未来奖励。通过反向传播算法,神经网络引擎可以调整其权重,以最小化预测奖励与实际奖励之间的差异。这种机制使智能体能够随着时间的推移优化其策略,从而最大化长期奖励。

在强化学习中,神经网络引擎通常用于表示值函数或策略函数。值函数估计每个状态的预期未来奖励,而策略函数根据当前状态确定智能体的行为。通过结合神经网络引擎的函数逼近能力和强化学习的试错学习,智能体可以学习复杂的环境并制定有效的行为策略。

# 2. 从基础到进阶

### 2.1 强化学习算法概述

#### 2.1.1 Q学习

**定义:**

Q学习是一种无模型的强化学习算法,它通过学习一个动作价值函数 Q(s, a) 来确定在每个状态 s 下采取动作 a 的价值。

**算法流程:**

1. 初始化 Q(s, a) 为任意值。

2. 在当前状态 s 下,选择一个动作 a。

3. 执行动作 a 并观察下一个状态 s' 和奖励 r。

4. 更新 Q(s, a) 为:

```python

Q(s, a) = Q(s, a) + α * (r + γ * max_a' Q(s', a') - Q(s, a))

```

其中:

* α 是学习率

* γ 是折扣因子

* max_a' Q(s', a') 是在下一个状态 s' 下所有可能动作 a' 的最大动作价值

**参数说明:**

* **学习率(α):**控制更新幅度,较高的学习率会导致更快的学习,但可能导致不稳定。

* **折扣因子(γ):**控制未来奖励的权重,较高的折扣因子会赋予未来奖励更大的价值。

**逻辑分析:**

Q学习通过不断更新 Q(s, a) 值,学习在每个状态下采取最佳动作的价值。它通过考虑当前奖励和未来奖励的折扣值来平衡探索和利用。

#### 2.1.2 策略梯度方法

**定义:**

策略梯度方法是一种有模型的强化学习算法,它通过直接优化策略函数 π(a|s) 来最大化奖励期望值。

**算法流程:**

1. 初始化策略函数 π(a|s)。

2. 采样一组轨迹,每个轨迹由状态-动作对 (s, a) 和奖励 r 组成。

3. 计算策略梯度:

```python

∇_π J(π) = E[(r - V(s)) * ∇_π log π(a|s)]

```

其中:

* J(π) 是奖励期望值

* V(s) 是状态 s 的值函数

* ∇_π log π(a|s) 是策略函数关于动作 a 的梯度

4. 更新策略函数:

```python

π(a|s) = π(a|s) + α * ∇_π J(π)

```

**参数说明:**

* **学习率(α):**控制更新幅度,较高的学习率会导致更快的学习,但可能导致不稳定。

**逻辑分析:**

策略梯度方法通过直接优化策略函数,学习如何采取动作以最大化奖励期望值。它不需要学习值函数,但需要采样轨迹来估计策略梯度。

# 3.1 深度神经网络在强化学习中的应用

深度神经网络(DNN)在强化学习中扮演着至关重要的角色,为复杂环境和高维输入提供强大的特征提取和表示能

0

0