神经网络引擎:神经网络的训练与优化,探索高效训练的秘诀,加速人工智能的落地应用

发布时间: 2024-07-13 04:27:26 阅读量: 112 订阅数: 29

# 1. 神经网络引擎概述**

神经网络引擎是一种强大的计算架构,专为处理复杂非线性数据而设计。它由大量相互连接的处理单元组成,称为神经元。这些神经元可以学习从数据中提取特征,并执行复杂的决策。

神经网络引擎的结构类似于人脑,它由输入层、隐藏层和输出层组成。输入层接收数据,隐藏层处理数据并提取特征,输出层生成预测或决策。神经元之间的连接权重是可学习的,通过训练数据进行调整,以优化网络的性能。

神经网络引擎被广泛应用于各种领域,包括图像识别、自然语言处理、机器学习和预测建模。它们能够处理大量数据,并从中识别复杂模式,从而为各种任务提供强大的解决方案。

# 2. 神经网络训练理论

### 2.1 神经网络的结构与原理

#### 2.1.1 人工神经元的模型

人工神经元是神经网络的基本单元,其结构和功能模拟了生物神经元。它接收多个输入信号,对这些信号进行加权求和,并通过一个激活函数产生输出。

```python

import numpy as np

class Neuron:

def __init__(self, weights, bias, activation_function):

self.weights = weights

self.bias = bias

self.activation_function = activation_function

def forward(self, inputs):

"""

正向传播函数,计算神经元的输出。

参数:

inputs:输入信号,是一个numpy数组。

返回:

输出信号,是一个标量。

"""

weighted_sum = np.dot(self.weights, inputs) + self.bias

output = self.activation_function(weighted_sum)

return output

```

#### 2.1.2 神经网络的层级结构

神经网络通常由多个神经元层组成,每一层的神经元接收上一层神经元的输出作为输入。层与层之间通过权重连接,形成一个复杂的网络结构。

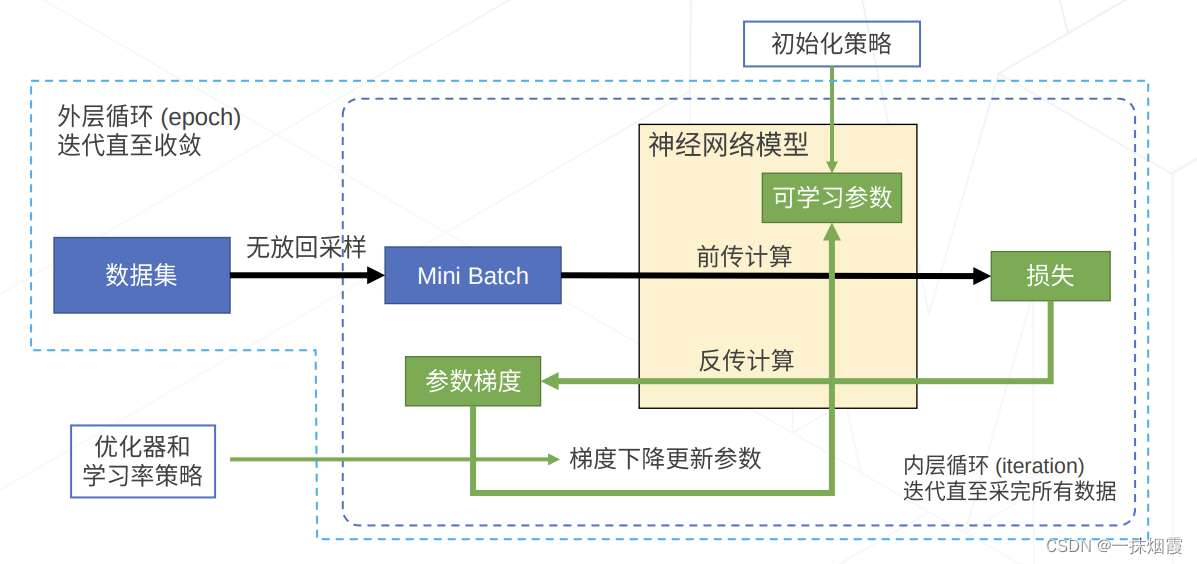

### 2.2 神经网络的训练算法

#### 2.2.1 梯度下降算法

梯度下降算法是神经网络训练中最常用的优化算法。它通过不断更新网络中的权重,使网络的损失函数最小化。

```python

import numpy as np

def gradient_descent(model, loss_function, learning_rate, num_iterations):

"""

梯度下降算法,更新网络中的权重。

参数:

model:神经网络模型。

loss_function:损失函数。

learning_rate:学习率。

num_iterations:迭代次数。

"""

for i in range(num_iterations):

# 正向传播,计算网络输出。

outputs = model.forward(inputs)

# 计算损失函数。

loss = loss_function(outputs, targets)

# 反向传播,计算梯度。

gradients = model.b

```

0

0