HDFS心跳机制的故障转移过程:数据节点宕机无缝切换的高招

发布时间: 2024-10-29 17:07:17 阅读量: 44 订阅数: 45

【HDFS篇08】NameNode故障处理1

# 1. HDFS心跳机制概述

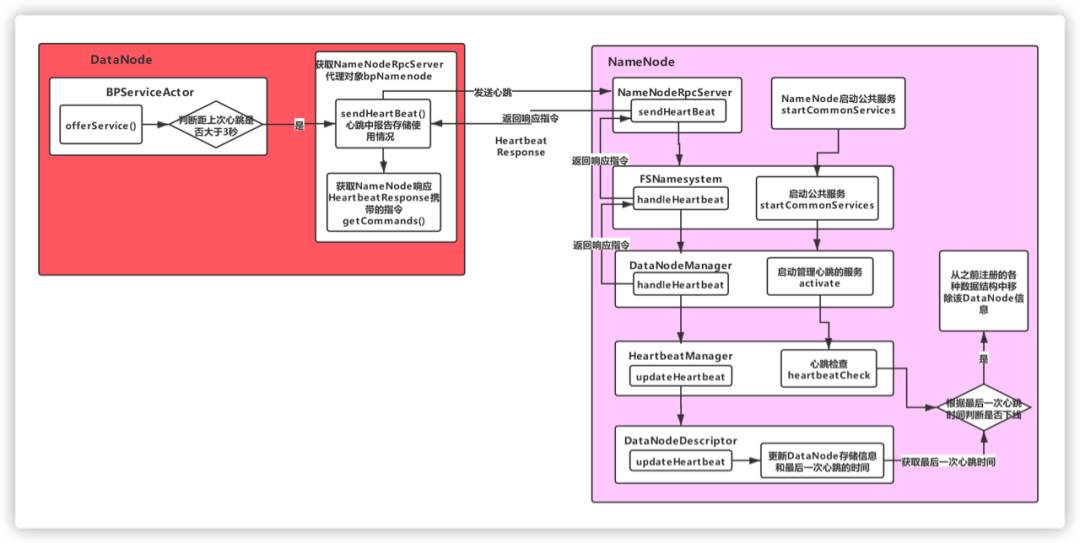

Hadoop分布式文件系统(HDFS)作为大数据存储的核心组件之一,其心跳机制是保证数据节点(DataNode)健康状态的关键。心跳信号作为数据节点向名称节点(NameNode)定期发送的存活证明,确保了集群的稳定运行。本章将介绍心跳机制的基本原理,以及它如何在HDFS中工作,为后续章节深入了解数据节点宕机的影响、故障转移机制以及高可用性架构改进提供理论基础。

# 2. 数据节点宕机的影响

Hadoop分布式文件系统(HDFS)是构建在普通硬件之上的具有高可靠性的分布式文件系统。它的设计目的是能够跨多个数据节点存储大量数据,同时确保数据的高可用性。HDFS通过数据节点(DataNode)的冗余来应对单点故障。然而,当数据节点发生故障时,系统会遭遇一些挑战,我们必须了解这些问题并采取相应的措施来保证数据的完整性和可用性。

## 2.1 HDFS中的数据节点角色

### 2.1.1 数据节点的基本功能

数据节点是HDFS集群中负责实际存储数据的节点。它们接收来自客户端或NameNode的请求,对文件系统中的文件进行实际的读写操作。数据节点以块的形式存储数据,这些数据块被分散存储在不同的节点上,从而实现数据的冗余。

每个数据节点运行在单独的主机上,负责维护其上存储的数据块。这些数据块可能会被复制多次,以确保数据的高可用性。此外,数据节点还会参与数据的创建、删除和复制等操作,并执行块的创建、删除和重新复制以平衡存储负载。

### 2.1.2 数据节点与NameNode的通信

数据节点与NameNode的通信对于保持HDFS状态至关重要。NameNode负责管理文件系统的命名空间,维护文件系统树及整个树内所有的文件和目录。这种管理是通过监听各个数据节点的报告来实现的,每个数据节点会定期向NameNode发送心跳信号和块报告。

数据节点在启动时会向NameNode注册并报告其上存储的所有块信息。一旦注册,数据节点会定期向NameNode发送心跳信号,以证明它们还在正常工作。在正常的操作过程中,数据节点会响应来自NameNode的指令,并在完成操作后返回状态信息。

## 2.2 故障转移前的数据一致性问题

### 2.2.1 心跳失效的检测机制

心跳机制是HDFS检测节点状态的关键。正常工作中的数据节点会周期性地向NameNode发送心跳信号,表明它还活着。如果一个数据节点停止发送心跳信号超过了设定的时间阈值(通常是几分钟),NameNode将认为该数据节点已经宕机。

一旦检测到数据节点失效,NameNode会更新文件系统的元数据,将失效节点上的数据块标记为不可用,并启动故障转移过程。在故障转移之前,必须确保数据的一致性,否则可能会在系统中造成不一致的状态。

### 2.2.2 数据复制和校验过程

在故障转移前,HDFS将确保数据的副本数量满足预定的要求。为此,HDFS会自动启动数据复制过程,从其他活跃的数据节点复制数据块到集群中的其他节点。

复制过程会涉及到数据校验,以确保复制的数据没有损坏。HDFS使用校验和机制来验证数据的一致性。在写入和读取数据时,客户端会计算数据的校验和并将其与数据一起存储。当数据被读取时,会再次计算校验和以确认数据的完整性。如果校验和不匹配,表明数据在复制过程中可能已经损坏,此时会自动启动一个新的复制过程,直到数据的一致性得到保证。

数据节点宕机对于HDFS的正常运作是一个严重的问题,它可能会威胁到数据的可用性和一致性。然而,通过心跳机制和数据复制等机制,HDFS能够在检测到节点失效时快速做出反应,启动故障转移过程,以最小化宕机事件对系统的影响。接下来的章节将会探讨故障转移机制的理论基础,深入了解HDFS是如何处理数据节点失效情况的。

# 3. 故障转移的实践操作

故障转移不仅在理论上要有一个坚实的基础,而且在实践中也应该有明确的操作指导和监控机制,以确保在数据节点宕机时,系统能够迅速并且可靠地进行故障转移。本章节将深入探讨如何进行故障转移的实践操作。

## 3.1 配置故障转移的相关参数

### 3.1.1 HDFS配置文件详解

故障转移策略的有效实施,很大程度上依赖于HDFS配置文件中的相关参数设置。其中最核心的参数包括心跳超时阈值(dfs心跳超时阈值)、故障节点的替换策略以及数据重新平衡的策略。通过调整这些参数,我们可以控制故障转移的行为,优化系统的稳定性和数据的安全性。

- dfs心跳超时阈值:此参数定义了一个数据节点多久没有发送心跳到NameNode后被认为是宕机。该值的设置应该根据实际的网络环境和硬件性能来决定,以避免因网络波动导致的误判。

- 故障节点的替换策略:当检测到故障节点后,系统需要按照一定的策略来选择一个合适的副本节点来替换故障节点。通常选择副本因子最多的节点,或者是最新的数据副本节点。

- 数据重新平衡策略:故障节点的数据需要被重新分配到其他节点,以达到数据均衡。这涉及到数据迁移的策略,需要平衡数据迁移速度和对集群性能的影响。

### 3.1.2 故障转移策略的自定义

自定义故障转移策略可以通过配置文件或编程接口实现。在HDFS中,可以创建自定义的故障转移类,该类继承自Hadoop的默认故障转移类,并在其中实现自定义的逻辑。例如,我们可以编写代码来增加对节点故障的判定逻辑,从而只在多个条

0

0