HDFS心跳机制与数据副本策略:协同工作确保数据安全的秘诀

发布时间: 2024-10-29 17:04:17 阅读量: 4 订阅数: 15

# 1. HDFS的基本概念与架构

Hadoop分布式文件系统(HDFS)是Hadoop项目的基石,它为大数据存储提供了高度容错的解决方案,特别适合于处理大规模数据集。HDFS通过其独特的设计理念与架构,支持高吞吐量的数据访问,并且易于扩展。

## 1.1 HDFS的核心设计理念

HDFS的设计借鉴了Google的GFS,其核心设计理念包括:

- **高容错性**:通过数据块的复制策略,确保在节点失效时数据不会丢失。

- **水平扩展**:系统可以通过增加更多的节点来扩大存储容量和处理能力。

- **流式数据访问**:优化设计使得HDFS能够以高速顺序读写大量数据。

## 1.2 HDFS的架构组成

HDFS的架构主要包括两类节点:**NameNode**和**DataNode**。

- **NameNode**:管理文件系统的命名空间,记录每个文件中的数据块所在的DataNode信息。

- **DataNode**:负责存储和检索数据块。当需要读写数据时,DataNode将与客户端直接交互。

## 1.3 HDFS的存储策略

HDFS为了保证数据安全,将每个数据块进行多份复制(默认为3份),分别存储在不同的DataNode上,这样即使部分节点失效,数据依然可用。

理解HDFS的基本概念与架构是深入学习HDFS的首要步骤,这为掌握其复杂的内部机制和优化策略奠定了坚实的基础。接下来,我们将深入探讨HDFS的另一个关键机制——心跳机制。

# 2. HDFS的心跳机制详解

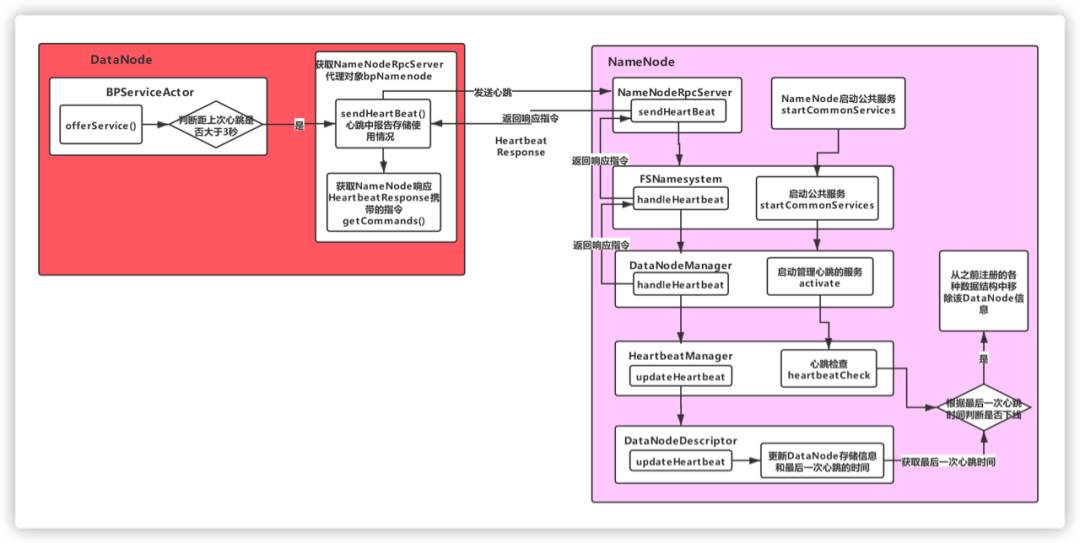

心跳机制是分布式系统中用于监控和维护节点状态的重要手段。HDFS(Hadoop Distributed File System)作为大数据存储的核心,其心跳机制保证了数据节点(DataNode)与主节点(NameNode)之间的健康通信,从而确保整个文件系统的稳定运行。本章节深入探讨HDFS的心跳机制,包括节点通信、心跳策略、与集群稳定性之间的关系,并提出优化方案。

## 2.1 HDFS节点间的通信机制

### 2.1.1 主节点与数据节点的角色

在HDFS架构中,NameNode作为主节点,负责管理文件系统的命名空间和客户端对文件的访问。DataNode则作为数据节点,负责存储实际的数据块,并执行来自NameNode的指令。HDFS的心跳机制中,DataNode定期向NameNode发送心跳信号,表明自己正处于活跃状态,同时NameNode响应心跳信号并控制数据节点的负载和数据块的复制。

### 2.1.2 心跳信号的发送与接收

心跳信号通常包含对等节点之间的信息交换,如存储空间状态、运行状态和数据复制情况。在HDFS中,DataNode启动时会向NameNode注册,并定期(默认3秒一次)发送心跳信号。如果超过一定时间(默认60秒)没有收到心跳,NameNode会认为该DataNode失效,并采取措施进行数据复制和节点恢复。

## 2.2 心跳检测的策略与触发条件

### 2.2.1 定期心跳与异步心跳

HDFS中心跳机制包括定期心跳和异步心跳。定期心跳保证了NameNode能够定期检查DataNode的存活状态,而异步心跳用于处理NameNode的负载和响应DataNode的快速变化。这种组合策略提高了心跳机制的效率和可靠性。

### 2.2.2 失败检测与自动恢复

心跳机制的另一个重要功能是失败检测和自动恢复。当NameNode收不到某个DataNode的心跳时,它会标记该节点为失效,并根据需要进行数据块的复制,以保证数据的持久性和可靠性。同时,心跳机制也帮助NameNode监控网络的健康状况,并在必要时进行网络分区的处理。

## 2.3 心跳机制与集群稳定性

### 2.3.1 心跳信息对集群性能的影响

心跳信息的准确性和频率直接影响集群的性能。如果心跳过于频繁,可能会增加NameNode的处理负担,影响集群整体效率;如果心跳间隔过长,则可能会延迟故障的检测和处理。因此,合理配置心跳间隔和超时参数,是保证HDFS集群性能的关键。

### 2.3.2 优化心跳机制提升集群响应

为提升集群响应,可以通过调整心跳间隔、超时设置和心跳包大小等参数进行优化。比如,通过减少心跳频率降低NameNode的负载,或者在感知到网络故障时临时增加心跳频率以快速反应。此外,合理配置HDFS的监控工具,如Ambari或Cloudera Manager,可以实时监控心跳状态,快速定位问题并做出响应。

### 代码示例:调整心跳间隔与超时参数

HDFS配置文件中相关参数示例如下:

```xml

<property>

<name>dfs心跳间隔</name>

<value>3000</value>

</property>

<property>

<name>dfs数据节点心跳超时</name>

<value>60000</value>

</property>

```

### 逻辑分析:

- 上述配置中的`dfs心跳间隔`表示心跳发送的频率(以毫秒为单位),默认值为3000毫秒,即每3秒发送一次。

- `dfs数据节点心跳超时`指定了在多少时间范围内未收到心跳即视为节点失效,默认为60秒。

以上设置应根据实际集群规模和工作负载进行调整。较小的集群或高负载情况下,可能需要缩短心跳间隔以提升响应速度;而对大规模集群,可能需要适当延长间隔,减少主节点的压力。

通过合理配置心跳机制,不仅可以提升HDFS集群的响应速度,还能保证数据的高可用性和稳定性,为上层应用提供坚实的基础。

# 3. HDFS的数据副本策略

数据副本策略是分布式文件系统设计中的核心部分,尤其是对于HDFS这样的大型存储系统,它确保了数据的高可用性和可靠性。本章节将深入探讨HDFS数据副本的基本原理、不同副本策略的适用场景、以及如何管理和优化数据副本,以实现数据冗余和系统稳定性的最佳平衡。

## 3.1 数据副本的基本原理

### 3.1.1 副本放置策略

在HDFS中,文件被分割成一系列的块(block),每个块默认复制成多个副本,这些副本被放置在不同的数据节点(DataNode)上。副本放置策略的目标是最大化数据的可靠性和可用性,同时优化读写性能。HDFS采用了一种特殊的副本放置策略,即“机架感知(rack-aware)”策略,该策略考虑了数据节点所在的网络机架位置。

默认情况下,HDFS会将第一个副本放置在上传文件的数据节点上,以便于快速写入。接着,HDFS会将第二个副本放置在另一个机架的不同节点上,这样做可以保护数据免受单点故障的影响。第三个及后续副本则根据剩余的节点随机分布。

```mermaid

graph TD;

A[上传数据节点] -->|副本1| B[同一机架的另一个节点]

A -->|副本2| C[不同机架的节点]

A -->|副本3...n| D[其他节点]

```

这种策略确保了即使某一个机架完全失效,数据依然可以从其他机架上的副本中恢复。同时,随机放置副本可以防止数据过于集中,减少了单个机架过载的风险。

### 3.1.2 副本冗余与数据安全

HDFS通过存储多个数据副本保证了数据的冗余性。默认情况下,副本数量被设置为3,这被认为是在性能和可靠性之间的一个平衡值。用户可以根据自己的需求调整副本数量,以达到所需的容错能力。

副本的冗

0

0