HDFS副本管理进阶秘籍:动态副本数量调整的高级策略

发布时间: 2024-10-28 06:47:21 阅读量: 54 订阅数: 45

4.Hadoop入门进阶课程_第4周_HDFS原理及操作.pdf

# 1. HDFS副本管理概述

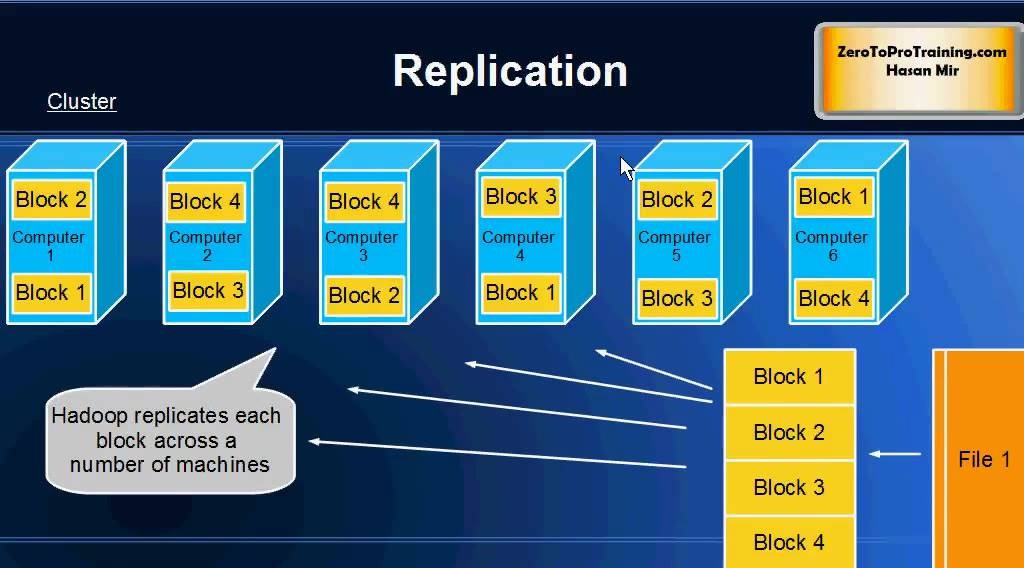

在大数据处理领域,Hadoop分布式文件系统(HDFS)以其高容错性和伸缩性成为了数据存储的重要基石。副本管理作为HDFS的核心功能之一,确保了数据的可靠性和高可用性。本章节将简要介绍HDFS副本管理的定义和重要性,为读者提供副本管理的背景知识和基础理论。

## HDFS副本管理的定义

HDFS副本管理指的是Hadoop在分布式环境中,对数据副本进行存储、复制、分配以及失效后的恢复等一系列操作。这一过程涉及到数据的冗余备份、负载均衡、故障转移等多个方面。

## 副本管理的重要性

在数据存储系统中,副本是提高数据可靠性的关键。通过对数据进行多份拷贝存储,即便部分节点发生故障,系统也能确保数据不丢失并维持服务的连续性。对于HDFS而言,副本管理机制的设计对于实现存储系统高吞吐量和扩展性至关重要。

## 副本管理的挑战

随着数据量的不断增长以及对高可用性要求的提高,副本管理面临诸多挑战。从技术层面来看,需要平衡数据的安全性与存储成本,优化副本放置策略以减少网络带宽的消耗,并且确保系统对故障具有快速响应的能力。在实际应用中,还需要考虑系统扩展性和数据恢复的效率问题。

通过深入了解副本管理,IT从业者可以更好地理解数据存储的本质,进而在实践中做出更合理的设计决策。在接下来的章节中,我们将进一步探索副本放置策略、动态副本数量调整以及高级副本管理策略等主题,以期为读者提供全面而深入的副本管理知识。

# 2. 副本放置策略的理论基础

### 2.1 HDFS副本放置规则

#### 2.1.1 副本的基本放置原则

Hadoop分布式文件系统(HDFS)设计的一个核心原则是“一次写入,多次读取”。这意味着一旦文件被写入到HDFS,它就不会被修改。在这样的系统中,数据副本的管理就变得至关重要,以确保数据的高可用性和系统容错性。副本的基本放置原则包括以下几点:

1. **数据冗余**:数据被复制多份保存在不同的DataNode节点上,以防止数据丢失。

2. **节点多样性**:不同副本的存储位置应分布于不同的硬件或机架,以提高容错能力。

3. **读写效率**:将副本放置于读写负载较低的节点上,以平衡系统的负载,提高读写操作的效率。

#### 2.1.2 节点选择算法和数据局部性原理

在HDFS中,副本的放置依赖于特定的节点选择算法,该算法旨在满足上述的放置原则,并且遵循数据局部性原理。数据局部性原理包括空间局部性和时间局部性:

- **空间局部性**:近期被访问的数据可能在不久的将来再次被访问。

- **时间局部性**:如果一个数据项被访问,那么它不久后很可能再次被访问。

根据这个原理,HDFS副本放置策略会尽量将副本放在与源节点物理位置相近的节点,以及负载较低的节点。HDFS的默认副本放置策略如下:

- 第一个副本存放在写入客户端所在的DataNode节点上(如果客户端不是一个DataNode节点,则选择随机一个)。

- 第二个副本存放在与第一个副本不同机架的某个DataNode节点上,以提高容错性。

- 后续副本则随机存放在不同机架的DataNode节点上。

### 2.2 副本放置策略的演变

#### 2.2.1 传统HDFS副本放置策略

传统HDFS的副本放置策略注重于提高数据的可靠性,它通过将副本分散存储在不同的机架上来防止机架级别的故障。然而,这种策略也存在一些问题,比如当DataNode发生故障时,会导致大量的数据传输,因为需要从其他机架上复制数据。

```mermaid

graph LR

A[客户端写入] -->|副本1| B[本地DataNode]

B -->|副本2| C[其他机架DataNode]

B -->|副本3| D[随机机架DataNode]

C -->|副本复制| D

```

#### 2.2.2 现代分布式存储的副本放置趋势

随着技术的发展,现代分布式存储系统开始关注副本放置策略的优化,以提升读写效率和数据安全性。这包括使用更智能的副本放置算法,如基于节点负载、网络状况和存储设备性能的动态副本放置策略。例如,Facebook的HDFS优化版本HDFS-RAID采用纠删码(Erasure Coding)技术,减少了存储空间的浪费,同时保持了数据的高可用性。

### 2.3 理论到实践的挑战

#### 2.3.1 理论模型与实际应用的差异

尽管理论上的副本放置策略已经设计得相当完备,但是在实际应用中,这些理论往往面临众多挑战。由于硬件故障、网络波动、节点负载等因素的影响,理论模型可能无法准确预测实际状况。因此,需要通过不断的实验和调整,使得副本放置策略更加贴合实际应用的需求。

#### 2.3.2 数据热冷特性与副本放置优化

不同的数据访问模式(热数据和冷数据)要求不同的副本放置策略。热数据,即频繁访问的数据,需要放置在性能更好的存储设备上,并且尽量靠近计算资源。而冷数据,则可以存放在成本更低、读写速度较慢的存储上。因此,设计一个可动态调整副本策略的系统是非常有必要的,以实现资源的最优分配。

为了进一步理解HDFS的副本放置规则,我们可以查看Hadoop源代码中的相关实现,了解在实际操作中副本是如何被放置的。下面是一个简化的代码段,展示了如何在HDFS中创建文件时放置副本的逻辑:

```java

// 伪代码,仅作逻辑展示,并非真实HDFS源代码

public void createFile(DFSOutputStream stream) {

// 创建文件时,为文件添加副本

int numReplicas = dfsConfig.getInt("dfs.replication", 3);

for (int i = 0; i < numReplicas; i++) {

// 调用副本放置算法

BlockPlacementPolicy bpPolicy = blockPlacementPolicyPicker.getPolicy(stream.getPipeline());

blockPlacementPolicyPicker.placeBlock(stream, bpPolicy);

}

}

```

上述代码展示了HDFS在创建文件时,会根据配置的副本数进行循环,每次循环中,都会调用副本放置策略(`BlockPlacementPolicy`),通过`blockPlacementPolicyPicker`选择合适的放置策略。

本章节中,我们深入探讨了HDFS副本放置策略的理论基础,接下来,我们将继续深入了解如何实现动态副本数量的调整以及高级副本管理策略。

# 3. 动态副本数量调整实践

## 3.1 自动副本调整机制

### 3.1.1 HDFS的自动副本数量调整原理

Hadoop Distributed File System (HDFS) 的自动副本调整原理是基于特定的启发式规则和统计方法。在HDFS中,文件系统的数据块是由多个副本组成,存储在不同的DataNode上,以便在部分节点失效时保证数据的高可用性和可靠性。为了动态地维持数据的副本数,HDFS内置了一个名为“ReplicationMonitor”的组件。

ReplicationMonitor的工作原理是定期检查数据块的副本数是否满足预设的副本策略,如有必要,则发起副本复制或删除操作。它会监控以下几个关键因素:

- DataNode的健康状态,确认是否有节点故障导致副本数不足。

- 磁盘空间和I/O负载,避免在资源紧张的节点上复制新的副本。

- 数据块的读取频率和访问模式,比如热点数据可能需要更多的副本以提供更好的性能。

自动副本调整机制的目标是优化资源使用和数据访问性能。当HDFS检测到数据块的副本数低于预设最小值时,它会自动启动副本复制过程,以保证数据块的副本数达到设定的安全阈值。相反,如果副本数高于预设的最大值,则会启动副本清理过程。

### 3.1.2 配置和监控

0

0