HDFS监控与报警策略:副本机制下的系统稳定性保障

发布时间: 2024-10-28 07:22:52 阅读量: 37 订阅数: 21

【光学】基于matlab计算石墨烯非线性光带和自激类克尔效应【含Matlab源码 10952期】.zip

# 1. HDFS基础和副本机制概述

## Hadoop分布式文件系统 (HDFS)

HDFS 是 Hadoop 的核心组件,为大规模数据存储提供了可靠的解决方案。作为一种支持高容错性的文件系统,它适用于运行在通用硬件上的分布式环境中。HDFS 通过数据的冗余存储(副本机制),保障了数据的可靠性和可用性。

## HDFS副本机制

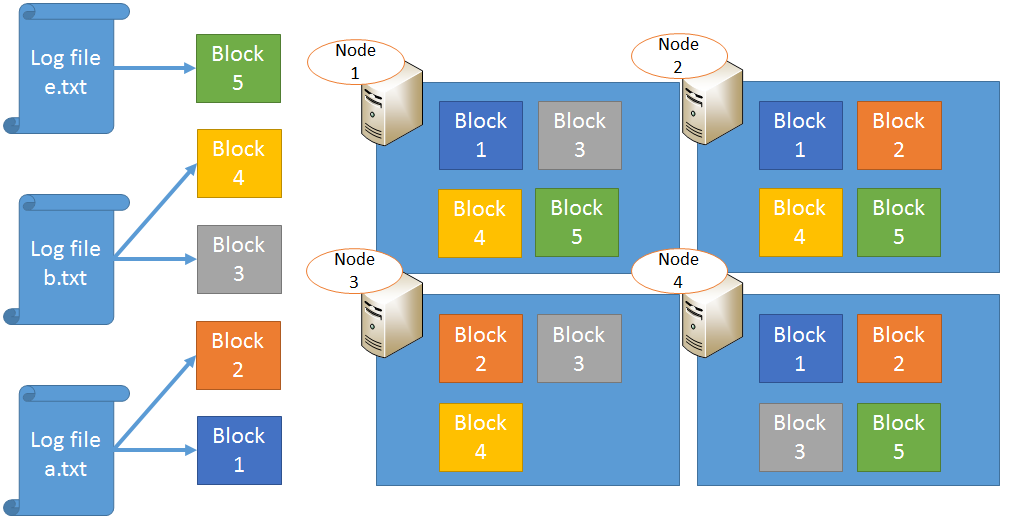

在 HDFS 中,文件被切分成一系列块(block),每个块默认大小为 128MB 或 256MB,并在多个 DataNode 节点上进行存储。这种设计允许文件即使在部分硬件失效的情况下,依然能够保持可用状态。副本的数量由 `dfs.replication` 配置项指定,默认情况下,副本因子为 3。

副本的放置策略遵循如下原则:

- 第一个副本放在写入文件的 DataNode 上(客户端所在节点)。

- 其余副本分布到不同的机架上,以避免机架级别的故障导致数据丢失。

- 优先填满一个机架上的存储空间,再往其他机架上放置副本。

了解 HDFS 的基础架构和副本机制对于设计高效的监控系统至关重要,因为监控和报警策略必须围绕数据的高可用性和系统的稳定性来制定。通过合理地监控数据块的副本分布、读写速率和存储容量,可以确保 HDFS 系统的稳定运行。接下来的章节将深入探讨 HDFS 的监控策略、报警机制以及它们在实际应用中的案例分析。

# 2. 监控策略的理论基础

## 2.1 HDFS监控指标的选取

### 2.1.1 理解关键性能指标

在Hadoop分布式文件系统(HDFS)的监控中,选择正确的性能指标是至关重要的。这些指标可以帮助管理员评估系统的健康状况、识别性能瓶颈和预测潜在的问题。对于HDFS来说,关键性能指标主要包括存储利用率、吞吐量、延迟以及副本的健康状态。

- **存储利用率**:监控HDFS中的存储空间使用情况对于优化存储资源非常重要。需要定期检查空间利用率,以确保不会出现因空间不足而影响服务的情况。

- **吞吐量**:衡量数据读写速度的指标,对于评估系统的性能至关重要。一个高效的HDFS应该保持持续和稳定的吞吐量。

- **延迟**:代表了文件读写操作的响应时间。高延迟可能表明存在网络、磁盘I/O或配置问题。

- **副本健康状态**:HDFS通过创建多个副本来确保数据的高可用性。监控副本的健康状态可以确保数据在节点故障时依然可用。

这些关键指标不仅对于日常的运维监控至关重要,也是灾难预防和恢复计划中不可或缺的部分。

### 2.1.2 指标对系统稳定性的影响

每一个性能指标都直接或间接地影响着HDFS系统的稳定性。例如,存储空间的急剧增加可能会导致节点频繁进行数据重新分配,这会增加系统的负载,导致处理延迟。如果监控系统能够及时检测到存储空间的异常增长,那么可以采取措施,如增加存储节点,来避免潜在的系统不稳定性。

另一个例子是吞吐量的波动。如果监控系统发现吞吐量突然下降,那么可能是因为网络拥塞或硬件故障。及时地检测并响应这些变化可以防止性能问题进一步扩大,保持系统的稳定运行。

## 2.2 监控工具和方法

### 2.2.1 开源监控工具介绍

在HDFS监控领域,有许多开源工具被广泛使用,比如Ganglia、Nagios、Zabbix等。这些工具各有特点,能够提供丰富的监控功能。

- **Ganglia**:一个高度可扩展的分布式监控系统,特别适用于大型集群环境。它收集、聚合和展示系统的度量指标,如CPU使用率、内存使用情况和网络流量等。

- **Nagios**:一个功能强大的系统和网络监控工具,可以帮助管理员在问题发生之前就被发现并得到通知。Nagios可以通过插件来支持HDFS的监控。

- **Zabbix**:一个用于监控网络和应用状态的工具,支持自动发现和配置监控项,并且可以灵活地设定报警条件。

上述工具均提供友好的用户界面和报警机制,但是它们各有优缺点,因此在选择监控工具时需要根据实际需求和环境来决定。

### 2.2.2 自定义监控脚本和策略

除了使用开源监控工具,还可以编写自定义监控脚本来满足特定的监控需求。这些脚本可以使用Shell、Python或其他编程语言编写,并利用Hadoop提供的Java API来访问HDFS的状态和性能数据。

脚本的编写通常需要遵循以下步骤:

1. 连接到HDFS集群。

2. 获取集群的健康状态和性能数据。

3. 分析数据,判断是否超出预定阈值。

4. 如果检测到问题,根据预定的策略执行报警或其他应对措施。

自定义脚本可以实现更为灵活和复杂的监控逻辑,例如自动化的数据收集、处理和报告,以及整合其他监控系统的数据。

## 2.3 报警机制的理论框架

### 2.3.1 报警级别与阈值设置

报警机制是监控系统中的一个关键部分,它可以及时通知管理员系统出现的问题。为了提高报警的有效性,需要合理地设置报警级别和阈值。常见的报警级别包括:

- **警告(Warning)**:系统存在潜在问题,但没有直接影响服务,需要提前关注。

- **紧急(Critical)**:系统性能下降或出现故障,影响业务的正常运行。

- **恢复(Recovery)**:系统已从紧急状态恢复,但仍需监控以确保稳定运行。

设置阈值需要根据历史数据和业务需求来确定,阈值过高可能导致重要问题被忽视,而阈值过低则可能引起大量的误报。

### 2.3.2 报警策略的制定原则

制定报警策略时,应当遵循以下原则:

- **简洁明了**:确保报警信息清晰,能够直接反映问题所在。

- **快速反应**:系统能够快速检测到问题并发出报警,以便及时处理。

- **避免误报**:设置合理的阈值,减少不必要的报警,降低误报率。

- **可操作性**:报警信息应包含足够的细节,便于管理员采取有效措施。

一个高效的报警策略不仅能够提高系统的稳定性,还可以提升管理员的工作效率,从而使得整个HDFS集群更加可靠和高效。

# 3. HDFS监控实践

Hadoop分布式文件系统(HDFS)是大数据处理系统中存储数据的核心组件。随着数据量的增加,系统的复杂性也随之提高,因此对HDFS进行有效监控以确保其稳定运行变得至关重要。本章节将详细介绍HDFS的常用监控指标,并探讨监控系统的部署和应用,同时分析和解决常见的监控问题。

## 3.1 常用监控指标详解

### 3.1.1 空间利用率监控

空间利用率是衡量HDFS集群存储资源使用情况的重要指标。高空间利用率可能导致文件系统无法写入新数据,而过低的空间利用率则可能意味着资源未被充分利用。监控这一指标,可以帮助系统管理员进行有效的容量规划和资源优化。

#### 代码块示例

假设我们使用Java编写了一个简单的脚本来获取HDFS空间利用率:

```java

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hdfs.DistributedFileSystem;

import java.io.IOException;

public class SpaceUtilizationMonitor {

public static void main(String[] args) throws IOException {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

if (fs instanceof DistributedFileSystem) {

float utilization = ((DistributedFileSystem) fs).getCapacityUsedPercent();

System.out.println("HDFS Space Utilization: " + utilization + "%");

}

// Close the file system resource

fs.close();

}

}

```

上述代码获取了HDFS集群的容量使用百分比并打印出来。`getCapacityUsedPercent()`方法返回的是已使用空间占总空间的百分比。

#### 参数说明

- `Configuration`: 包含HDFS的配置信息。

- `FileSystem`: Hadoop的文件系统类,用于访问文件系统资源。

- `DistributedFileSystem`: HDFS的文件系统实现类。

#### 执行逻辑说明

- 实例化配置信息并创建文件系统对象。

- 检查文件系统是否为分布式类型。

- 获取空间利用率并输出。

- 最后,关闭文件系统资源。

监控空间利用率有助于及时发现存储容量不足的问题,从而采取必要的措施,例如添

0

0