HDFS数据恢复全攻略:副本机制下的恢复原理与步骤详解

发布时间: 2024-10-28 07:04:12 阅读量: 4 订阅数: 8

# 1. HDFS数据恢复概述

Hadoop分布式文件系统(HDFS)作为大数据存储的关键组件,其数据恢复策略对于保障数据安全至关重要。本章将从HDFS数据恢复的必要性和基本概念入手,为读者提供一个清晰的概览。我们将讨论为何需要对HDFS进行数据恢复,以及恢复过程中的主要挑战和考量因素。此外,本章还会简要介绍后续章节将深入探讨的HDFS架构、副本机制和恢复技巧,为理解更深层次的内容打下基础。

在理解数据恢复的重要性后,我们将探讨HDFS架构中的关键组件,如NameNode和DataNode,以及它们在数据恢复中的作用。读者将会了解到副本机制如何影响数据恢复策略,并为后续章节中详细介绍副本放置策略和读写一致性保证做好铺垫。

## 2.1 HDFS架构详解

### 2.1.1 NameNode与DataNode的基本功能

NameNode是HDFS中的主节点,负责管理文件系统的命名空间以及客户端对文件的访问。它通过维护文件系统树及整个HDFS集群中所有文件的元数据信息,实现了文件命名、权限控制和空间分配等关键功能。在数据恢复过程中,NameNode的状态对于重新构建文件系统结构至关重要。

DataNode是HDFS中的工作节点,负责存储实际的数据。每个DataNode管理着一部分数据块,它执行文件系统客户端的读写请求,并将数据块复制到其他DataNode上以提供数据的容错性。在数据恢复中,DataNode需要确保数据块的正确复制和一致性。

### 2.1.2 HDFS数据块的存储过程

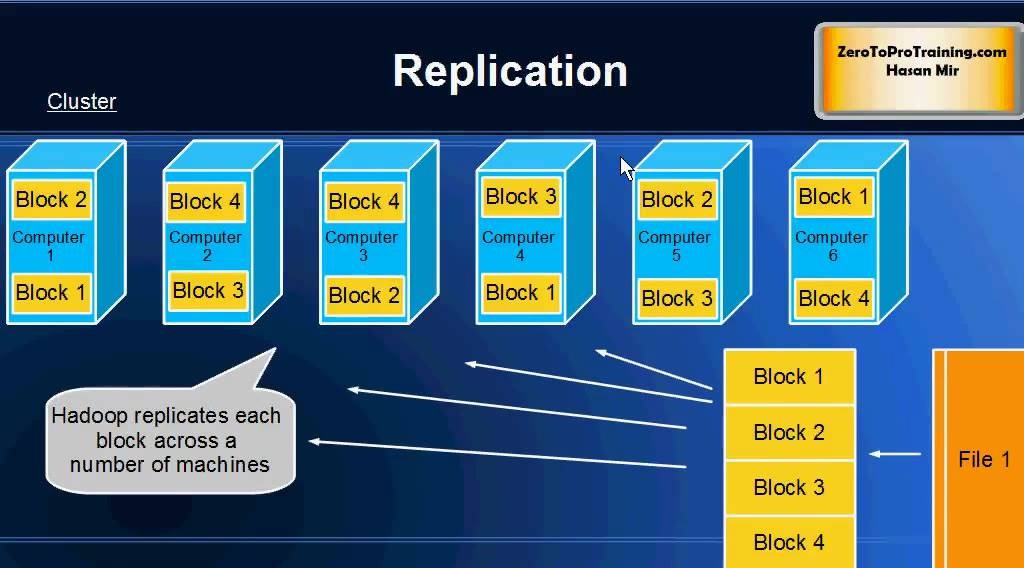

HDFS将大文件分割为固定大小的数据块(默认为128MB),这些数据块在多个DataNode上进行冗余存储,以提供高可靠性和容错能力。HDFS通过“副本”机制保证数据的安全性,每个数据块默认会有三个副本,分别存放在不同的DataNode上。一个为首选副本(primary),另外两个为备份副本。

当数据写入HDFS时,客户端首先将数据发送给NameNode,NameNode根据文件系统和数据块的负载情况确定存储位置。然后,数据被分成块,并且在写入首选副本的同时,还被传输到其他两个备份节点。如果任一DataNode发生故障,NameNode会检测到并启动数据块的复制过程,以确保副本数量达到要求。

> HDFS的数据块存储过程是一个高效的数据分片和冗余存储策略,为数据恢复提供了坚实的基础。

# 2. HDFS的基本原理与副本机制

Hadoop Distributed File System(HDFS)是Hadoop项目的核心组件之一,它是一个高度容错的系统,用于存储大量数据。它通过廉价的硬件设备实现高吞吐量的数据访问,并通过其副本机制实现数据的可靠存储。在深入探讨HDFS数据恢复之前,我们先要了解HDFS的基本原理和其副本机制的运作方式。

## 2.1 HDFS架构详解

HDFS架构的设计重点在于支持大量文件的存储,并且这些文件的大小往往可以达到GB甚至TB级别。HDFS的架构设计使其能够跨越多个硬件平台,适用于不同规模的部署。

### 2.1.1 NameNode与DataNode的基本功能

HDFS架构由两种类型的节点组成:NameNode和DataNode。

#### NameNode

NameNode是HDFS的主节点,它的主要职责是管理文件系统的命名空间和客户端对文件的访问。具体来说,NameNode负责执行以下任务:

- 维护文件系统的目录结构。

- 管理文件和目录的元数据,例如权限、访问控制列表(ACLs)等。

- 管理DataNode上的数据块。

由于NameNode保存了文件系统的元数据,因此它对整个系统的正常运行至关重要。在HDFS中,通常会有两个NameNode(一个活动的和一个处于热备状态的),以实现高可用性。

#### DataNode

DataNode是存储数据的节点。每个DataNode负责存储数据块(block),并且执行数据的读写操作。DataNode的主要功能包括:

- 存储由HDFS文件切分出来的数据块。

- 执行数据块的创建、删除和复制操作。

- 定期向NameNode发送心跳信号,报告自己的健康状态。

DataNode的分布式的特性意味着数据会被跨多个DataNode存储,提供高可靠性。

### 2.1.2 HDFS数据块的存储过程

HDFS将文件分割为一系列的数据块进行存储,数据块的默认大小是128MB(在较新版本中为256MB),具体大小可以在集群初始化时进行配置。

- 当客户端向HDFS写入文件时,文件会被分割成数据块,并且这些数据块会被传输到多个DataNode上。

- NameNode负责决定将数据块复制到哪些DataNode上,以及后续的数据块复制策略。

- 写入的数据块会在多个DataNode上保持多个副本,以防止数据丢失。

这种设计模式确保了即使在单个DataNode发生故障的情况下,数据也能保持完整性和可用性。

## 2.2 副本机制的工作原理

HDFS通过其副本机制保证数据的可靠性和容错性。了解副本机制的工作原理,对于进行高效的数据恢复至关重要。

### 2.2.1 副本放置策略

副本的放置是HDFS高可用性的一个核心部分。Hadoop的默认副本策略是:

- 第一个副本存放在写入DataNode上。

- 第二个副本存放在与写入DataNode不在同一机架的另一个DataNode上。

- 其余的副本存放在与第一个副本不同的机架上。

这种策略是为了在发生硬件故障时提供更好的容错性。当一个机架发生故障时,数据不会全部丢失,因为至少还有一个副本存放在其他机架的DataNode上。

### 2.2.2 副本读写的一致性保证

HDFS提供了严格的一致性模型,确保在一个文件上进行的写操作完成后,读操作可以立即得到最新数据。HDFS保证了以下一致性:

- 原子性:文件的写操作是原子的,要么全部完成,要么全部不完成。

- 顺序一致性:一次只有一个写操作能够写入数据块。

- 一致性:一旦写操作成功,数据块就是最新的,读操作总能读到最新的数据。

为了维持一致性,HDFS使用了文件锁机制和写入确认机制。同时,NameNode也会周期性地进行数据块的校验和检查。

在HDFS的数据恢复章节中,我们将了解到如何使用这些原理和策略来处理数据损坏、节点故障等情况。HDFS的数据恢复不仅是一个技术问题,更是对Hadoop生态中数据持久性和容错性理念的实践应用。通过掌握HDFS的基本原理和副本机制,数据恢复的操作将变得更加高效和可控。

# 3. ```

# 第三章:HDFS数据恢复前的准备工作

## 3.1 HDFS数据恢复前的环境检查

### 3.1.1 确认HDFS运行状态

在执行HDFS数据恢复之前,首先需要确保Hadoop分布式文件系统(HDFS)运行状态的正常。HDFS作为大数据存储的核心组件,任何故障都可能导致数据的不可用。确认HDFS运行状态包括检查NameNode和DataNode的存活状态,以及检查数据是否能够正常读写。一个简单而有效的方法是使用`hdfs dfsadmin -repo

```

0

0